引言:

JS逆向是指利用编程技术对网站上的JavaScript代码进行逆向分析,从而实现对网站数据的抓取和分析。这种技术在网络数据采集和分析中具有重要的应用价值,能够帮助程序员获取网站上的有用信息,并进行进一步的处理和分析。

基础知识:

JavaScript解析引擎是爬虫JS逆向技术中的核心之一,它能够解析网页中的JavaScript代码,获取生成的内容。浏览器模拟动态行为可以模拟真实浏览器的,行为包括发送请求、执行JavaScript代码、处理Cookie等,以获取网页数据。破解反爬虫是针对网站针对爬虫的防御措施,需要不断更新技术手段应对网站的反爬虫策略。处理动态渲染页面可以针对使用JavaScript进行页面内容渲染的网页,需要使用特定的技术来获取完整的页面数据。这些技术通常需要具备一定的JavaScript编程能力和对网页结构的深入理解。

实践应用示例:

以爬取京东为案例,我们可以利用爬虫JS逆向技术来获取京东网站上的商品信息,比如价格、评论等。首先,我们将使用Python和Node.js来实现对京东网站的数据爬取,重点关注爬虫JS逆向的实践应用。我们可以通过以下步骤来实现这一目标:

- 发起HTTP请求

- 分析JavaScript代码

- 数据解析和处理

- 完整实现代码

1.发起HTTP请求

首先,我们需要利用Python的请求库Node.js的axios库来向京东网站发起HTTP请求,以获取网页内容。这一步是爬虫或者是基础,通过获取网页内容,我们可以进一步分析并提取所需的内容的数据。

在Python中,我们可以使用requests库来发送HTTP请求,示例代码如下:

Python

复制

import requests

url = 'https://www.jd.com'

response = requests.get(url)

print(response.text)

在Node.js中,我们可以使用axios库来实现相同的功能,示例代码如下:

javascript

复制

const axios = require('axios');

axios.get('https://www.jd.com')

.then(response => {

console.log(response.data);

})

.catch(error => {

console.error(error);

});

2.分析JavaScript代码

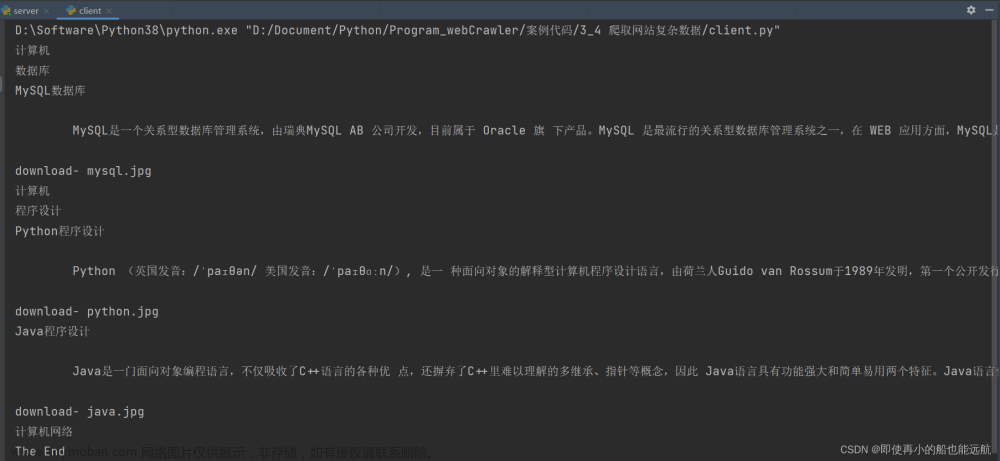

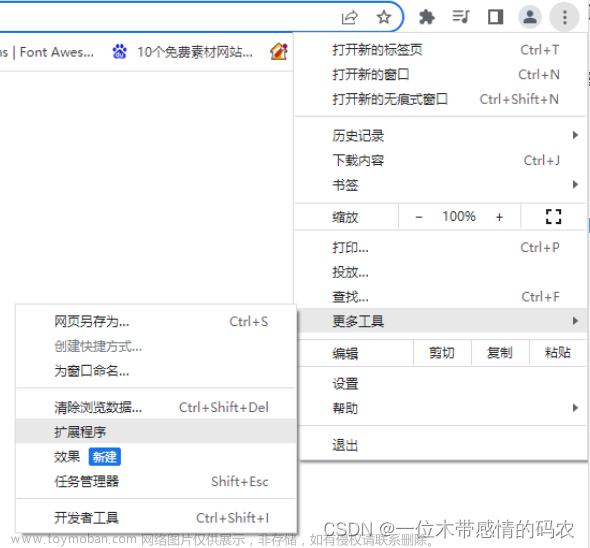

通过分析京东网页上的JavaScript代码,我们可以了解数据的加载和渲染机制,找到需要的数据所在的位置。该步骤需要对网页结构和JavaScript代码进行深入的分析,以便后续的数据提取和处理。

3. 数据解析和处理

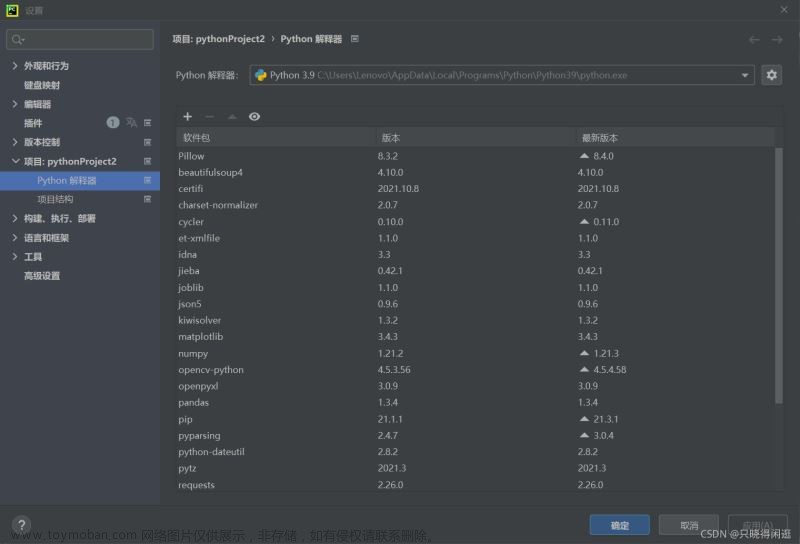

在获取到需要的网页内容后,我们需要利用相应的工具来进行解析和处理,以提取出商品信息、价格等数据。在Python中,我们可以使用BeautifulSoup或者lxml等库来进行网页内容的解析和数据提取;在Node.js中,我们可以使用cheerio等库来实现相同的功能。

4. 完整实现代码

最后,根据上述步骤,我们可以编写完整的爬虫JS逆向代码,实现对京东网站的数据提取和分析。以下是一个简单的示例代码,用于从京东网站获取商品信息:文章来源:https://www.toymoban.com/news/detail-803966.html

javascript

复制

const axios = require('axios');

const cheerio = require('cheerio');

async function getJdProductInfo() {

const url = 'https://item.jd.com/1000123456789.html';

const response = await axios.get(url);

const $ = cheerio.load(response.data);

const title = $('div.sku-name').text();

const price = $('span.price').text();

console.log('商品名称:', title);

console.log('商品价格:', price);

}

getJdProductInfo();

通过以上步骤,我们可以实现对京东网站的数据抓取和分析,为进一步的数据处理和应用提供基础。文章来源地址https://www.toymoban.com/news/detail-803966.html

到了这里,关于如何使用JS逆向爬取网站数据的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!