以下是在Linux系统上安装Hadoop的详细步骤:

-

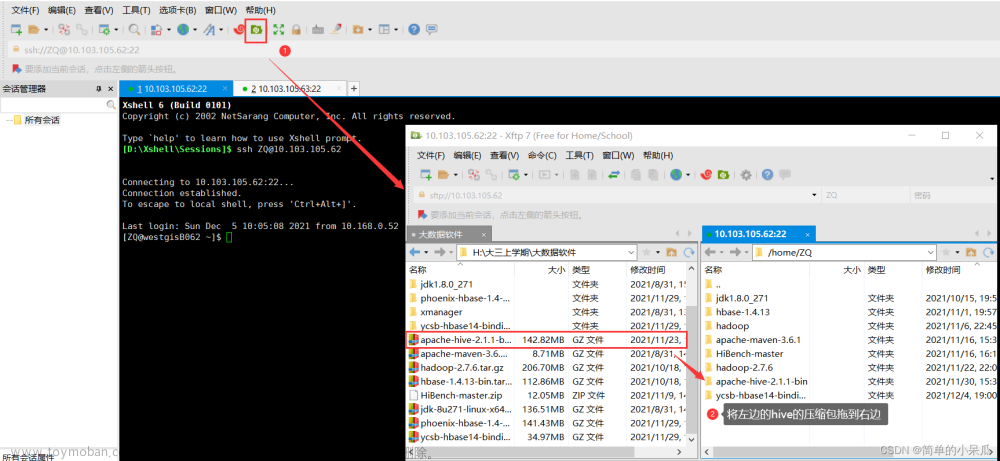

下载Hadoop文件

在Hadoop官方网站上下载最新的稳定版本的Hadoop文件。下载地址:https://hadoop.apache.org/releases.html -

解压Hadoop文件

打开终端,使用以下命令将下载的Hadoop文件解压到指定目录:tar -xzvf hadoop-X.X.X.tar.gz -C /usr/local/ -

配置环境变量

打开终端,使用以下命令打开配置文件:sudo nano ~/.bashrc在配置文件里添加以下内容:

# Hadoop相关路径配置 export HADOOP_HOME=/usr/local/hadoop-X.X.X export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin export HADOOP_MAPRED_HOME=$HADOOP_HOME export HADOOP_COMMON_HOME=$HADOOP_HOME export HADOOP_HDFS_HOME=$HADOOP_HOME export YARN_HOME=$HADOOP_HOME保存并关闭配置文件,然后运行以下命令使配置生效:

source ~/.bashrc -

配置Hadoop

进入Hadoop安装目录,并编辑配置文件:cd /usr/local/hadoop-X.X.X/etc/hadoop/ sudo nano hadoop-env.sh将以下代码行:

export JAVA_HOME=${JAVA_HOME}修改为:

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64保存并关闭文件。

-

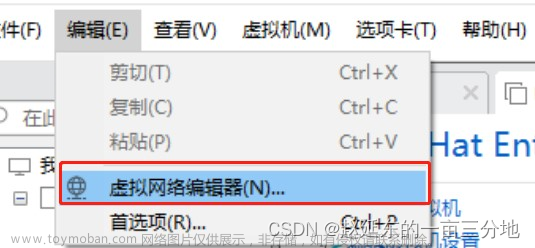

配置Hadoop集群

打开core-site.xml文件:sudo nano core-site.xml在<configuration>和</configuration>之间添加以下内容:

<property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/usr/local/hadoop-X.X.X/tmp</value> </property>保存并关闭文件。

-

配置HDFS

打开hdfs-site.xml文件:sudo nano hdfs-site.xml在<configuration>和</configuration>之间添加以下内容:

<property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:/usr/local/hadoop-X.X.X/hadoop_data/hdfs/namenode</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:/usr/local/hadoop-X.X.X/hadoop_data/hdfs/datanode</value> </property>保存并关闭文件。

-

配置YARN

打开yarn-site.xml文件:sudo nano yarn-site.xml在<configuration>和</configuration>之间添加以下内容:

<property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name> <value>org.apache.hadoop.mapred.ShuffleHandler</value> </property> <property> <name>yarn.resourcemanager.hostname</name> <value>localhost</value> </property>保存并关闭文件。

-

格式化Hadoop文件系统

运行以下命令:hdfs namenode -format -

启动Hadoop集群

运行以下命令:start-dfs.sh start-yarn.sh您可以使用以下命令检查Hadoop是否成功启动:

jps如果一切正常,应该能够看到NameNode、DataNode、ResourceManager和NodeManager等进程。文章来源:https://www.toymoban.com/news/detail-804020.html

现在,Hadoop已经成功安装在您的Linux系统上。文章来源地址https://www.toymoban.com/news/detail-804020.html

到了这里,关于linux安装hadoop详细步骤的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!