kafka消费相关问题(GPT回答版本)

在Java中,要避免重复消费Kafka消息,可以使用以下方法

1. 使用消费者组:

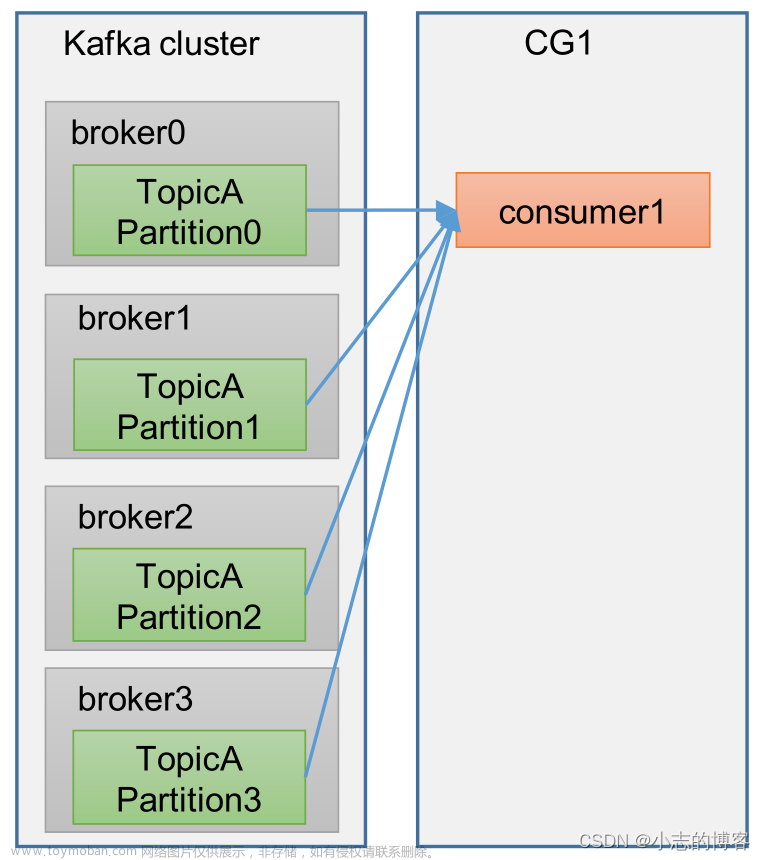

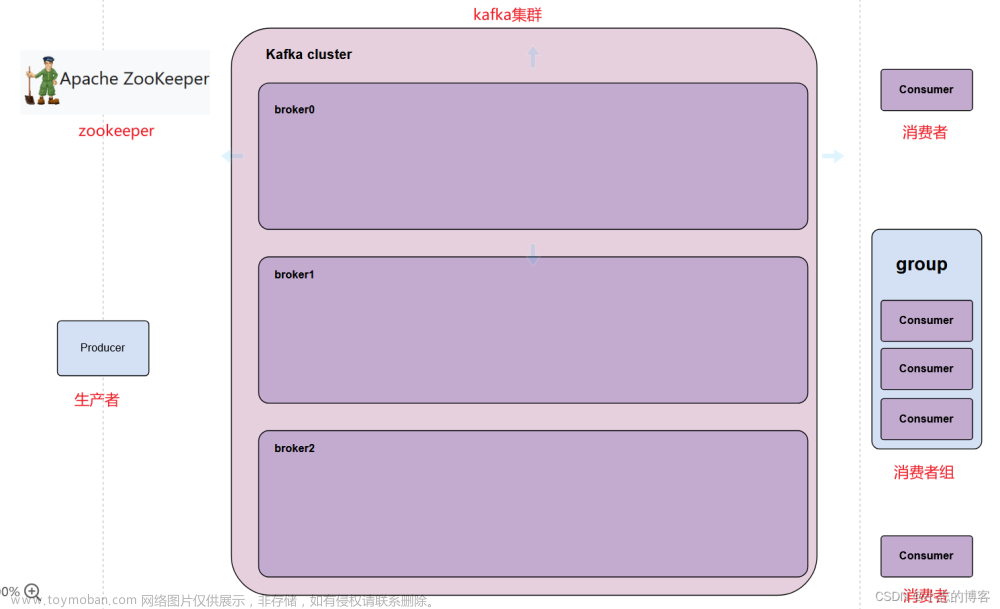

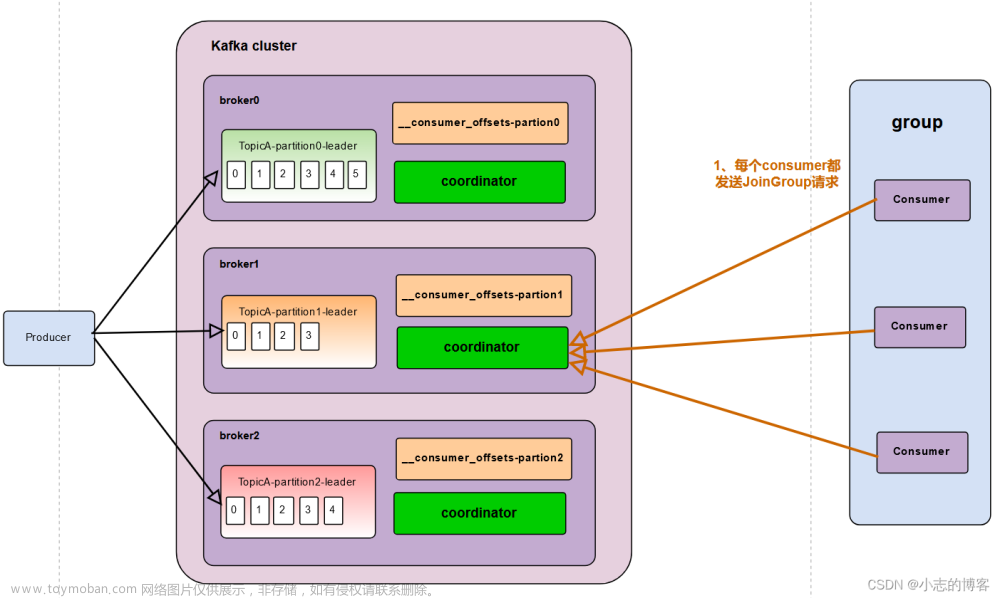

在设置Kafka消费者时,可以指定一个消费者组。一个消费者组中可以有多个消费者实例,每个实例只会消费到消息的其中一部分。当一条消息被某个消费者实例处理后,其他消费者实例就不会再消费到相同的消息。这种方式可以避免同一个消息被多个消费者重复处理。

2. 提交消费位移:

消费者在消费消息的同时,可以手动提交消费位移(offset)。消费位移表示消费者已经处理到的消息位置。通过手动提交位移,消费者可以在处理完一条消息后,立即提交位移,确保消息被成功消费。当消费者重启后,它可以根据上次提交的位移继续消费,从而避免重复消费。

3. 设置幂等性:

在订单系统中,幂等性是一个重要的概念。当同一个消息被重复消费时,保证系统行为的一致性非常重要。可以通过在订单系统中实现幂等性逻辑,来避免同一个订单被多次处理。例如,可以使用唯一订单号作为判定重复的依据,在处理订单前先检查订单号是否已经存在,如果存在则直接返回成功。

4. 使用分区键:

Kafka消息被分为多个分区,每个分区都有一个唯一的分区键。可以在生产者端设置合适的分区键,将相关的订单消息发送到同一个分区。这样,同一个订单的消息总是会被发送到同一个分区中,保证了消息的顺序性。消费者只需要消费特定的分区即可,避免重复消费。

通过以上方法,可以有效地避免重复消费Kafka消息,确保订单系统的消息处理准确性和可靠性。

对应的demo

1. 使用消费者组:

import org.apache.kafka.clients.consumer.*;

import java.util.*;

public class KafkaConsumerDemo {

private static final String TOPIC = "order_topic";

private static final String GROUP_ID = "order_consumer_group";

public static void main(String[] args) {

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", GROUP_ID);

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Collections.singletonList(TOPIC));

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<String, String> record : records) {

// 处理接收到的消息

System.out.println("Received message: " + record.value());

}

}

}

}

2. 提交消费位移:

import org.apache.kafka.clients.consumer.*;

import java.util.*;

public class KafkaConsumerDemo {

private static final String TOPIC = "order_topic";

public static void main(String[] args) {

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "order_consumer_group");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Collections.singletonList(TOPIC));

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<String, String> record : records) {

// 处理接收到的消息

System.out.println("Received message: " + record.value());

// 手动提交位移

consumer.commitSync();

}

}

}

}

3. 设置幂等性:

import org.apache.kafka.clients.consumer.*;

import java.util.*;

public class KafkaConsumerDemo {

private static final String TOPIC = "order_topic";

public static void main(String[] args) {

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "order_consumer_group");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Collections.singletonList(TOPIC));

Set<String> processedOrders = new HashSet<>(); // 用于存储已经处理的订单号

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<String, String> record : records) {

// 处理接收到的消息

String order = record.value();

if (!processedOrders.contains(order)) {

System.out.println("Processing order: " + order);

// 在此处实现订单处理逻辑

processedOrders.add(order); // 将已处理的订单号添加到集合中

}

}

}

}

}

4. 使用分区键:

import org.apache.kafka.clients.consumer.*;

import java.util.*;

public class KafkaConsumerDemo {

private static final String TOPIC = "order_topic";

public static void main(String[] args) {

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "order_consumer_group");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.assign(Arrays.asList(new TopicPartition(TOPIC, 0))); // 消费指定分区

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<String, String> record : records) {

// 处理接收到的消息

System.out.println("Received message from partition " + record.partition() + ": " + record.value());

}

}

}

}

这些示例代码展示了如何在Java中使用Kafka来处理订单系统中的消息,并防止重复消费。

在订单系统中,为了避免重复消费 Kafka 消息并保持幂等性,通常需要在消费端做一些特殊的处理。以下是一个简单的 Java 示例,展示如何实现幂等性和避免重复消费:

假设订单系统中有一个主题(topic)叫做 “orders”,用于接收订单消息。在这个例子中,我们使用数据库来记录已经处理过的订单,并通过订单号来保持幂等性。

import org.apache.kafka.clients.consumer.Consumer;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import java.time.Duration;

import java.util.Collections;

import java.util.Properties;

import java.util.Set;

import java.util.concurrent.ConcurrentHashMap;

public class OrderConsumer {

// 模拟数据库,用于记录已处理的订单号

private static Set<String> processedOrders = ConcurrentHashMap.newKeySet();

public static void main(String[] args) {

Properties props = new Properties();

props.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "your_kafka_bootstrap_servers");

props.put(ConsumerConfig.GROUP_ID_CONFIG, "order-consumer-group");

props.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

props.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

props.put(ConsumerConfig.ENABLE_AUTO_COMMIT_CONFIG, "false"); // 关闭自动提交

props.put(ConsumerConfig.AUTO_OFFSET_RESET_CONFIG, "earliest");

Consumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Collections.singletonList("orders"));

try {

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

// 处理订单消息

records.forEach(record -> {

String orderId = record.key();

String orderData = record.value();

// 检查订单是否已经处理过

if (!processedOrders.contains(orderId)) {

// 在这里添加业务逻辑,处理订单消息

// 记录已处理的订单号

processedOrders.add(orderId);

// 手动提交偏移量

consumer.commitSync();

} else {

// 订单已处理过,可能是重复消息

System.out.println("Order " + orderId + " has already been processed.");

}

});

}

} finally {

consumer.close();

}

}

}

在这个示例中,processedOrders 是一个用于记录已处理订单号的集合。在处理每条消息之前,我们先检查订单是否已经在集合中,如果是,则认为这是一条重复消息,不再进行处理。否则,我们执行业务逻辑,并将订单号添加到已处理集合中。

请注意,这只是一个简单的示例,实际中可能需要更复杂的幂等性保证措施,具体要根据业务逻辑和系统架构来进行设计。

kafka重复发送消息

Kafka本身是一个分布式消息系统,而消息的重复发送通常是由于网络问题、生产者重试机制或者消费者处理失败引起的。以下是可能导致消息重复发送的一些情况以及相应的解决方法:

-

网络问题:

- 情况: 网络抖动、分区领导者切换等情况可能导致生产者在发送消息时出现网络错误。

-

解决方法: 在生产者端可以通过配置适当的重试机制,确保在网络问题得到解决后可以成功发送消息。此外,Kafka自身也有一些配置可以调整,例如

retries参数,控制生产者重试次数。

-

生产者确认机制问题:

- 情况: 如果生产者在发送消息后没有收到确认(acknowledgment),可能会触发重试机制,导致消息被重复发送。

-

解决方法: 配置生产者的

acks参数来调整确认机制。设置为"all"表示等待所有分区的确认,确保消息已经成功写入所有分区后才返回。

-

消费者处理失败:

- 情况: 消费者在处理消息时发生错误,可能触发消息重复消费。

- 解决方法: 在消费者端,可以通过记录已经处理过的消息的偏移量(offset)来避免重复消费。Kafka本身也提供了自动管理偏移量的功能,确保消息被消费后会更新偏移量。

-

Exactly-Once语义:

- 情况: Kafka提供的默认语义是至少一次(at-least-once)语义,这可能导致消息在发生重试时被重复发送。

- 解决方法: 如果确保消息不会被重复发送对你的应用非常关键,可以考虑使用Kafka事务或幂等性来实现Exactly-Once语义。这需要生产者和消费者的一些特殊配置和操作。

总体来说,确保Kafka集群的配置合理,生产者和消费者的配置符合业务需求,可以最大程度地避免消息重复发送和消费的问题。在设计时,也要考虑系统的幂等性,以最大程度地减少因重试而引起的问题。

下面我将为上述可能导致消息重复发送的情况分别提供一个简单的解决方案的示例:

1. 网络问题导致的消息重复发送:

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.Properties;

public class ProducerWithRetry {

public static void main(String[] args) {

Properties props = new Properties();

props.put("bootstrap.servers", "your_kafka_bootstrap_servers");

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("acks", "all");

props.put("retries", 3); // 设置重试次数

Producer<String, String> producer = new KafkaProducer<>(props);

try {

// 发送消息

ProducerRecord<String, String> record = new ProducerRecord<>("your_topic", "key", "value");

producer.send(record);

} catch (Exception e) {

e.printStackTrace();

// 处理发送失败的情况

} finally {

producer.close();

}

}

}

2. 生产者确认机制问题:

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.Properties;

public class ProducerWithAck {

public static void main(String[] args) {

Properties props = new Properties();

props.put("bootstrap.servers", "your_kafka_bootstrap_servers");

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("acks", "all"); // 设置为"all"表示等待所有分区的确认

Producer<String, String> producer = new KafkaProducer<>(props);

try {

// 发送消息

ProducerRecord<String, String> record = new ProducerRecord<>("your_topic", "key", "value");

producer.send(record);

} catch (Exception e) {

e.printStackTrace();

// 处理发送失败的情况

} finally {

producer.close();

}

}

}

3. 消费者处理失败:

消费者的解决方案主要在于记录已经处理的消息的偏移量,并确保消费者的提交偏移量的操作在消息处理后执行。这部分通常需要在消费者的代码中实现。

4. Exactly-Once语义:

实现Exactly-Once语义通常需要涉及Kafka事务或幂等性的配置和操作,这可能会更为复杂。需要确保生产者和消费者的配置和代码逻辑符合Exactly-Once的要求。文章来源:https://www.toymoban.com/news/detail-804092.html

写在最后:针对kafka使用,各位看官如果有什么问题可以在评论区留言,我会适时补充在这篇回答下面,谢谢~文章来源地址https://www.toymoban.com/news/detail-804092.html

到了这里,关于kafka消费相关问题(GPT回答版本)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!