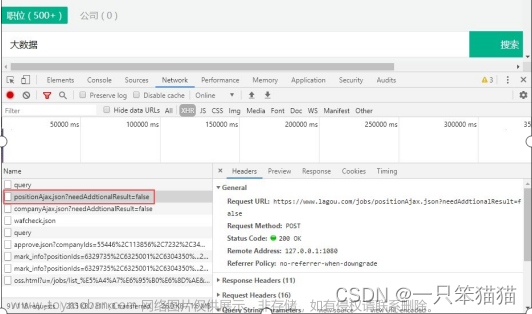

使用Python编程语言和Selenium库来实现自动化的网页操作,从而实现登录、搜索和爬取职位信息的功能。

首先,导入了所需的库,包括time用于处理时间,selenium用于模拟浏览器操作,csv用于写入CSV文件,BeautifulSoup用于解析网页数据。然后,定义了一个名为login的函数,该函数接受一个WebDriver对象和一个关键词作为参数。

在login函数中,使用WebDriver对象打开51job网站,并通过模拟用户的行为进行登录操作。登录过程中需要输入关键词并点击搜索按钮。然后,使用BeautifulSoup库解析页面源代码,找到包含职位信息的HTML元素,并逐个提取出岗位名、公司、薪资、城市、区县、行业、标签、性质、企业人数和回复等信息。将提取的信息存储在一个列表中,并通过csv库将列表中的数据写入到CSV文件中。

在主函数main中,配置了Chrome浏览器的启动选项,并创建了一个WebDriver对象。接下来,代码循环遍历不同的城市列表,在每个城市中调用login函数进行登录和职位信息的爬取。

代码的运行过程是自动化的,通过模拟浏览器操作来实现登录和搜索功能,然后从搜索结果中提取所需的职位信息,并将其保存到CSV文件中。使用Selenium库可以实现与浏览器相同的操作,包括点击按钮、输入文本、滚动页面等。

主要代码如下:文章来源:https://www.toymoban.com/news/detail-805173.html

def main():

# while True:

"""

chromeOptions 是一个配置 chrome 启动是属性的类,就是初始化

"""

option = webdriver.ChromeOptions()

"""

add_experimental_option 添加实验性质的设置参数

"""

option.add_experimental_option('excludeSwitches', ['enable-automation']) # webdriver防检测

'''

add_argument 添加启动参数

'''

# option.add_argument("--disable-blink-features=AutomationControlled")

# option.add_argument("--no-sandbox")

# option.add_argument("--disable-dev-usage")

# option.add_experimental_option("prefs", {"profile.managed_default_content_settings.images": 2})#不加载图片

"""

Chrome 配置驱动

"""

driver = webdriver.Chrome(executable_path='chromedriver.exe',options=option)

driver.set_page_load_timeout(15)

list0=[['guangzhou', '广州'], ['shanghai', '上海'], ['shenzhen', '深圳'], ['changsha', '长沙'],['chongqing','重庆']]

for k in list0:

login(driver,k)

time.sleep(15)

# driver.set_page_load_timeout(15)

# jugesd(driver)

if __name__ == '__main__':

headers = {

'User-Agent':'你的user-agent',

'Cookie':'你的cookie(一定要登录,不然久不久就会反爬验证)'}

main()

完整代码可联系我,白嫖勿扰文章来源地址https://www.toymoban.com/news/detail-805173.html

到了这里,关于基于Python的51job(前程无忧)招聘网站数据采集,通过selenium绕过网站反爬,可以采集全国各地数十万条招聘信息的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!