1 项目地址

https://github.com/THUDM/ChatGLM3

简介:ChatGLM3 是智谱AI和清华大学 KEG 实验室联合发布的新一代对话预训练模型。

2 本机配置

台式机:

CPU: Intel(R) Core(TM) i7-10700F

RAM: 32G

GPU: NVIDIA RTX3060(显存12G)

OS: Windows 10 企业版

3 部署环境

3.1 使用anaconda3进行虚拟环境管理

3.1.1 安装和配置anaconda3

a.下载地址

anaconda3下载(推荐使用镜像源)

https://mirrors.tuna.tsinghua.edu.cn/anaconda/archive/

b.安装

双击安装。我的安装路径:D:\worksoft\anaconda3

c. 配置环境变量

path 中添加环境变量:

D:\worksoft\anaconda3

D:\worksoft\anaconda3\Scripts

D:\worksoft\anaconda3\Library\mingw-w64\bin

3.1.2 操作虚拟环境:

在powershell的命令行中操作(当然也pycharm的terminal中操作,下文有讲解)

打开powershell的命令行窗口

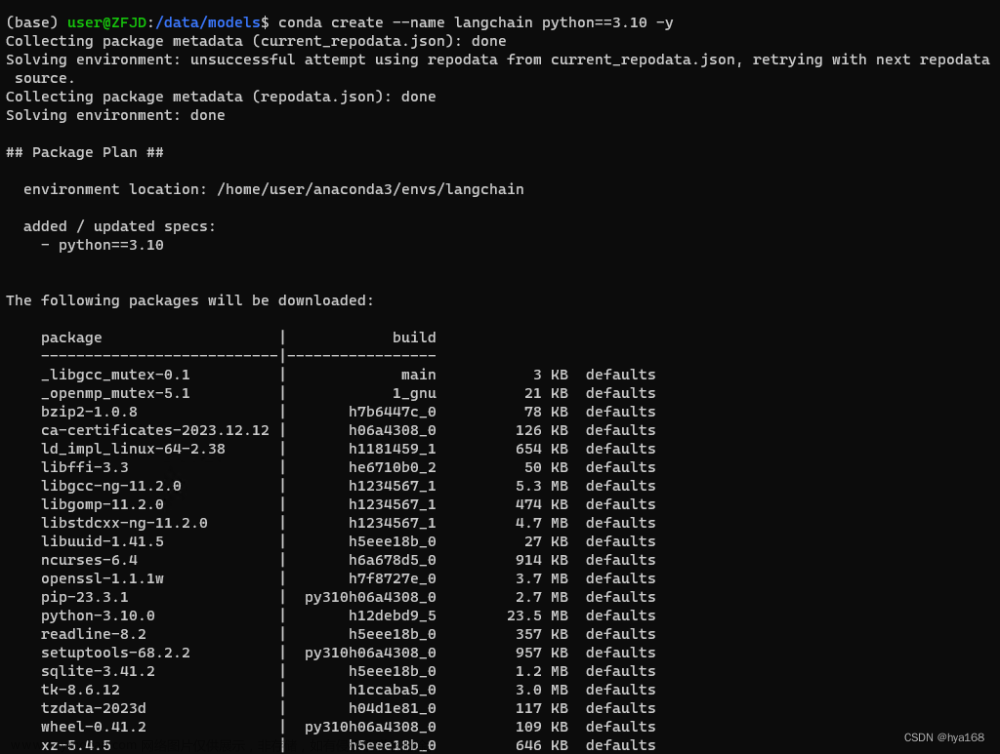

a.创建虚拟环境

conda create -n ChatGML3 python=3.11

注:这里指定了python的版本,你也可以不指定。如:conda create -n ChatGML3 这样的话,就使用anaconda自带的python版本

b.激活

conda activate ChatGML3

c.退出虚拟环境

conda deactivate

d.删除虚拟环境

conda remove -n ChatGML3

3.2 配置git命令运行环境

无论是GitHub还是Hugging Face,都是使用git进行克隆比较方便。 另外一个非常重要一点的,在windows运行一些命令行,需要用git中的sh.exe组件的。所以这里需要安装git

git下载,

https://git-scm.com/

自行下载和安装。这里就不在详解了;

3.3 安装显卡驱动,以及CUDA计算工具

a.显卡信息查看

pytorch安装和显卡驱动版本有关,所以需要先检查显卡驱动版本,可以用命令查看

nvidia-smi

b.查看驱动

可以到网址https://docs.nvidia.com/cuda/cuda-toolkit-release-notes/index.html查看支持的CUDA版本

c.安装数据处理工具pytorch

pytorch安装,直接到官网https://pytorch.org/选择conda或者pip,并复制代码安装即可

我这里是anaconda环境的。cuda的版本是11.8

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia

d.检查cuda驱动是否安装成功

conda activate ChatGML3 # 已经在虚拟环境下就不用运行这行

python # 进入python

import torch # 引入库

torch.cuda.is_available() # 查看cuda是否可用。如果为TRUE为驱动正常

exit() # 退出python文章来源:https://www.toymoban.com/news/detail-806653.html

4 项目部署

4.1 下载ChatGLM3项目并安装依赖

cd F:\ai\

git clone https://github.com/THUDM/ChatGLM3 # 从GitHub仓库克隆

cd ChatGLM3 # 转到已经下载好的文件目录中

pip install -r requirements.txt # 安装依赖4.2 下载模型

git lfs install # 验证一下lfs是否安装正确

git clone https://huggingface.co/THUDM/chatglm3-6b # 下载模型

注:如果下载的慢的话,可以去魔塔社区去下载(https://modelscope.cn/)5 项目运行

管理员模式运行Anaconda Powershell,激活env,转到ChatGLM3中,运行basic_demo文件夹内的cli_demo.py(需要终止时可以用Ctrl+C中断python)文章来源地址https://www.toymoban.com/news/detail-806653.html

conda activate ChatGLM3

cd F:\ai\ChatGLM3

python .\basic_demo\cli_demo.py # 运行当前文件夹下的basic_demo\cli_demo.py到了这里,关于ChatGLM3在windows上部署的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!