1.背景介绍

人工智能(Artificial Intelligence, AI)是一门研究如何让计算机模拟人类智能的科学。在过去的几十年里,人工智能技术已经取得了显著的进展,例如机器学习、深度学习、自然语言处理、计算机视觉等。然而,这些技术仍然存在一个重要的问题:它们的决策过程通常是不可解释的,这意味着人们无法理解这些算法如何到达某个决策。这种不可解释性可能导致许多问题,例如隐私问题、法律问题、道德问题和可靠性问题。

为了解决这个问题,人工智能社区开始关注可解释性(Explainable AI, XAI)。可解释性是一种人工智能技术,旨在提供关于算法如何到达某个决策的信息。这可以帮助人们更好地理解和信任人工智能系统。

在本文中,我们将讨论可解释性的核心概念、算法原理、实例和未来趋势。我们将从以下几个方面入手:

- 背景介绍

- 核心概念与联系

- 核心算法原理和具体操作步骤以及数学模型公式详细讲解

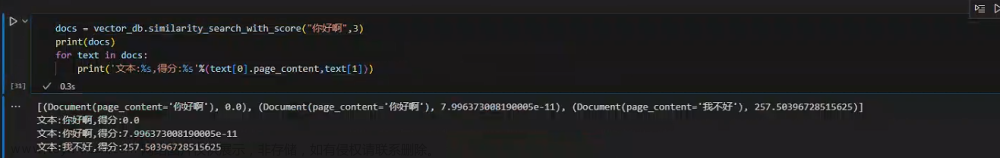

- 具体代码实例和详细解释说明

- 未来发展趋势与挑战

- 附录常见问题与解答

2.核心概念与联系

在本节中,我们将介绍可解释性的核心概念,包括解释、可解释性、解释性模型、解释性方法和解释性度量。

2.1 解释

解释(interpretation)是对某个现象或事物的理解和说明。在人工智能领域,解释通常用于描述模型如何到达某个预测或决策。解释可以是数学的,例如公式、方程、函数等,也可以是非数学的,例如自然语言文本、图表、图像等。文章来源:https://www.toymoban.com/news/detail-807689.html

2.2 可解释性

可解释性(ex文章来源地址https://www.toymoban.com/news/detail-807689.html

到了这里,关于人工智能入门实战:如何在人工智能中实施可解释性的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!