0、基本信息

- 作者:Chen Qian, Huayi Tang, Zhirui Yang

- 文章链接:Can Large Language Models Empower Molecular Property Prediction?

- 代码链接:Can Large Language Models Empower Molecular Property Prediction?

1、研究动机

分子属性预测得到巨大的关注,分子图能够被描述为图结构的数据或SMILES (Simplified Molecular-Input Line-Entry System)文本。LLMs的快速发展给NLP领域带来颠覆性变化,但是,LLM如何影响分子性质预测的探索仍处于早期阶段。

本文,从两个视角——零样本和少样本分子分类,通过LLMs生成分子原始SMILESD的新解释。

- 首先提示LLM进行上下文分子分类并评估其性能。

- 然后,我们使用LLM为原始SMILES生成语义丰富的分析和解释。文本解释可以作为分子的新表征。

- 最后,利用它来微调多个下游任务的小规模LM模型

2、创新性

由于分子可以表示为SMILES序列,因此使用具有强大文本理解能力的LLM来处理分子数据是一个不错的想法。简而言之,大模型在分子预测任务上的迁移。

例如,对于给定分子的SMILES,ChatGPT可以准确地描述分子的功能组、化学性质和潜在的药物应用。如下图所示。

基本思想:

对于所给的SMILES序列,设计合理的提示,提示LLM进行zero/few-shot 分类,并总结出新的表征,即Caption as new Representation,用新的表征在下游任务上微调小规模LMs。

3、方法论

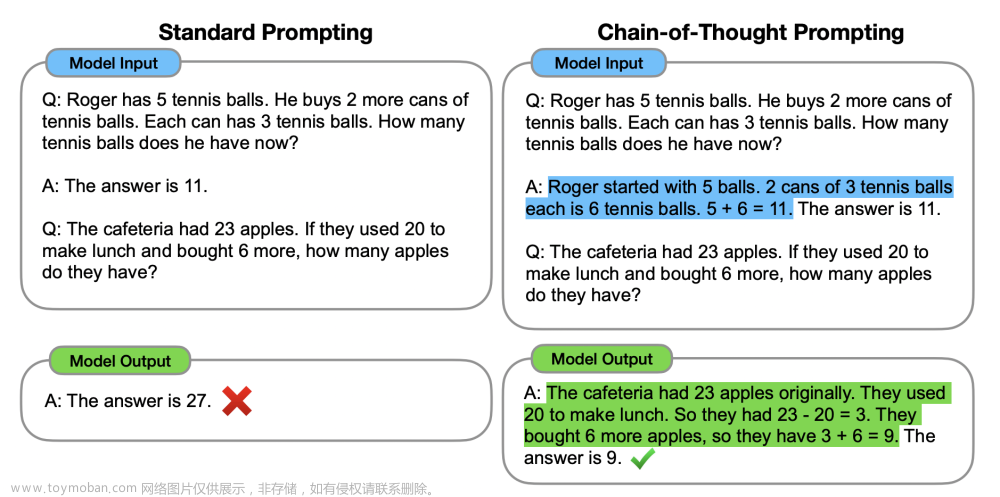

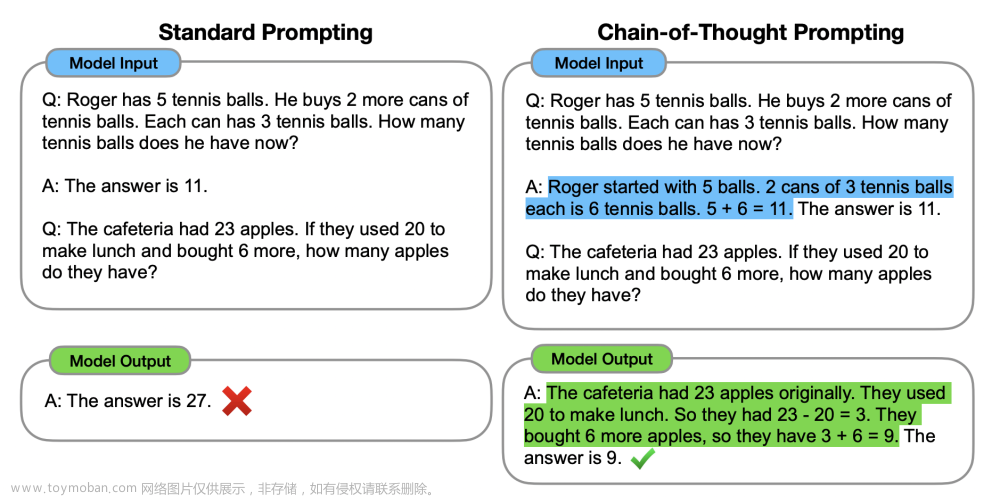

情境学习(ICL)已经成为NLP的新范式。使用包含以自然语言模板编写的多个示例作为输入的上下文,LLM可以对未看到的输入进预测,而不需要额外的参数更新。利用ChatGPT的ICL能力,通过设计的提示来帮助分子分类任务,如下图所示。

这种模式使得通过改变演示和模板将人类知识融入LLM变得更加容易。

在PTC数据集上,使用“毒性”、“癌症”和“有害”等术语进行关键字搜索,以检索ChatGPT为原始SMILES格式PTC数据集生成的所有解释。值得注意的是,观察到这些关键字中的大多数主要出现在标记为-1的条目中。这表明ChatGPT能够为原始SMILES字符串提供有意义和独特的专业解释,从而使下游任务受益。

总之,利用ChatGPT来理解原始SMILES字符串并生成包含各个方面的文本描述;然后,微调预训练的小规模LM用于各种下游任务,例如分子分类和性质预测。文章来源:https://www.toymoban.com/news/detail-808052.html

4、实验结果

ChatGPT具有一定水平的少样本分子分类能力。然而,在整个实验中,发现ChatGPT的分类性能并不一致,对于相同的提示,不同的提示也有显着的影响的结果。因此,设计有效的提示,并聚合合理的先验信息实现更好的零样本和少样本分类至关重要的.文章来源地址https://www.toymoban.com/news/detail-808052.html

到了这里,关于【论文阅读】Can Large Language Models Empower Molecular Property Prediction?的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文阅读笔记77]LoRA:Low-Rank Adaptation of Large Language Models](https://imgs.yssmx.com/Uploads/2024/02/740494-1.png)

![[论文阅读笔记] TRACE: A Comprehensive Benchmark for Continual Learning In Large Language Models](https://imgs.yssmx.com/Uploads/2024/01/801421-1.png)

![[arxiv论文阅读] LiDAR-LLM: Exploring the Potential of Large Language Models for 3D LiDAR Understanding](https://imgs.yssmx.com/Uploads/2024/02/785864-1.png)