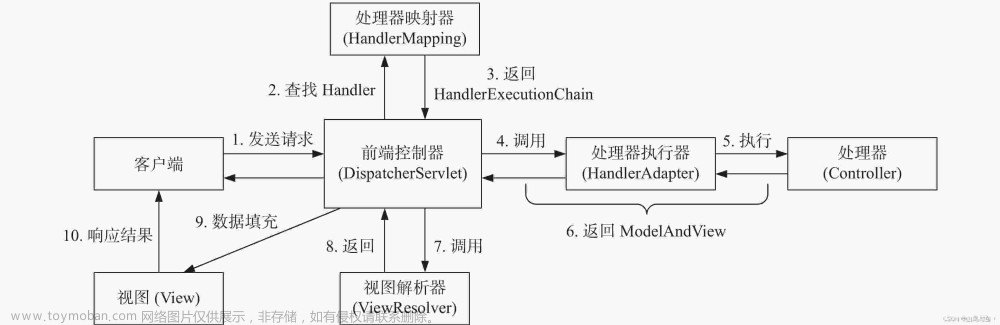

Apache Spark 架构设计是其高效、分布式处理能力的基础。Spark 的架构主要包括以下几个核心组件:

-

Driver Program(驱动器)

- 驱动器程序负责执行用户的主函数,创建 SparkContext 对象。

- 它负责构建并优化 DAG(有向无环图),表示 RDD(弹性分布式数据集)操作的执行计划。

- 驱动器还负责任务的调度,并与集群管理器(如 Hadoop YARN、Apache Mesos 或 Standalone 模式下的 Master 节点)进行通信以获取和分配资源。

-

Cluster Manager(集群管理器)

- 集群管理器是整个集群资源的管理者,根据应用需求分配执行作业所需的计算资源。

- 在不同的部署模式下,集群管理器可以是 Hadoop YARN、Mesos、Kubernetes 或 Spark 自带的 Standalone 模式。

-

Executor(执行器)

- 执行器在集群中的每个工作节点上运行,由 Driver 程序启动并与之通信。

- Executor 为应用程序提供了一块内存空间(包括存储区域和计算区域),用于缓存数据和执行实际的数据处理任务。

- 执行器之间可以直接通过网络通信交换数据,从而实现高效的数据共享和协同计算。

-

Task(任务)

- Task 是 Spark 计算的基本单位,由 Driver 分配给 Executor 执行。

- 当 RDD 进行转换或行动操作时,DAG 调度器会将这些操作分解成多个任务并在 Executor 上并发执行。

-

RDD(弹性分布式数据集)

- RDD 是 Spark 提供的核心抽象,代表了分布在集群中不同节点上的不可变、可分区的数据集合。

- RDD 支持两种类型的算子:转换(Transformation)和动作(Action)。转换不会立即执行,而是构建 DAG;而动作触发 DAG 的执行,并从集群中收集结果。

-

DAG Scheduler(DAG 调度器)

- 在 Driver 中,DAG 调度器将多个转换操作合并成阶段(Stage),并生成任务集提交给底层的任务调度器(TaskScheduler)进一步执行。

-

TaskScheduler(任务调度器)

- 根据 DAG 调度器提供的任务集,任务调度器与集群管理器交互,将任务分配到各个可用的 Executor 上执行。

通过上述组件的协作,Spark 实现了一个高度灵活且容错性强的大数据处理框架,能够支持批处理、流处理、机器学习等多种应用场景。

Apache Spark 的工作流程主要包括以下步骤:

-

启动Spark应用程序

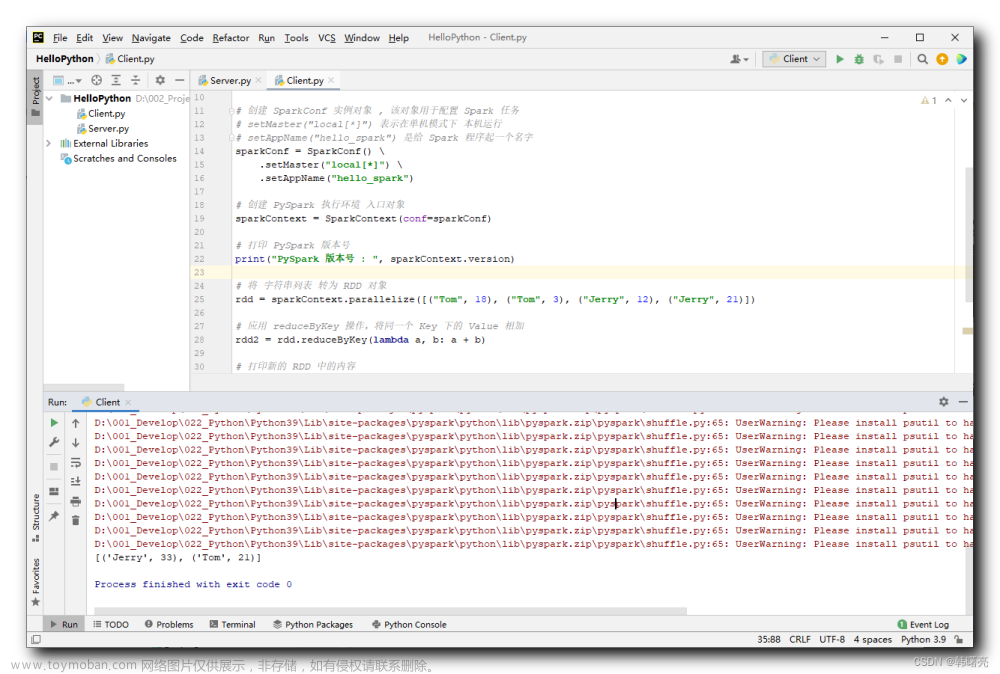

- 用户通过编写一个主函数,创建

SparkContext对象。这个对象是与Spark集群交互的入口点。

- 用户通过编写一个主函数,创建

-

构建RDD(弹性分布式数据集)

- 用户定义或从外部数据源读取数据,生成初始的 RDD。可以通过对基础数据集执行转换操作(Transformation)来生成新的 RDD。

-

DAG构建和优化

- 每个 RDD 转换操作都会被记录下来,并形成一个有向无环图(DAG)。在用户调用行动操作(Action)触发计算时,Spark 的 DAG Scheduler 将会根据血缘关系分析并优化这个图,将其拆分成一系列阶段(Stage),每个阶段由一组可以并行执行的任务(Task)组成。

-

任务调度与分配

- 优化后的 DAG 被提交给 TaskScheduler,TaskScheduler 与 Cluster Manager 协作,将各个任务分配到集群中的 Executor 上执行。

- Executor 在其所在的工作节点上为应用启动进程,维护一块内存空间用于存储和计算数据。

-

任务执行

- 分配到 Executor 的任务开始执行,在Executor的内存中处理数据。如果数据量超过内存大小,Spark还支持磁盘存储或外存存储,如Hadoop HDFS等。

-

数据交换与缓存

- 如果不同任务之间需要共享数据,Spark 可以通过网络进行数据交换,同时支持数据缓存于内存、磁盘或持久化到外部存储系统,以便后续复用。

-

结果收集与返回

- 当所有任务完成后,行动操作的结果会被收集并返回给 Driver 程序。对于某些行动操作,例如 count 或 collect,Driver 会等待所有任务完成并将结果合并。

-

容错处理文章来源:https://www.toymoban.com/news/detail-809111.html

- 在整个过程中,Spark 提供了容错机制,包括 RDD 的 lineage 信息记录和 Checkpointing 功能,当节点失败时能够重新计算丢失的数据块。

总结来说,Spark 工作流程的核心就是:从驱动器程序发起计算请求,构建和优化计算逻辑,然后通过分布式执行器高效地在集群中执行任务,并最终将结果汇集回驱动器。文章来源地址https://www.toymoban.com/news/detail-809111.html

到了这里,关于大数据之Spark架构设计与工作流程的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!