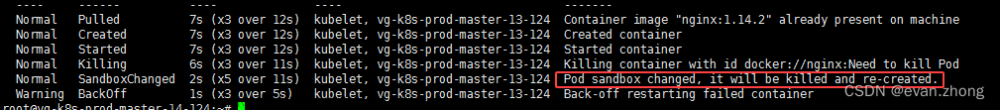

K8S集群中Pod资源处于CrashLoopBackOff状态排查思路

1.Pod资源处于CrashLoopBackOff状态的原因

CrashLoopBackOff状态一般都是Pod资源中的容器出现了问题,可以有以下几点原因:

- 容器中部署的程序存在Bug,无法正常启动,就会出现此状态,可以查询容器的启动日志,从日志中获取重要线索,逐个进行排查。

- 定义Pod资源时,对于Pod中的容器进行了资源限额,可能限额的资源不够容器使用,就会导致Pod处于此状态。

CrashLoopBackOff状态存在偶发性,可能上一秒还是Running状态,下一秒就成了CrashLoopBackOff状态了。文章来源:https://www.toymoban.com/news/detail-809839.html

一般Pod文章来源地址https://www.toymoban.com/news/detail-809839.html

到了这里,关于K8S集群中Pod资源处于CrashLoopBackOff状态排查思路的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!