参考:

https://github.com/vllm-project/vllm

https://zhuanlan.zhihu.com/p/645732302

https://vllm.readthedocs.io/en/latest/getting_started/quickstart.html ##文档

1、vLLM

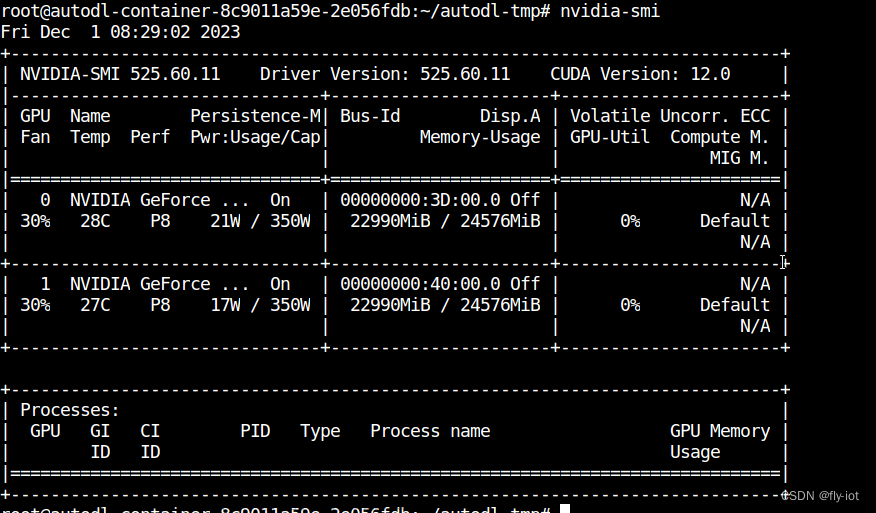

这里使用的cuda版本是11.4,tesla T4卡

加速原理:

PagedAttention,主要是利用kv缓存 文章来源:https://www.toymoban.com/news/detail-809915.html

文章来源:https://www.toymoban.com/news/detail-809915.html

2、qwen测试使用:

注意:用最新的qwen 7B v1.1版本的话,vllm要升级到最新0.2.0才可以(https://modelscope.cn/models/qwen/Qwen-7B-Chat/summary)

注意更改:–dtype=half文章来源地址https://www.toymoban.com/news/detail-809915.html

python -m vllm.entrypoints到了这里,关于LLM大模型推理加速 vLLM;docker推理大模型;Qwen vLLM使用案例;模型生成速度吞吐量计算的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!