Lugmayr A, Danelljan M, Romero A, et al. Repaint: Inpainting using denoising diffusion probabilistic models[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022: 11461-11471.

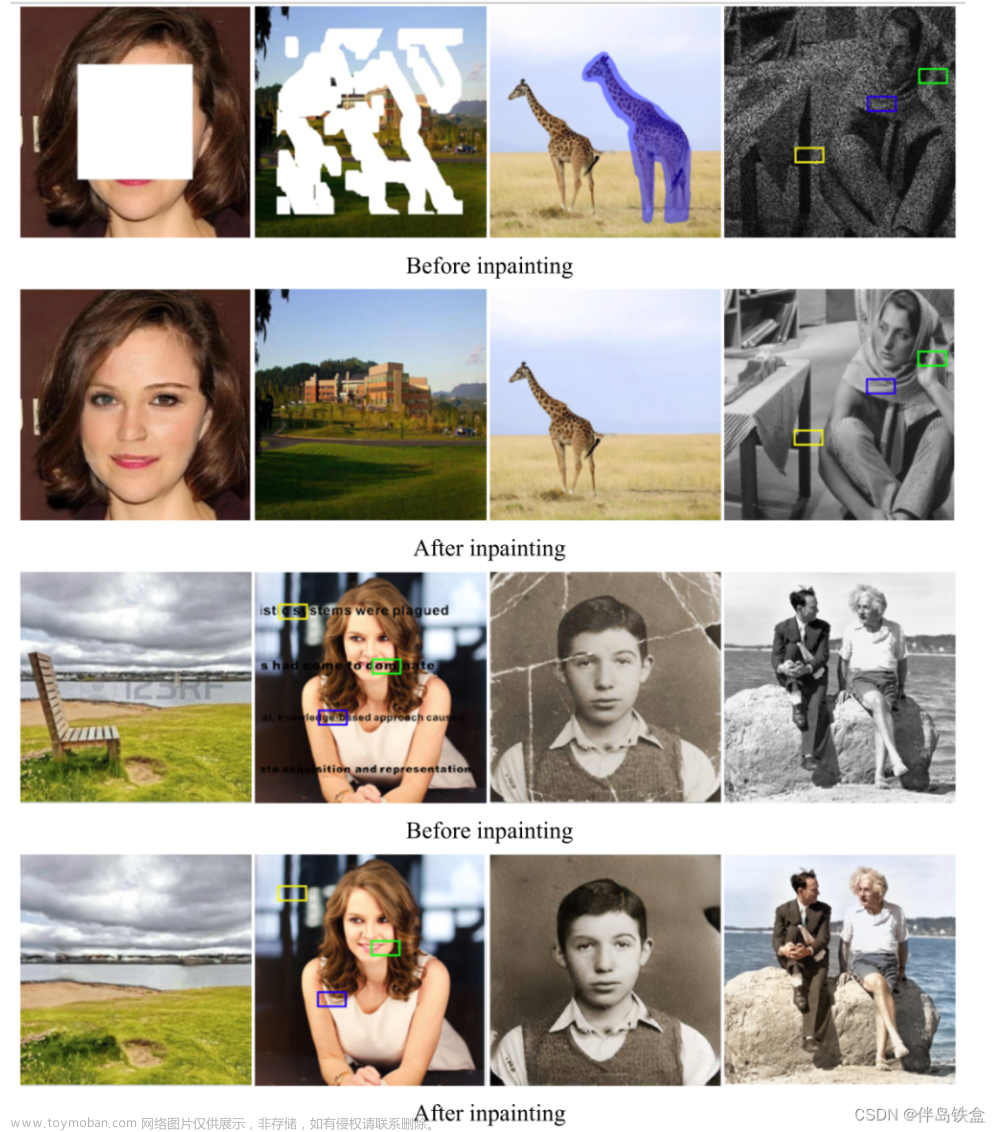

效果展示

左图展示了masked image逐步去噪的过程;右图展示了基于扩散模型的Inpainting方法生成图片的多样性。

摘要

现有方法的问题:(1) 大部分方法都只在特定类型的mask上训练,对于任意的mask缺少泛化能力;(2) 模型只能匹配简单的纹理,缺少对高层次语义信息的理解。为此本文提出了基于扩散模型的Inpainting方法,对任意形状的mask具有良好的泛化能力,同时生成内容具有多样性,生成效果优于基于GAN和AR的方法。

背景介绍

图像Inpainting任务的要求:(1) 生成内容与背景内容相互协调,纹理一致; (2) 生成内容在语义上是合理的。扩散模型展现了强大的图像生成能力,因此本文尝试把它用在inpainting任务上。如果直接使用扩散模型原始的采样策略,能够满足要求(1),但生成内容在语义上通常是错误的,难以满足要求(2)。为了解决这个问题,本文提出了一种Resample的去噪策略(这也是论文方法叫RePaint的原因)。

相关工作

基于GAN的Inpainting方法:能生成确定性内容,缺少多样性;基于VAE的Inpainting方法:需要在生成能力和多样性之间追求trade-off。

方法

主要回答两个问题:

(1) 怎么把扩散模型用在Inpainting任务上?A: Conditioning on the known Region.

(2) 针对Inpainting任务本身的特性,对去噪过程做了改进?A: Resample.

Conditioning on the known Region

原始的扩散模型回顾

扩散模型分为前向加噪和反向去噪过程。前向加噪:给定输入图像和任意时间步t,t时刻的噪声图像,可以直接计算得到:

反向去噪:给定t时刻的噪声图像,利用神经网络估计t时刻噪声,便能得到去噪后的t-1时刻的图像。重复去噪过程便能得到最终想要的去噪图像。

训练的时候,给定输入图片,先给图片加噪,然后将噪声图片输入模型,模型预测噪声,最后将预测噪声和真实加入的噪声计算MSE loss。

预测的时候,输入随机噪声图像 ,模型预测噪声,计算得到去噪图像 ,重复去噪过程直至得到想要的图像。

扩散模型应用在Inpainting任务上

整体pipeline如图所示,对于给定的输入图片 和mask区域

(1) 对进行前向加噪,得到噪声图像;

(2) 对进行反向去噪,将输入训练好的扩散模型预测噪声,得到;

(3) 更新 :mask区域使用模型预测得到的,非mask区域使用前向加噪得到的 (已知和时间步t-1,便可直接计算得到t-1时刻的噪声图像)

(4) 新的再进入下一次的去噪过程。

Resample

如下图所示,只使用上述方法,模型能够生成相似的纹理,但是却不能保证语义上的正确性(没有理解应该生成一只完整的【狗】)。

究其原因,是因为在去噪的过程中加入了已知噪声的背景图像,但是这部分图像和模型生成的图像,只是简单的拼接到一起,两者没有产生任何交互,然后在下一次去噪的时候又是各去各的。

解决方法:Resample,就是在Pipeline中的步骤(3)之后,先跑几步前向加噪,然后再进行下一次去噪。改进效果如下图所示,额外加噪步数一般到10对性能的提升就饱和了。

实验

实验从对mask的鲁棒性、生成结果的多样性、语义上的正确性三方面进行评价。在人脸和通用场景上验证,分别在CelebA-HQ和ImageNet数据集上进行。ImageNet使用现成的预训练模型,CelebA-HQ则重新训练了一个预训练模型。图片尺寸256,去噪步数为256,其中进行resampling的次数为10,每次resample前向加噪的jumpy size为10。不用针对mask做额外训练,直接使用DDPM训练好的图像生成模型(也可以加类别引导)。

评价指标

(1) LPIPS:原图和生成图片过AlexNet得到特征,对比两个特征的distance,越小越好。这个指标不太准,如下图,重绘幅度较大,LPIPS大,但效果其实是好的。

(2) User Study:实验人员给不同方法生成的实验结果图打分,每张测试图片综合5个人的打分结果。

实验结果

横排是不同的mask类型,纵列是不同的方法,DSI和ICT都是基于AR的方法,AOT、DeepFillv2和LaMa都是基于GAN的方法。可以看到,在LPIPS指标上,本文方法均较低。对Usesr Study,以本文方法作为基准(100%),其它方法的票数百分比均低于本文方法。

定性效果

文章来源:https://www.toymoban.com/news/detail-811830.html

文章来源:https://www.toymoban.com/news/detail-811830.html

总结

使用训练好的扩散模型,在去噪过程中加入mask和resample策略,适配inpainting任务。文章来源地址https://www.toymoban.com/news/detail-811830.html

到了这里,关于论文阅读 | RePaint: Inpainting using Denoising Diffusion Probabilistic Models的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!