👀日报&周刊合集 | 🎡生产力工具与行业应用大全 | 🧡 点赞关注评论拜托啦!

🉑 支付宝 X 堆友 | 新春音浪 AIGC 贺岁MV大赛,奖金池很有诚意啊!

https://d.design/competition/alipay-spring

补充一份背景:堆友 (D.Design) 是阿里巴巴推出的一个新的在线设计平台

支付宝和堆友联合推出了一场 AIGC 视频创作比赛,邀请创作者使用AI工具创作贺岁 MV,并提供了丰厚的奖金池 (* ̄3 ̄)╭ 而且不限工具、不限风格、时间充裕!感觉有时间可以玩一玩~

比赛分为「大众组」和「学生组」,设置了近百个获奖名额、总共23万元的奖金池!堆友的比赛一直主打奖品丰厚!每次都超心动啊~ ⋙ 了解更多

征集时间:1月8日-2月18日

视频时长:建议30秒以上

创作要求:可以使用 Stable Diffusion、Midjourney 等任意AI工具生成图片或视频,允许使用PS、剪映等工具进行编辑;提供创作说明、Prompt、创作过程等可作为评审加权参考

👀 Runway GEN:48 | 第二届48小时AI短片创作比赛,开放报名啦!

https://gen48.runwayml.com

补充一份背景:Runway 是一款强大的、基于AI的图片&视频编辑工具;GEN:48 是 Runway 举办的一个AI短片创作挑战比赛,今年已经是第二次举办

Runway GEN:48 全称是 Runway GEN 48 Hour Short Film Competition,是一场面向全球的线上创作比赛。比赛主题和创作要求在开赛时宣布,届时参赛者需要在48小时内构思并创作一部 1~4 分钟的电影短片。

参赛时间:2月3日-2月5日

每队人数:1-3 人

参赛激励:参赛团队可得到 30万 Runway 生成积分用于比赛创作

获奖作品:5000 美元,100万 Runway 生成积分,Epidemic Sound 一年会员,作品在 NYC 和 LA 的AI电影节上放映

🉑 重要投资 | a16z 向 Quora 投资 7500 万美元,Poe 估值达到5亿美元

https://quorablog.quora.com/New-Funding-from-Andreessen-Horowitz

补充一份背景:Quora 是全球知名的在线问答社区,类似于海外版「知乎」;Poe 是 Quora 推出的AI聊天机器人聚合平台,几个月前允许用户创作 Bot 并可以盈利 (一定程度上类似 OpenAI GPTs)

2024年1月10日,Quora CEO @Adam D’Angelo 宣布,Quora 从 a16z 获得了新一轮 7500 万美元的融资,用以加速 Poe 平台的增长。Adam D’Angelo 专门提到,本次融资后的大部分资金将用于奖励 Poe 平台的 Bot 创作者,帮助个人开发者和开发团队在 Poe 平台实现盈利,并借此将AI推广向更广泛的人群。

在 Adam D’Angelo 看来,AI 时代的 Poe 定位类似于互联网早期的浏览器,需要完成两个目标:成为消费者与各种AI产品交流的最佳方式 & 成为开发者构建AI聊天产品并触达大众的最简单的方式。

公告披露了一些基础数据,例如Poe 总用户 (付费用户+免费用户) 已超百万,创建的 Bot 已经有数百万个;Quora 月活超4亿且有着健康的现金流,公司将同时运营 Quora 和 Poe 两个产品

https://a16z.com/announcement/investing-in-quora-and-poe/

a16z 在其官方网站发文确认了这一信息,并给出了详细的投资理由。日报将其总结为以下5个方面,可以看出投资人非常专业且务实,而且给同类型内容平台指出了发展方向:

市场潜力:尽管AI模型和工具的发展迅速,但普通消费者对AI的接触仍然有限;Poe 可以帮助全球5亿+互联网用户更容易地访问和使用AI

聚合多个大模型:Poe 聚合了全球领先的多个大模型,包括 OpenAI GPT 系列、Anthropic Claude系列、Google Gemini / PaLM、Meta Llama 2、StableDiffusionXL、Mistral 等等,更符合用户的多模型需求场景

创建并使用 Bot:创作者可以使用现有模型构建 Bot 并从中获益,用户可以发现 AI Bot 并自定义工具集,双方可以形成网络效应

Quora 社区优势:Quora 社区有着超过4亿优质用户并沉淀了大量专业知识,并且为 AI Bot 提供了一个独特且大流量的分发渠道

团队&发展速度:Poe 团队在短时间内实现了快速发展,包括支持了多种语言、开发了PDF摘要等功能、实现了创作者盈利、推出了 iOS、Android 和 Windows 版本应用等

👀 收藏清单 | AI工程师都应了解的生成式AI框架和工具

https://levelup.gitconnected.com/gen-ai-frameworks-and-tools-every-ai-ml-engineer-should-know-1f0ce36f1452

生成式人工智能 (Generative AI) 常用的框架和工具有哪些?看看这篇文章的总结!!AI工程师的效率宝藏大起底,快快加入自己的工具清单~

- LangChain

用途:开源平台,用于构建基于大语言模型 (LLM) 的应用程序,例如 ChatGPT 聊天机器人

功能:提供了一套全面的套件,可以在不同用例中使用大语言模型,例如聊天机器人、自动问答、文本摘要等

工作流程:括将大量数据分解成小块,嵌入向量并存储在向量数据库中;用户输入提示后,LangChain 使用大语言模型检索相关信息并生成回答

- SingleStore Notebooks

基于Jupyter Notebook的工具,专为 SingleStore 分布式 SQL 数据库而设计

特点:提供了原生的 SingleStore SQL支持,支持 SQL 和 Python 的互操作性,支持协作工作流程,提供了交互式数据可视化支持,对于新手易用

用途:数据探索和分析,特别是与 SingleStore 数据库一起使用

- LlamaIndex

用途:高级编排框架,增强大语言模型的能力,允许它们与私有或特定领域的数据源交互

功能:提供了一种结构化的方式来摄取、组织和利用各种数据源,包括 APIs、数据库和 PDFs

工作流程:通过将数据索引为大语言模型优化的格式,LlamaIndex 使得用户能够通过自然语言查询与他们的私有数据无缝对话

- Meta Llama 2

背景:使用公开在线数据进行预训练,其中包括书籍、文章、其他书面内容等大量语料库

用途:用于聊天机器人的集成,提供了细致且连贯的对话响应

特点:通过 RLHF 进行监督微调和强化学习,包括拒绝采样和近端策略优化 (PPO) ,提升了规模、效率和性能,,适用于不同的计算能力和应用场景

- Hugging Face

平台:提供了模型中心、数据集、模型训练、微调工具、应用构建、社区和协作等功能

功能:拥有大量预训练模型,覆盖了文本分类、问答、翻译和文本生成等多种 NLP 任务

用途:提供了丰富的数据集资源,支持模型的训练和微调;与 TensorFlow 和 PyTorch 等流行编程库无缝集成,便于开发AI应用

- Haystack

类别:端到端框架,用于构建基于 NLP 技术的应用,包括但不限于生成式AI

功能:支持检索增强生成 (RAG) 、提供一套全面的 NLP 工具和组件、灵活&可扩展

用途:结合检索&生成方法进行搜索和内容创建,提供全面的 NLP 工具和组件,并且能与流行的生成式AI模型进行集成

🉑 播客推荐 | 42章经:24/25 年是下一代浪潮最关键的两年

https://www.xiaoyuzhoufm.com/episode/65a2a75fb5e4856c70801eba

补充一份背景:42章经的播客品质都非常高!尤其关于AI的几期播客,频繁出现在我们的播放、收藏和推荐清单里 🔍

这期播客是 42章经 创始人 @曲凯 的个人年终总结。2023年,他聊过了市场上大部分的 AI 创始人和几乎所有的 AI 投资人,服务了十多家 AI 公司的融资并且参与了其中四家的投资,视角可谓一线且全面。

在这期播客中,他毫无保留地分享了对于 23 年 AI 市场的总结观察,以及对 24 年及之后市场变化趋势的判断。他的一个核心观点是: 24年和25 年就是我们这代人最关键的两年的机会。

这期播客评论区,有大量优质留言&曲凯的互动,推荐推荐!这个时代有大量的优秀团队在瞄着AI赛道呀~ [摩拳擦掌👏]

0:20 24、25 年会是下一代浪潮最关键的两年

7:51 当下市场的核心问题:AI 并不能被称为一个「赛道」

9:16 创业者要解决的核心问题从「如何讲故事拿融资」变成了「如何靠自己赚钱做收入利润」

11:18 解决大模型可控性差的三条路径

14:29 技术不成熟的阶段,反而更需要好的产品经理

16:22 2024 会不会是 AI 时代的 2010 (移动互联网元年)?

18:36 一个判断:24 年会出现大规模落地的产品,25 年 AI 会迎来爆发

19:11 当下一定要接受的两个设定

24:00 一些未来的方向和机会

37:45 2024 年我们判断公司和选择项目的标准

🔔 精华整理汇总

历史上没有哪个赛道能够像这波AI一样,迅速建立极大的共识,但又同时存在非常大的非共识。共识是AI是个非常颠覆性创新的大机会,非共识则是 AI 到底会在什么时候以哪种方式落地

2023年是对大多创业者非常不友好的一年:市场还早,变化很快,投资团队最终选择投资「人」而不是AI。最后拿钱的团队很多不是靠着逻辑、故事、产品或数据,反而是靠着创始人背景融资

为什么2023年没有AI产品能够落地呢?关键还是大模型的可控性差。解决大模型可控性差有三条路径:

交付结果。典型公司是 Fancytech。在自己体系内部用 AI 和人工结合的方式来操作,不让客户直接和产品发生交互

区分生产端和消费端。典型公司是 S2B2C 类企业。让 AI 只和生产环节发生关系,不和消费环节发生关系

收敛场景、有限使用。典型公司是妙鸭。AI 产品落地要么选择一些已经可控性比较高的场景,要么就是让 AI 和其他各种现有的技术配合

当下需要要接受的两个设定:

市场还早,大模型能力未达标,现在能落地能赚钱的公司大多是套壳的、擦边的、蹭的,真信 AGI,真想做 AI 的大多都在痛苦挣扎

目前市场上所有的产品都将成为先烈和炮灰。大部分产品会随着时间发展而淘汰,小部分产品会逐渐升级迭代成完全不同的逻辑 (不过这些迭代,大概率会发生在已有的公司和团队内部)

新一代创业者要充分认识,市场核心矛盾是如何把产品做到落地赚钱,在一两年里能把公司体量和组织结构养起来,然后随着技术的成熟而不断迭代产品和市场

一些未来的方向和机会:

所有的现存外包场景都有机会用AI的方式和组织结构重做一遍,并扩大 N 倍

大多的双边平台都有机会被 AI改造,非标服务可被 AI 标准化,生成式内容可把双边平台变成单边即可成立并快速起量

大多的复杂产品和交互形态都有机会被 AI Agent 简化成聊天类产品交付,大幅降低使用门槛

内容生成即渠道,解构渠道,未来 AI 时代内容生产和消费形式将发生颠覆性的变化 ⋙ 文字版原文

🉑 RAG 要点速查 | 一图掌握 RAG「从基础到进阶」完整内容

https://d3ddy8balm3goa.cloudfront.net/llamaindex/rag-cheat-sheet-final.svg

补充一份背景:RAG (Retrieval-Augmented Generation,检索增强生成) ,从外部知识数据库检索文档 (Retrieval component) 并将这些文档与用户的查询一起传递给大语言模型 (LLM) 以生成响应 (Generation component)

这份速查表介绍了 RAG 的作用、RAG 基础用法、RAG 高级用法 这三部分的要点内容。日报将主要内容整理成中文,👆 上方链接可下载 svg 高清文件~

🔔 Motivation

大语言模型 (LLM) 生成的答案可能不准确,因为

LLM 可能会产生幻觉 (hallucinations)

相关信息可能超出了 LLM 训练语料库的范围

LLM 无法访问最新的信息

🔔 Basic RAG

Basic RAG 部分提到的能力和技术,是构建一个有效 RAG 系统的基础,可以提高系统在理解和回答问题时的准确性和相关性。

关键能力 (Key Abilities)

噪声鲁棒性 (Noise Robustness):系统需要能够处理和过滤掉噪声数据,确保生成的信息质量

负拒绝 (Negative Rejection):系统应该能够识别并拒绝不相关或错误的信息

信息整合 (Information Integration):系统需要能够整合来自不同来源的信息,以提供全面的答案

反事实鲁棒性 (Counterfactual Robustness):系统需要能够处理与训练数据分布不同的情境,即能够对反事实情况进行推理

质量评分标准 (Quality Scores)

上下文相关性 (Context Relevance):生成的答案需要与用户问题的上下文紧密相关

答案相关性 (Answer Relevance):生成的答案应该直接回答用户的问题

忠实性 (Faithfulness):系统提供的答案应该忠实于检索到的信息,避免产生幻觉 (hallucinations)

🔔 Advanced RAG

Advanced RAG 提到的能力与技术,可以提升RAG 系统在处理复杂问题和数据时的性能,确保检索和生成过程能够相互协作,提供更准确和相关的信息。

RAG成功的要求

检索:必须能够找到与用户查询最相关的文档

生成:必须能够有效利用检索到的文档来充分回答用户查询

高级检索技术

块大小优化 (Chunk-size optimization):调整检索时使用的文档块大小,以提高检索效率和相关性

滑动窗口分块 (Sliding window chunking):使用滑动窗口技术来分块文档,以便更灵活地处理文档内容

知识图谱 (Knowledge Graphs):使用知识图谱来增强检索过程,提供更丰富的上下文信息

嵌入微调 (Embedding Fine-Tuning):对嵌入向量进行微调,以更好地匹配检索任务的需求

结构化知识 (Structured knowledge):整合结构化的知识信息,如实体和关系,以提高检索的相关性

元数据附加 (Metadata Attachments):将元数据附加到文档上,以提供额外的上下文信息

混合检索 (Mixed Retrieval):结合不同类型和来源的检索结果

问题嵌入转换 (Question-Embedding Transformation):对用户问题进行嵌入转换,以更好地与检索文档匹配

高级生成技术

信息压缩 (Information Compression):压缩检索到的信息,以便于后续的生成过程

生成器微调 (Generator Fine-Tuning):对生成器进行微调,以生成更准确和相关的答案

结果重排序 (Result Re-Rank):对检索结果进行重排序,以优化最终输出的顺序

适配器方法 (Adapter Methods):使用适配器来调整模型以适应特定的任务或数据

同时解决检索和生成成功要求的技术

整体微调 (Monolithic Fine-Tuning):对整个系统进行微调,以提高整体性能

生成器增强检索 (Generator-Enhanced Retrieval):通过生成器的输出来增强检索过程

检索基础模型 (Retrieval Foundational Models):构建强大的基础检索模型

迭代检索-生成 (Iterative Retrieval-Generation):采用迭代的方法,结合检索和生成过程,以逐步改进答案的质量

https://blog.llamaindex.ai/a-cheat-sheet-and-some-recipes-for-building-advanced-rag-803a9d94c41b

这篇文章是上方速查表的拓展介绍长文,不仅详细介绍了关键组件的具体功能,而且附上了关键代码,搭配食用可以更好地掌握 RAG 知识和实践~

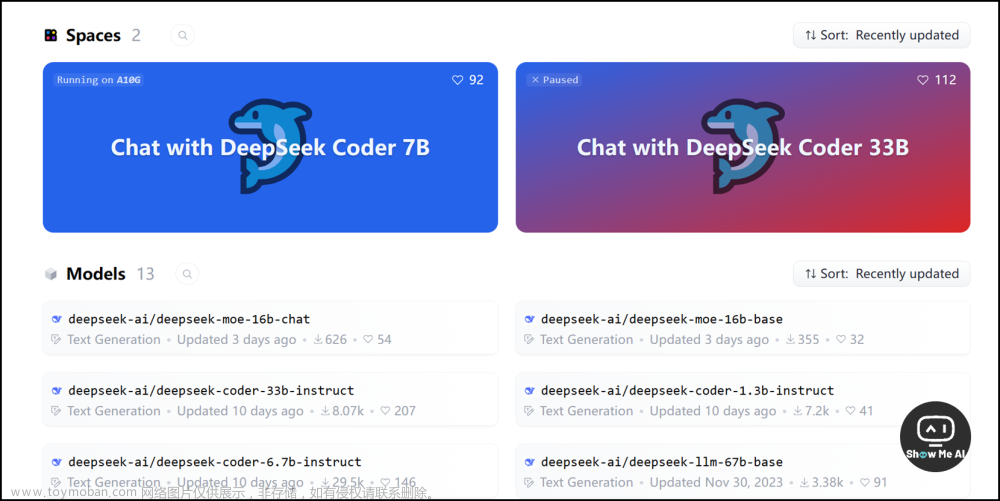

👀 DeepSeekMoE | 国内首个 MoE 开源大模型,技术报告&模型权重同时发布

模型下载 https://huggingface.co/deepseek-ai

微调代码 https://github.com/deepseek-ai/DeepSeek-MoE

技术报告 https://github.com/deepseek-ai/DeepSeek-MoE/blob/main/DeepSeekMoE.pdf

补充一份背景:MoE (Mixture-of-Experts,混合专家架构) 上次引起广泛关注是 Mistral AI 发布的 Mixtral-8x7B 大语言模型,这种架构的核心思想是将一个大神经网络分解为多个小神经网络,每个小网络负责处理不同部分从而提高灵活性和效率

DeepSeek 率先开源了国内首个MoE大模型 DeepSeekMoE,全新架构,支持中英,免费商用。自研的全新MoE架构,多尺度(2B->16B->145B)模型效果均领先:

DeepSeekMoE 2B 可接近 MoE 模型的理论上限 2B Dense 模型性能(即相同Attention/FFN 参数配比的 2B Dense模型),仅用了 17.5% 计算量

DeepSeekMoE 16B 性能比肩 LLaMA2 7B 的同时,仅用了 40% 计算量,也是本次主力开源模型,40G 显存可单卡部署

DeepSeekMoE 145B 上的早期实验进一步证明该MoE架构明显领先于Google的MoE架构GShard,仅用28.5%(甚至18.2%)计算量即可匹配 67B Dense 模型的性

DeepSeekMoE 在框架上做了两大创新

细粒度专家划分:不同于传统MoE直接从与标准FFN大小相同的N个专家里选择激活K个专家,我们把N个专家粒度划分更细,在保证激活参数量不变的情况下,从mN个专家中选择激活mK个专家,如此可以更加灵活地组合多个专家

共享专家分离:我们把激活专家区分为共享专家(Shared Expert)和独立路由专家(Routed Expert),此举有利于将共享和通用的知识压缩进公共参数,减少独立路由专家参数之间的知识冗余 ⋙ 阅读原文

🉑 新书追更 | 从头开始构建大语言模型,作者 Sebastian Raschka

https://www.manning.com/books/build-a-large-language-model-from-scratch

补充一份背景:这本书处于 MEAP (Manning Early Access Program) 预览阶段,共8章,目前更新的2章允许在线阅读

根据 👆 上方预览链接可以看出,这本书「Build A Large Language Model」可以带你深入了解大语言模型的内容工作原理,教你从头创建、训练和调整大语言模型,一步步揭开 LLM 的神秘面纱~

跟随着书籍内容的展开,读者可以按照业界标准步骤来训练和开发自己的小模型,甚至可以在自己的笔记本上完成开发和部署! 还可以跟随作者的脚步构建各种使用的 LLM 应用 👏

👆 上图是作者整理的全书知识框架。日报把书籍目录整理如下,已经发布的前2章有更细致的大纲,其他章节待更新 (主题很新&质量不错,可追更哇 🧭

- 理解大语言模型

什么是LLM?

LLM的应用

构建和使用LLM的阶段

为不同任务使用LLM

利用大型数据集

GPT架构的深入观察

构建大语言模型

总结

参考文献和进一步阅读

- 处理文本数据

理解词嵌入

文本分词

将标记转换为标记ID

添加特殊上下文标记

字节对编码

使用滑动窗口进行数据采样

创建标记嵌入

编码词位置

总结

参考文献和进一步阅读

练习答案

理解注意力机制

从头开始实现GPT模型以生成文本

在未标记数据上进行预训练

为文本分类进行微调

使用人类反馈进行微调以遵循指令

在实践中使用大语言模型

https://github.com/rasbt/LLMs-from-scratch/tree/main

而且!作者还在 GitHub 开源了书籍配套的全部代码!还在实时更新和维护中~ 这伟大的开源精神,值得一个 Star⭐

感谢贡献一手资讯、资料与使用体验的 ShowMeAI 社区同学们!

◉ 点击 👀日报&周刊合集,订阅话题 #ShowMeAI日报,一览AI领域发展前沿,抓住最新发展机会!文章来源:https://www.toymoban.com/news/detail-813603.html

◉ 点击 🎡生产力工具与行业应用大全,一起在信息浪潮里扑腾起来吧!文章来源地址https://www.toymoban.com/news/detail-813603.html

到了这里,关于24-25年是下一代浪潮最关键的两年!GenAI框架与工具合集;RAG要点速查手册;国内首个MoE开源大模型;大语言模型新书追更 | ShowMeAI日报的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!