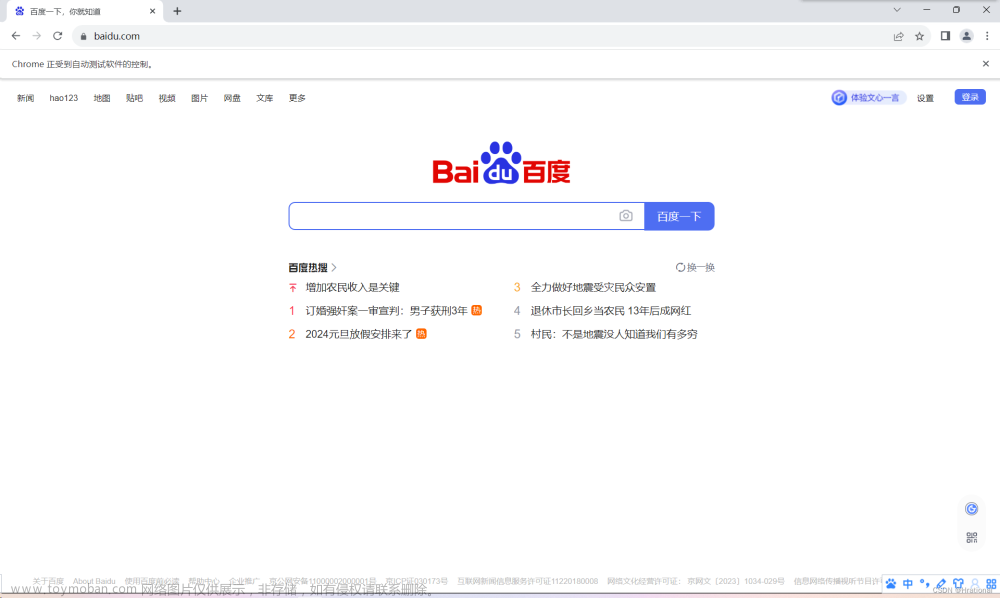

网络爬虫是从网站提取数据的重要方法。然而,在进行网络爬虫时,常常会遇到一个障碍,那就是CAPTCHA(全自动公共图灵测试以区分计算机和人类)。本文将介绍在网络爬虫中解决CAPTCHA的最佳方法,并重点介绍CapSolver无缝集成。

了解网络爬虫中的CAPTCHA:

网络爬虫中的CAPTCHA是指在从网站提取数据时遇到的CAPTCHA挑战。CAPTCHA旨在防止自动化机器人访问和获取信息。它们通常包括对人类容易解答但对机器人难以解答的视觉或逻辑测试。

在网络爬虫中遇到CAPTCHA的原因:

网站通常使用CAPTCHA作为安全措施,以保护内容并防止未经授权的访问。在存储有价值或受限数据的网站上,以及旨在防止过度流量或网络爬虫活动的网站上,通常会出现CAPTCHA。当网络爬虫遇到CAPTCHA时,他们需要找到解决或绕过CAPTCHA的方法,以继续提取所需的数据。

解决网络爬虫中的CAPTCHA:

在网络爬虫中有效解决CAPTCHA挑战需要采用强大的策略。一种方法是手动干预,即人工解答CAPTCHA挑战。然而,这种方法耗时且会影响爬取过程的效率。

相反,开发人员可以利用自动化的CAPTCHA解决技术。这涉及使用算法和工具识别和解决CAPTCHA挑战,无需人工干预。自动化的CAPTCHA解决技术显著提高了网络爬虫任务的速度和效率。

网络爬虫开发人员可以探索各种提供CAPTCHA解决服务的库和API。这些服务提供了预训练的模型和算法,能够准确解决不同类型的CAPTCHA,包括基于图像和文本的CAPTCHA。通过将这些CAPTCHA解决服务集成到爬取工作流程中,开发人员可以有效地克服CAPTCHA挑战并继续提取所需的数据。

介绍CapSolver:网络爬虫中CAPTCHA解决的最佳解决方案:

对于从事大规模数据爬取或自动化任务的用户来说,CAPTCHA可能是一个严峻的障碍。幸运的是,CapSolver已成为解决网络数据爬取等场景中遇到的CAPTCHA挑战的首选解决方案提供商。CapSolver可以轻松快速地解决各种CAPTCHA障碍,并为遇到CAPTCHA问题的用户提供即时解决方案。

CapSolver支持各种类型的CAPTCHA服务,包括reCAPTCHA(v2/v3/Enterprise)、FunCaptcha、hCaptcha(Normal/Enterprise)、DataDome、GeeTest V3/V4、Imperva/Incapsula、AWS Captcha、CyberSiara、Akamai Web/Bmp、ImageToText等。它涵盖了市场上大多数CAPTCHA类型,并且CapSolver不断更新其功能,以解决用户遇到的新类型或挑战。

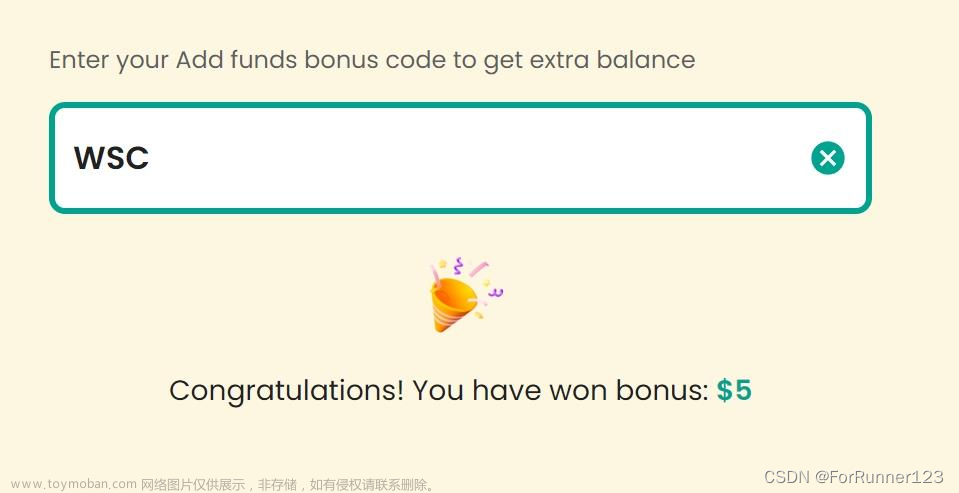

这是一个给Capsolver的额外优惠代码:WSC。在兑换后,每次充值后您将获得额外的5%奖励。

为什么要使用Python解决Web抓取中的CAPTCHA?

在Web抓取中使用Python解决CAPTCHA是自动化数据提取的关键,它绕过了障碍并提高了效率。Python提供了强大的库来自动化解决CAPTCHA,节省时间和精力。自动化的CAPTCHA解决方案提高了Web抓取任务的准确性,确保数据提取的高效性和可靠性。

如何使用Python和Capsolver解决任何CAPTCHA问题:

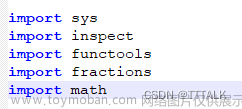

先决条件:

- 一个有效的代理

- 已安装Python

- 已获得Capsolver的API密钥

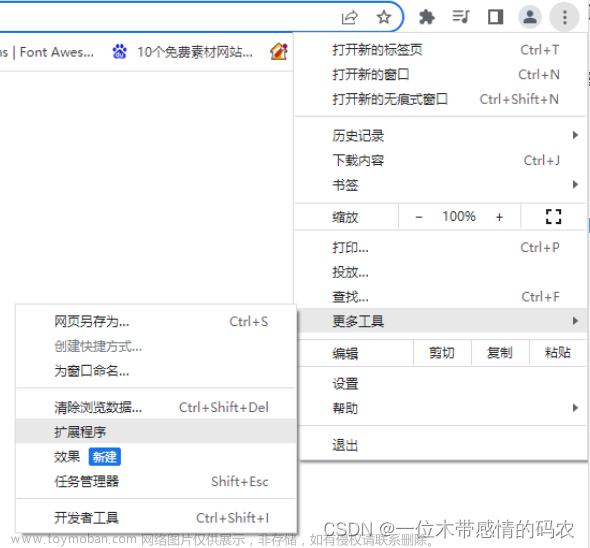

步骤1:安装所需的包

执行以下命令来安装所需的包:

pip install capsolver以下是绕过reCAPTCHA v2的示例代码

使用您的代理绕过reCAPTCHA v2的Python代码示例:

import capsolver

# Consider using environment variables for sensitive information

PROXY = "http://username:password@host:port"

capsolver.api_key = "Your Capsolver API Key"

PAGE_URL = "PAGE_URL"

PAGE_KEY = "PAGE_SITE_KEY"

def solve_recaptcha_v2(url,key):

solution = capsolver.solve({

"type": "ReCaptchaV2Task",

"websiteURL": url,

"websiteKey":key,

"proxy": PROXY

})

return solution

def main():

print("Solving reCaptcha v2")

solution = solve_recaptcha_v2(PAGE_URL, PAGE_KEY)

print("Solution: ", solution)

if __name__ == "__main__":

main()👨💻 Python代码绕过reCAPTCHA v2无需代理文章来源:https://www.toymoban.com/news/detail-813698.html

这是一个用于完成任务的Python示例脚本:文章来源地址https://www.toymoban.com/news/detail-813698.html

import capsolver

# Consider using environment variables for sensitive information

capsolver.api_key = "Your Capsolver API Key"

PAGE_URL = "PAGE_URL"

PAGE_KEY = "PAGE_SITE_KEY"

def solve_recaptcha_v2(url,key):

solution = capsolver.solve({

"type": "ReCaptchaV2TaskProxyless",

"websiteURL": url,

"websiteKey":key,

})

return solution

def main():

print("Solving reCaptcha v2")

solution = solve_recaptcha_v2(PAGE_URL, PAGE_KEY)

print("Solution: ", solution)

if __name__ == "__main__":

main()到了这里,关于如何在网络爬虫中解决CAPTCHA?使用Python进行网络爬虫的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!