接上,我们今天来梳理和学习第2步,分析/合成变换的几种方式。

一、基于RNN架构的方法

基于RNN架构的方法定义:

在分析/合成变换中,基于RNN(循环神经网络)架构的方法是指利用RNN模型来学习和表示输入数据(如序列数据)中的模式、结构和依赖关系,并根据这些学习到的特征来进行分析或合成新的数据。RNN具有循环连接的特性,能够处理变长输入和输出,并捕捉序列中的时序信息。

特点:

- 时序建模:RNN能够捕捉序列数据中的时序依赖关系,使得在处理时间序列、语音、文本等数据时具有优势。

- 参数共享:RNN在每个时间步使用相同的参数,减少了模型参数的数量,并使得模型能够处理任意长度的输入序列。

- 循环连接:RNN通过内部的循环连接来保持信息在时间上的传递,从而使得网络具有记忆能力。

优势:

- 处理变长数据:RNN能够自然地处理变长输入和输出序列,无需进行额外的填充或截断操作。

- 时序模式识别:RNN对于序列中的模式识别非常有效,如语音识别、文本生成等任务。

- 模型灵活性:RNN可以与多种神经网络结构结合,如CNN、LSTM、GRU等,以进一步提高模型的性能。

劣势:

- 梯度消失/爆炸:传统的RNN在训练过程中可能会遇到梯度消失或梯度爆炸的问题,导致难以学习长期依赖关系。

- 计算效率:RNN的循环结构使得其计算效率相对较低,尤其是在处理长序列时。

- 固定记忆容量:RNN的记忆能力受限于其隐藏状态的大小,难以处理需要长时间记忆的任务。

关键技术:文章来源:https://www.toymoban.com/news/detail-814447.html

- LSTM(长短期记忆):LSTM是一种特殊的RNN结构,通过引入门控机制和记忆单元来解决梯度消失问题,并能够更好地捕捉长期依赖关系。

- GRU(门控循环单元):GRU是另一种简化的RNN结构,通过门控机制来捕捉序列中的重要信息,同时减少了参数数量。

- 序列到序列学习:基于RNN的序列到序列学习模型(Seq2Seq)能够实现从一个序列到另一个序列的映射,广泛应用于机器翻译、对话生成等任务。

例子:文章来源地址https://www.toymoban.com/news/detail-814447.html

- 语音识别:基于RNN的语音识别系统能够将输入的语音信号转换为文本输出,通过捕捉语音序列中的时序信息来实现准确的识别。

- 文本生成:RNN可以用于生成连贯的文本序列,如新闻摘要、诗歌生成等,通过捕捉语言的结构和语义信息来生成高质量的文本。

- 时间序列预测:基于RNN的时间序列预测模型能够利用历史数据来预测未来的趋势和值,广泛应用于金融、气象、交通等领域。

基于RNN架构的方法在分析/合成变换中具有强大的时序建模能力和灵活性,适用于处理各种序列数据。然而,它们也面临一些挑战,如梯度消失/爆炸问题和计算效率等。通过结合其他神经网络结构和优化技术,可以进一步改进基于RNN的方法,提高其在各种任务中的性能。

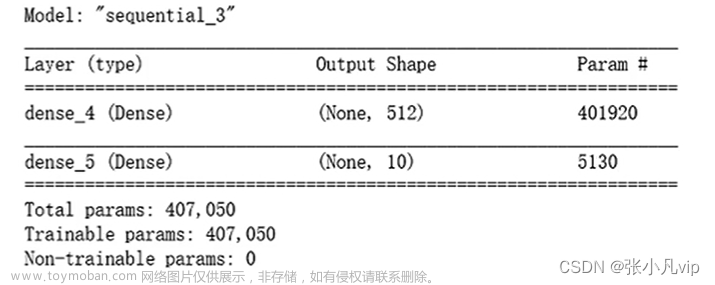

二、基于CNN架构的方法

在分析/合成变换中,基于CNN(卷积神经网络)架构的方法是指利用CNN模型来处理和分析具有网格结构的数据,如图像、音频信号等。CNN通过卷积操作、池化操作和全连接层等组件,能够有效地捕捉输入数据中的局部特征和层次结构,进而实现数据的分析和合成。

特点:

- 局部连接:CNN通过卷积核与输入数据的局部区域进行连接,从而捕捉局部特征。这种局部连接性使得CNN在处理图像等具有局部相关性的数据时非常有效。

- 权值共享:CNN中的卷积核在滑动过程中共享权值,减少了模型参数的数量,降低了模型的复杂度。

- 层次结构:CNN通过多层卷积和池化操作,能够逐步提取输入数据的层次化特征表示,从而实现从低级到高级的特征抽象。

优势:

- 特征提取能力:CNN具有强大的特征提取能力,能够自动学习输入数据中的有用特征,无需手动设计特征提取器。

- 计算效率:相比于全连接网络,CNN的参数数量较少,计算效率较高,适用于处理大规模数据集。

- 平移不变性:由于卷积操作的特性,CNN具有一定的平移不变性,即输入数据的微小位移不会对输出产生显著影响。

劣势:

- 空间结构限制:CNN主要适用于具有网格结构的数据,对于非网格结构的数据(如图网络、序列数据等)处理起来较为困难。

- 长距离依赖问题:由于CNN的局部连接性,它在捕捉长距离依赖关系方面相对较弱。

- 参数敏感性:CNN的性能对超参数的选择较为敏感,如卷积核大小、步长、填充方式等。

关键技术:

- 卷积操作:卷积操作是CNN的核心组件,通过滑动卷积核并计算与输入数据的局部区域的点积来提取特征。

- 池化操作:池化操作用于降低数据的空间分辨率,减少计算量和参数数量,同时提高模型的泛化能力。

- 激活函数:激活函数用于引入非线性因素,增强模型的表达能力。常用的激活函数包括ReLU、Sigmoid、Tanh等。

例子:

- 图像分类:基于CNN的图像分类模型(如VGGNet、ResNet等)能够自动学习图像中的特征,并实现高效的分类性能。这些模型在图像识别、场景理解等领域具有广泛应用。

- 图像生成:通过CNN的逆过程(即反卷积),可以实现图像的生成和重建。例如,生成对抗网络(GAN)中的生成器部分通常采用CNN架构来生成图像。

- 语音识别:虽然CNN在语音识别中不如RNN常用,但它仍可以作为特征提取器与RNN或其他模型结合使用,提高语音识别的准确性。

总之,基于CNN架构的方法在分析/合成变换中具有强大的特征提取能力和计算效率,适用于处理具有网格结构的数据。然而,它也面临一些挑战,如空间结构限制和长距离依赖问题等。通过结合其他神经网络结构和优化技术,可以进一步改进基于CNN的方法,拓宽其应用场景并提高性能。

三、基于Transformer架构的方法

在分析/合成变换中,基于Transformer架构的方法是指使用Transformer模型来进行数据处理和分析。Transformer是一种基于自注意力机制的深度学习模型,最初在自然语言处理领域提出,后来也被广泛应用于其他领域,如计算机视觉、语音识别等。它通过自注意力机制和位置编码来捕捉输入数据中的全局依赖关系,并利用多层堆叠的结构进行特征提取和转换。

特点:

- 自注意力机制:Transformer通过自注意力机制来计算输入数据中每个位置对其他位置的权重,从而捕捉全局依赖关系。这种机制使得模型能够关注到与当前位置相关的所有信息,而不受距离限制。

- 位置编码:由于Transformer模型本身不具有循环或卷积结构,无法直接捕捉输入数据的顺序信息。因此,它通过添加位置编码来提供序列中每个位置的信息,使模型能够区分不同位置的特征。

- 并行计算:Transformer模型中的自注意力机制和前馈神经网络都可以进行并行计算,提高了模型的训练速度和推理效率。

优势:

- 全局依赖捕捉:通过自注意力机制,Transformer能够捕捉输入数据中的全局依赖关系,克服了RNN和CNN在处理长距离依赖时的限制。

- 并行化能力:Transformer的并行计算特性使得它在处理大规模数据集时具有更高的计算效率。

- 模型灵活性:Transformer模型可以很容易地扩展到处理不同长度和维度的输入数据,适用于多种任务和应用场景。

劣势:

- 计算资源需求:Transformer模型通常具有较大的参数量和计算复杂度,需要更多的计算资源来训练和部署。

- 位置信息依赖:虽然Transformer通过位置编码来提供序列的位置信息,但这种方式对于处理具有复杂位置关系的任务可能不够灵活。

- 解释性较弱:Transformer模型的黑盒特性使得其解释性相对较弱,难以直观理解模型内部的决策过程。

关键技术:

- 自注意力机制:自注意力机制是Transformer模型的核心组件,它通过计算输入数据中每个位置对其他位置的权重来捕捉全局依赖关系。

- 位置编码:位置编码用于提供输入序列中每个位置的信息,使模型能够区分不同位置的特征。

- 多层堆叠:Transformer模型通常采用多层堆叠的结构,通过多个自注意力层和前馈神经网络的组合来提取和转换特征。

例子:

- 自然语言处理:在自然语言处理领域,Transformer模型被广泛用于机器翻译、文本摘要、情感分析等任务。例如,BERT(Bidirectional Encoder Representations from Transformers)是一种基于Transformer的预训练语言模型,在各种自然语言处理任务中取得了显著的效果。

- 计算机视觉:在计算机视觉领域,Transformer也被应用于图像分类、目标检测、图像生成等任务。例如,ViT(Vision Transformer)是一种将Transformer直接应用于图像分类任务的模型,通过将图像划分为固定大小的块,并将其作为序列输入到Transformer中进行处理。

- 语音识别:在语音识别领域,Transformer可以用于语音到文本的转换任务。例如,Transformer-based模型在自动语音识别(ASR)系统中取得了良好的性能,能够处理长序列的语音输入并输出对应的文本。

基于Transformer架构的方法在分析/合成变换中展现了强大的全局依赖捕捉能力和并行计算能力,适用于多种任务和应用场景。然而,它也面临计算资源需求大、位置信息依赖和解释性较弱等挑战。未来的研究将继续探索如何优化Transformer模型的结构和性能,以更好地适应各种复杂任务的需求。

四、基于混合架构的方法

在分析/合成变换中,基于混合架构的方法是指结合多种神经网络架构(如CNN、RNN、Transformer等)来构建模型。这种方法旨在充分利用不同架构的优势,以处理复杂的数据和任务。通过结合不同架构的特点,混合模型能够捕捉输入数据中的多种特征和依赖关系,并实现更高效的分析和合成。

特点:

- 多样性:混合架构结合了多种神经网络架构,具有处理不同类型数据和任务的能力。

- 互补性:不同架构之间具有互补性,能够捕捉输入数据中的多种特征和依赖关系。

- 灵活性:混合架构可以根据具体任务和数据特点进行定制,选择适合的组件和结构。

优势:

- 综合性能:混合架构能够充分利用不同神经网络架构的优势,提高模型的综合性能。

- 适应性强:混合模型对于不同类型的数据和任务具有较强的适应性,能够灵活应对各种场景。

- 特征提取能力:结合多种架构的特征提取能力,混合模型能够捕捉更丰富的特征信息,提高分析和合成的准确性。

劣势:

- 模型复杂性:混合架构通常具有更高的模型复杂性,需要更多的计算资源和训练时间。

- 调参难度:由于混合模型涉及多个组件和结构,调参过程可能更加复杂和困难。

- 解释性挑战:混合架构的黑盒特性使得模型解释性相对较弱,难以直观理解模型内部的决策过程。

关键技术:

- 架构选择:根据任务和数据特点选择合适的神经网络架构进行组合。

- 特征融合:设计有效的特征融合策略,将不同架构提取的特征进行融合。

- 优化算法:针对混合模型设计有效的优化算法,提高模型的训练效率和性能。

例子:

- 图像描述生成:结合CNN和RNN的混合架构可以用于图像描述生成任务。CNN用于提取图像特征,RNN用于生成描述文本,两者结合实现从图像到文本的映射。

- 语音识别:在语音识别任务中,可以结合CNN、RNN和Transformer的混合架构。CNN用于提取音频信号的局部特征,RNN用于捕捉时序信息,Transformer用于全局依赖捕捉,最终实现准确的语音到文本转换。

- 多模态情感分析:在处理多模态情感分析任务时,可以构建结合CNN、RNN和注意力机制的混合模型。CNN用于处理图像数据,RNN用于处理文本数据,注意力机制用于融合多模态特征,并输出最终的情感分析结果。

到了这里,关于【AI】深度学习在编码中的应用(5)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!