大型语言模型智能评估新尺度:AGENTBENCH

论文题目:Agentbench: Evaluating llms as agents

论文链接:https://arxiv.org/pdf/2308.03688

目录:

- 摘要

- 总览

- 方法

- 代码环境中的智能Agent评估

- 操作系统环境:OS

- 数据库环境:DB

- 知识图谱环境:KG

- 游戏环境中的智能Agent评估

- 数字卡牌游戏:策略与决策的试金石

- 横向思维谜题:非传统思维的展现

- 家务任务:常识与实用性的检验

- 网络环境中的智能Agent评估

- 在线购物:WebShop数据集的新透视

- 网页浏览:Mind2Web基准的适应性试验

- 代码环境中的智能Agent评估

- 评测

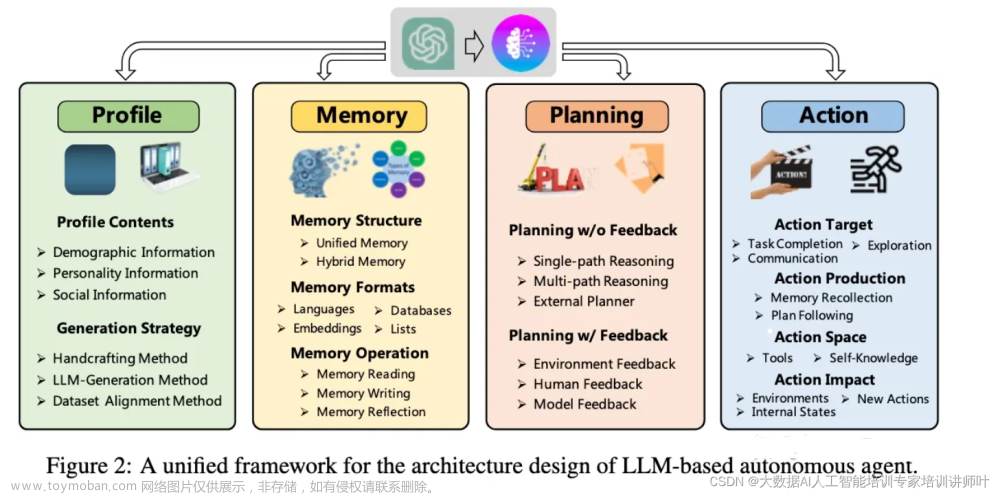

随着大型语言模型(LLMs)的不断进步,它们在现实世界中应对各种实用任务的能力也日益增强。传统的自然语言处理任务已经不能完全满足对这些模型能力的评估需求。因此,我们迫切需要一个新的评估系统,来在实际的互动环境中测试LLMs在面对具有挑战性任务时的推理与决策能力。

今天,我想向大家介绍一个名为AGENTBENCH的全新基准。这是一个多维度、动态发展的基准系统,它通过8个不同的环境来测试LLMs在多轮开放式生成任务中的表现。

简单来说,AGENTBENCH就像是给语言模型的智能设立了一个真实世界的考场。

通过AGENTBENCH,我们对27个基于API的和开源(OSS)的LLMs进行了一系列详尽的测试。令人瞩目的发现是,尽管顶尖的商业LLMs在复杂的环境中展现了强有力的“Agent”能力,但它们与开源竞争对手之间在性能上的差距仍然十分明显。

通过分析,我们找出了LLMs在各环境中失败的典型原因。长期推理、决策制定和指令遵循能力的不足成为了开发高效LLMagent的主要障碍。进一步的研究还表明,通过对代码进行优化和在高质量多轮对话数据上进行训练,可以有效提高LLMs作为Agent的表现。

AGENTBENCH的研究成果非常宝贵,所有的数据集、环境和集成评估工具包都已经开源在GitHub上,你可以通过访问https://github.com/THUDM/AgentBench获取这些资源。

在这里,本文还有一些额外的分享数据(由于我不是很关系,请阅读原文):

- AGENTBENCH上不同LLMs的表现(相对值)与每个环境中的最佳表现之间的对比

- AGENTBENCH在8个测试环境中的整体得分情况

通过这些数据可以看到两种LLM类型之间的差异。

AGENTBENCH不仅为我们提供了一个深入了解LLMs能力的窗口,也指引了未来LLM Agent开发的方向。

总览

AGENTBENCH不同于以往的代理评估基准,它利用了思维链(Chain of Thought, CoT)的提示方式,更加注重对LLMs的实际评估。这种评估涵盖了代码理解、游戏策略以及网络应用等多种场景,旨在探索LLMs在实际应用中具有潜力的各个方面,并提供了一个公平的评估平台,以完成任务的自主性为中心。

通过AGENTBENCH,我们可以观察到LLMs在执行任务时的实际表现,而不仅仅是在特定的任务模型上。例如,它避免了为了评估而特别设计的基于代码的LLMs在测试中的过度表现。这就意味着,无论是哪种类型的LLMs,它们都将在同一标准下接受考验,这对于发现它们的真实能力至关重要。

方法

代码环境中的智能Agent评估

操作系统环境:OS

在操作系统(如Ubuntu Docker)的终端上操作,对LLMs来说是一项既有趣又充满挑战的任务。先前的研究虽尝试将自然语言翻译为Shell命令,但很少有研究在实际可执行的环境中对模型进行评估。我们的目标是评估LLMs在处理具有确定性答案的实际操作系统问题上的能力,例如查询非/home目录的用户数量,或执行实际目标操作,如将所有目录文件设为只读。评估指标为成功率(SR),更多细节请参阅附录B。

数据库环境:DB

数据库操作对于许多日常事务至关重要,但执行起来却相当困难,因此评估LLMs通过SQL对实际数据库进行操作的能力显得尤为关键。尽管先前的研究重点在于SQL与自然语言之间的转换,或是在小型表格上的问题回答,但鲜有研究将注意力集中在对整个流程的评估。AGENTBENCH在真实的SQL接口、数据库、多个表以及各种类型的查询上对LLMs进行评估,反映了真实世界中的使用场景。主要评估指标同样为成功率,详细信息见附录C。

知识图谱环境:KG

与大规模的知识图谱(如FREEBASE)进行交互,需要智能Agent具备广泛的技能,这包括语言理解、规划以及工具使用等。在这些仅部分可观察的环境中操作,要求Agent能够基于不完整信息进行决策,并管理固有的不确定性。因此,我们选择知识图谱作为一个测试智能Agent决策能力的代表性环境。基础任务形式为问答,评价标准为F1值,更多信息详见附录D。

通过这些基于代码的环境,我们不仅能够测试Agent在技术任务中的能力,还能够深入理解它们如何辅助人类进行更高效的技术操作。在未来,这些评估结果将对智能Agent的设计和优化提供重要的指导。

游戏环境中的智能Agent评估

数字卡牌游戏:策略与决策的试金石

数字卡牌游戏(DCG)如《炉石传说》(Hearthstone)等,提供了丰富的策略空间,使得它们成为评估语言模型(LLM)的理想选择。不同于需要编码能力的任务,DCG更侧重于玩家对于规则的理解、策略的制定以及动态调整计划的能力。

最近,清华大学计算机科学与技术学院科技协会举办的Agent竞赛引入了一个名为Aquawar的简化DCG系统。在这场游戏中,智能代理人需要扮演指挥一群各具特色的鱼类角色,展开一场回合制的对决。这不仅是对策略深度的检验,也是对Agent即兴应变能力的挑战。

横向思维谜题:非传统思维的展现

横向思维谜题(LTP)则是检验Agent横向推理能力的有趣方式。在这种游戏中,参与者需通过提问,逐步揭开谜题背后的故事。这不单是对知识的考验,更是对智能Agent思维模式多样性和创新性的挑战。

研究者们为此开发了一个横向思维谜题的自动主持系统,并通过这一系统收集了各种难度的谜题。智能Agent的任务是通过有限的回合,尽可能多地解开谜题的情节,这一过程能量化地反映出其横向推理的能力。

家务任务:常识与实用性的检验

在AGENTBENCH中,对Agent进行的另一项评估是在家务环境中的表现。这里的家务任务如同现实中的挑战,比如“把平底锅放在餐桌上”。这样的任务检验了Agent在理解日常生活常识和执行实际操作上的能力。

智能Agent的未来不仅在于能解决多么复杂的数学问题,更在于它们能否理解和适应这个世界的常识。这样的评估标准为我们提供了一种全新的视角,去观察和理解人工智能的进步和局限。

通过这些多样化的游戏环境,我们可以全方位地评估智能Agent的能力。从数字卡牌游戏中的策略制定,到横向思维谜题中的创新思考,再到家务任务中的常识应用,每一个维度都对智能Agent的发展提出了新的挑战。

网络环境中的智能Agent评估

网络作为现实世界交互的延伸,已经形成了一片无边界的数字海洋。在这个海洋中,评估智能Agent的行为不仅仅是一项技术挑战,它更是为未来的智能系统发展指明方向。今天,我们来探讨如何通过网络页面这个舞台,来考验语言模型(LLM)智能Agent的实际应用能力。

在线购物:WebShop数据集的新透视

在线购物已经成为我们生活的一部分,它的复杂性在于要在一系列商品中筛选出最理想的选项。这不仅考验了用户的决策能力,同样也是对智能Agent推理能力的重大考验。

Yao等人在2022年提出的WebShop数据集,为我们提供了一个模拟的在线购物环境。该环境通过模拟用户在电子商务网站上的搜索、查看和选择商品的行为轨迹,来评估Agent的决策和推理能力。我们在这里对数据集进行了适配,使其能够针对不同的LLMs进行评估,而且这种评估只需要基于Agent的提示响应,无需进行额外的模型训练。

网页浏览:Mind2Web基准的适应性试验

除了专门的在线购物场景之外,更广泛的网页浏览活动也是智能Agent必须掌握的技能。Deng等人在2023年发布的Mind2Web是一个多功能基准,旨在评估Agent在不同网站领域执行复杂任务的能力。

Mind2Web通过定义一系列网站交互动作,如点击、选择和输入,为评估LLM作为网页浏览代理提供了条件。我们对这个基准进行了调整,以便在不进行额外微调的情况下,仅凭借智能提示就能评估LLMs的表现。

通过对WebShop和Mind2Web数据集的适配和评估,我们能够在没有额外训练成本的情况下,更准确地衡量智能Agent在网络环境中的实际表现。这种评估方法不仅能够反映出Agent当前的能力水平,同时也为未来的研究和开发提供了新的方向。

评测

对包括API商业模型和开源LLM在内的27个LLM进行了广泛评估,以形成对LLM作为Agent现有性能的系统观点。并且设计并发布了一个简单的即插即用评估工具包,以促进相关的LLM作为Agent研究。

这一部分我个人不是很感兴趣,有感兴趣的读者可以阅读一下原文,获得他的实验结果。文章来源:https://www.toymoban.com/news/detail-814733.html

完结!文章来源地址https://www.toymoban.com/news/detail-814733.html

到了这里,关于【Agent论文】大型语言模型智能评估新尺度:AGENTBENCH(Agentbench: Evaluating llms as agents)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!