@article{wang2024cs2fusion,

title={CS2Fusion: Contrastive learning for Self-Supervised infrared and visible image fusion by estimating feature compensation map},

author={Wang, Xue and Guan, Zheng and Qian, Wenhua and Cao, Jinde and Liang, Shu and Yan, Jin},

journal={Information Fusion},

volume={102},

pages={102039},

year={2024},

publisher={Elsevier}

}

| 论文级别:SCI A1 |

| 影响因子:18.6 |

📖[论文下载地址]

💽[代码下载地址]

📖论文解读

作者认为以往的方法中,缺乏对源图像之间同一性和差异性的关注,无法充分利用其【互补信息】

为了解决这个问题,作者提出了一种基于【对比学习】的【自监督】【端到端】融合模型,该模型将红外图像视为可见光图像的补充。并且提出了补偿感知网络CPN(Compensation Perception Network)指导backbone network根据红外图像的特征补偿图生成融合图像。

具体来说,使用【自相关】和【显著性运算】重构正/负对,从而驱动CPN在对比损失的约束下,感知红外图像相对于可见光图像的互补特征。

CPN采用了自监督机制,通过从可见光图像中随机裁剪patch,来模拟视觉冲击区域(visually impaired areas),以提供同一场景到多个正样本的更多变化信息,从而增强模型的细粒度感知能力。

此外,作者还在backbone中设计了需求驱动模块DDM(demand-driven module),该模块在图像重构的时候,主动查询以此来改善提升层间信息,并且整合更多的空间结构信息。

上文中提到的CPN,是一个辅助网络,仅出现在训练过程中,用于驱动backbone以自监督的方式完成训练。

🔑关键词

Image Fusion 图像融合

Contrastive Learning 对比学习

Feature Compensation Map 特征补偿图

Identity and Divergence 同一性与差异性

💭核心思想

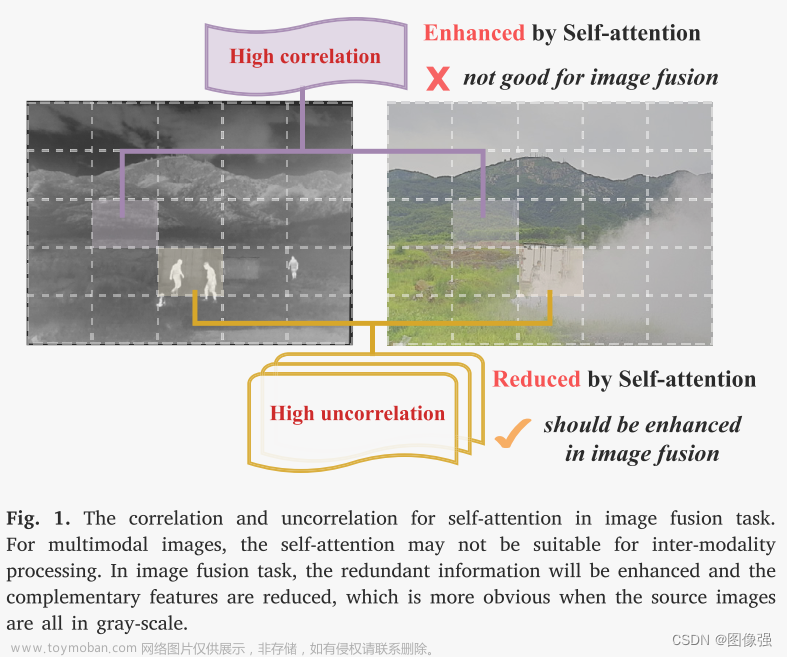

- 不同模态的语义信息通常有很大的差异

- 尽管语义差异很大,但是在相同模态特征中,自相关分布和显著特征趋于相同

因此,将红外光图像视作可见光图像的补充,使用CPN生成红外图像特征补偿图,以此指导backbone生成融合图像。

扩展学习

[什么是图像融合?(一看就通,通俗易懂)]

🪅相关背景知识

🪅对比学习

对比学习通过构造正样本和负样本并调整潜在特征空间中样本之间的距离来驱动模型学习样本的一般特征。由于其强大的特征表示能力,无需任何注释或基本事实即可发现尽可能多的潜在数据信息。

本文利用源图像之间的同一性和差异性构造正负样本,以此来增强感知互补特征,从而提升融合性能。

扩展学习

对比学习(contrastive learning)

🪢网络结构

作者提出的网络结构如下所示。该网络结构包括两部分,backbone和CPN。

上图中,左边最下面的图像

A

V

I

S

\mathcal AVIS

AVIS是从可见光图像数据增强得到的图像

M

i

\mathcal M_i

Mi是CPN产生的特征补偿图

🪢骨干网络

该backbone借鉴了SMFuse。

CS2Fusion将红外光-可见光图像作为一对输入,然后将红外光-扩张可见光图像作为另一对输入。

主干网络由四层权重共享的卷积块(CB)组成,形成一个密集编码器,用于从红外图像(𝐼𝑅𝑖)和可见图像(𝑉𝐼𝑆𝑖)中提取特征。然后将这些提取的特征输入解码器(由四层 CB 组成),解码器在需求驱动模块(DDM)的指导下生成融合图像𝐹。此外,红外图像和增强可见光图像

A

V

I

S

\mathcal AVIS

AVIS都采用相同的方法来构造正负样本并生成增强补偿图

A

M

i

\mathcal {AM}_i

AMi,使得CPN能够生成准确的

M

i

\mathcal M_i

Mi。

在解码器中设计了DDM来补偿信息损失并增强层间的信息流。 DDM是主动特征融合组件,以通道注意力学习到的需求图作为查询依据,通过查询源特征来实现特征补充。如下图

输入是红外和可见光源图像特征,以及输入特征流,输出是需求图。上图画的很清晰,提取特征,然后相乘后相加,具体的过程可以用公式表述为:

CA是通道注意力机制,AP和MP是最大池化和平均池化。

backbone的损失函数为:

损失函数=结构损失 + map损失

🪢CPN

CPN 的主要作用是在训练过程中利用源特征之间的同一性和散度来感知红外图像相对于可见图像的互补特征。这种认知促使骨干网络有效地生成高质量的融合图像。

CPN 将提取的特征作为输入并执行两个主要操作。

首先,它通过两层CB和归一化操作(Norm)生成补偿图

M

i

\mathcal M_i

Mi

其次,它利用自相关和显着性操作(SSO)来生成正样本和负样本,从而约束

M

i

\mathcal M_i

Mi的生成。

可见光特征和补偿特征可以表示为:

CPN的损失函数为:

L

p

n

\mathcal L_{pn}

Lpn对比损失用来鼓励源图像的正负样本分离

L

A

p

n

\mathcal L_{\mathcal Apn}

LApn对比损失用来鼓励扩充源图像的正负样本分离

📉损失函数

上节已介绍。

🔢数据集

图像融合数据集链接

[图像融合常用数据集整理]

🎢训练设置

🔬实验

📏评价指标

- MI

- VIF

- Qabf

- Qncie

- Qy

扩展学习

[图像融合定量指标分析]

🥅Baseline

✨✨✨扩展学习✨✨✨

强烈推荐必看博客

[图像融合论文baseline及其网络模型]

🔬实验结果

更多实验结果及分析可以查看原文:

📖[论文下载地址]

🚀传送门

📑图像融合相关论文阅读笔记

📑[CrossFuse: A novel cross attention mechanism based infrared and visible image fusion approach]

📑[(DIF-Net)Unsupervised Deep Image Fusion With Structure Tensor Representations]

📑[(MURF: Mutually Reinforcing Multi-Modal Image Registration and Fusion]

📑[(A Deep Learning Framework for Infrared and Visible Image Fusion Without Strict Registration]

📑[(APWNet)Real-time infrared and visible image fusion network using adaptive pixel weighting strategy]

📑[Dif-fusion: Towards high color fidelity in infrared and visible image fusion with diffusion models]

📑[Coconet: Coupled contrastive learning network with multi-level feature ensemble for multi-modality image fusion]

📑[LRRNet: A Novel Representation Learning Guided Fusion Network for Infrared and Visible Images]

📑[(DeFusion)Fusion from decomposition: A self-supervised decomposition approach for image fusion]

📑[ReCoNet: Recurrent Correction Network for Fast and Efficient Multi-modality Image Fusion]

📑[RFN-Nest: An end-to-end resid- ual fusion network for infrared and visible images]

📑[SwinFuse: A Residual Swin Transformer Fusion Network for Infrared and Visible Images]

📑[SwinFusion: Cross-domain Long-range Learning for General Image Fusion via Swin Transformer]

📑[(MFEIF)Learning a Deep Multi-Scale Feature Ensemble and an Edge-Attention Guidance for Image Fusion]

📑[DenseFuse: A fusion approach to infrared and visible images]

📑[DeepFuse: A Deep Unsupervised Approach for Exposure Fusion with Extreme Exposure Image Pair]

📑[GANMcC: A Generative Adversarial Network With Multiclassification Constraints for IVIF]

📑[DIDFuse: Deep Image Decomposition for Infrared and Visible Image Fusion]

📑[IFCNN: A general image fusion framework based on convolutional neural network]

📑[(PMGI) Rethinking the image fusion: A fast unified image fusion network based on proportional maintenance of gradient and intensity]

📑[SDNet: A Versatile Squeeze-and-Decomposition Network for Real-Time Image Fusion]

📑[DDcGAN: A Dual-Discriminator Conditional Generative Adversarial Network for Multi-Resolution Image Fusion]

📑[FusionGAN: A generative adversarial network for infrared and visible image fusion]

📑[PIAFusion: A progressive infrared and visible image fusion network based on illumination aw]

📑[CDDFuse: Correlation-Driven Dual-Branch Feature Decomposition for Multi-Modality Image Fusion]

📑[U2Fusion: A Unified Unsupervised Image Fusion Network]

📑综述[Visible and Infrared Image Fusion Using Deep Learning]

📚图像融合论文baseline总结

📚[图像融合论文baseline及其网络模型]

📑其他论文

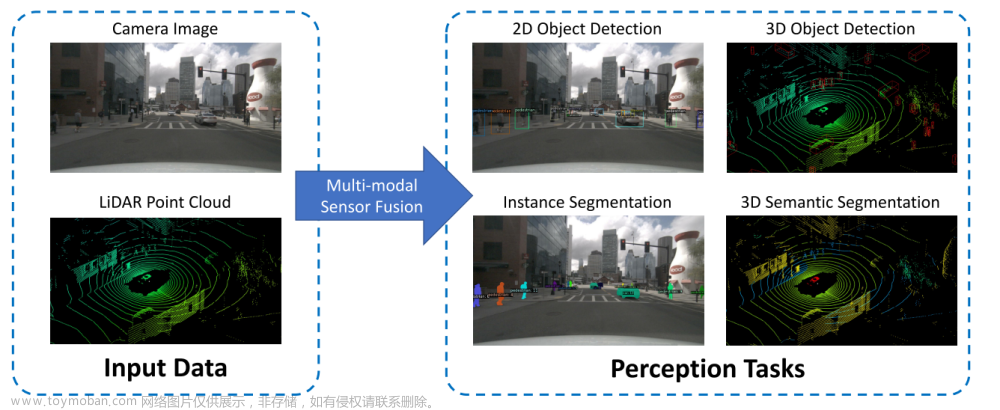

📑[3D目标检测综述:Multi-Modal 3D Object Detection in Autonomous Driving:A Survey]

🎈其他总结

🎈[CVPR2023、ICCV2023论文题目汇总及词频统计]

✨精品文章总结

✨[图像融合论文及代码整理最全大合集]

✨[图像融合常用数据集整理]文章来源:https://www.toymoban.com/news/detail-815098.html

🌻【如侵权请私信我删除】

联系方式:420269520@qq.com;

码字不易,【关注,收藏,点赞】一键三连是我持续更新的动力,祝各位早发paper,顺利毕业~文章来源地址https://www.toymoban.com/news/detail-815098.html

到了这里,关于图像融合论文阅读:CS2Fusion: 通过估计特征补偿图谱实现自监督红外和可见光图像融合的对比学习的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!