K8S集群Node节点NotReay状态故障排查思路

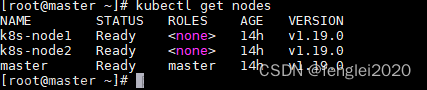

1.K8S集群集群节点故障

在K8S集群中,经常会出现Node节点处于NotReady的状态,当Node节点处于NotReady状态时,会导致该Node节点上的所有Pod资源停止服务,对整体应用程序会产生一定的影响。

在一个Node节点中可以运行多个Pod资源,每一个Pod资源中可以运行一个容器或者多个容器,同时共享一个网络存储资源,一般情况下,一个Pod资源中会运行一个容器,如果Node节点不可用,就会导致该Node节点上运行的Pod容器不可用,Node节点是否健康,会直接影响该节点下所有应用程序容器的监控状态,都会处于不可用的状态,甚至会影响K8S集群。文章来源:https://www.toymoban.com/news/detail-815751.html

节点故障的原因有以下几种:文章来源地址https://www.toymoban.com/news/detail-815751.html

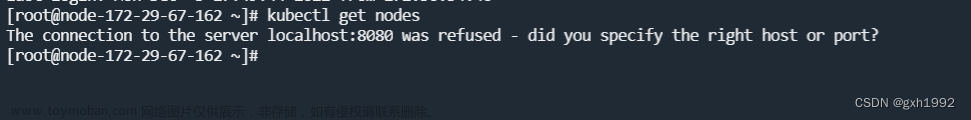

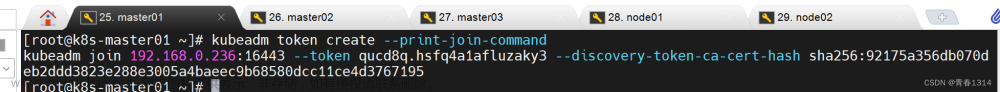

- 集群刚搭建完成,集群Node节点处于NotReady状态,Pod无法调度。

- 集群稳定运行一段时间后,Node节点突然处于NodeReady状态,可能是由于Kubelet组件发生故障导致。

<

到了这里,关于K8S集群Node节点NotReay状态故障排查思路的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!