前言

继上一篇 【Linux上创建一个LVM卷组,将多个物理卷添加到卷组中使用】

创建一个卷组,并将多个物理卷添加到该卷组中。

在卷组上创建一个逻辑卷,并进行文件系统格式化。

将逻辑卷挂载到指定目录并自动挂载。

扩展逻辑卷的大小,并调整文件系统以适应扩容后的存储空间。

那么这篇是Linux 对磁盘进行清理、重建、配置文件系统和挂载的一系列操作,进行系统存储管理 调整存储结构

一、查看磁盘和分区列表

使用命令 lsblk 如下:

[root@hnode3 ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 1.1T 0 disk

├─sda1 8:1 0 200M 0 part /boot/efi

├─sda2 8:2 0 200M 0 part /boot

├─sda3 8:3 0 1.1T 0 part

│ ├─vg_srv-lv_root 253:0 0 2.1T 0 lvm /

│ ├─vg_srv-lv_swap 253:1 0 16G 0 lvm [SWAP]

│ ├─vg_srv-lv_usr 253:2 0 50G 0 lvm /usr

│ ├─vg_srv-lv_opt 253:4 0 50G 0 lvm /opt

│ ├─vg_srv-lv_tmp 253:5 0 50G 0 lvm /tmp

│ ├─vg_srv-lv_var 253:6 0 50G 0 lvm /var

│ └─vg_srv-lv_home 253:7 0 50G 0 lvm /home

└─sda4 8:4 0 1M 0 part

sdb 8:16 0 1.1T 0 disk

└─sdb1 8:17 0 1.1T 0 part

└─vg_srv-lv_root 253:0 0 2.1T 0 lvm /

sdc 8:32 0 1.1T 0 disk

└─sdc6 8:38 0 1.1T 0 part

└─vg_srv-lv_root 253:0 0 2.1T 0 lvm /

sdd 8:48 0 1.1T 0 disk

└─sdd1 8:49 0 1.1T 0 part

└─vg_data-edp_data 253:3 0 8.8T 0 lvm /data

sde 8:64 0 1.1T 0 disk

└─sde1 8:65 0 1.1T 0 part

└─vg_data-edp_data 253:3 0 8.8T 0 lvm /data

sdf 8:80 0 1.1T 0 disk

└─sdf1 8:81 0 1.1T 0 part

└─vg_data-edp_data 253:3 0 8.8T 0 lvm /data

sdg 8:96 0 1.1T 0 disk

└─sdg1 8:97 0 1.1T 0 part

└─vg_data-edp_data 253:3 0 8.8T 0 lvm /data

sdh 8:112 0 1.1T 0 disk

└─sdh1 8:113 0 1.1T 0 part

└─vg_data-edp_data 253:3 0 8.8T 0 lvm /data

sdi 8:128 0 1.1T 0 disk

└─sdi1 8:129 0 1.1T 0 part

└─vg_data-edp_data 253:3 0 8.8T 0 lvm /data

sdj 8:144 0 1.1T 0 disk

└─sdj1 8:145 0 1.1T 0 part

└─vg_data-edp_data 253:3 0 8.8T 0 lvm /data

sdk 8:160 0 1.1T 0 disk

└─sdk1 8:161 0 1.1T 0 part

└─vg_data-edp_data 253:3 0 8.8T 0 lvm /data

sdl 8:176 0 1.1T 0 disk

└─sdl1 8:177 0 1.1T 0 part

└─vg_data-edp_data 253:3 0 8.8T 0 lvm /data

sdm 8:192 0 1.1T 0 disk

└─sdm1 8:193 0 1.1T 0 part

sdn 8:208 0 1.1T 0 disk

└─sdn1 8:209 0 1.1T 0 part

sdo 8:224 0 1.1T 0 disk

└─sdo1 8:225 0 1.1T 0 part

sdp 8:240 0 1.1T 0 disk

└─sdp1 8:241 0 1.1T 0 part

sdq 65:0 0 1.1T 0 disk

└─sdq1 65:1 0 1.1T 0 part

sdr 65:16 0 1.1T 0 disk

└─sdr1 65:17 0 1.1T 0 part

sds 65:32 0 1.1T 0 disk

└─sds1 65:33 0 1.1T 0 part

sdt 65:48 0 1.1T 0 disk

└─sdt1 65:49 0 1.1T 0 part

sdu 65:64 0 1.1T 0 disk

└─sdu1 65:65 0 1.1T 0 part

sdv 65:80 0 1.1T 0 disk

└─sdv1 65:81 0 1.1T 0 part

sdw 65:96 0 1.1T 0 disk

└─sdw1 65:97 0 1.1T 0 part

sdy 65:128 0 1.1T 0 disk

└─sdy1 65:129 0 1.1T 0 part

sdz 65:144 0 1.1T 0 disk

└─sdz1 65:145 0 1.1T 0 part

sr0 11:0 1 1024M 0 rom

sdaa 65:160 0 1.1T 0 disk

└─sdaa1 65:161 0 1.1T 0 part

sdab 65:176 0 1.1T 0 disk

└─sdab1 65:177 0 1.1T 0 part

You have new mail in /var/spool/mail/root

[root@hnode3 ~]#

二、创建 ext4 文件系统,即:格式化分区为ext4文件系统。

1.使用命令 mkfs.ext4 (make file system)报错如下:

[root@hnode3 ~]# mkfs.ext4 /dev/sdd1

mke2fs 1.39 (29-May-2006)

/dev/sdd1 isapparently in use by the system; will not make a filesystem here!

WC报错:

意思是:/dev/sdd1 似乎已经被系统占用,无法在这里创建文件系统。sdd1 是一个硬盘设备文件,如

果在使用中,系统可能已经分配了这个设备。可以看到第一步执行结果挂载点MOUNTPOINT下有/data。为了创建文件系统,需要先卸载占用这个设备的程序,或者将设备重新分配给系统。那怎么办呢?咱们往下走。

解决办法1:(经测试,不采用)X

卸载现有的文件系统:

umount /dev/sdd1

创建一个新的ext4文件系统:

mkfs.ext4 /dev/sdd1

在创建新的文件系统时,如果您的设备上已经存在一个或多个文件系统,则必须先卸载它们,否则将无法创建新的文件系统。此时还会报错,继续!

解决办法2:(经测试,不采用)X

使用 fdisk 或 parted 命令格式化 sdd1 设备,然后重新挂载 sdd1 设备 fdisk /dev/sdd1

解决办法3:(采用)●

查看卷组信息

vgs或者vgdisplay

VG #PV #LV #SN Attr VSize VFree

vg_data 24 1 0 wz-pn- <26.20t <17.41t

vg_srv 3 7 0 wz--n- 3.27t <985.62g

1.检查是否有文件系统或其他进程挂载或访问卷组(可跳过)

2.卸载文件系统

提示:删除逻辑卷之前先卸载文件系统是因为逻辑卷上的文件系统可能正在被使用,文件系统是在逻辑卷上创建的,他是负责管理文件和目录的结构以及存储数据的组织方式。文件系统被挂载后,系统会不断地读取、写入、修改文件和目录以及更新文件系统的元数据。如果这种情况下直接删除逻辑卷,则会中断文件系统的正常操作,可能会导致文件丢失、数据损坏或文件系统无法恢复。所以在删除逻辑卷之前必须使用umount命令卸载文件系统保证不再被系统或其他进程使用。

umount /dev/卷组名称/逻辑卷名称

umount /dev/vg_data/edp_data

此时,再执行第一步lsblk命令MOUNTPOINT下的 /data 就应该消失了接下来编辑/etc/fstab文件,注释掉逻辑卷对应的挂载目录,如下:

#/dev/vg_data/edp_data /data ext4 defaults 0 0

3-4. 删除指定逻辑卷

lvremove /dev/vg_data/edp_data

此时,再执行第一步lsblk命令 sdd1、sde1、sdf1、sdg1、sdh1、sdi1、sdj1、sdk1、sdjl 下的逻辑卷vg_data-edp_data 就应该消失了

3-5. 删除卷组

执行命令

vgremove vg_data

可能出错:Volume group “vg_data” not found, is inconsistent or has PVs missing.

出错原因:物理卷缺失或元数据描述不一致

解决方法:

vgreduce --removemissing vg_data

然后再执行 vgremove vg_data 即可。

过程如下:

[root@hnode2 ~]# vgs

WARNING: Device for PV Axs30r-DKSg-4sgo-0f24-Tthl-lrM8-aO0qWH not found or rejected by a filter.

WARNING: Device for PV XNCljT-Da6w-5zmc-0WJh-MJAK-VDBa-Vq7h1L not found or rejected by a filter.

Couldn't find device with uuid Axs30r-DKSg-4sgo-0f24-Tthl-lrM8-aO0qWH.

Couldn't find device with uuid XNCljT-Da6w-5zmc-0WJh-MJAK-VDBa-Vq7h1L.

VG #PV #LV #SN Attr VSize VFree

vg_data 25 0 0 wz-pn- <27.29t <27.29t

vg_srv 2 7 0 wz--n- 2.18t <67.84g

[root@hnode2 ~]# vgremove vg_data

WARNING: Device for PV Axs30r-DKSg-4sgo-0f24-Tthl-lrM8-aO0qWH not found or rejected by a filter.

WARNING: Device for PV XNCljT-Da6w-5zmc-0WJh-MJAK-VDBa-Vq7h1L not found or rejected by a filter.

Couldn't find device with uuid Axs30r-DKSg-4sgo-0f24-Tthl-lrM8-aO0qWH.

Couldn't find device with uuid XNCljT-Da6w-5zmc-0WJh-MJAK-VDBa-Vq7h1L.

Volume group "vg_data" not found, is inconsistent or has PVs missing.

Consider vgreduce --removemissing if metadata is inconsistent.

You have mail in /var/spool/mail/root

[root@hnode2 ~]# vgreduce --removemissing vg_data

WARNING: Device for PV Axs30r-DKSg-4sgo-0f24-Tthl-lrM8-aO0qWH not found or rejected by a filter.

WARNING: Device for PV XNCljT-Da6w-5zmc-0WJh-MJAK-VDBa-Vq7h1L not found or rejected by a filter.

Couldn't find device with uuid Axs30r-DKSg-4sgo-0f24-Tthl-lrM8-aO0qWH.

Couldn't find device with uuid XNCljT-Da6w-5zmc-0WJh-MJAK-VDBa-Vq7h1L.

Wrote out consistent volume group vg_data.

You have mail in /var/spool/mail/root

[root@hnode2 ~]# vgremove vg_data

Volume group "vg_data" successfully removed

[root@hnode2 ~]# vgs

VG #PV #LV #SN Attr VSize VFree

vg_srv 2 7 0 wz--n- 2.18t <67.84g

You have mail in /var/spool/mail/root

[root@hnode2 ~]#

3-6. 清除物理卷(可跳过)

pvremove /dev/sdd

pvremove /dev/sde

pvremove /dev/sdf

pvremove /dev/sdg

pvremove /dev/sdh

pvremove /dev/sdi

pvremove /dev/sdj

pvremove /dev/sdk

pvremove /dev/sdl

pvremove /dev/sdm

pvremove /dev/sdn

pvremove /dev/sdo

pvremove /dev/sdp

pvremove /dev/sdq

pvremove /dev/sdr

pvremove /dev/sds

pvremove /dev/sdt

pvremove /dev/sdu

pvremove /dev/sdv

pvremove /dev/sdw

pvremove /dev/sdx

pvremove /dev/sdy

pvremove /dev/sdz

pvremove /dev/sdaa

pvremove /dev/sdab

3-7.删除磁盘分区( d w ),执行完以下命令

fdisk /dev/sdd

fdisk /dev/sde

fdisk /dev/sdf

fdisk /dev/sdg

fdisk /dev/sdh

fdisk /dev/sdi

fdisk /dev/sdj

fdisk /dev/sdk

fdisk /dev/sdl

fdisk /dev/sdm

fdisk /dev/sdn

fdisk /dev/sdo

fdisk /dev/sdp

fdisk /dev/sdq

fdisk /dev/sdr

fdisk /dev/sds

fdisk /dev/sdt

fdisk /dev/sdu

fdisk /dev/sdv

fdisk /dev/sdw

fdisk /dev/sdx

fdisk /dev/sdy

fdisk /dev/sdz

fdisk /dev/sdaa

fdisk /dev/sdab

过程如下:

[root@hnode3 ~]# fdisk /dev/sdd

WARNING: fdisk GPT support is currently new, and therefore in an experimental phase. Use at your own discretion.

Welcome to fdisk (util-linux 2.23.2).

Changes will remain in memory only, until you decide to write them.

Be careful before using the write command.

Command (m for help): d

Selected partition 1

Partition 1 is deleted

Command (m for help): w

The partition table has been altered!

Calling ioctl() to re-read partition table.

Syncing disks.

[root@hnode3 ~]# fdisk /dev/sdc

3-8. 创建ext4文件系统,即:格式化分区为ext4文件系统

mkfs.ext4 -F /dev/sdd

mkfs.ext4 -F /dev/sde

mkfs.ext4 -F /dev/sdf

mkfs.ext4 -F /dev/sdg

mkfs.ext4 -F /dev/sdh

mkfs.ext4 -F /dev/sdi

mkfs.ext4 -F /dev/sdj

mkfs.ext4 -F /dev/sdk

mkfs.ext4 -F /dev/sdl

mkfs.ext4 -F /dev/sdm

mkfs.ext4 -F /dev/sdn

mkfs.ext4 -F /dev/sdo

mkfs.ext4 -F /dev/sdp

mkfs.ext4 -F /dev/sdq

mkfs.ext4 -F /dev/sdr

mkfs.ext4 -F /dev/sds

mkfs.ext4 -F /dev/sdt

mkfs.ext4 -F /dev/sdu

mkfs.ext4 -F /dev/sdv

mkfs.ext4 -F /dev/sdw

mkfs.ext4 -F /dev/sdx

mkfs.ext4 -F /dev/sdy

mkfs.ext4 -F /dev/sdz

mkfs.ext4 -F /dev/sdaa

mkfs.ext4 -F /dev/sdab

三、通过UUID挂载单磁盘

1.查看可用的磁盘和其对应的UUID

UUID类似于 “xGf9KO-bTuD-ZOCf-3gne-FcmX-2i3v-P9m2Y2” 这样的字符串

命令

lsblk -f

或者

blkid

2.创建用于挂载的目录

mkdir -p /data/data01 /data/data02 /data/data03 /data/data04 /data/data05 /data/data06 /data/data07 /data/data08 /data/data09 /data/data10 /data/data11 /data/data12 /data/data13 /data/data14 /data/data15 /data/data16 /data/data17 /data/data18 /data/data19 /data/data20 /data/data21 /data/data22 /data/data23 /data/data24

3.挂载磁盘(注意:下面两种方法,选其一,这里选方法一)

3-1. 方法一 : UUID挂载,执行如下命令

mount UUID=674381fb-a275-4ac3-b100-ac584bdd55f0 /data/data01

mount UUID=9c34cda2-2f35-4b54-acdf-4a1f1719c750 /data/data02

mount UUID=3c127316-e48b-4d37-a3cd-c188169545ff /data/data03

mount UUID=f4a52c56-24fb-4b0b-88ce-a01894411fbb /data/data04

mount UUID=c039759a-d62e-4143-ba26-922d07c34257 /data/data05

mount UUID=318dc3ad-46ea-4001-a566-7e063c61cdcb /data/data06

mount UUID=fa83fcdc-3ed5-4e1c-9a71-882e9d2596c5 /data/data07

mount UUID=c0c01c9c-5c9d-4b20-8050-0c2aae34f0f9 /data/data08

mount UUID=6ca1476b-ea30-497b-b20e-b619b76812cf /data/data09

mount UUID=12b1b722-ac8e-4883-a859-2f4e36042351 /data/data10

mount UUID=2aef99a2-ae4e-40b5-ac15-e650a679b487 /data/data11

mount UUID=0dd6caa6-54bd-46e1-9ae6-8df8b1cbc8b4 /data/data12

mount UUID=f92a6cf4-57e8-4d01-b5ba-7df9d91f95b6 /data/data13

mount UUID=31002ad3-3b66-4691-bd20-0d82fa89ff90 /data/data14

mount UUID=cf64a8a8-5820-41dc-920d-f18e24f62623 /data/data15

mount UUID=9edeba3b-39e6-4373-8854-7e188ce69b0d /data/data16

mount UUID=6b4fce1e-4d1c-4674-b042-265ba448a2dc /data/data17

mount UUID=be80e106-41fd-4e55-ace8-a39405c46011 /data/data18

mount UUID=5883c1da-47e5-472c-8a5a-eebd781d6517 /data/data19

mount UUID=c1f66bf2-7981-4a3a-8e47-1fae29492b16 /data/data20

mount UUID=ba5ab178-ff9f-4923-9639-a01c06265b7f /data/data21

mount UUID=abdb2b93-ca9c-456c-80e7-afea5daecd6c /data/data22

mount UUID=4eebe0a5-f062-40e5-84af-253c2cd9f69e /data/data23

mount UUID=333c1707-d04c-4378-8eb8-c0310bc338b3 /data/data24

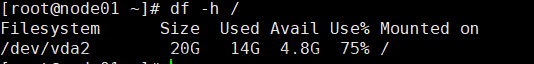

3-2. 检查挂载节点是否有误如下:(没问题)

[root@hnode3 ~]# df -h

Filesystem Size Used Avail Use% Mounted on

/dev/mapper/vg_srv-lv_root 2.1T 1.1T 1016G 52% /

devtmpfs 126G 0 126G 0% /dev

tmpfs 126G 0 126G 0% /dev/shm

tmpfs 126G 28M 126G 1% /run

tmpfs 126G 0 126G 0% /sys/fs/cgro

/dev/mapper/vg_srv-lv_usr 51G 4.1G 46G 9% /usr

/dev/sda2 194M 142M 52M 74% /boot

/dev/sda1 200M 9.8M 191M 5% /boot/efi

/dev/mapper/vg_srv-lv_opt 51G 76M 50G 1% /opt

/dev/mapper/vg_srv-lv_tmp 51G 34M 50G 1% /tmp

/dev/mapper/vg_srv-lv_var 51G 2.8G 48G 6% /var

/dev/mapper/vg_srv-lv_home 51G 4.8G 46G 10% /home

tmpfs 26G 12K 26G 1% /run/user/42

tmpfs 26G 0 26G 0% /run/user/10

/dev/sdd 1.1T 77M 1.1T 1% /data/data01

/dev/sde 1.1T 77M 1.1T 1% /data/data02

/dev/sdf 1.1T 77M 1.1T 1% /data/data03

/dev/sdg 1.1T 77M 1.1T 1% /data/data04

/dev/sdh 1.1T 77M 1.1T 1% /data/data05

/dev/sdi 1.1T 77M 1.1T 1% /data/data06

/dev/sdj 1.1T 77M 1.1T 1% /data/data07

/dev/sdk 1.1T 77M 1.1T 1% /data/data08

/dev/sdl 1.1T 77M 1.1T 1% /data/data09

/dev/sdm 1.1T 77M 1.1T 1% /data/data10

/dev/sdn 1.1T 77M 1.1T 1% /data/data11

/dev/sdo 1.1T 77M 1.1T 1% /data/data12

/dev/sdp 1.1T 77M 1.1T 1% /data/data13

/dev/sdq 1.1T 77M 1.1T 1% /data/data14

/dev/sdr 1.1T 77M 1.1T 1% /data/data15

/dev/sds 1.1T 77M 1.1T 1% /data/data16

/dev/sdt 1.1T 77M 1.1T 1% /data/data17

/dev/sdu 1.1T 77M 1.1T 1% /data/data18

/dev/sdv 1.1T 77M 1.1T 1% /data/data19

/dev/sdx 1.1T 77M 1.1T 1% /data/data20

/dev/sdy 1.1T 77M 1.1T 1% /data/data21

/dev/sdz 1.1T 77M 1.1T 1% /data/data22

/dev/sdaa 1.1T 77M 1.1T 1% /data/data23

/dev/sdab 1.1T 77M 1.1T 1% /data/data24

[root@hnode3 ~]#

3-2. 方法二 : 设备文件名挂载

mount /dev/sdd /data/data01

mount /dev/sde /data/data02

mount /dev/sdf /data/data03

mount /dev/sdg /data/data04

mount /dev/sdh /data/data05

mount /dev/sdi /data/data06

mount /dev/sdj /data/data07

mount /dev/sdk /data/data08

mount /dev/sdl /data/data09

mount /dev/sdm /data/data10

mount /dev/sdn /data/data11

mount /dev/sdo /data/data12

mount /dev/sdp /data/data13

mount /dev/sdq /data/data14

mount /dev/sdr /data/data15

mount /dev/sds /data/data16

mount /dev/sdt /data/data17

mount /dev/sdu /data/data18

mount /dev/sdv /data/data19

mount /dev/sdw /data/data20

mount /dev/sdx /data/data21

mount /dev/sdy /data/data22

mount /dev/sdz /data/data23

mount /dev/sdaa /data/data24

4.编辑 /etc/fstab文件添加挂载内容(与上一步骤连贯,上面方法一,这里也得是方法一的操作,反之同理)

4-1. 方法一 :UUID挂载需在 /etc/fstab 添加如下内容,是为了重启系统防止挂载节点丢失,确保系统在启动时自动挂载并且更加稳定便捷的运行。

UUID=674381fb-a275-4ac3-b100-ac584bdd55f0 /data/data01 ext4 defaults 0 0

UUID=9c34cda2-2f35-4b54-acdf-4a1f1719c750 /data/data02 ext4 defaults 0 0

UUID=3c127316-e48b-4d37-a3cd-c188169545ff /data/data03 ext4 defaults 0 0

UUID=f4a52c56-24fb-4b0b-88ce-a01894411fbb /data/data04 ext4 defaults 0 0

UUID=c039759a-d62e-4143-ba26-922d07c34257 /data/data05 ext4 defaults 0 0

UUID=318dc3ad-46ea-4001-a566-7e063c61cdcb /data/data06 ext4 defaults 0 0

UUID=fa83fcdc-3ed5-4e1c-9a71-882e9d2596c5 /data/data07 ext4 defaults 0 0

UUID=c0c01c9c-5c9d-4b20-8050-0c2aae34f0f9 /data/data08 ext4 defaults 0 0

UUID=6ca1476b-ea30-497b-b20e-b619b76812cf /data/data09 ext4 defaults 0 0

UUID=12b1b722-ac8e-4883-a859-2f4e36042351 /data/data10 ext4 defaults 0 0

UUID=2aef99a2-ae4e-40b5-ac15-e650a679b487 /data/data11 ext4 defaults 0 0

UUID=0dd6caa6-54bd-46e1-9ae6-8df8b1cbc8b4 /data/data12 ext4 defaults 0 0

UUID=f92a6cf4-57e8-4d01-b5ba-7df9d91f95b6 /data/data13 ext4 defaults 0 0

UUID=31002ad3-3b66-4691-bd20-0d82fa89ff90 /data/data14 ext4 defaults 0 0

UUID=cf64a8a8-5820-41dc-920d-f18e24f62623 /data/data15 ext4 defaults 0 0

UUID=9edeba3b-39e6-4373-8854-7e188ce69b0d /data/data16 ext4 defaults 0 0

UUID=6b4fce1e-4d1c-4674-b042-265ba448a2dc /data/data17 ext4 defaults 0 0

UUID=be80e106-41fd-4e55-ace8-a39405c46011 /data/data18 ext4 defaults 0 0

UUID=5883c1da-47e5-472c-8a5a-eebd781d6517 /data/data19 ext4 defaults 0 0

UUID=c1f66bf2-7981-4a3a-8e47-1fae29492b16 /data/data20 ext4 defaults 0 0

UUID=ba5ab178-ff9f-4923-9639-a01c06265b7f /data/data21 ext4 defaults 0 0

UUID=abdb2b93-ca9c-456c-80e7-afea5daecd6c /data/data22 ext4 defaults 0 0

UUID=4eebe0a5-f062-40e5-84af-253c2cd9f69e /data/data23 ext4 defaults 0 0

UUID=333c1707-d04c-4378-8eb8-c0310bc338b3 /data/data24 ext4 defaults 0 0

4-2.设备文件名挂载需添加如下

/dev/sdd1 /data/data01 ext4 defaults 0 0

/dev/sde1 /data/data02 ext4 defaults 0 0

/dev/sdf1 /data/data03 ext4 defaults 0 0

/dev/sdg1 /data/data04 ext4 defaults 0 0

/dev/sdh1 /data/data05 ext4 defaults 0 0

/dev/sdi1 /data/data06 ext4 defaults 0 0

/dev/sdj1 /data/data07 ext4 defaults 0 0

/dev/sdk1 /data/data08 ext4 defaults 0 0

/dev/sdl1 /data/data09 ext4 defaults 0 0

/dev/sdm1 /data/data10 ext4 defaults 0 0

/dev/sdn1 /data/data11 ext4 defaults 0 0

/dev/sdo1 /data/data12 ext4 defaults 0 0

/dev/sdp1 /data/data13 ext4 defaults 0 0

/dev/sdq1 /data/data14 ext4 defaults 0 0

/dev/sdr1 /data/data15 ext4 defaults 0 0

/dev/sds1 /data/data16 ext4 defaults 0 0

/dev/sdt1 /data/data17 ext4 defaults 0 0

/dev/sdu1 /data/data18 ext4 defaults 0 0

/dev/sdv1 /data/data19 ext4 defaults 0 0

/dev/sdw1 /data/data20 ext4 defaults 0 0

/dev/sdx1 /data/data21 ext4 defaults 0 0

/dev/sdz1 /data/data22 ext4 defaults 0 0

/dev/sdaa1 /data/data23 ext4 defaults 0 0

5.重新挂载/etc/fstab文件中系统列出的所有已配置但当前未挂载的文件系统

命令 mount -a文章来源:https://www.toymoban.com/news/detail-816276.html

6.reboot 重启之后

检查命令: df -h --output=target,source,used,size | sort -k1 或 l

运行结果磁盘挂载正常,如下:文章来源地址https://www.toymoban.com/news/detail-816276.html

[root@hnode1 ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 1.1T 0 disk

├─sda1 8:1 0 200M 0 part /boot/efi

├─sda2 8:2 0 200M 0 part /boot

├─sda3 8:3 0 1.1T 0 part

│ ├─vg_srv-lv_root 253:0 0 2.1T 0 lvm /

│ ├─vg_srv-lv_swap 253:1 0 16G 0 lvm [SWAP]

│ ├─vg_srv-lv_usr 253:2 0 50G 0 lvm /usr

│ ├─vg_srv-lv_opt 253:3 0 50G 0 lvm /opt

│ ├─vg_srv-lv_tmp 253:4 0 50G 0 lvm /tmp

│ ├─vg_srv-lv_var 253:5 0 50G 0 lvm /var

│ └─vg_srv-lv_home 253:6 0 50G 0 lvm /home

└─sda4 8:4 0 1M 0 part

sdb 8:16 0 1.1T 0 disk

└─sdb1 8:17 0 1.1T 0 part

└─vg_srv-lv_root 253:0 0 2.1T 0 lvm /

sdc 8:32 0 1.1T 0 disk

└─sdc1 8:33 0 1.1T 0 part

└─vg_srv-lv_root 253:0 0 2.1T 0 lvm /

sdd 8:48 0 1.1T 0 disk /data/data01

sde 8:64 0 1.1T 0 disk /data/data02

sdf 8:80 0 1.1T 0 disk /data/data03

sdg 8:96 0 1.1T 0 disk /data/data04

sdh 8:112 0 1.1T 0 disk /data/data05

sdi 8:128 0 1.1T 0 disk /data/data06

sdj 8:144 0 1.1T 0 disk /data/data07

sdk 8:160 0 1.1T 0 disk /data/data08

sdl 8:176 0 1.1T 0 disk /data/data09

sdm 8:192 0 1.1T 0 disk /data/data10

sdn 8:208 0 1.1T 0 disk /data/data11

sdo 8:224 0 1.1T 0 disk /data/data12

sdp 8:240 0 1.1T 0 disk /data/data13

sdq 65:0 0 1.1T 0 disk /data/data14

sdr 65:16 0 1.1T 0 disk /data/data15

sds 65:32 0 1.1T 0 disk /data/data16

sdt 65:48 0 1.1T 0 disk /data/data17

sdu 65:64 0 1.1T 0 disk /data/data18

sdv 65:80 0 1.1T 0 disk /data/data19

sdw 65:96 0 1.1T 0 disk /data/data20

sdx 65:112 0 1.1T 0 disk /data/data21

sdy 65:128 0 1.1T 0 disk /data/data22

sdz 65:144 0 1.1T 0 disk /data/data23

sr0 11:0 1 1024M 0 rom

sdaa 65:160 0 1.1T 0 disk /data/data24

[root@hnode1 ~]#

到了这里,关于【Linux对磁盘进行清理、重建、配置文件系统和挂载,进行系统存储管理调整存储结构】的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!