概述

- 介绍一下请求状态原理

- 分析需要登录的网站请求特点

- 分析登陆前后请求差异

- 如何从接口分析一步步构建一个合理的登录爬虫

- 巧方法解决登录

需要登录的网站请求特点

登录分析1

我们打开这个链接https://login2.scrape.center/,如果是未登录状态,页面如下

我们输入用户名与密码,点击登录,同时打开f12抓包。获取到的抓包结果如下:

网络请求内有一个状态码为302的登录请求,这个请求就是登录请求

这里整个登录与请求流程就是

- 请求登录页面,输入用户名密码登录

- 获取登录响应的响应头Set-Cookie字段【这个字段就是用于为后续请求构造请求头的】

- 请求头带着Set-Cookie内的字段,获取登录后的数据

登录分析2

我们再来分析一个需要登录的网站:

https://login3.scrape.center/login

我们访问登录页面,输入用户名密码登录,并f12抓包

登录接口预览如下:

我们查看登录接口的响应,响应如下:

我们接着分析数据接口:

后续的数据请求只要携带请求头字段Authorization为jwt拼接登录后的token值就可以维持登录状态的请求。

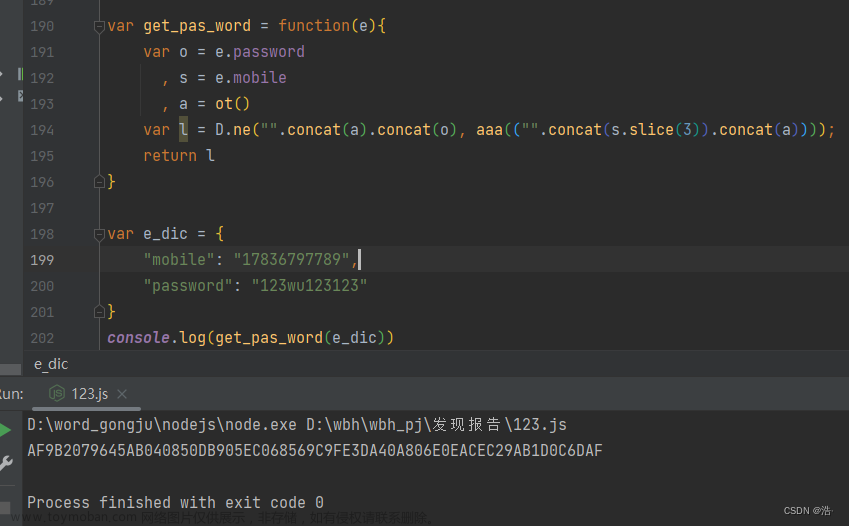

登录分析3

我们再来分析这个网站,输入网址https://www.faxin.cn/lib/zyfl/zyflcontent.aspx?gid=A341401&libid=010101

点击右上角的登录按钮,进入登录页面;同时打开f12抓包,抓包结果如下:

输入用户名与密码点击登录。抓包结果如下:

通过以上的三个需要登录的网站分析,我们发现只要网站的某些数据请求是需要登录之后才能获取到的,我们在只需要分析登录接口,同时解析出登录状态维持的字段【可能是cookie也可能是其他字段,第2个登录分析在登录响应内字段名为token,而在数据请求内为Authorization】,我们并携带在后续的数据请求内,就可以获取到登录后的数据。

注意

需要注意的是:

- 维持登录状态的字段值可能会失效,我们在开发爬虫中,需要及时校验是否cookie或其他登录状态值失效,如果失效,我们需要再次构造登录,更新字段值

- 登录爬虫我们对于数据请求需要控制频率,尽可能用更多的账号,建立一个独立存在的维持登录状态的参数池【如:token池或cookie池等】,这样便于即使维护与更新,将爬虫的各个阶段解耦,提升效率。而且如果账号请求数据频繁,可能会被目标网站封禁账号,我们需要考虑到账号封禁的风险与ip封禁等风险,并使用代理ip等方法规避这些风险。

案例分析

案例一

https://login2.scrape.center/

默认重定向导致无法获取到重定向前的cookie

案例一爬虫源码

# coding=utf-8

import requests

headers = {

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.7',

'Accept-Language': 'zh-CN,zh;q=0.9,en;q=0.8',

'Cache-Control': 'no-cache',

'Connection': 'keep-alive',

'Content-Type': 'application/x-www-form-urlencoded',

'Origin': 'https://login2.scrape.center',

'Pragma': 'no-cache',

'Referer': 'https://login2.scrape.center/login',

'Sec-Fetch-Dest': 'document',

'Sec-Fetch-Mode': 'navigate',

'Sec-Fetch-Site': 'same-origin',

'Sec-Fetch-User': '?1',

'Upgrade-Insecure-Requests': '1',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'sec-ch-ua': '"Not_A Brand";v="8", "Chromium";v="120", "Google Chrome";v="120"',

'sec-ch-ua-mobile': '?0',

'sec-ch-ua-platform': '"Windows"',

}

data = {

'username': 'admin',

'password': 'admin',

}

response = requests.post('https://login2.scrape.center/login', headers=headers, data=data, allow_redirects=False)

status = response.status_code

################### 直接获取响应的cookie字段 ################

logined_cookies = response.cookies

print(status)

print(logined_cookies)

# 将cookies输出为字典

print(dict(logined_cookies)) # {'sessionid': 'h1d41qkv8qzrlhk0ykfzx54g3ph0od6j'}

################# 从响应头内获取cookie ###################

headers_resp = dict(response.headers)

cookies = headers_resp.get('Set-Cookie') # 获取到cookie字符串

print(cookies) # sessionid=h1d41qkv8qzrlhk0ykfzx54g3ph0od6j; expires=Wed, 24 Jan 2024 23:40:31 GMT; HttpOnly; Max-Age=1209600; Path=/; SameSite=Lax

案例二

https://login3.scrape.center/login

爬虫源码:

# coding=utf-8

import requests

headers = {

'Accept': 'application/json, text/plain, */*',

'Accept-Language': 'zh-CN,zh;q=0.9,en;q=0.8',

'Cache-Control': 'no-cache',

'Connection': 'keep-alive',

'Content-Type': 'application/json;charset=UTF-8',

'Origin': 'https://login3.scrape.center',

'Pragma': 'no-cache',

'Sec-Fetch-Dest': 'empty',

'Sec-Fetch-Mode': 'cors',

'Sec-Fetch-Site': 'same-origin',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'sec-ch-ua': '"Not_A Brand";v="8", "Chromium";v="120", "Google Chrome";v="120"',

'sec-ch-ua-mobile': '?0',

'sec-ch-ua-platform': '"Windows"',

}

json_data = {

'username': 'admin',

'password': 'admin',

}

response = requests.post('https://login3.scrape.center/api/login', headers=headers, json=json_data)

token = response.json()['token']

authorization = 'jwt '+token

print(token)

headers_login = {

'Accept': 'application/json, text/plain, */*',

'Accept-Language': 'zh-CN,zh;q=0.9,en;q=0.8',

'Authorization': authorization,

'Cache-Control': 'no-cache',

'Connection': 'keep-alive',

'Pragma': 'no-cache',

'Sec-Fetch-Dest': 'empty',

'Sec-Fetch-Mode': 'cors',

'Sec-Fetch-Site': 'same-origin',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'sec-ch-ua': '"Not_A Brand";v="8", "Chromium";v="120", "Google Chrome";v="120"',

'sec-ch-ua-mobile': '?0',

'sec-ch-ua-platform': '"Windows"',

}

params = {

'limit': '18',

'offset': '0',

}

response = requests.get('https://login3.scrape.center/api/book/', params=params, headers=headers_login)

print(authorization)

print(response.json())

运行结果如下:【爬虫构造成功】 文章来源:https://www.toymoban.com/news/detail-816374.html

文章来源:https://www.toymoban.com/news/detail-816374.html

案例三

法信爬虫文章来源地址https://www.toymoban.com/news/detail-816374.html

登录脚本

# coding=utf-8

import time

import requests

cookies = {

'ASP.NET_SessionId': 'at0wmkahm3o1yf2uzdcyo24z',

'insert_cookie': '89314150',

'showUpdate': '2024-01-05',

'Hm_lvt_a317640b4aeca83b20c90d410335b70f': '1704930439',

'clx': 'n',

'sid': 'at0wmkahm3o1yf2uzdcyo24z',

'isAutoLogin': 'off',

'Hm_lpvt_a317640b4aeca83b20c90d410335b70f': str(int(time.time())),

}

headers = {

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.7',

'Accept-Language': 'zh-CN,zh;q=0.9,en;q=0.8',

'Cache-Control': 'no-cache',

'Connection': 'keep-alive',

'Content-Type': 'application/x-www-form-urlencoded',

# 'Cookie': 'ASP.NET_SessionId=at0wmkahm3o1yf2uzdcyo24z; insert_cookie=89314150; showUpdate=2024-01-05; Hm_lvt_a317640b4aeca83b20c90d410335b70f=1704930439; clx=n; sid=at0wmkahm3o1yf2uzdcyo24z; isAutoLogin=off; Hm_lpvt_a317640b4aeca83b20c90d410335b70f=1704930535',

'Origin': 'https://www.faxin.cn',

'Pragma': 'no-cache',

'Referer': 'https://www.faxin.cn/login.aspx?url=/lib/zyfl/zyflcontent.aspx%3Fgid=A341404%26libid=010101',

'Sec-Fetch-Dest': 'document',

'Sec-Fetch-Mode': 'navigate',

'Sec-Fetch-Site': 'same-origin',

'Sec-Fetch-User': '?1',

'Upgrade-Insecure-Requests': '1',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'sec-ch-ua': '"Not_A Brand";v="8", "Chromium";v="120", "Google Chrome";v="120"',

'sec-ch-ua-mobile': '?0',

'sec-ch-ua-platform': '"Windows"',

}

data = {

'__VIEWSTATE': '/wEPDwUJNzUzMzc2OTcyZBgBBR5fX0NvbnRyb2xzUmVxdWlyZVBvc3RCYWNrS2V5X18WAgUKaXNSZW1lbWJlcgULaXNBdXRvTG9naW7CqpQN/iu5+xaD2O1P5o5lGgo7gA==',

'__VIEWSTATEGENERATOR': 'C2EE9ABB',

'WebUCHead_Special1$hiddIsLogin': '0',

'WebUCSearchNoAdvSearch1$lib': '',

'keyword': '',

'user_name': '',# 你的用户名

'user_password': '', # 你的密码

'isLogout': '0',

}

response = requests.post(

'https://www.faxin.cn/login.aspx?url=%2flib%2fzyfl%2fzyflcontent.aspx%3fgid%3dA341404%26libid%3d010101',

cookies=cookies,

headers=headers,

data=data,

allow_redirects=False

)

status = response.status_code

################### 直接获取响应的cookie字段 ################

logined_cookies = response.cookies

print(status)

print(logined_cookies)

# 将cookies输出为字典

print(dict(logined_cookies))

到了这里,关于需要登录的网站爬虫详解的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!