一、概述

1、是什么

Instruct BLIP 全称《InstructBLIP: Towards General-purpose Vision-Language Models with Instruction Tuning》,是一个多模态视觉-文本大语言模型,隶属BLIP系列第三篇,可以完成:图像描述、视觉问答、名画名人等识别(问答、描述)。支持单幅图片输入(作为第一个输入),多轮文本对话。(不支持图文交错输入、写代码、视觉定位、JSON mode等。)

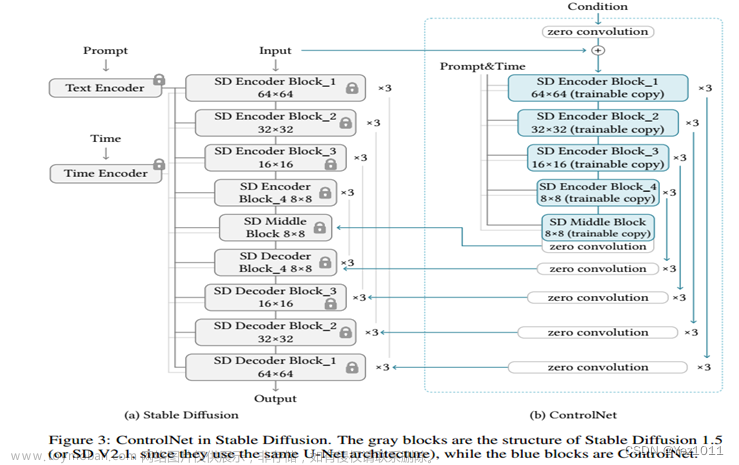

整体架构沿用BLIP2,在Q-former中多加入了文本prompt token来和图片进行交互。构造一个指令数据集,只训练q-former。

2、亮点

*对视觉语言指令调优进行了全面而系统的研究。将26个数据集转换为指令调优格式(13个用于指令调优,13个用于zero-shot评估),并将其分为11个任务类别(保留了四个完整的任务类别,以便在任务水平上进行zero-shot评估)。

*提出了指令感知的视觉特征提取,这是一种新的机制,可以根据给定的指令灵活地提取信息丰富的特征。

*使用两个LLM家族评估并开源了一套InstructBLIP模型:FlanT5、Vicuna。

PS文章来源:https://www.toymoban.com/news/detail-816896.html

这里要注意其实BLIP2的Q-former 也是有文本输入的,也可以作为prompt,只是可能没有专门经文章来源地址https://www.toymoban.com/news/detail-816896.html

到了这里,关于VLM 系列——Instruct BLIP——论文解读的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!