前言

在这节课,我们将学习语义分割和实例分割。在语义分割中,我们需要重点掌握语义分割的概念、常用数据集、评价指标(IoU)以及经典的语义分割方法(Deeplab系列);在实例分割中,需要知道实力分割可以近似看为“目标检测+语义分割”,需要知道Mask R-CNN方法的计算流程,以及评价指标mAP。

一、语义分割

1.1 分割类任务的定义

分割类任务是一种密集标注任务,即将图像中每个像素赋予一个语义或者实例标签。

1.2 语义分割的应用场景

- 无人驾驶

- 机器人

- 医学图像

- ……

1.3 常用数据集

1.3.1 Pascal VOC Dataset

VOC数据集是计算机视觉主流数据集之一,由牛津大学、比利时鲁汶大学等高校的视觉研究组联合发布,可以用作分类,分割,目标检测,动作检测和人物定位五类任务,包含21个类别标签,训练1464,验证1449,测试1456。

1.3.2 MS COCO Dataset

MS COCO(Microsoft Common Objects in Context Dataset)是微软发布的一个大规模物体检测,分割及文字定位数据集,支持目标检测、实例分割、全景分割、Stuff Segmentation、关键点检测、看图说话等任务类型,包含80个对象类别。

1.3.3 ADE20K Dataset

ADE20K数据集由 MIT CSAIL 研究组发布,涵盖广泛的场景和对象类别,可用于场景感知、解析、分割、多物体识别和语义理解。该数据集构建了一个场景解析基准,包含150个对象和素材类。

1.3.4 CityScapes Dataset

CityScapes是由奔驰自动驾驶实验室、马克思·普朗克研究所、达姆施塔特工业大学联合发布的图像数据集,专注于对城市街景的语义理解。 该数据集包含50个城市不同场景、不同背景、不同街景,以及30类涵盖地面、建筑、交通标志、自然、天空、人和车辆等的物体标注,共有5000张精细标注的图像和2万张粗略标注的图像。

1.4 评价指标(重点)

平均交并比 (mean Intersection over Union, mIoU) ——每个类别的所有像素去计算交并比

1.5 语义分割方法

1.5.1 基于滑动窗的提取图像块后分类

基于滑动窗提取图像块然后对图像块的中心进行分类

1.5.2 用CNN计算整幅图的特征

用CNN计算整幅图的特征,然后在其上进行标签预测

1.5.3 全卷积网络

【方案一】

设计只含有卷积层而没有降采样操作的神经网络,这样可以同时对所有像素进行标签预测

【方案二】

设计包含卷积层、下采样操作和上采样操作的神经网络。

下采样操作:可以通过池化和加大卷积步长来实现

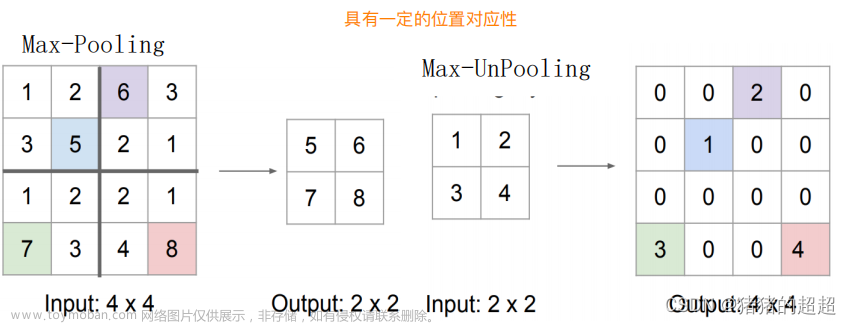

上采样操作:可以通过插值、逆池化和转置卷积来实现

【插值】

【逆池化】

【转置卷积】

【上采样结构总结】

【U-Net】

1.5.4 DeepLab系列

【Deeplab V1】

【Deeplab V2】

【Deeplab V3】

【Deeplab V3+】

1.5.5 PSPNet

1.5.6 HRNet

二、实例分割

2.1 实例分割的概念

实例分割 可以近似看为 目标检测 + 语义分割

2.2 Mask R-CNN

2.3 评价指标(重点)

2.4 实例分割效果

文章来源:https://www.toymoban.com/news/detail-817019.html

文章来源:https://www.toymoban.com/news/detail-817019.html

总结

在本文中,我们学习了语义分割和实例分割,需要清楚二者的区别,并掌握二者的算法流程,需要重点关注语义分割和实例分割的方法举例和评价指标。文章来源地址https://www.toymoban.com/news/detail-817019.html

到了这里,关于计算机视觉基础(11)——语义分割和实例分割的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![深度学习应用篇-计算机视觉-语义分割综述[5]:FCN、SegNet、Deeplab等分割算法、常用二维三维半立体数据集汇总、前景展望等](https://imgs.yssmx.com/Uploads/2024/02/567599-1.png)