源码地址

- 本人使用的opencv c++ github代码,代码作者非本人

实现推理源码中作者的yolov8s.onnx

推理条件

windows 10

Visual Studio 2019

Nvidia GeForce GTX 1070

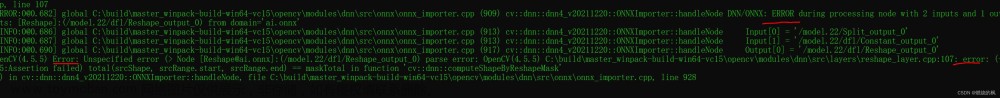

opencv4.7.0 (opencv4.5.5在别的地方看到不支持yolov8的推理,所以只使用opencv4.7.0)

c++部署

先将源码复制到下图位置中

环境和代码的大致步骤跟yolov5 opencv dnn部署 github代码一样,环境部署好之后

在将所有的环境配置设置好之后,直接运行yolov8.cpp,不用做任何修改文章来源:https://www.toymoban.com/news/detail-817262.html

c++推理结果

文章来源地址https://www.toymoban.com/news/detail-817262.html

文章来源地址https://www.toymoban.com/news/detail-817262.html

参考链接

- 另外两个yolov8推理的代码参考链接

- https://github.com/hpc203/yolov8-face-landmarks-opencv-dnn

- https://github.com/UNeedCryDear/yolov8-opencv-onnxruntime-cpp

到了这里,关于yolov8 opencv dnn部署 github代码的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!