博主介绍:黄菊华老师《Vue.js入门与商城开发实战》《微信小程序商城开发》图书作者,CSDN博客专家,在线教育专家,CSDN钻石讲师;专注大学生毕业设计教育和辅导。

所有项目都配有从入门到精通的基础知识视频课程,免费

项目配有对应开发文档、开题报告、任务书、PPT、论文模版等项目都录了发布和功能操作演示视频;项目的界面和功能都可以定制,包安装运行!!!

如果需要联系我,可以在CSDN网站查询黄菊华老师

在文章末尾可以获取联系方式

基于Python重庆招聘数据爬虫采集系统设计与实现(Django框架)

一、研究背景与意义

随着互联网的快速发展,网络招聘已成为招聘行业的主要形式。重庆市作为西南地区的重要城市,其招聘市场的发展对于人才引进和资源配置具有重要影响。然而,目前缺乏一个有效的数据爬虫采集系统来收集和分析重庆地区的招聘数据,这限制了对于招聘市场动态的掌握和对于招聘趋势的预测。

通过设计和实现基于Python的重庆招聘数据爬虫采集系统,可以自动化地从各大招聘网站获取重庆地区的招聘数据,并对其进行存储、分析和可视化。这将为重庆市的招聘行业带来诸多益处,例如:

- 实时监测招聘市场的变化,以便及时调整招聘策略;

- 预测未来的招聘趋势,以制定长远的人才引进计划;

- 发现潜在的优秀人才,以扩大公司的候选人库;

- 通过对数据的深度分析,为公司的招聘决策提供数据支持。

因此,本课题的研究具有重要的实际意义和价值。

二、国内外研究现状

在国内外,已有不少关于网络爬虫和数据采集系统的研究。例如,Scrapy、BeautifulSoup和Selenium等都是常用的网络爬虫库,可以实现对网页数据的自动化采集。此外,Django等Web框架也被广泛应用于后端开发。然而,针对重庆地区招聘数据爬虫采集系统的研究尚不多见。

三、研究思路与方法

本研究将采用以下思路和方法:

- 确定目标网站:首先,我们将确定需要爬取的目标招聘网站,如智联招聘、前程无忧等。

- 数据采集:使用Python的Scrapy框架来实现数据的自动化采集。具体来说,我们将编写爬虫程序来访问目标网站,并提取所需的招聘数据。

- 数据存储:将采集到的数据存储到数据库中,以便后续的分析和可视化。

- 数据分析:使用Python的数据分析库(如Pandas)对数据进行清洗、分析和可视化。

- 可视化展示:使用Django框架来设计和实现一个Web界面,以展示分析后的数据。

四、研究内容与创新点

本研究的主要内容是设计和实现一个基于Python的重庆招聘数据爬虫采集系统。具体来说,本研究的创新点包括:

- 针对重庆地区的招聘数据设计并实现了一个有效的数据爬取方案;

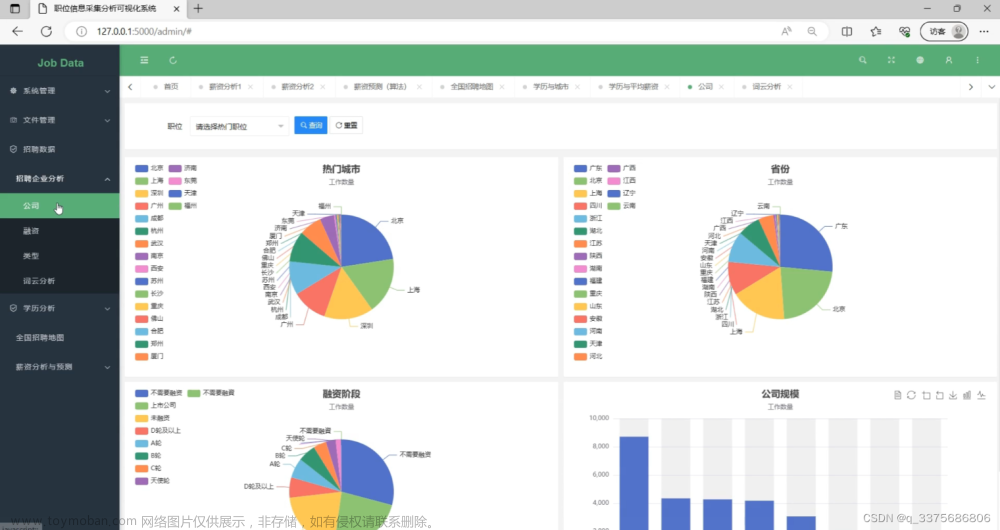

- 使用Django框架来实现数据的可视化展示,使得用户可以直观地查看和分析招聘数据;

- 通过对数据的深度分析,可以预测未来的招聘趋势,为招聘行业提供数据支持。

五、前后台功能详细介绍

本系统的前后台功能如下:

- 前台功能:用户可以通过Web界面查看和分析采集到的招聘数据。具体来说,用户可以查看各种职位的招聘人数、薪资水平、公司规模等信息,同时也可以对数据进行筛选、排序和导出。此外,系统还提供了职位搜索功能,用户可以通过关键词搜索职位并查看详细信息。

- 后台功能:管理员可以通过后台管理界面进行系统的配置和管理。具体来说,管理员可以配置爬取规则、管理用户账户、查看系统日志等。此外,管理员还可以对采集到的数据进行清洗、分析和可视化,以便更好地了解招聘市场的动态和趋势。

六、研究思路与研究方法、可行性

本研究将采用以下思路和研究方法:

- 通过调研和分析目标网站的页面结构和数据格式,设计并实现一个有效的数据爬取方案;

- 使用Python的Scrapy框架来实现数据的自动化采集;

- 使用Django框架设计和实现一个Web界面来展示和分析采集到的数据;

- 使用Python的数据分析库对数据进行清洗、分析和可视化;

七、研究进度安排

本研究将分为以下几个阶段进行:

- 第一阶段(1-2个月):进行项目需求分析和系统设计,确定系统的整体架构和功能模块。同时,进行数据库的设计和搭建,以及所需的技术选型和环境配置。

- 第二阶段(3-4个月):编写爬虫程序,实现对目标网站的数据自动化采集。同时,设计和实现后台管理系统,包括用户管理、数据管理、日志管理等功能。

- 第三阶段(5-6个月):进行数据清洗、分析和可视化,设计和实现前台Web界面,包括数据展示、筛选、排序、导出等功能。同时,进行系统的测试和调试,确保系统的稳定性和可靠性。

- 第四阶段(7-8个月):进行系统的试运行和用户反馈收集,对系统进行优化和完善。同时,进行相关文档的编写和整理,包括用户手册、管理员手册、开发文档等。

- 第五阶段(9-10个月):进行项目的总结和成果汇报,包括研究成果、技术创新点、应用前景等。同时,整理并提交研究成果,包括学术论文、专利申请、软件著作权申请等。

八、论文(设计)写作提纲

本论文(设计)将分为以下几个部分进行撰写:

- 引言:介绍本课题的研究背景和意义,阐述研究的目的和内容。

- 文献综述:综述国内外相关研究现状和发展趋势,分析现有研究的不足之处。

- 研究方法与技术:介绍本研究的研究思路和方法,包括数据爬取、数据存储、数据分析、可视化展示等技术细节。

- 系统设计与实现:详细介绍系统的设计过程和实现方法,包括前后台功能的设计与实现、数据库的设计与搭建等。

- 实验与分析:展示实验结果和分析过程,包括数据清洗、分析和可视化等方面的详细阐述。

- 结论与展望:总结本课题的研究成果和创新点,提出未来的研究方向和应用前景。

- 参考文献:列出本论文(设计)所引用的相关文献和资料。

- 附录:提供本论文(设计)中需要补充的材料或证明,如程序代码、数据样本等。

九、主要参考文献

[此处列出主要参考文献]

一、研究背景与意义

随着国内互联网行业的不断发展,网络招聘已经成为一种主流的求职方式。而网络招聘平台上的职位信息,可以为求职者提供大量的职位资源,方便了求职者的就业。而对于企业来说,网络招聘也成为了招聘人才的常规方式之一,通过发布职位信息可以大大提高企业的招聘效率。因此,设计并实现一款基于Python的重庆招聘数据爬虫采集系统,对于提高求职者就业和企业招聘效率有着重要的意义。

二、国内外研究现状

目前国内外已经有不少与网络爬虫相关的研究,例如基于Python的网络爬虫,以及基于Django框架的Web应用程序。其中,网络爬虫主要用于从互联网中获取数据,而Web应用程序则是一种基于Web技术的交互式应用程序。在招聘数据爬虫方面,国内外也有一些相关的研究,例如基于Spark的招聘信息爬虫系统和基于Scrapy的数据爬虫系统。这些研究也为本项目提供了很好的参考和借鉴。

三、研究思路与方法

本项目的研究思路主要包括以下几个步骤:

(1)确定目标招聘网站

本项目的目标是重庆地区的招聘网站,因此需要在众多招聘网站中筛选出符合要求的网站。

(2)分析目标网站

对于目标网站,需要进行分析,包括网页结构分析、数据存储方式分析、访问速度分析等等。

(3)编写爬虫程序

根据目标网站的分析结果,编写相应的爬虫程序,实现对招聘数据的爬取。

(4)数据存储与处理

爬取到的数据需要进行存储和处理,提取出有用的信息,并进行相应的数据清洗和格式化处理,以达到用户可读性的要求。

(5)开发Web应用程序

基于Django框架,开发一个Web应用程序,将数据以可视化的形式展现出来,方便用户查看和搜索。

四、研究内客和创新点

本研究的主要创新点如下:

(1)基于Python的网络爬虫

本项目采用Python语言编写爬虫程序,具有优秀的网络爬取能力,可以快速获取大量招聘数据。

(2)基于Django框架的Web应用程序

本项目采用Django框架开发Web应用程序,具有响应速度快、开发周期短、易于维护等优点。

(3)数据可视化

本项目将爬取到的数据进行可视化处理,方便用户查看和搜索,提升用户体验。

五、前后台功能详细介绍

本项目的前台主要包括以下几个功能:

(1)职位搜索

用户可以在搜索框中输入关键词,进行职位的搜索,并可以根据关键词、工作地点、薪资等条件进行筛选。

(2)职位浏览

用户可以浏览招聘信息,并可以根据时间、薪资等条件进行排序。

(3)阅读详情

用户可以点击招聘信息,进入招聘详情页面,查看职位详细信息。

(4)投递简历

用户可以通过本站投递简历,方便快捷。

后台主要包括以下几个功能:

(1)数据抓取

管理员可以选择要抓取的招聘网站,并进行相应的设置。

(2)数据管理

管理员可以对抓取到的招聘信息进行管理,可进行增删改查等操作。

(3)用户管理

管理员可以管理用户信息,包括用户权限、用户操作等。

(4)系统设置

管理员可以对系统进行设置,包括网站名称、网站标语、SEO设置等。

六、研究思路与研究方法、可行性

本研究采用Python编写爬虫程序,采用Django框架开发Web应用程序,实现对重庆招聘数据的爬取和展示。其中,Python编程语言具有简单易学、高效稳定等特点,是网络爬虫的首选编程语言。而Django框架则具有易于维护、高效开发等优点,能够快速开发Web应用程序。

本项目的研究方法主要是采取实验研究法,通过实际爬取数据来检验本项目的可行性。在实际操作过程中,需要充分了解目标网站的网页结构、数据存储方式、反爬机制等,通过一系列技术手段实现对数据的爬取。

七、研究进度安排

本项目的研究进度安排如下:

(1)前期准备工作

1)选题:初步确定拟研究的课题,进行相关背景调研。

2)确定研究思路:确定研究内容和研究方法,并制定相关计划。

3)文献综述:对国内外相关的文献进行搜集和阅读,为后续研究提供参考。

(2)爬虫程序实现

1)网站选择:在重庆地区的招聘网站中选择符合要求的网站。

2)网页分析:分析目标网站的网页结构、数据存储方式以及反爬机制。

3)编写爬虫程序:根据目标网站的分析结果,编写相应的爬虫程序,并进行测试和调试。

(3)Web应用程序开发

1)框架选择:采用Django框架开发Web应用程序。

2)界面设计:设计可视化的界面,包括搜索框、职位列表、职位详情等。

3)功能实现:实现用户登录、职位搜索、职位浏览、职位详情等功能。

(4)系统测试与完善

1)单元测试:对系统中各模块进行单元测试,防止潜在的错误和漏洞。

2)系统测试:对整个系统进行测试,并对测试结果进行分析和处理。

3)系统完善:对系统中存在的问题进行改进和完善,提升用户体验。文章来源:https://www.toymoban.com/news/detail-818519.html

文章来源地址https://www.toymoban.com/news/detail-818519.html

到了这里,关于基于python重庆招聘数据爬虫采集系统设计与实现(django框架)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!