前言

在机器学习和数据科学领域,模型调参是一个不可避免的任务。为了提高模型的性能,通常需要调整不同的超参数。

常用的调参策略包括:

- 网格搜索(Grid Search) 在模型中尝试的每种可能的参数组合来工作,这意味着执行整个搜索将需要很长时间,而且计算成本可能会很高。

- 随机搜索(Random Search) 使用超参数值的随机组合来找到构建模型的最佳解决方案,缺点是可能会在搜索空间中错过重要的点。

此外还有其他调参的工具包,例如

- Scikit-learn:参考 3.2. Tuning the hyper-parameters of an estimator — scikit-learn 1.3.2 documentation

- Optuna: 在这篇文章中有总结

- Hyperopt: 我们会在接下来的内容中了解Hyperopt的使用方法。

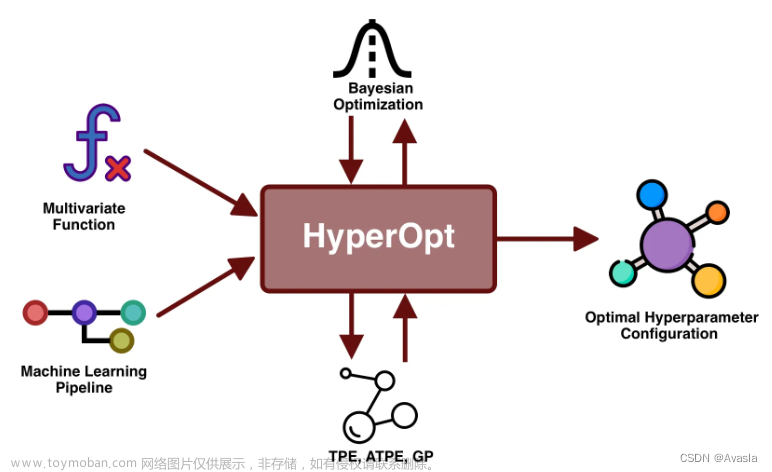

1. Hyperopt是什么?

Hyperopt是一个用于优化算法超参数的开源库,它提供了多种搜索算法,包括随机搜索和基于贝叶斯优化的Tree of Parzen Estimators(TPE)算法。通过调整模型的超参数,Hyperopt帮助实现对目标函数的最大化或最小化,从而提升机器学习模型的性能。

算法介绍:

目前,Hyperopt实现了三种算法:

- 随机搜索(Random Search)

- 树状帕森估计器(Tree of Parzen Estimators,TPE)

- 自适应TPE(Adaptive TPE)

Hyperopt的设计考虑了基于高斯过程和回归树的贝叶斯优化算法,但目前尚未实现这些算法。

所有这些算法都可以通过两种方式并行化:

- Apache Spark

- MongoDB

2. Hyperopt的优缺点

Hyperopt相对于其他调参方法的优势在于采用贝叶斯优化实现智能、高效的超参数搜索,但在初始化配置和处理高维空间方面可能存在一定的劣势。

优势

- 贝叶斯优化: Hyperopt采用贝叶斯优化方法,相较于传统的网格搜索(Grid Search)和随机搜索(Random Search),它更智能地选择超参数,能够在搜索空间中更快地找到全局最优解。

- 自适应: Hyperopt会在每次迭代中自适应地调整搜索空间,根据之前的实验结果动态地更新参数搜索范围,从而更有效地探索超参数空间。

- 并行优化: Hyperopt支持并行优化,能够利用多核处理器或分布式计算资源,加速超参数搜索的过程。

劣势

- 初始化配置: Hyperopt的性能高度依赖于初始化的配置,不同的初始化设置可能导致不同的搜索结果。

- 适应性不足: 在某些复杂的高维超参数空间中,Hyperopt可能无法充分发挥其优势,因为贝叶斯优化算法在高维空间中的表现可能受限。

3. 如何使用 Hyperopt 进行调参

3.1 安装 Hyperopt

pip install hyperopt

3.2 构建超参数空间

首先,定义超参数搜索的范围。使用hp.choice、hp.uniform等函数定义超参数的类型和取值范围。

from hyperopt import hp

space = {

'learning_rate': hp.uniform('learning_rate', 0.01, 0.1),

'n_estimators': hp.choice('n_estimators', [50, 100, 150]),

'max_depth': hp.choice('max_depth', [5, 10, 15]),

# 添加其他超参数...

}

3.3 定义目标函数

编写目标函数,即模型评估的指标,作为贝叶斯优化的目标。这个函数的输入是超参数组合,输出是模型在验证集上的性能指标。

def objective(params):

# 训练模型并返回性能指标

# ...

return performance_metric

3.4 运行 Hyperopt 优化

使用 fmin 函数运行 Hyperopt 优化过程。

from hyperopt import fmin, tpe, Trials

trials = Trials()

best = fmin(fn=objective,

space=space,

algo=tpe.suggest,

max_evals=50,

trials=trials)

3.5 获取最优超参数

最优超参数存储在best字典中。

print("Best Hyperparameters:", best)

4. XGB调参代码示例

下面是一个简单的调参代码示例,使用 XGBoost 模型:

import xgboost as xgb

from sklearn.datasets import load_digits

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

from hyperopt import hp, fmin, tpe, Trials

# 加载数据

digits = load_digits()

X_train, X_val, y_train, y_val = train_test_split(digits.data, digits.target, test_size=0.2, random_state=42)

# 定义超参数搜索空间

space = {

'learning_rate': hp.uniform('learning_rate', 0.01, 0.1),

'n_estimators': hp.choice('n_estimators', [50, 100, 150]),

'max_depth': hp.choice('max_depth', [5, 10, 15]),

}

# 定义目标函数

def objective(params):

model = xgb.XGBClassifier(**params)

model.fit(X_train, y_train)

y_pred = model.predict(X_val)

accuracy = accuracy_score(y_val, y_pred)

return -accuracy # 负号因为 fmin 会最小化目标函数

# 运行 Hyperopt 优化

trials = Trials()

best = fmin(fn=objective,

space=space,

algo=tpe.suggest,

max_evals=50,

trials=trials)

# 获取最优超参数

print("Best Hyperparameters:", best)

这个例子中,我们使用了 XGBoost 分类器,并通过 Hyperopt 寻找最佳的学习率、树的数量和最大深度等超参数。根据实际需求,可以调整搜索空间和目标函数。

参考资料

官方文档: Hyperopt Documentation文章来源:https://www.toymoban.com/news/detail-818802.html

其他文章链接:

Hyperopt - Alternative Hyperparameter Optimization Technique 主要是参数介绍

HyperOpt for Automated Machine Learning With Scikit-Learn - MachineLearningMastery.com 代码有些错误文章来源地址https://www.toymoban.com/news/detail-818802.html

到了这里,关于【机器学习】模型调参工具:Hyperopt 使用指南的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!