pandas还能当爬虫用,你敢信吗?而且超级简单,两行代码就趴下来

只要想提取的表格是属于<table 标签内,就可以使用pd.read_html(),它可以将网页上的表格都抓取下来,并以DataFrame的形式装在一个列表中返回。

例子:

比如这个基金网站,想趴下基金的持仓股表格,

http://vip.stock.finance.sina.com.cn/q/go.php/vComStockHold/kind/jjzc/index.phtml

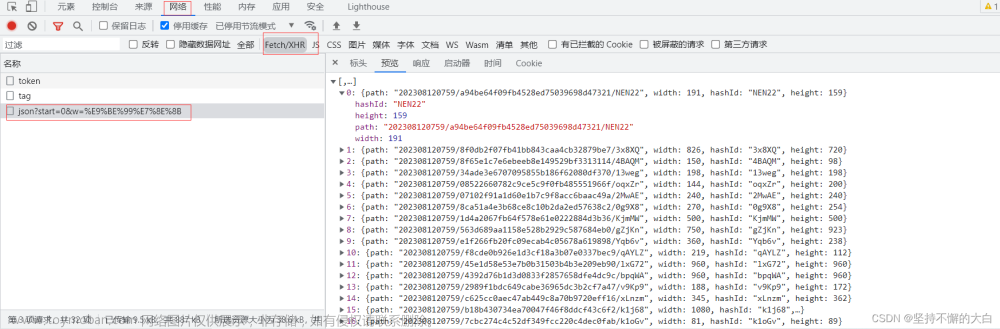

首先F12,页面元素点击表格内容,发现最上面的层级是<table,那么就可以用pandas直接抓!

代码如下:文章来源:https://www.toymoban.com/news/detail-819402.html

import pandas as pd

df = pd.DataFrame()

for i in range(6):

url = 'http://vip.stock.finance.sina.com.cn/q/go.php/vComStockHold/kind/jjzc/index.phtml?p={page}'.format(page=i+1)

df = pd.concat([df,pd.read_html(url)[0]])

print("第{page}页完成~".format(page=i+1))

df.to_csv('D:\\data.csv', encoding=gbk, index=0) #保存地址

就看到保存的CSV文件了

搞定。。!是不是超级简单,记得点个赞哦!文章来源地址https://www.toymoban.com/news/detail-819402.html

到了这里,关于python爬虫——抓取表格pandas当爬虫用超简单的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!