High-Resolution Image Synthesis with Latent Diffusion Models

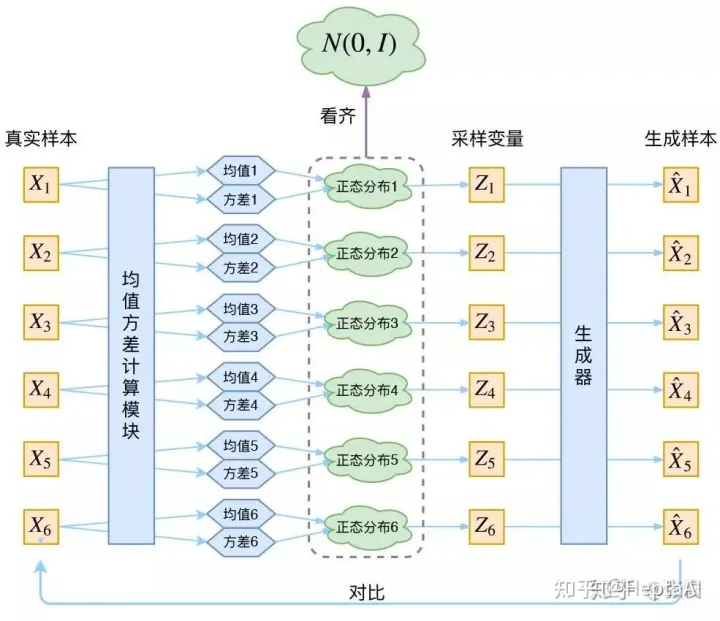

- 主要思想:基于像素空间的扩散模型训练需要消耗巨量资源。作者认为模型在训练的时候会经过两个阶段,前一阶段是语义的压缩和理解,是模型比较重要的,而后一阶段是感知理解和压缩,是人无法感受到的。通过提前训练一个encoder和decoder将图片转化为具有语义信息的潜空间特征,并在特征空间中进行扩散是这篇论文的主要思路。

模型大致如下:通过训练一个\(\mathcal{E}\)和\(\mathcal{D}\)进行正逆映射。通过交叉注意力来引入其他的监督信号。

结果:

- 图像到潜变量的缩放因子在4-16比较好,少了无效果,多了会损失信息无法扩散。

- 在text2img,inpainting、super-resolution都取得了良好效果。

Stable Video Diffusion: Scaling Latent Video Diffusion Models to Large Datasets

主要贡献:设计了一套数据清洗策略来清洗大规模的低质量的数据,用于训练T2V的SOTA模型,并证明了此模型具有足够强的关于动作和3D的先验知识可以用于视频相关的下游任务。

目前主要的T2V的模型都是基于T2I模型进行一些额外的修改(添加序列信息,添加condition等),因此大部分T2V模型的训练会经过以下的流程:image_pretrain ---> video_pretrain ---> video_finetune。模型会现在图片上进行训练,之后是大规模低质量数据,最后实在高质量的数据集上优化。

Data curation workflow

cut detection pipeline \(\rightarrow\) 3 caption method \(\rightarrow\) -> dense optical flow(remove static or text img) \(\rightarrow\) alcu-

late aesthetics scores and text-image similarities.

3 training stage

这几个数据集主要揭示了使用经过处理之后的vedio数据集进行预训练,即使经过了后续的finetune,最终的模型性能仍然更加优秀。上述图片是实验结果。

VideoFactory: Swap Attention in Spatiotemporal Diffusions for Text-to-Video Generation

主要贡献:1. 提出了一个交换空间的交叉注意力方式。2. 收集了130M的高质量、无水印的数据集。

swap Spatiotemporal Cross Attention

主要是对于连续的UNet Blk,分别使用空间特征和时序特征作为Q来进行交叉注意力。

HD-VG-130M

没有详细介绍数据集的收集和清洗过程,使用的是PySceneDetect作为分析工具。

InternVideo: General Video Foundation Models via Generative and Discriminative Learning

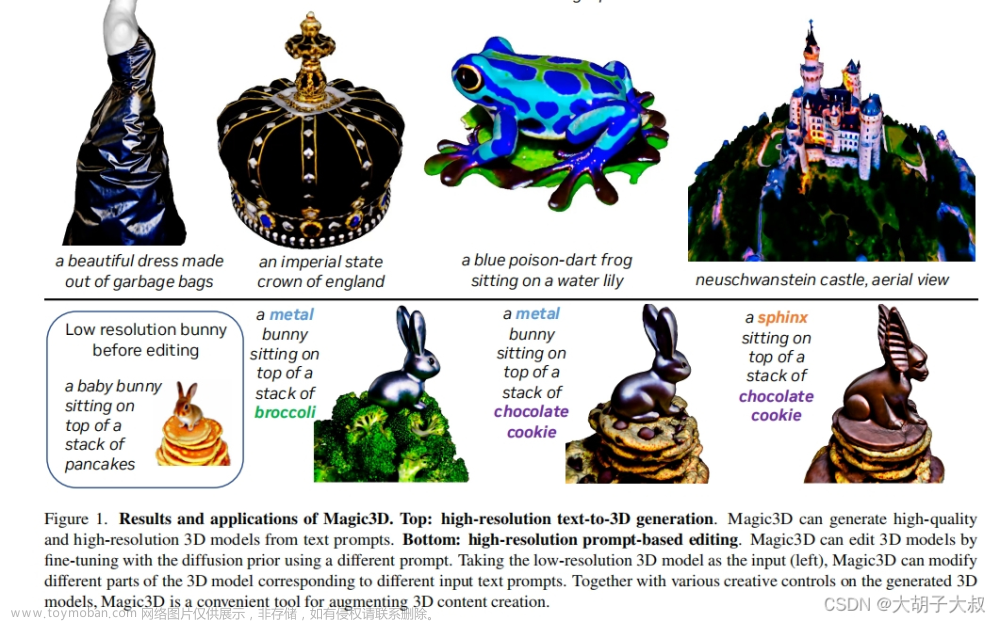

Adding Conditional Control to Text-to-Image Diffusion Models

- 为Stable diffusion加入condition,实现自定义控制

- Stable diffusion 的网络架构不变,Encoder 被复制一份(要求完全复制权重),用于做condition的编码,采用了zero convolution 进行权重初始化(保证没有噪音在初始化时候影响模型),保证在网络训练的初期等价于原始stable diffusion.

将ControlNet用在了SD的Encoder上:

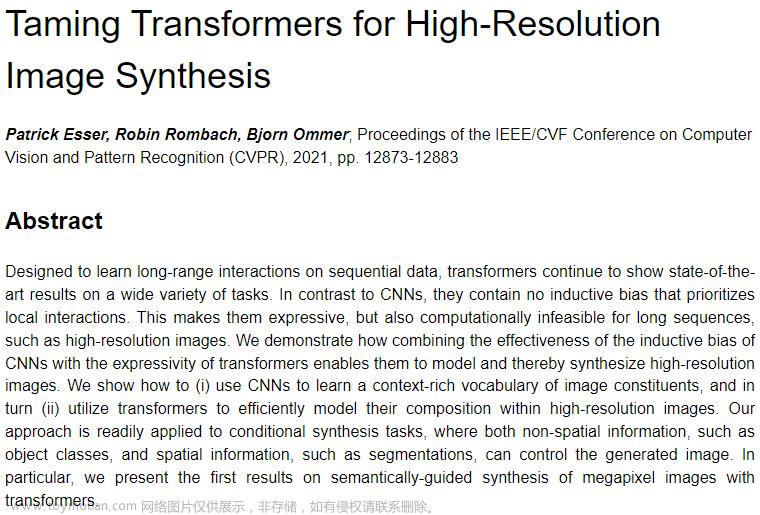

Improved Denoising Diffusion Probabilistic Models

提出了一些改善DDPM的方法:

\(\Sigma_\theta(x_t,t)=\exp(v\log\beta_t+(1-v)\log\tilde{\beta}_t)\)

- 在之前论文发现使用固定的\(\beta_t ,\tilde{\beta}_t\)在最终效果是类似的,采用上述的插值来确定\(\Sigma,v\)是一个学习的变量

\(L_{\mathrm{hybrid}}=L_{\mathrm{simple}}+\lambda L_{\mathrm{vlb}}\)

- 修改了loss函数,使得\(\Sigma\)也能够学习,同时\(\mathrm{L}{vlb}\)只被用于优化\(\Sigma(x_t,t)\),优化\(\mu_{\theta}\)的梯度被关闭。

\(\bar{\alpha}_t=\frac{f(t)}{f(0)},\quad f(t)=\cos\left(\frac{t/T+s}{1+s}\cdot\frac\pi2\right)^2\)

- 修改了\(\alpha_t\)的变化方式,之前都是从0.9-0.999线性增长的,论文通过一种更加平稳的增长方式(加上了<0.999的限制)

通过一系列实验证明了上述方式在生成质量和速度(通过增加stride方式)的优势。

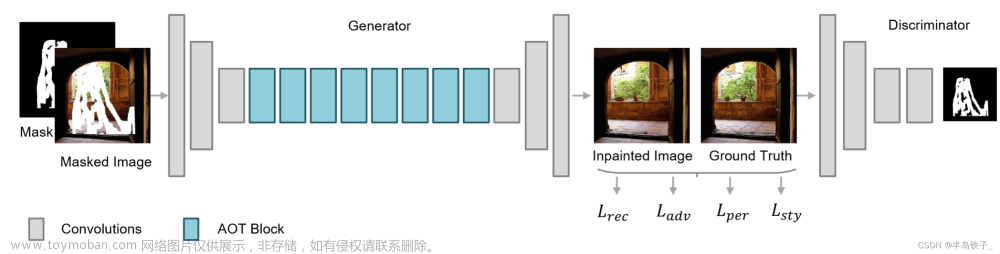

Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifold

一个可以设置多个点移动来对图像空间语意(pose、segmentation...)进行修改的GAN模型

主要分为motion supervision和point tracking两个部分,并且论文认为判别器的中间层特征足够丰富,因此不用使用其他方法就可以用来进行motion 、tracking的工作

- 在生成最终图片之前交替进行

motion supervision和point tracking工作,生成新的image mid-featuremap latentcode,并且在mid feature map上使用最近邻搜索来确定新的point位置。

损失函数:文章来源:https://www.toymoban.com/news/detail-819499.html

上述loss函数是的在\(q_i\)的点向目标点\(t\)移动,移动的距离为\(d_{i}=\frac{t_{i}-p_{i}}{\|t_{i}-p_{i}\|_{2}}\),就是要求\(q_i\)的点向更靠近\(t\)的\(q_i+d_i\)点的特征靠近。文章来源地址https://www.toymoban.com/news/detail-819499.html

到了这里,关于生成方向论文速览的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!