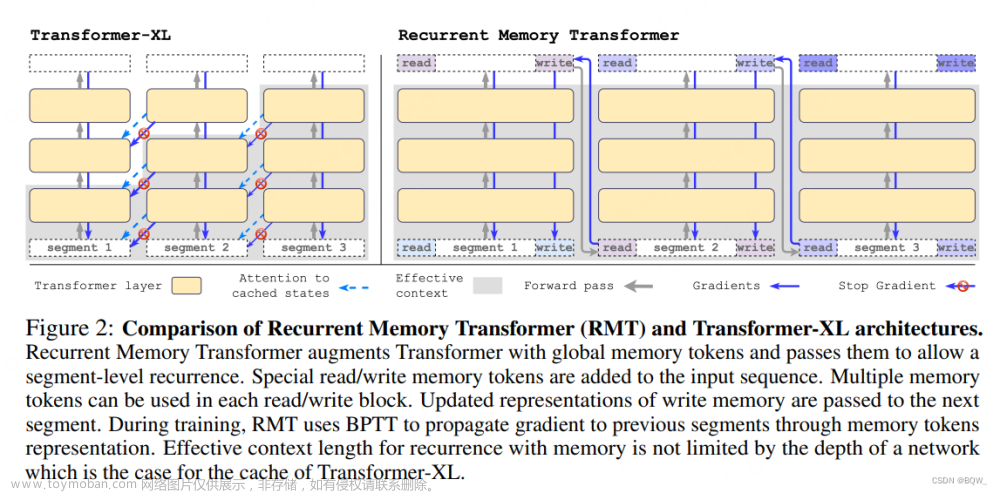

Transformer-XL

首先需要明确,Transformer-XL(XL 是 extra long 的简写)只是一个堆叠了自注意力层的 BPTT 语言模型,并不是 Transformer 原始论文中提到的编码器-解码器架构,也不是原始 Transformer 中的编码器部分或者解码器部分,根据其大致实现可以将其理解为丢弃 cross attention 模块的 Transformer 解码器。之所以名字包含“Transformer”,我认为是当时的很多学者都有一种将自注意力机制与 Transformer 画等的潜意识,更何况当时 Transformer 大火,如果名字中包含“Transformer”,多少可以蹭一下热度。

因此,下面我会常称类似的结构为“自注意力”,而不是 Transformer。

BPTT 意味着与 RNNs 类似,也存在时序计算过程,即当前”时刻“的计算依赖于前一”时刻“的计算结果。Trm-XL 的”时刻“指的是子序列。

概述

在 Trm-XL 论文中,作者将 REF [2] 中的模型视为主要对比的 baseline,并称该模型为普通 Transformer(vanilla Transformer),它也是语言模型。文章来源:https://www.toymoban.com/news/detail-819796.html

在 Trm-XL 之前,Al-Rfou 在 REF [2] 中已经提出了处理文本序列的基于自注意力的语言模型 vanilla Trm,只不过其大致思想是,在训练阶段将文本按照模型可接收的序列长度对文本进行切分,文章来源地址https://www.toymoban.com/news/detail-819796.html

到了这里,关于【自然语言处理】Transformer-XL 讲解的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[自然语言处理] 自然语言处理库spaCy使用指北](https://imgs.yssmx.com/Uploads/2024/02/611542-1.png)