火箭点火发射来理解神经网络的故事细节

在一个充满科技气息的研究室里,一群科学家们正在忙碌地准备着一次重要的火箭点火发射。这次发射不仅是一次航天探索的壮丽征程,更是一场利用神经网络处理数据的智慧之旅。

在火箭发射的背后,神经网络扮演着至关重要的角色。它们就像一位富有经验的导师,通过学习和处理大量数据,为火箭发射提供精确的指导和决策支持。

故事从数据输入开始。在发射前,科学家们收集了大量的历史发射数据,包括各种传感器读数、环境参数、火箭设计信息等。这些数据就像一块未经雕琢的玉石,蕴含着宝藏般的信息。

收集故事中大量历史发射数据

def load_historical_launch_data():

# 从数据输入开始。在发射前,科学家们收集了大量的历史发射数据,

data = [

{

'sensor_reading': 0.2, #传感器读数

'environment_parameter': 0.6,#环境参数

'rocket_design_info': 0.4,#火箭设计信息

'target': 1 # Rocket should fire #火箭点火信号

},

{

'sensor_reading': 0.5,#传感器读数

'environment_parameter': 0.3,#环境参数

'rocket_design_info': 0.8,#火箭设计信息

'target': 0 # Rocket should not fire#火箭点火信号

},

]

return data

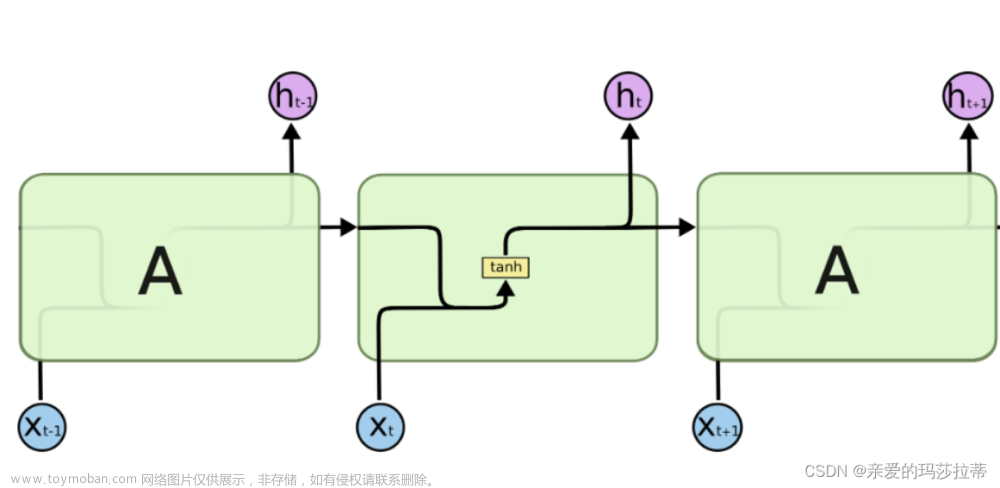

接下来,这些数据被送入神经网络进行学习。神经网络通过模拟人脑神经元之间的连接和信号传递过程,对数据进行逐层分析和抽象。每一层神经元都会从上一层提取特征,并逐层传递下去,最终形成一个高度抽象和具有判别力的数据表示。

把火箭信息处理和人脑神经元之间模拟

import numpy as np

# 神经网络通过模拟人脑神经元之间的连接和信号传递过程,对数据进行逐层分析和抽象

class NeuralNetwork:

def __init__(self, x, y):

self.input = x # 输入层接收原始数据

self.weights1 = np.random.rand(self.input.shape[1],4) # 第一层权重,模拟神经元连接

self.weights2 = np.random.rand(4,1) # 第二层权重

self.y = y # 真实标签

self.output = np.zeros(y.shape) # 输出层,最终的数据表示

# 每一层神经元都会从上一层提取特征,并逐层传递下去

def feedforward(self):

self.layer1 = sigmoid(np.dot(self.input, self.weights1)) # 第一层提取特征,通过激活函数传递

self.output = sigmoid(np.dot(self.layer1, self.weights2)) # 输出层接收上一层特征,形成最终数据表示

# 根据输出误差逐层反向计算每个神经元的误差,使用梯度下降算法更新权重

def backprop(self):

d_weights2 = np.dot(self.layer1.T, (2*(self.y - self.output) * sigmoid_derivative(self.output)))

d_weights1 = np.dot(self.input.T, (np.dot(2*(self.y - self.output) * sigmoid_derivative(self.output), self.weights2.T) * sigmoid_derivative(self.layer1)))

self.weights1 += d_weights1

self.weights2 += d_weights2

# 定义激活函数及其导数,模拟神经元信号传递过程中的非线性变换

def sigmoid(x):

return 1 / (1 + np.exp(-x))

def sigmoid_derivative(x):

return x * (1 - x)

# 示例数据和训练过程

X = np.array([[0,0,1], [0,1,1], [1,0,1], [1,1,1]])

y = np.array([[0],[1],[1],[0]])

nn = NeuralNetwork(X,y)

for i in range(1500): # 通过多次迭代训练神经网络

nn.feedforward()

nn.backprop()

print(nn.output) # 输出训练后的预测结果

在神经网络的内部,数据经历了一场奇妙的旅程。它们通过权重和激活函数的共同作用,在不同的神经元之间传递和变化。这就像是一个复杂而精妙的数据舞蹈,每一个数据点都在舞动中找到了属于自己的位置和意义。

经过神经网络的学习和处理,最终输出的是对火箭发射过程的精确预测和决策建议。科学家们可以根据这些输出信息,调整火箭的点火时间、推力大小、轨道参数等关键参数,确保火箭能够顺利升空并准确到达目标轨道。

输出的火箭发射过程精确预测和决策

ignition_time, thrust, orbit_param = adjust_rocket_parameters(prediction)

print(f"根据神经网络的预测,建议的点火时间为:{ignition_time}秒,推力大小为:{thrust}牛顿,轨道参数为:{orbit_param}")

最终,火箭点火发射的时刻到来了。在科学家们的精心操控下,火箭犹如一条巨龙腾空而起,冲破了大气层的束缚,向着浩渺的宇宙进发。这一次的发射成功,不仅彰显了人类科技的伟大成就,更展示了神经网络在数据处理和学习方面的巨大潜力。

在这个故事中,我们看到了神经网络如何以数据的处理和学习为基础,为火箭发射提供了强大的智力支持。它们就像是一位智慧的导师,通过学习和分析数据,为我们揭示了隐藏在其中的规律和奥秘。文章来源:https://www.toymoban.com/news/detail-822796.html

随着科技的不断发展,神经网络将在更多领域发挥重要作用。它们将帮助我们处理和分析日益复杂的数据集,揭示出更多未知的领域和可能性。让我们期待这场科技与智慧的奇妙之旅将带领我们走向更加美好的未来!文章来源地址https://www.toymoban.com/news/detail-822796.html

根据文章完整梳理代码如下:

import numpy as np

# 故事中的数据输入部分

# 假设我们有以下传感器读数和环境参数作为输入数据

sensor1_data = np.array([[0.1]]) # 传感器1数据:温度

sensor2_data = np.array([[0.2]]) # 传感器2数据:湿度

# ... 更多数据 ...

# 定义神经网络的结构参数

input_size = 3 # 输入层神经元数量

hidden_layers = [4, 3] # 隐藏层神经元数量

output_size = 1 # 输出层神经元数量

# 创建神经网络实例

rocket_nn = RocketNeuralNetwork(input_size, hidden_layers, output_size)

# 输入数据需要被转换为神经网络可以处理的格式

input_data = np.array([sensor1_data, sensor2_data, # 更多数据...

# ...]))

# 火箭发射前,神经网络对输入数据进行学习和处理

# 这里简化为使用一个示例神经网络前向传播的结果

processed_data = rocket_nn.feedforward(input_data)[-1]

# 故事中的数据输出部分,即神经网络的预测和决策

# 假设神经网络输出火箭发射的控制参数

prediction = processed_data[0] # 获取输出层第一个神经元的预测结果

# 根据预测结果调整火箭参数

ignition_time, thrust, orbit_param = adjust_rocket_parameters(prediction)

print(f"根据神经网络的预测,建议的点火时间为:{ignition_time}秒,推力大小为:{thrust}牛顿,轨道参数为:{orbit_param}")

# 下面是神经网络类的定义

class RocketNeuralNetwork:

# 初始化神经网络的权重和偏差

def __init__(self, input_size, hidden_layers, output_size):

self.input_size = input_size

self.hidden_layers = hidden_layers

self.output_size = output_size

# 随机初始化权重和偏差

self.weights = []

self.biases = []

for i in range(len(hidden_layers) + 1):

if i == 0:

# 输入层的权重

self.weights.append(np.random.rand(input_size, hidden_layers[0]))

elif i == len(hidden_layers):

# 输出层的权重

self.weights.append(np.random.rand(hidden_layers[-1], output_size))

else:

# 隐藏层的权重

self.weights.append(np.random.rand(hidden_layers[i - 1], hidden_layers[i]))

self.biases.append(np.random.rand(hidden_layers[i]))

# Sigmoid激活函数

def sigmoid(self, x):

return 1 / (1 + np.exp(-x))

# 前向传播

def feedforward(self, inputs):

assert inputs.shape == (self.input_size, 1), "输入数据形状不正确"

layer_inputs = inputs

layer_outputs = []

for weight_matrix, bias in zip(self.weights, self.biases):

layer_inputs = self.sigmoid(np.dot(layer_inputs, weight_matrix) + bias)

layer_outputs.append(layer_inputs)

return layer_outputs

# 根据预测结果调整火箭参数

def adjust_rocket_parameters(prediction):

# 根据预测结果调整火箭参数,这里只是一个简单的示例

ignition_time = prediction[0] * 0.1 # 假设点火时间与预测结果成正比

thrust = prediction[0] * 1000 # 假设推力与预测结果成正比

orbit_param = prediction[0] * 5 # 假设轨道参数与预测结果成正比

return ignition_time, thrust, orbit_param

ignition_time, thrust, orbit_param = adjust_rocket_parameters(prediction)

print(f"根据神经网络的预测,建议的点火时间为:{ignition_time}秒,推力大小为:{thrust}牛顿,轨道参数为:{orbit_param}")

到了这里,关于【神经网络】火箭点火发射-诠释一场数据与学习的奇妙之旅的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[图神经网络]图卷积神经网络--GCN](https://imgs.yssmx.com/Uploads/2024/02/500041-1.png)