Self-Organized Group for Cooperative Multi-Agent Reinforcement Learning

这是一篇发表在NeurIPS2022的论文,文章提出了一种分组算法,旨在提高算法零样本泛化能力

1 论文背景

CTDE:集中训练分散执行,在训练阶段将所有智能体的Q值加到一起去训练,训练完了之后在执行阶段大家各自执行自己的,比较典型的有qmix算法

存在问题:泛化能力一般、协作能力一般(没有通信)

解决方案:

加入通信,结合现实生活中的现象:一个公司往往分成好几个部门,每个部门都有各自的领导,领导下发任务,该论文设计了一个自组织的分组强化学习算法(SOG),每个组内的成员只和指挥者通信,提高效率

设计了一个基于变分的通信器,提高通信效率

例子:

背景:A、B、C同时按下按钮才可以完成任务,按钮位置固定,按钮1和2相距10m,按钮3在按钮1和2中间;

观测:局部观测视野在6m,也就是说A观测不到B按;

限制:显然CTDE框架下Qmix没法解决这个问题;

引出:设计了一种基于通信的CTDE方法解决上述问题

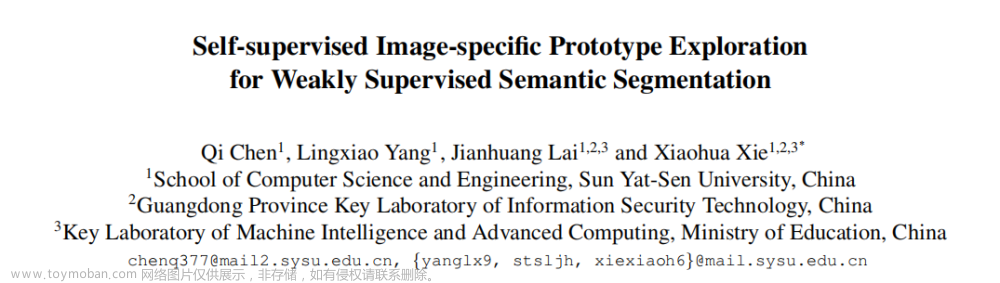

2 论文方法

文章来源:https://www.toymoban.com/news/detail-822945.html

文章来源:https://www.toymoban.com/news/detail-822945.html

- 选出指挥者,指挥者向周围的智能体发出组队邀请;

- 其余智能体选取自己想要追随的指挥者,并打包发送信息给自己的指挥者;

- 队伍成立,指挥者给小组成员发送处理过的信息

指挥者选取方法: - 随机CE:每个agent以一定概率p当指挥官

- DPP-based CE:希望最大化指挥官之间的多样性,保证选取出来指挥官相关性小

- PG-based CE:基于策略梯度,将指挥官的选择也视为一个强化学习任务。输入是全局状态,输出是每个agent成为指挥官的概率,用PG做梯度下降

消息传递总体规则: - 分组形成后,指挥官接受组内的消息,将处理后的信息发送回分组内的成员

- 指挥官采用累加求平均的非参数化消息混合器处理接受到的信息

每个智能体只需要与组内的指挥官通信

3 实验效果

文章来源地址https://www.toymoban.com/news/detail-822945.html

文章来源地址https://www.toymoban.com/news/detail-822945.html

到了这里,关于强化学习论文阅读——自动分组Self-Organized Group for Cooperative Multi-Agent Reinforcement Learning的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文阅读]Self-Supervised Learning for Videos: A Survey](https://imgs.yssmx.com/Uploads/2024/02/795864-1.png)