1 矩阵运算基本概念

1.1 点积

又称为数量积、标量积(scalar product)或者内积(inner product)

它是指实数域中的两个向量运算得到一个实数值标量的二元运算。也就是对应元素的位置相乘

举例:

对于向量 a = ( x 1 , y 1 ) 和 b = ( x 2 , y 2 ) ,他们的点积就是 a ⋅ b = x 1 x 2 + y 1 y 2 a=(x_1,y_1)和b=(x_2,y_2),他们的点积就是a·b=x_1x_2+y_1y_2 a=(x1,y1)和b=(x2,y2),他们的点积就是a⋅b=x1x2+y1y2

1.2 矩阵乘法

两个运算的矩阵需要满足矩阵乘法规则,即需要前一个矩阵的列和后一个矩阵的行相等

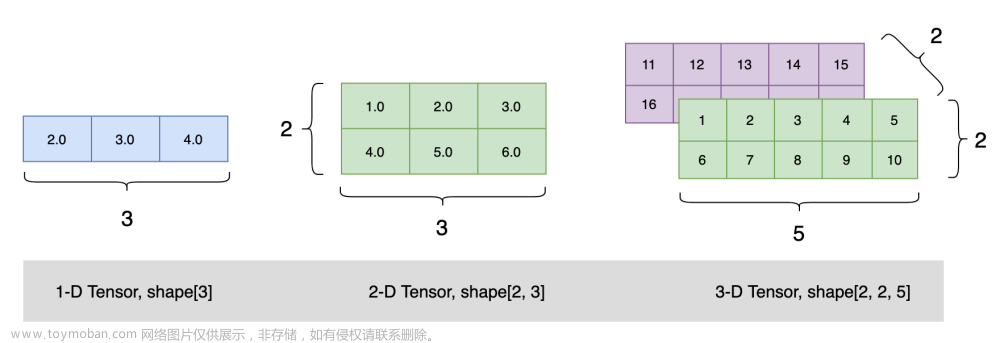

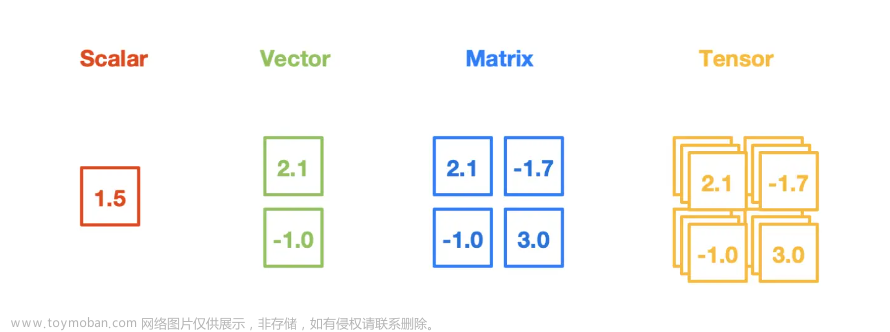

一般我们用矩阵运算

就是Numpy的ndarray和torch的tensor张量 两种矩阵形式进行运算

他们大体相同,有一些小的差异,比如numpy的dot可以实现高维度的矩阵乘法但是torch的dot不可以

下表详细比较了他们之间的差异

| 运算 | 形式 | 实现结果 | 返回结果 |

|---|---|---|---|

| dot函数 | numpy.dot(a,b) torch.dot(a,b) | numpy的dot 可以实现一维度点积及高唯度的矩阵乘法,而torch的dot只能实现一维度点积,不能实现高维度矩阵乘法(报错RuntimeError: 1D tensors expected, but got 2D and 2D tensors) | 对应位置会加起来,往往返回会是一个数字 |

| multiply()函数 等价于 * | numpy.multiply(a,b) torch.multiply(a,b) a*b | 点乘(和dot不同的是乘完之后不会加起来)返回往往是一个矩阵,两个矩阵必须形状一致 | 对应位置乘完之后不会加起来,往往返回是一个矩阵 |

| matmul()函数等价于@ | numpy.matmul(a,b) torch.matmul(a,b) 或者torch.mm(a,b) a@b | 矩阵乘法 | 往往返回是一个矩阵 |

具体看下面的例子

2 dot()

numpy和torch的dot 可以用在一维的数组相乘,此时相当于两个数组的点积。

例1

import numpy as np

a=np.array([1,2,3])

b=np.array([2,3,4])

print(np.dot(a,b))

输出

20

numpy的dot也可以用在多维数组的相乘,此时是矩阵乘法,所以需要满足矩阵乘法的运算规则,需要前一个矩阵的列和后一个矩阵的行相等

例2

import numpy as np

a=np.array([[1,2,3],

[1,2,3]])

b=np.array([[2,3],

[3,4],

[5,6]])

print(np.dot(a,b))

输出

[[23 29]

[23 29]]

但是torch的dot就会报错

例3

a=torch.tensor([[1,2,3,4],[1,2,3,4]])

b=torch.tensor([[5,6],[7,8],[5,6],[7,8]])

print(a.ndim,b.ndim)

print(torch.dot(a,b))

输出

RuntimeError: 1D tensors expected, but got 2D and 2D tensors

3 multiply() 和 *

两个运算都是相当于点乘,可以实现一维或高维度的点积,参与运算的两个矩阵必须形状一致

(和dot不同的是乘完之后不会加起来)返回往往是一个矩阵

import numpy as np

a=np.array([[1,2,3],

[1,2,3]])

b=np.array([[2,3,4],

[3,4,5]],)

print("multiply:")

print(np.multiply(a,b))

print("*:")

print(a*b)

输出

multiply:

[[ 2 6 12]

[ 3 8 15]]

*:

[[ 2 6 12]

[ 3 8 15]]

4 matmul和@

matmul 是matrix multiply的缩写,专门用于矩阵乘法,需要满足矩阵乘法的运算规则,需要前一个矩阵的列和后一个矩阵的行相等

import numpy as np

a=np.array([[1,2,3],

[1,2,3]])

b=np.array([[2,3],

[3,4],

[5,6]])

print("matmul:")

print(np.matmul(a,b))

print("@:")

print(a@b)

输出

matmul:

[[23 29]

[23 29]]

@:

[[23 29]

[23 29]]

注意这里的行向量可以列向量,比如

a=np.array([[1,2,3],

[1,2,3]])

b=np.array([2,3,4])

我们如果把b看做1行3列的矩阵,则运算不符合运算规则,但是如果看做3行1列的矩阵,则它是正确的,即2*3 × 3 * 1=2 * 1 即最后会输出一维的向量

import numpy as np

a=np.array([[1,2,3],

[1,2,3]])

b=np.array([2,3,4])

print("matmul:")

print(np.matmul(a,b))

输出

matmul:

[20 20]

在PyTorch中,有几种执行矩阵乘法的方式,包括torch.matmul、torch.mm和@运算符。这些方法之间有一些区别,让我们逐个解释它们:

-

torch.matmul:

-

torch.matmul是PyTorch中用于执行矩阵乘法的通用函数。 - 它支持广播(broadcasting),可以处理不同形状的输入矩阵。

- 对于两个二维矩阵,

torch.matmul等效于矩阵乘法。 - 对于高维张量,

torch.matmul会在合适的维度上进行广播,以进行张量间的乘法。

import torch A = torch.tensor([[1, 2], [3, 4]]) B = torch.tensor([[5, 6], [7, 8]]) result = torch.matmul(A, B) -

-

torch.mm:

-

torch.mm是专门用于两个二维矩阵相乘的函数,不支持广播。 - 输入的两个矩阵必须是二维的,并且符合矩阵乘法的规则。

import torch A = torch.tensor([[1, 2], [3, 4]]) B = torch.tensor([[5, 6], [7, 8]]) result = torch.mm(A, B) -

-

@运算符:文章来源:https://www.toymoban.com/news/detail-824412.html

-

@运算符在PyTorch中被重载,用于执行矩阵乘法。 - 类似于

torch.matmul,它支持广播操作。

import torch A = torch.tensor([[1, 2], [3, 4]]) B = torch.tensor([[5, 6], [7, 8]]) result = A @ B -

总结:文章来源地址https://www.toymoban.com/news/detail-824412.html

- 如果你希望使用通用的矩阵乘法函数,并且想要支持广播,可以使用

torch.matmul或@运算符。 - 如果你知道你的输入是二维矩阵且不需要广播,可以使用

torch.mm。 - 通常来说,推荐使用

torch.matmul或@运算符,因为它们更通用,而torch.mm仅限于二维矩阵。

到了这里,关于【易混区分】 tensor张量 Numpy张量的各种矩阵乘法、点积的函数对比 (dot, multiply,*,@matmul)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!