1.背景介绍

在过去的几年里,计算机视觉技术取得了巨大的进步,这主要归功于深度学习技术的蓬勃发展。深度学习技术为计算机视觉提供了强大的表示和学习能力,使得许多复杂的计算机视觉任务变得可行。然而,随着数据规模和任务复杂性的增加,深度学习模型的复杂性也随之增加,这导致了训练时间的长度和计算资源的需求的增加。此外,深度学习模型的黑盒性使得模型的解释性和可解释性变得困难。

为了解决这些问题,人工智能科学家和计算机视觉研究人员开始关注基于动作和评价的学习方法,这些方法被称为Actor-Critic算法。Actor-Critic算法是一种基于动作的深度学习算法,它结合了策略梯度(Policy Gradient)和值网络(Value Network)两个核心组件,以实现模型的优化和评估。

在本文中,我们将深入探讨Actor-Critic算法在计算机视觉领域的应用,特别是在图像和视频分析任务中。我们将讨论Actor-Critic算法的核心概念、原理和具体实现,并通过代码示例来说明其使用方法。最后,我们将讨论Actor-Critic算法在计算机视觉领域的未来发展趋势和挑战。

2.核心概念与联系

2.1 Actor-Critic算法基本概念

Actor-Critic算法是一种基于动作的深度学习算法,它结合了策略梯度(Policy Gradient)和值网络(Value Network)两个核心组件,以实现模型的优化和评估。策略梯度是一种基于动作的学习方法,它通过优化策略网络来实现模型的优化。值网络则用于评估状态值,从而帮助策略网络进行优化。

在Actor-Critic算法中,策略网络(Actor)用于生成动作,而值网络(Critic)用于评估这些动作的质量。策略网络和值网络共同工作,以实现模型的优化和评估。

2.2 Actor-Critic算法与计算机视觉的联系

Actor-Critic算法在计算机视觉领域的应用主要体现在图像和视频分析任务中。通过将Actor-Critic算法应用于计算机视觉任务,我们可以实现以下优势:

- 解决深度学习模型的黑盒性问题,提高模型的解释性和可解释性。

- 减少深度学习模型的复杂性,降低训练时间和计算资源的需求。

- 实现模型的动态调整,以适应不同的任务和环境。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 Actor-Critic算法原理

Actor-Critic算法的核心原理是通过策略梯度和值网络来实现模型的优化和评估。策略梯度通过优化策略网络来实现模型的优化,而值网络则用于评估状态值,从而帮助策略网络进行优化。

3.1.1 策略梯度

策略梯度是一种基于动作的学习方法,它通过优化策略网络来实现模型的优化。策略网络通过输入状态并输出动作来实现。策略网络的优化目标是最大化累积奖励。

3.1.2 值网络

值网络用于评估状态值,从而帮助策略网络进行优化。值网络通过输入状态并输出状态值来实现。值网络的优化目标是最小化预测值与实际值之间的差异。

3.2 Actor-Critic算法具体操作步骤

Actor-Critic算法的具体操作步骤如下:

- 初始化策略网络(Actor)和值网络(Critic)。

- 从环境中获取初始状态。

- 使用策略网络生成动作。

- 执行动作并获取奖励和下一状态。

- 使用值网络评估当前状态的值。

- 使用策略网络和值网络进行优化。

- 重复步骤3-6,直到达到终止条件。

3.3 Actor-Critic算法数学模型公式详细讲解

3.3.1 策略梯度

策略梯度的目标是最大化累积奖励。策略梯度通过优化策略网络来实现模型的优化。策略网络的输出是一个概率分布,表示在当前状态下取得的动作概率。策略梯度的数学模型公式如下:

$$ \nabla \theta = \mathbb{E}[\nabla{\theta} \log \pi{\theta}(a|s)Q(s,a)] $$

其中,$\theta$是策略网络的参数,$a$是动作,$s$是状态,$Q(s,a)$是状态动作值函数。

3.3.2 值网络

值网络的目标是最小化预测值与实际值之间的差异。值网络通过输入状态并输出状态值来实现。值网络的数学模型公式如下:

$$ V(s) = \mathbb{E}{\tau \sim P}[\sum{t=0}^{T} \gamma^t rt | s0 = s] $$

其中,$V(s)$是状态$s$的值,$r_t$是时间$t$的奖励,$\gamma$是折扣因子。

4.具体代码实例和详细解释说明

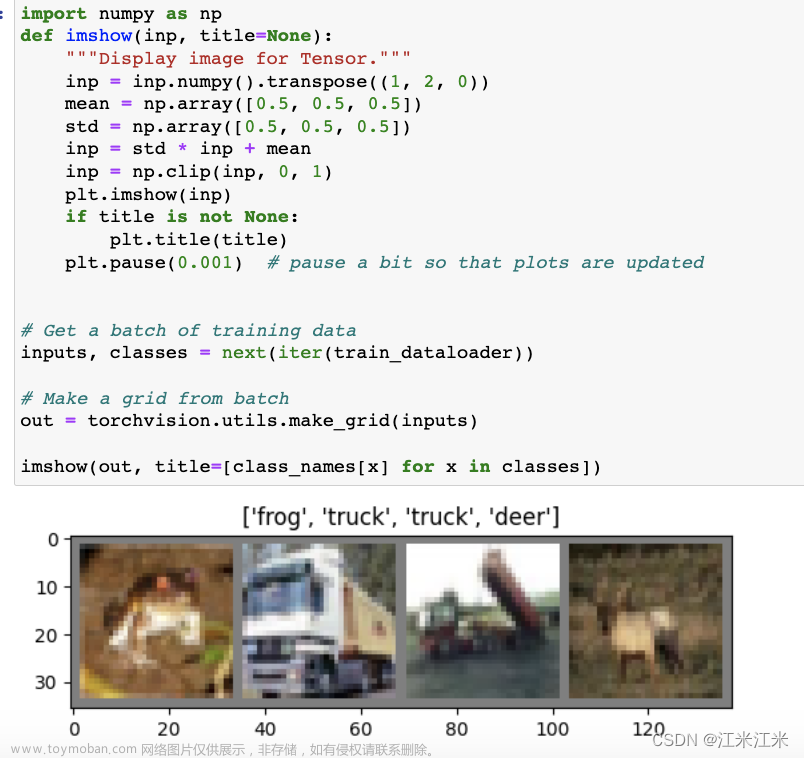

在本节中,我们将通过一个简单的图像分类任务来演示Actor-Critic算法的具体应用。我们将使用PyTorch实现Actor-Critic算法,并在CIFAR-10数据集上进行训练。

```python import torch import torch.nn as nn import torch.optim as optim import torchvision.transforms as transforms import torchvision.datasets as datasets import torchvision.models as models

定义策略网络和值网络

class Actor(nn.Module): def init(self, inputsize, outputsize): super(Actor, self).init() self.fc1 = nn.Linear(inputsize, 128) self.fc2 = nn.Linear(128, outputsize)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.sigmoid(self.fc2(x))

return xclass Critic(nn.Module): def init(self, inputsize): super(Critic, self).init() self.fc1 = nn.Linear(inputsize, 128) self.fc2 = nn.Linear(128, 1)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x初始化策略网络和值网络

inputsize = 32 * 32 * 3 outputsize = 10 actor = Actor(inputsize, outputsize) critic = Critic(input_size)

定义优化器

actoroptimizer = optim.Adam(actor.parameters(), lr=1e-3) actoroptimizer.zero_grad()

criticoptimizer = optim.Adam(critic.parameters(), lr=1e-3) criticoptimizer.zero_grad()

定义损失函数

criterion = nn.MSELoss()

训练策略网络和值网络

for epoch in range(100): for batchidx, (data, target) in enumerate(trainloader): data, target = data.to(device), target.to(device)

# 使用策略网络生成动作

action = actor(data)

# 执行动作并获取奖励和下一状态

reward = critic(data)

next_state = data

# 使用策略网络和值网络进行优化

# 策略网络优化

actor_loss = criterion(action, next_state)

actor_loss.backward()

actor_optimizer.step()

# 值网络优化

critic_loss = criterion(reward, next_state)

critic_loss.backward()

critic_optimizer.step()

# 清空梯度

actor_optimizer.zero_grad()

critic_optimizer.zero_grad()保存训练好的模型

torch.save(actor.statedict(), 'actor.pth') torch.save(critic.statedict(), 'critic.pth') ```

5.未来发展趋势与挑战

在未来,Actor-Critic算法在计算机视觉领域的发展趋势和挑战主要体现在以下几个方面:

- 提高算法效率和性能:随着数据规模和任务复杂性的增加,Actor-Critic算法的效率和性能将成为关键问题。为了解决这个问题,我们需要发展更高效的算法和优化技术。

- 提高模型的解释性和可解释性:深度学习模型的黑盒性限制了模型的解释性和可解释性。为了提高模型的解释性和可解释性,我们需要开发新的解释性方法和工具。

- 应用于更复杂的计算机视觉任务:Actor-Critic算法已经在图像和视频分析任务中得到了应用。在未来,我们需要探索更复杂的计算机视觉任务,如目标检测、场景理解和人工智能视觉等。

6.附录常见问题与解答

在本节中,我们将回答一些关于Actor-Critic算法在计算机视觉领域的常见问题。

Q:Actor-Critic算法与传统的深度学习算法有什么区别?

A:Actor-Critic算法与传统的深度学习算法的主要区别在于它们的学习目标和优化方法。传统的深度学习算法通常通过最小化损失函数来优化模型,而Actor-Critic算法通过优化策略网络和值网络来实现模型的优化和评估。

Q:Actor-Critic算法在计算机视觉任务中的应用有哪些?

A:Actor-Critic算法在计算机视觉领域的应用主要体现在图像和视频分析任务中,如图像分类、目标检测、场景理解等。

Q:Actor-Critic算法有哪些优势?文章来源:https://www.toymoban.com/news/detail-825256.html

A:Actor-Critic算法在计算机视觉领域具有以下优势:文章来源地址https://www.toymoban.com/news/detail-825256.html

- 解决深度学习模型的黑盒性问题,提高模型的解释性和可解释性。

- 减少深度学习模型的复杂性,降低训练时间和计算资源的需求。

- 实现模型的动态调整,以适应不同的任务和环境。

到了这里,关于ActorCritic Algorithms in Computer Vision: Enhancing Image and Video Analysis的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!