随着人工智能技术的飞速发展,聊天机器人成为了一个热门的研究领域。清华大学研发的ChatGLM3模型,作为其中的佼佼者,为开发者提供了强大的自然语言处理能力。本文将指导您如何在本地搭建ChatGLM3模型,实现离线AI聊天功能。

一、前置准备

在开始搭建之前,您需要准备以下物品:

- 一台性能良好的计算机,建议配置至少8GB内存和2GB显存的显卡。

- 安装Python 3.8或更高版本。

- 安装必要的Python库,如torch、transformers等。

- 下载ChatGLM3模型文件。

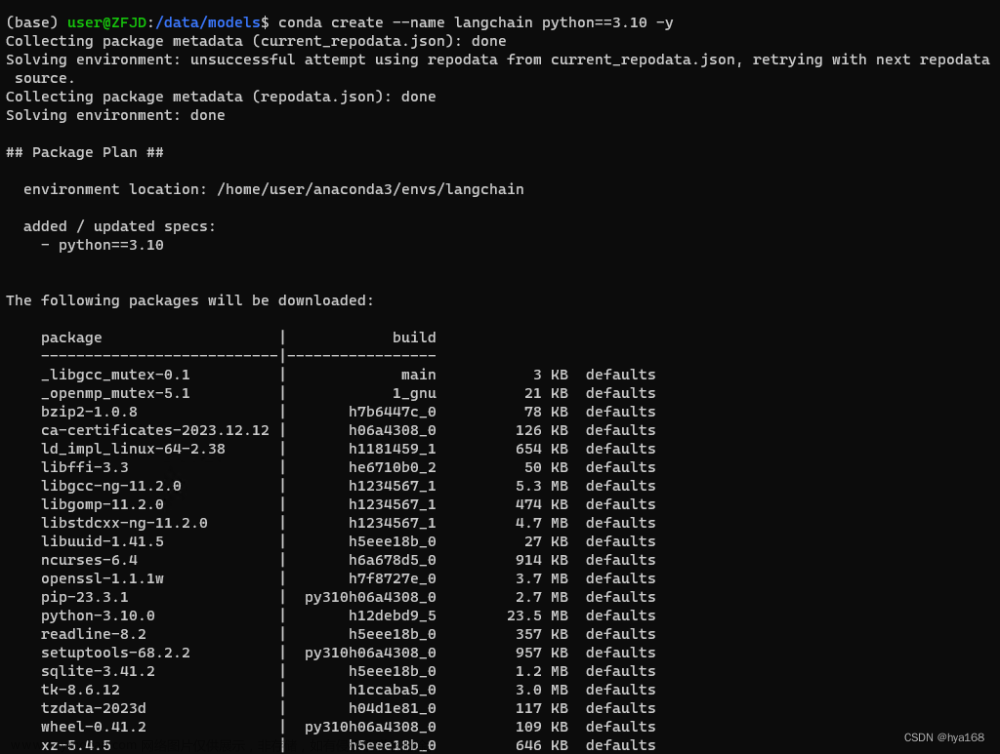

二、安装依赖

在搭建过程中,您需要使用到一些Python库。您可以通过以下命令安装这些库:

pip install torch transformers

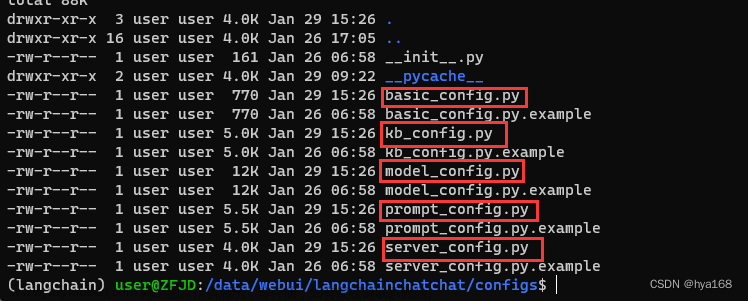

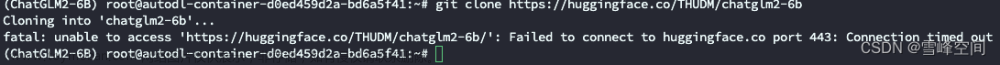

三、下载并加载模型

- 从清华大学官方渠道下载ChatGLM3模型文件。

- 将下载的模型文件解压到本地目录。

- 使用Python加载模型:

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("path/to/your/model")

model = AutoModelForCausalLM.from_pretrained("path/to/your/model")

其中,"path/to/your/model"为模型文件所在的路径。

四、实现聊天功能

接下来,我们可以使用加载的模型来实现聊天功能。以下是一个简单的示例:

def chat(prompt):

inputs = tokenizer(prompt, return_tensors="pt")

outputs = model.generate(**inputs, max_length=256)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

return response

# 测试聊天功能

user_input = "你好,我是用户。请问有什么可以帮到您的吗?"

bot_response = chat(user_input)

print(bot_response)

在这个示例中,我们定义了一个名为chat的函数,它接受一个字符串作为输入(用户的提问),然后使用模型生成一个回复。我们使用tokenizer.decode将模型的输出转换为文本格式,并将其作为回复返回。

五、注意事项文章来源:https://www.toymoban.com/news/detail-825320.html

- ChatGLM3模型需要较大的计算资源,因此在运行过程中可能会占用较多的内存和显存。请确保您的计算机性能足够强大,以支持模型的运行。

- 在使用模型时,请遵循相关法律法规和道德准则,不要使用模型进行违法或不当行为。

通过本文的指导,您应该已经成功在本地搭建了ChatGLM3模型,并实现了离线AI聊天功能。祝您使用愉快!文章来源地址https://www.toymoban.com/news/detail-825320.html

到了这里,关于离线AI聊天清华大模型(ChatGLM3)本地搭建指南的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!