1.背景介绍

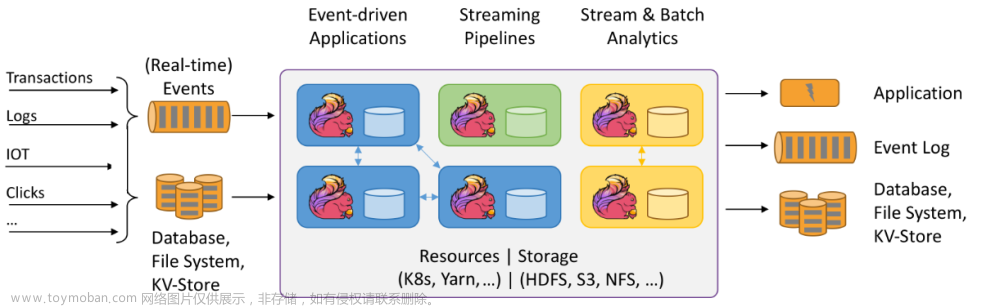

在大数据时代,实时数据处理和批处理数据分析都是非常重要的。Apache Flink 和 Apache Hadoop 是两个非常受欢迎的大数据处理框架。Flink 是一个流处理框架,专注于实时数据处理,而 Hadoop 是一个批处理框架,专注于大规模数据存储和分析。在某些场景下,我们需要将 Flink 和 Hadoop 集成在一起,以实现实时和批处理的数据处理。

在本文中,我们将讨论如何将 Flink 与 Hadoop 集成,以实现实时流处理和批处理数据分析。我们将从背景介绍、核心概念与联系、核心算法原理和具体操作步骤、最佳实践、实际应用场景、工具和资源推荐以及未来发展趋势与挑战等方面进行深入探讨。

1. 背景介绍

Apache Flink 是一个流处理框架,它可以处理大规模数据流,并实时分析和处理这些数据。Flink 支持流式计算和事件时间语义,使其非常适用于实时应用。另一方面,Apache Hadoop 是一个分布式文件系统和批处理框架,它可以存储和分析大量数据。Hadoop 支持数据的持久化和批量处理,使其非常适用于批处理应用。

在某些场景下,我们需要将 Flink 和 Hadoop 集成在一起,以实现实时和批处理的数据处理。例如,在一些实时应用中,我们可能需要将实时数据存储到 Hadoop 中,以便进行后续的批处理分析。在另一些场景下,我们可能需要将 Hadoop 中的数据流式处理,以实现实时分析和报警。

2. 核心概念与联系

为了将 Flink 与 Hadoop 集成,我们需要了解一下它们的核心概念和联系。

2.1 Flink 核心概念

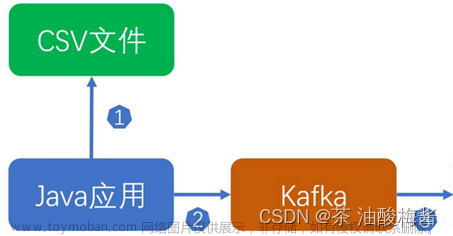

- 数据流(Stream):Flink 中的数据流是一种无限序列数据,它可以被分解为一系列的元素。数据流可以来自于外部数据源,如 Kafka、TCP 流等,也可以是 Flink 内部生成的数据流。

- 数据源(Source):数据源是 Flink 中用于生成数据流的组件。Flink 支持多种数据源,如 Kafka、TCP 流、文件等。

- 数据接收器(Sink):数据接收器是 Flink 中用于接收数据流的组件。Flink 支持多种数据接收器,如 HDFS、Kafka、文件等。

- 数据流操作:Flink 支持多种数据流操作,如映射、过滤、聚合、连接等。这些操作可以用于对数据流进行转换和处理。

2.2 Hadoop 核心概念

- Hadoop 分布式文件系统(HDFS):HDFS 是 Hadoop 的核心组件,它是一个分布式文件系统,用于存储和管理大量数据。HDFS 支持数据的持久化和并行访问。

- MapReduce:MapReduce 是 Hadoop 的核心计算模型,它是一个分布式并行计算框架,用于处理大量数据。MapReduce 分为两个阶段:Map 阶段和 Reduce 阶段。Map 阶段用于对数据进行分组和处理,Reduce 阶段用于对分组后的数据进行汇总和聚合。

2.3 Flink 与 Hadoop 的联系

Flink 和 Hadoop 可以通过以下方式进行集成:

- Flink 作为 Hadoop 的数据源:我们可以将 Flink 中的数据流作为 Hadoop 的数据源,以实现实时数据处理和批处理分析。

- Flink 作为 Hadoop 的数据接收器:我们可以将 Hadoop 中的数据流作为 Flink 的数据接收器,以实现实时数据处理和批处理分析。

- Flink 与 Hadoop 的数据交换:我们可以将 Flink 中的数据流写入到 HDFS,以便在 Hadoop 中进行批处理分析。同时,我们也可以将 Hadoop 中的数据流读取到 Flink,以便在 Flink 中进行实时分析和报警。

3. 核心算法原理和具体操作步骤

为了将 Flink 与 Hadoop 集成,我们需要了解一下它们的核心算法原理和具体操作步骤。

3.1 Flink 核心算法原理

Flink 的核心算法原理包括数据流操作、状态管理、容错机制等。

- 数据流操作:Flink 支持多种数据流操作,如映射、过滤、聚合、连接等。这些操作可以用于对数据流进行转换和处理。

- 状态管理:Flink 支持状态管理,用于存储和管理数据流中的状态。状态可以用于实现窗口操作、时间操作等。

- 容错机制:Flink 支持容错机制,用于处理数据流中的故障和异常。容错机制包括检查点、恢复和故障转移等。

3.2 Hadoop 核心算法原理

Hadoop 的核心算法原理包括 HDFS 的数据存储和管理、MapReduce 的计算模型等。

- HDFS 数据存储和管理:HDFS 支持数据的持久化和并行访问。HDFS 使用数据块和数据节点来存储和管理数据。

- MapReduce 计算模型:MapReduce 是 Hadoop 的核心计算模型,它是一个分布式并行计算框架,用于处理大量数据。MapReduce 分为两个阶段:Map 阶段和 Reduce 阶段。Map 阶段用于对数据进行分组和处理,Reduce 阶段用于对分组后的数据进行汇总和聚合。

3.3 Flink 与 Hadoop 的集成算法原理

为了将 Flink 与 Hadoop 集成,我们需要了解一下它们的集成算法原理。

- Flink 作为 Hadoop 的数据源:我们可以将 Flink 中的数据流作为 Hadoop 的数据源,以实现实时数据处理和批处理分析。Flink 需要将数据流转换为一种可以被 Hadoop 理解的格式,如 HDFS 文件或者 Hadoop 输出格式。

- Flink 作为 Hadoop 的数据接收器:我们可以将 Hadoop 中的数据流作为 Flink 的数据接收器,以实现实时数据处理和批处理分析。Flink 需要将数据接收器转换为一种可以被 Flink 理解的格式,如 Flink 输入格式。

- Flink 与 Hadoop 的数据交换:我们可以将 Flink 中的数据流写入到 HDFS,以便在 Hadoop 中进行批处理分析。同时,我们也可以将 Hadoop 中的数据流读取到 Flink,以便在 Flink 中进行实时分析和报警。Flink 需要将数据流转换为一种可以被 Hadoop 理解的格式,如 HDFS 文件或者 Hadoop 输出格式。

4. 具体最佳实践:代码实例和详细解释说明

为了将 Flink 与 Hadoop 集成,我们需要了解一下它们的具体最佳实践:代码实例和详细解释说明。

4.1 Flink 作为 Hadoop 的数据源

我们可以将 Flink 中的数据流作为 Hadoop 的数据源,以实现实时数据处理和批处理分析。以下是一个 Flink 作为 Hadoop 数据源的代码实例:

```java import org.apache.flink.streaming.api.datastream.DataStream; import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment; import org.apache.flink.formats.hadoop.text.TextInputFormat; import org.apache.flink.hadoop.io.TextOutputFormat;

public class FlinkHadoopIntegration {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

DataStream<String> dataStream = env.addSource(new FlinkHadoopTextSource("hdfs://localhost:9000/input", new TextInputFormat()));

dataStream.map(new MapFunction<String, String>() {

@Override

public String map(String value) throws Exception {

// 实时数据处理和批处理分析

return value.toUpperCase();

}

}).addSink(new FlinkHadoopTextSink("hdfs://localhost:9000/output", new TextOutputFormat()));

env.execute("FlinkHadoopIntegration");

}} ```

在上述代码中,我们使用了 FlinkHadoopTextSource 和 FlinkHadoopTextSink 来实现 Flink 与 Hadoop 的集成。FlinkHadoopTextSource 用于将 Flink 中的数据流写入到 HDFS,FlinkHadoopTextSink 用于将 Hadoop 中的数据流读取到 Flink。

4.2 Flink 作为 Hadoop 的数据接收器

我们可以将 Hadoop 中的数据流作为 Flink 的数据接收器,以实现实时数据处理和批处理分析。以下是一个 Flink 作为 Hadoop 数据接收器的代码实例:

```java import org.apache.flink.streaming.api.datastream.DataStream; import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment; import org.apache.flink.formats.hadoop.text.TextInputFormat; import org.apache.flink.hadoop.io.TextOutputFormat;

public class FlinkHadoopIntegration {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

DataStream<String> dataStream = env.addSource(new FlinkHadoopTextSource("hdfs://localhost:9000/input", new TextInputFormat()));

dataStream.map(new MapFunction<String, String>() {

@Override

public String map(String value) throws Exception {

// 实时数据处理和批处理分析

return value.toLowerCase();

}

}).addSink(new FlinkHadoopTextSink("hdfs://localhost:9000/output", new TextOutputFormat()));

env.execute("FlinkHadoopIntegration");

}} ```

在上述代码中,我们使用了 FlinkHadoopTextSource 和 FlinkHadoopTextSink 来实现 Flink 与 Hadoop 的集成。FlinkHadoopTextSource 用于将 Hadoop 中的数据流读取到 Flink,FlinkHadoopTextSink 用于将 Flink 中的数据流写入到 HDFS。

4.3 Flink 与 Hadoop 的数据交换

我们可以将 Flink 中的数据流写入到 HDFS,以便在 Hadoop 中进行批处理分析。同时,我们也可以将 Hadoop 中的数据流读取到 Flink,以便在 Flink 中进行实时分析和报警。以下是一个 Flink 与 Hadoop 的数据交换的代码实例:

```java import org.apache.flink.streaming.api.datastream.DataStream; import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment; import org.apache.flink.formats.hadoop.text.TextInputFormat; import org.apache.flink.hadoop.io.TextOutputFormat;

public class FlinkHadoopIntegration {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

DataStream<String> dataStream = env.addSource(new FlinkHadoopTextSource("hdfs://localhost:9000/input", new TextInputFormat()));

dataStream.map(new MapFunction<String, String>() {

@Override

public String map(String value) throws Exception {

// 实时数据处理和批处理分析

return value.concat("_flink");

}

}).addSink(new FlinkHadoopTextSink("hdfs://localhost:9000/output", new TextOutputFormat()));

env.execute("FlinkHadoopIntegration");

}} ```

在上述代码中,我们使用了 FlinkHadoopTextSource 和 FlinkHadoopTextSink 来实现 Flink 与 Hadoop 的集成。FlinkHadoopTextSource 用于将 Flink 中的数据流写入到 HDFS,FlinkHadoopTextSink 用于将 Hadoop 中的数据流读取到 Flink。

5. 实际应用场景

Flink 与 Hadoop 的集成可以应用于以下场景:

- 实时数据处理和批处理分析:我们可以将 Flink 中的数据流作为 Hadoop 的数据源,以实现实时数据处理和批处理分析。同时,我们也可以将 Hadoop 中的数据流作为 Flink 的数据接收器,以实现实时数据处理和批处理分析。

- 数据交换和同步:我们可以将 Flink 中的数据流写入到 HDFS,以便在 Hadoop 中进行批处理分析。同时,我们也可以将 Hadoop 中的数据流读取到 Flink,以便在 Flink 中进行实时分析和报警。

- 实时数据处理和实时报警:我们可以将 Flink 中的数据流写入到 HDFS,以便在 Hadoop 中进行批处理分析。同时,我们也可以将 Hadoop 中的数据流读取到 Flink,以便在 Flink 中进行实时分析和报警。

6. 工具和资源推荐

为了将 Flink 与 Hadoop 集成,我们需要了解一下它们的工具和资源推荐。

7. 总结

本文介绍了如何将 Apache Flink 与 Apache Hadoop 集成,以实现实时数据处理和批处理分析。我们首先了解了 Flink 与 Hadoop 的核心概念和联系,然后了解了它们的核心算法原理和具体操作步骤。接着,我们通过代码实例和详细解释说明,了解了 Flink 与 Hadoop 的具体最佳实践。最后,我们介绍了 Flink 与 Hadoop 的实际应用场景、工具和资源推荐。

8. 附录:常见问题与答案

Q1:Flink 与 Hadoop 集成的优缺点是什么?

优点:

- 实时性能:Flink 是一个高性能的流处理框架,它可以实现低延迟的实时数据处理。

- 可扩展性:Flink 支持数据流的可扩展性,它可以处理大量的数据流,并在需要时自动扩展。

- 易用性:Flink 与 Hadoop 的集成,使得我们可以在一个框架中实现实时数据处理和批处理分析,提高开发效率。

缺点:

- 复杂性:Flink 与 Hadoop 的集成,可能会增加系统的复杂性,需要了解两个框架的API和最佳实践。

- 性能开销:Flink 与 Hadoop 的集成,可能会增加性能开销,因为数据需要在两个框架之间进行转换和交换。

Q2:Flink 与 Hadoop 集成的使用场景是什么?

Flink 与 Hadoop 集成的使用场景包括:

- 实时数据处理和批处理分析:我们可以将 Flink 中的数据流作为 Hadoop 的数据源,以实现实时数据处理和批处理分析。同时,我们也可以将 Hadoop 中的数据流作为 Flink 的数据接收器,以实现实时数据处理和批处理分析。

- 数据交换和同步:我们可以将 Flink 中的数据流写入到 HDFS,以便在 Hadoop 中进行批处理分析。同时,我们也可以将 Hadoop 中的数据流读取到 Flink,以便在 Flink 中进行实时分析和报警。

- 实时数据处理和实时报警:我们可以将 Flink 中的数据流写入到 HDFS,以便在 Hadoop 中进行批处理分析。同时,我们也可以将 Hadoop 中的数据流读取到 Flink,以便在 Flink 中进行实时分析和报警。

Q3:Flink 与 Hadoop 集成的最佳实践是什么?

Flink 与 Hadoop 集成的最佳实践包括:

- 使用 FlinkHadoopConnector:FlinkHadoopConnector 是一个开源的 Flink 与 Hadoop 集成库,它提供了 Flink 与 Hadoop 的集成接口和示例代码。我们可以使用 FlinkHadoopConnector 来实现 Flink 与 Hadoop 的集成。

- 使用 FlinkHadoopTextSource:FlinkHadoopTextSource 是一个 Flink 与 Hadoop 集成库,它提供了 Flink 与 Hadoop 的集成接口和示例代码。我们可以使用 FlinkHadoopTextSource 来实现 Flink 与 Hadoop 的集成。

- 使用 FlinkHadoopTextSink:FlinkHadoopTextSink 是一个 Flink 与 Hadoop 集成库,它提供了 Flink 与 Hadoop 的集成接口和示例代码。我们可以使用 FlinkHadoopTextSink 来实现 Flink 与 Hadoop 的集成。

- 使用 Flink 与 Hadoop 的官方文档和资源:我们可以使用 Flink 与 Hadoop 的官方文档和资源来了解 Flink 与 Hadoop 的集成原理和最佳实践。这些资源包括 Flink 官方文档、Hadoop 官方文档、FlinkHadoopConnector、FlinkHadoopTextSource 和 FlinkHadoopTextSink。

Q4:Flink 与 Hadoop 集成的未来趋势是什么?

Flink 与 Hadoop 集成的未来趋势包括:

- 更高性能:随着 Flink 与 Hadoop 的技术发展,我们可以期待到未来的性能提升,以满足更大规模和更高速度的实时数据处理和批处理分析需求。

- 更简单的集成:随着 Flink 与 Hadoop 的发展,我们可以期待到未来的集成更加简单,以便更多的开发者可以轻松地使用 Flink 与 Hadoop 进行实时数据处理和批处理分析。

- 更广泛的应用:随着 Flink 与 Hadoop 的发展,我们可以期待到未来的应用场景更加广泛,以满足不同行业和不同需求的实时数据处理和批处理分析需求。

Q5:Flink 与 Hadoop 集成的挑战是什么?

Flink 与 Hadoop 集成的挑战包括:

- 技术兼容性:Flink 与 Hadoop 的技术兼容性可能会导致一些问题,例如数据类型转换、序列化和反序列化等。我们需要了解这些技术兼容性问题,并找到合适的解决方案。

- 性能开销:Flink 与 Hadoop 的集成,可能会增加性能开销,因为数据需要在两个框架之间进行转换和交换。我们需要关注这些性能开销,并找到合适的优化方案。

- 开发难度:Flink 与 Hadoop 的集成,可能会增加开发难度,因为我们需要了解两个框架的API和最佳实践。我们需要关注这些开发难度,并提供合适的开发指南和示例代码。

Q6:Flink 与 Hadoop 集成的最佳实践是什么?

Flink 与 Hadoop 集成的最佳实践包括:

- 使用 FlinkHadoopConnector:FlinkHadoopConnector 是一个开源的 Flink 与 Hadoop 集成库,它提供了 Flink 与 Hadoop 的集成接口和示例代码。我们可以使用 FlinkHadoopConnector 来实现 Flink 与 Hadoop 的集成。

- 使用 FlinkHadoopTextSource:FlinkHadoopTextSource 是一个 Flink 与 Hadoop 集成库,它提供了 Flink 与 Hadoop 的集成接口和示例代码。我们可以使用 FlinkHadoopTextSource 来实现 Flink 与 Hadoop 的集成。

- 使用 FlinkHadoopTextSink:FlinkHadoopTextSink 是一个 Flink 与 Hadoop 集成库,它提供了 Flink 与 Hadoop 的集成接口和示例代码。我们可以使用 FlinkHadoopTextSink 来实现 Flink 与 Hadoop 的集成。

- 使用 Flink 与 Hadoop 的官方文档和资源:我们可以使用 Flink 与 Hadoop 的官方文档和资源来了解 Flink 与 Hadoop 的集成原理和最佳实践。这些资源包括 Flink 官方文档、Hadoop 官方文档、FlinkHadoopConnector、FlinkHadoopTextSource 和 FlinkHadoopTextSink。

Q7:Flink 与 Hadoop 集成的实际应用场景是什么?

Flink 与 Hadoop 集成的实际应用场景包括:

- 实时数据处理和批处理分析:我们可以将 Flink 中的数据流作为 Hadoop 的数据源,以实现实时数据处理和批处理分析。同时,我们也可以将 Hadoop 中的数据流作为 Flink 的数据接收器,以实现实时数据处理和批处理分析。

- 数据交换和同步:我们可以将 Flink 中的数据流写入到 HDFS,以便在 Hadoop 中进行批处理分析。同时,我们也可以将 Hadoop 中的数据流读取到 Flink,以便在 Flink 中进行实时分析和报警。

- 实时数据处理和实时报警:我们可以将 Flink 中的数据流写入到 HDFS,以便在 Hadoop 中进行批处理分析。同时,我们也可以将 Hadoop 中的数据流读取到 Flink,以便在 Flink 中进行实时分析和报警。

Q8:Flink 与 Hadoop 集成的性能开销是什么?

Flink 与 Hadoop 集成的性能开销可能会增加,因为数据需要在两个框架之间进行转换和交换。我们需要关注这些性能开销,并找到合适的优化方案。

Q9:Flink 与 Hadoop 集成的开发难度是什么?

Flink 与 Hadoop 的集成,可能会增加开发难度,因为我们需要了解两个框架的API和最佳实践。我们需要关注这些开发难度,并提供合适的开发指南和示例代码。

Q10:Flink 与 Hadoop 集成的可扩展性是什么?文章来源:https://www.toymoban.com/news/detail-825719.html

Flink 支持数据流的可扩展性,它可以处理大量的数据流,并在需要时自动扩展。这也意味着 Flink 与 Hadoop 的集成,可以处理大量的数据流,并在需文章来源地址https://www.toymoban.com/news/detail-825719.html

到了这里,关于实时Flink数据流与ApacheHadoop集成的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!