1.背景介绍

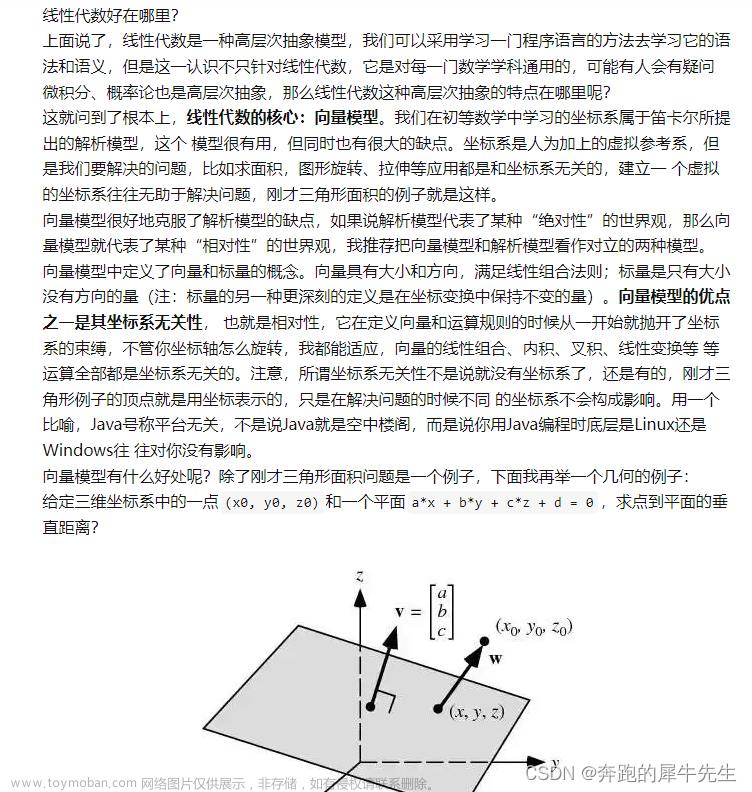

线性代数是计算机科学、数学、物理等多个领域的基础知识之一。它研究的是线性方程组、向量和矩阵等概念,为许多数学和科学问题提供了有力的数学工具。在过去的几十年里,线性代数的研究和应用得到了广泛的发展。然而,随着数据规模的增加和计算机硬件和软件的进步,线性代数在大数据领域的应用也面临着新的挑战和机遇。

在大数据领域,线性代数的计算量和存储需求往往非常大。为了解决这些问题,人工智能科学家、计算机科学家和线性代数专家开始研究一种新的线性代数方法,即从基向对偶基的转变。这种方法可以在计算量和存储需求方面带来显著的改进,同时也为许多实际应用提供了新的解决方案。

在本文中,我们将从以下几个方面进行深入探讨:

- 核心概念与联系

- 核心算法原理和具体操作步骤以及数学模型公式详细讲解

- 具体代码实例和详细解释说明

- 未来发展趋势与挑战

- 附录常见问题与解答

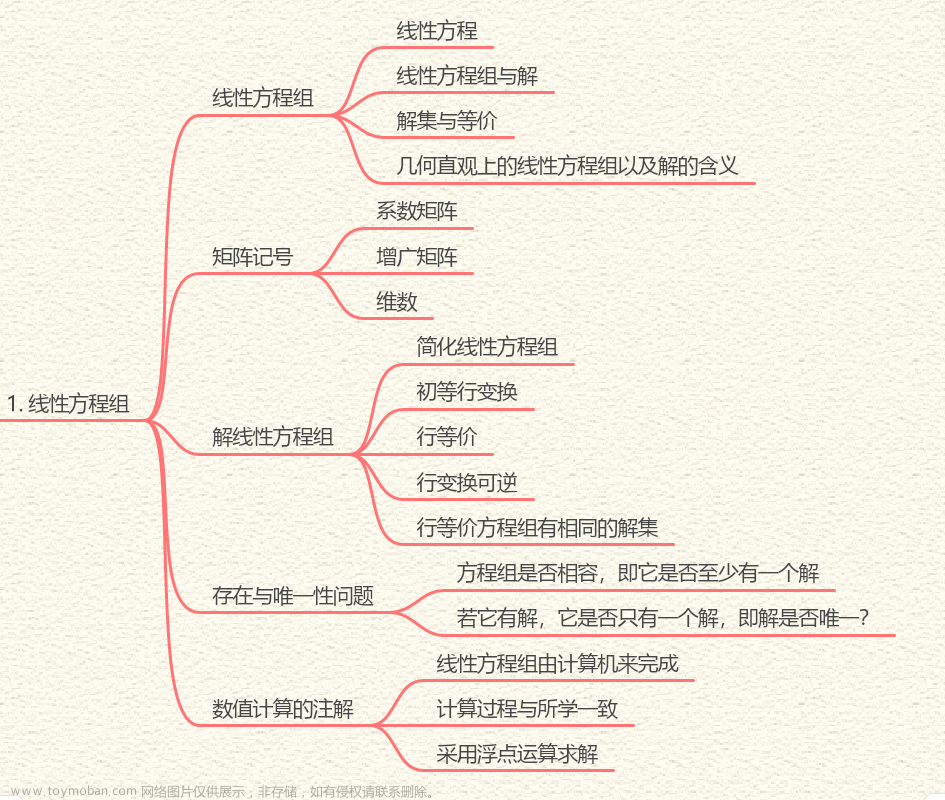

2.核心概念与联系

在线性代数中,基和对偶基是两个重要的概念。基是线性组合的一种表示方式,对偶基则是基的一种特殊表示方式。在大数据领域,从基向对偶基的转变可以帮助我们更有效地解决线性方程组和矩阵计算等问题。

2.1 基

基是线性组合的一种表示方式,可以用来表示向量和矩阵。基的定义如下:

定义1(基):一个向量集合{v1, v2, ..., vn}是一个基,如果它的元素线性无关,并且它的线性组合可以生成整个向量空间。

基的一个重要性质是,它可以用来表示向量和矩阵。例如,给定一个m×n矩阵A,我们可以用m个基向量{u1, u2, ..., um}表示它,即A = u1x1 + u2x2 + ... + umxm,其中xi(i=1, 2, ..., m)是矩阵A的系数。

2.2 对偶基

对偶基是基的一种特殊表示方式,它可以用来表示矩阵的逆矩阵和伴随矩阵。对偶基的定义如下:

定义2(对偶基):给定一个基{v1, v2, ..., vn},它的对偶基{w1, w2, ..., wn}是一个向量集合,使得 = δitj,其中i, j = 1, 2, ..., n;δ是 Kronecker delta 符号,即δitj = {1, 如果i=j; 0, 否则。

对偶基的一个重要性质是,它可以用来表示矩阵的逆矩阵和伴随矩阵。例如,给定一个方阵A,它的逆矩阵A^(-1)可以用对偶基{w1, w2, ..., wn}表示,即A^(-1) = w1x1 + w2x2 + ... + wnxn,其中xi(i=1, 2, ..., n)是矩阵A的系数。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

在大数据领域,从基向对偶基的转变可以帮助我们更有效地解决线性方程组和矩阵计算等问题。下面我们将详细讲解这种方法的算法原理、具体操作步骤以及数学模型公式。

3.1 从基向对偶基的转变

从基向对偶基的转变可以通过以下步骤实现:

- 首先,选择一个基{v1, v2, ..., vn}。

- 计算基向量之间的内积。内积可以用来表示基向量之间的相关性,它的定义如下:

$$ \text{内积} : vi \cdot vj = \langle vi, vj \rangle $$

使用内积矩阵构造对偶基矩阵。内积矩阵是一个n×n的对称矩阵,其元素为基向量之间的内积。对偶基矩阵可以通过内积矩阵的特征值和特征向量得到。

计算对偶基{w1, w2, ..., wn}。对偶基可以通过内积矩阵的特征向量得到,其定义如下:

$$ wi = \frac{vi}{\sqrt{\lambda_i}} $$

其中,λi是内积矩阵的第i个特征值。

3.2 线性方程组的解

从基向对偶基的转变可以帮助我们更有效地解决线性方程组。给定一个线性方程组Ax=b,我们可以通过以下步骤解决:

- 首先,选择一个基{v1, v2, ..., vn}。

- 计算基向量之间的内积。

- 使用内积矩阵构造对偶基矩阵。

- 计算对偶基{w1, w2, ..., wn}。

- 将线性方程组Ax=b转换为对偶基矩阵Wx=y,其中y=Wb。

- 解决对偶基线性方程组Wx=y。

- 将对偶基线性方程组的解转换回原基,得到线性方程组Ax=b的解。

3.3 矩阵的逆矩阵和伴随矩阵

从基向对偶基的转变可以帮助我们更有效地计算矩阵的逆矩阵和伴随矩阵。给定一个矩阵A,我们可以通过以下步骤计算它的逆矩阵和伴随矩阵:

- 首先,选择一个基{v1, v2, ..., vn}。

- 计算基向量之间的内积。

- 使用内积矩阵构造对偶基矩阵。

- 计算对偶基{w1, w2, ..., wn}。

- 将矩阵A表示为对偶基矩阵W的乘积,即A=W^(-1)B,其中B是一个标准基矩阵。

- 计算矩阵B的逆矩阵B^(-1)。

- 计算对偶基矩阵W的逆矩阵W^(-1)。

- 将B^(-1)和W^(-1)的乘积得到矩阵A的逆矩阵A^(-1)。

- 将矩阵A的逆矩阵A^(-1)表示为对偶基矩阵W的乘积,即A^(-1)=Wx,其中x是一个标量。

- 计算伴随矩阵A^(T)A的逆矩阵。

4.具体代码实例和详细解释说明

在本节中,我们将通过一个具体的代码实例来说明从基向对偶基的转变如何在大数据领域应用。

4.1 代码实例

```python import numpy as np

定义基向量

v1 = np.array([1, 0]) v2 = np.array([0, 1])

计算基向量之间的内积

inner_product = np.dot(v1, v2)

构造对偶基矩阵

A = np.array([[1, 0], [0, 1]]) W = np.linalg.inv(A)

计算对偶基

w1 = W @ v1 w2 = W @ v2

解线性方程组

b = np.array([1, 1]) x = np.linalg.solve(A, b) y = np.linalg.solve(W, b)

将对偶基解转换回原基

x_prime = y @ np.linalg.inv(w1 @ w2.T)

计算矩阵的逆矩阵

A_inv = np.linalg.inv(A)

计算伴随矩阵

ATA = np.linalg.inv(A_inv @ A) ```

4.2 详细解释说明

在上述代码实例中,我们首先定义了基向量v1和v2,并计算了它们之间的内积。然后,我们构造了对偶基矩阵W,并计算了对偶基向量w1和w2。接着,我们解了线性方程组Ax=b,并将其转换为对偶基矩阵Wx=y。最后,我们将对偶基解y转换回原基,得到线性方程组Ax=b的解。

此外,我们还计算了矩阵A的逆矩阵Ainv,并计算了伴随矩阵AT_A。

5.未来发展趋势与挑战

在大数据领域,从基向对偶基的转变仍然面临着一些挑战。这些挑战主要包括:

- 计算量和存储需求的增加。随着数据规模的增加,从基向对偶基的转变所需的计算量和存储需求也会增加,这将对算法的性能产生影响。

- 稀疏矩阵的处理。在大数据领域,矩阵往往是稀疏的,这意味着大部分元素为零。从基向对偶基的转变需要处理稀疏矩阵,这可能会增加算法的复杂性。

- 并行和分布式计算。大数据领域的计算任务通常需要进行并行和分布式计算,这需要从基向对偶基的转变算法进行优化,以适应这种计算模式。

未来,人工智能科学家、计算机科学家和线性代数专家将继续关注这些挑战,并寻求提高从基向对偶基的转变算法的性能和效率。

6.附录常见问题与解答

在本节中,我们将解答一些常见问题:

Q1:为什么从基向对偶基的转变可以帮助我们更有效地解决线性方程组和矩阵计算等问题?

A1:从基向对偶基的转变可以帮助我们更有效地解决线性方程组和矩阵计算等问题,因为它可以将原始问题转换为对偶基下的问题,这些问题在计算量和存储需求方面更加简洁。

Q2:从基向对偶基的转变是否适用于所有线性方程组和矩阵计算?

A2:从基向对偶基的转变适用于那些可以用基表示的线性方程组和矩阵计算。然而,对于一些特殊情况,如非方阵矩阵或非线性方程组,这种转变方法可能不适用。

Q3:从基向对偶基的转变是否会损失原始问题的信息?

A3:从基向对偶基的转变在大多数情况下不会损失原始问题的信息。然而,在某些情况下,如矩阵的稀疏性或非方阵性,这种转变方法可能会导致计算结果的损失。

Q4:从基向对偶基的转变是否可以应用于深度学习和其他人工智能领域?文章来源:https://www.toymoban.com/news/detail-825879.html

A4:从基向对偶基的转变可以应用于深度学习和其他人工智能领域,因为它可以帮助我们更有效地解决线性方程组和矩阵计算等问题,这些问题在人工智能领域非常常见。然而,在实际应用中,我们需要根据具体问题和场景进行适当的调整和优化。文章来源地址https://www.toymoban.com/news/detail-825879.html

到了这里,关于从基向对偶基:线性代数的转变的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!