1.背景介绍

批量梯度下降(Batch Gradient Descent)是一种常用的优化算法,广泛应用于机器学习和人工智能领域。它是一种迭代优化方法,通过不断地更新模型参数,逐渐将模型拟合到训练数据,从而最小化损失函数。在过去的几十年里,批量梯度下降已经成为机器学习中的基石,为许多现代算法奠定了基础。

在本文中,我们将深入探讨批量梯度下降的核心概念、算法原理、具体操作步骤以及数学模型。此外,我们还将通过实际代码示例来解释批量梯度下降的工作原理,并探讨其在人工智能领域的未来发展趋势和挑战。

2.核心概念与联系

2.1 优化问题与损失函数

在人工智能中,我们经常需要解决优化问题。优化问题通常可以表示为找到一个参数向量 $\theta$,使得某个函数 $J(\theta)$ 达到最小值。这个函数 $J(\theta)$ 被称为损失函数(Loss Function)或目标函数(Objective Function)。

损失函数的具体形式取决于具体的问题和任务。例如,在线性回归中,损失函数通常是均方误差(Mean Squared Error, MSE);在逻辑回归中,损失函数可以是交叉熵损失(Cross-Entropy Loss);在深度学习中,损失函数可能是交叉熵损失、均方误差等多种形式。

2.2 梯度下降法

梯度下降法(Gradient Descent)是一种优化算法,它通过沿着梯度最steep(最陡)的方向来迭代地更新参数向量,从而逐渐将损失函数最小化。梯度下降法的核心思想是:如果在当前参数值处,梯度是负的,那么沿着梯度方向走一步会降低损失函数的值。

2.3 批量梯度下降

批量梯度下降(Batch Gradient Descent)是一种改进的梯度下降法。在标准的梯度下降法中,参数更新是基于单个样本的梯度。而批量梯度下降则是基于所有样本的梯度进行参数更新。这种方法通常在计算效率和收敛速度方面具有优势,尤其是在处理大规模数据集时。

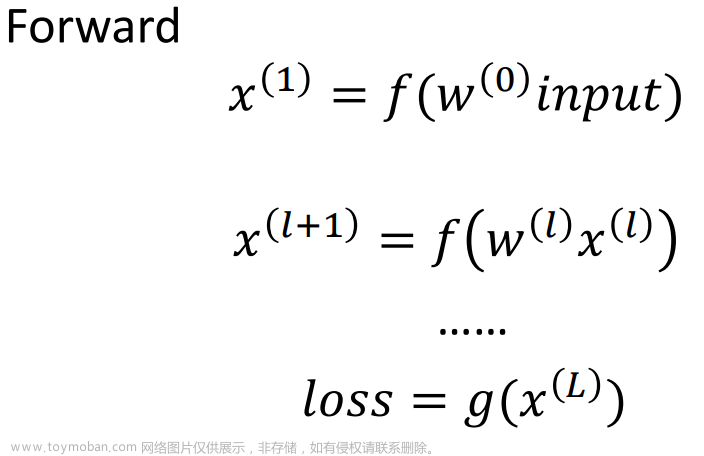

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 算法原理

批量梯度下降的核心思想是通过不断地更新模型参数 $\theta$,使得损失函数 $J(\theta)$ 达到最小。这个过程可以分为以下几个步骤:

- 随机初始化模型参数 $\theta$。

- 计算损失函数 $J(\theta)$。

- 计算梯度 $\nabla J(\theta)$。

- 更新参数 $\theta$。

- 重复步骤 2-4,直到收敛或达到最大迭代次数。

3.2 具体操作步骤

以线性回归为例,我们来详细看一下批量梯度下降的具体操作步骤。

- 随机初始化模型参数 $\theta0 = \begin{pmatrix} \theta{00} \ \theta_{01} \end{pmatrix}$。

- 对于每个训练样本 $\begin{pmatrix} xi \ yi \end{pmatrix}$,计算预测值 $\hat{y}i = xi^T \theta$。

- 计算损失函数 $J(\theta) = \frac{1}{2m} \sum{i=1}^m (yi - \hat{y}_i)^2$,其中 $m$ 是训练样本数。

- 计算梯度 $\nabla J(\theta) = \frac{1}{m} \sum{i=1}^m (yi - \hat{y}i) xi$。

- 更新参数 $\theta{t+1} = \thetat - \alpha \nabla J(\theta_t)$,其中 $\alpha$ 是学习率。

- 重复步骤 2-5,直到收敛或达到最大迭代次数。

3.3 数学模型公式

在线性回归中,损失函数 $J(\theta)$ 和梯度 $\nabla J(\theta)$ 的公式如下:

$$ J(\theta) = \frac{1}{2m} \sum{i=1}^m (yi - (x_i^T \theta))^2 $$

$$ \nabla J(\theta) = \frac{1}{m} \sum{i=1}^m (yi - (xi^T \theta)) xi $$

其中 $m$ 是训练样本数,$\theta$ 是模型参数向量,$xi$ 是第 $i$ 个训练样本的特征向量,$yi$ 是第 $i$ 个训练样本的标签。

4.具体代码实例和详细解释说明

4.1 线性回归示例

我们来看一个简单的线性回归示例,通过批量梯度下降算法来拟合数据。

```python import numpy as np

随机生成数据

np.random.seed(42) X = 2 * np.random.rand(100, 1) y = 4 + 3 * X + np.random.randn(100, 1)

初始化参数

theta = np.random.randn(2, 1)

学习率

alpha = 0.01

最大迭代次数

iterations = 1000

批量梯度下降

for i in range(iterations): # 预测值 predictions = X @ theta

# 损失函数

loss = (1 / 2 * m) * np.sum((y - predictions) ** 2)

# 梯度

gradient = (1 / m) * np.sum((y - predictions) * X, axis=0)

# 更新参数

theta = theta - alpha * gradient

# 输出迭代次数和损失值

if i % 100 == 0:

print(f"Iteration {i}, Loss: {loss}")```

在这个示例中,我们首先生成了一组随机的线性回归数据,并初始化了模型参数 $\theta$。然后我们使用批量梯度下降算法进行参数更新,直到达到最大迭代次数。在每一次迭代中,我们计算预测值、损失函数和梯度,并根据梯度更新参数。

4.2 逻辑回归示例

接下来,我们来看一个逻辑回归示例,通过批量梯度下降算法来进行二分类任务。

```python import numpy as np

随机生成数据

np.random.seed(42) X = 2 * np.random.rand(100, 2) y = np.where(X[:, 0] + X[:, 1] > 1, 1, 0)

初始化参数

theta = np.random.randn(2, 1)

学习率

alpha = 0.01

最大迭代次数

iterations = 1000

逻辑回归

for i in range(iterations): # 预测值 predictions = X @ theta

# 损失函数

loss = -np.sum(y * np.log(1 + np.exp(-(y * predictions))) + (1 - y) * np.log(1 + np.exp((1 - y) * predictions)))

# 梯度

gradient = -np.sum((y - (1 + np.exp(-(y * predictions))) ** -1) * X, axis=0)

# 更新参数

theta = theta - alpha * gradient

# 输出迭代次数和损失值

if i % 100 == 0:

print(f"Iteration {i}, Loss: {loss}")```

在这个示例中,我们首先生成了一组随机的逻辑回归数据,并初始化了模型参数 $\theta$。然后我们使用批量梯度下降算法进行参数更新,直到达到最大迭代次数。在每一次迭代中,我们计算预测值、损失函数和梯度,并根据梯度更新参数。

5.未来发展趋势与挑战

5.1 深度学习与批量梯度下降

随着深度学习技术的发展,批量梯度下降在许多现代算法中发挥着重要作用。例如,在卷积神经网络(Convolutional Neural Networks, CNNs)和递归神经网络(Recurrent Neural Networks, RNNs)中,批量梯度下降被广泛应用于优化模型参数。

5.2 分布式和并行计算

随着数据规模的增加,批量梯度下降在计算能力方面面临着挑战。为了解决这个问题,研究者们在分布式和并行计算领域进行了深入探讨,以提高批量梯度下降的计算效率。

5.3 自适应学习率和动态调整

在实际应用中,学习率是一个关键的超参数。为了使批量梯度下降更加高效,研究者们尝试了不同的自适应学习率策略,如AdaGrad、RMSprop和Adam等,以动态调整学习率。

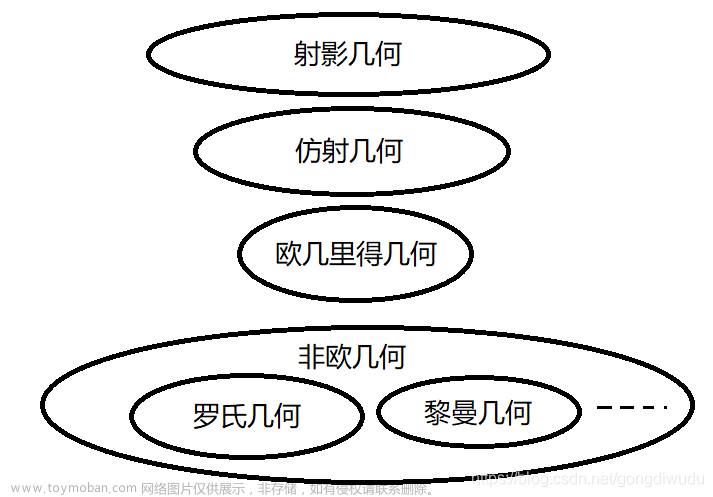

5.4 二阶优化算法

批量梯度下降是一种一阶优化算法,它仅依赖于梯度信息。然而,在某些情况下,使用二阶优化算法可能会更有效。这些算法利用Hessian矩阵(二阶导数)来指导参数更新,例如牛顿法(Newton's Method)和梯度下降的变种(e.g., L-BFGS)。

6.附录常见问题与解答

Q1. 批量梯度下降与梯度下降的区别?

A1. 批量梯度下降(Batch Gradient Descent)使用所有训练样本的梯度来更新参数,而梯度下降(Gradient Descent)使用单个样本的梯度。批量梯度下降通常在计算效率和收敛速度方面具有优势。

Q2. 批量梯度下降如何处理大规模数据集?

A2. 批量梯度下降可以通过分批处理大规模数据集,将整个数据集划分为多个小批次,然后逐批地更新参数。这种方法称为小批量梯度下降(Stochastic Gradient Descent, SGD)。

Q3. 批量梯度下降如何处理非凸损失函数?

A3. 批量梯度下降可以应用于非凸损失函数,但是在这种情况下,收敛性可能会变得更加复杂。在非凸优化问题中,多个局部最小值可能存在,批量梯度下降可能会收敛到一个不理想的局部最小值。文章来源:https://www.toymoban.com/news/detail-825986.html

Q4. 批量梯度下降如何处理高维数据?

A4. 批量梯度下降可以直接应用于高维数据,但是在高维空间中,梯度可能会变得非常复杂,这可能会导致收敛速度减慢。在这种情况下,可以尝试使用自适应学习率策略或其他优化算法来提高收敛速度。文章来源地址https://www.toymoban.com/news/detail-825986.html

到了这里,关于批量梯度下降在人工智能的大局的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!