1.背景介绍

凸性优化是一种广泛应用于计算机科学、数学、经济学等领域的优化方法。它主要解决的问题是在一个凸函数空间中找到一个局部最小值或全局最小值。凸性优化的一个关键步骤是通过计算函数的二阶导数来确定函数在某一点的凸性或凹性。这里的二阶导数通常表示为 Hessian 矩阵。Hessian 矩阵在凸性优化中具有重要的作用,因为它可以帮助我们判断一个点是否为全局最小值、局部最小值或者鞍点。在本文中,我们将深入探讨 Hessian 矩阵在凸性优化中的重要作用,以及如何利用 Hessian 矩阵来解决凸性优化问题。

2.核心概念与联系

2.1 Hessian 矩阵

Hessian 矩阵是一种二阶导数矩阵,用于描述一个函数在某一点的曲率。对于一个二元函数 f(x, y),其 Hessian 矩阵 H 定义为:

$$ H = \begin{bmatrix} \frac{\partial^2 f}{\partial x^2} & \frac{\partial^2 f}{\partial x \partial y} \ \frac{\partial^2 f}{\partial y \partial x} & \frac{\partial^2 f}{\partial y^2} \end{bmatrix} $$

Hessian 矩阵可以用来判断函数在某一点的凸性或凹性。如果 Hessian 矩阵的所有元素都大于零,则函数在该点凸;如果所有元素都小于零,则函数在该点凹;如果矩阵中存在正负元素,则函数在该点可能是鞍点。

2.2 凸性优化

凸性优化是一种寻找函数最小值或最大值的方法,其中函数和约束条件都是凸的。凸函数在其域内具有唯一的极大值和极小值,且它们都位于凸函数的锐角。凸性优化的一个重要应用是求解线性规划、非线性规划等问题。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 新凯撒算法

新凯撒算法是一种用于解决凸性优化问题的迭代算法。其核心思想是通过在每一轮迭代中更新变量的估计值,以逼近问题的最优解。新凯撒算法的具体步骤如下:

- 初始化:选择一个初始点 x0,设当前迭代次数 k = 0。

- 更新步长:计算步长 αk,使得在当前点 xk 处的函数值减小一定程度。

- 更新变量:根据步长 αk 更新变量 xk+1。

- 判断终止条件:如果满足终止条件(例如迭代次数达到最大值、函数值减小到满足要求等),则停止迭代;否则,将 k 加1,返回步骤2。

在新凯撒算法中,Hessian 矩阵用于计算步长 αk。具体来说,我们可以使用线性回归方法估计 Hessian 矩阵:

$$ Hk = \frac{\sum{i=1}^n (xi - xk) (xi - xk)^T f(xi)}{\sum{i=1}^n (xi - xk) (xi - xk)^T} $$

其中,n 是数据点数,xi 是数据点,f(xi) 是对应的函数值。

3.2 牛顿法

牛顿法是一种用于解决凸性优化问题的二阶方法。它的核心思想是在当前点 xk 处使用 Hessian 矩阵对函数进行二阶泰勒展开,然后求解得到的方程来获得下一个点 xk+1。牛顿法的具体步骤如下:

- 初始化:选择一个初始点 x0,设当前迭代次数 k = 0。

- 计算二阶泰勒展开:

$$ f(x{k+1}) \approx f(xk) + (x{k+1} - xk)^T \nabla f(xk) + \frac{1}{2} (x{k+1} - xk)^T Hk (x{k+1} - xk) $$

- 求解方程:解得 xk+1,使得 f(x_{k+1}) 最小。

- 判断终止条件:如果满足终止条件,则停止迭代;否则,将 k 加1,返回步骤2。

牛顿法在每一轮迭代中都需要求解方程,这可能是一个复杂的过程。但是,如果函数满足凸性条件,那么牛顿法可以在每一轮迭代中直接使用 Hessian 矩阵的逆来得到下一个点:

$$ x{k+1} = xk - Hk^{-1} \nabla f(xk) $$

4.具体代码实例和详细解释说明

在这里,我们将通过一个简单的二元凸函数来展示如何使用新凯撒算法和牛顿法解决凸性优化问题。考虑以下二元凸函数:

$$ f(x, y) = x^2 + y^2 $$

我们的目标是找到这个函数的全局最小值。首先,我们需要计算 Hessian 矩阵。对于这个函数,Hessian 矩阵为:

$$ H = \begin{bmatrix} 2 & 0 \ 0 & 2 \end{bmatrix} $$

接下来,我们使用新凯撒算法和牛顿法来解决这个问题。

4.1 新凯撒算法实例

```python import numpy as np

def f(x, y): return x2 + y2

def gradient_f(x, y): return np.array([2x, 2y])

def hessian_f(x, y): return np.array([[2, 0], [0, 2]])

x0 = np.array([0, 0]) alpha = 0.01 k = 0

while True: grad = gradientf(x0[0], x0[1]) H = hessianf(x0[0], x0[1]) alphak = -grad.T @ H**(-1) @ grad / (2 * H @ x0) x1 = x0 + alphak * grad k += 1 if np.linalg.norm(grad) < 1e-6: break x0 = x1 print(f"Iteration {k}: x = {x0}, f(x) = {f(x0[0], x0[1])}")

print(f"Optimal solution: x = {x0}, f(x) = {f(x0[0], x0[1])}") ```

4.2 牛顿法实例

```python import numpy as np

def f(x, y): return x2 + y2

def gradient_f(x, y): return np.array([2x, 2y])

def hessian_f(x, y): return np.array([[2, 0], [0, 2]])

x0 = np.array([0, 0]) k = 0

while True: grad = gradientf(x0[0], x0[1]) H = hessianf(x0[0], x0[1]) x1 = x0 - H**(-1) @ grad k += 1 if np.linalg.norm(grad) < 1e-6: break x0 = x1 print(f"Iteration {k}: x = {x0}, f(x) = {f(x0[0], x0[1])}")

print(f"Optimal solution: x = {x0}, f(x) = {f(x0[0], x0[1])}") ```

5.未来发展趋势与挑战

随着数据规模的不断增加,凸性优化在机器学习、深度学习等领域的应用也在不断扩展。未来,我们可以期待以下几个方面的发展:

- 更高效的优化算法:随着数据规模的增加,传统的优化算法可能无法满足实际需求。因此,研究更高效的优化算法变得越来越重要。

- 自适应优化算法:自适应优化算法可以根据问题的特点自动调整步长、迭代次数等参数,这将对于解决大规模凸性优化问题具有重要意义。

- 并行和分布式优化:大规模凸性优化问题需要大量的计算资源。因此,研究并行和分布式优化算法将成为一个热门的研究方向。

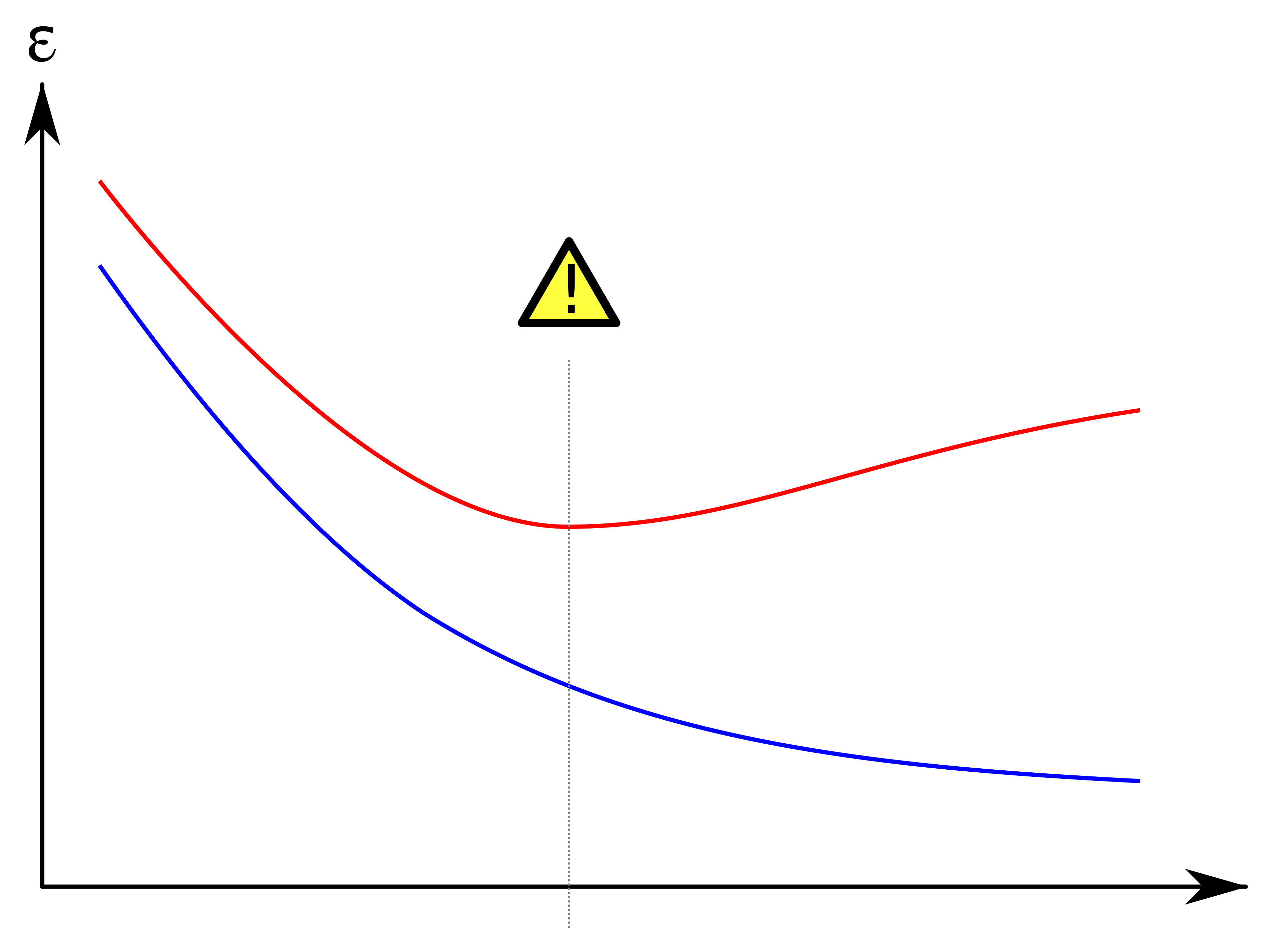

- 优化算法的稳定性和收敛性:在实际应用中,优化算法的稳定性和收敛性是非常重要的。因此,研究如何提高优化算法的稳定性和收敛性将是一个重要的方向。

6.附录常见问题与解答

Q1: 凸性优化和非凸性优化有什么区别?

A1: 凸性优化问题涉及到的函数和约束条件都是凸的,而非凸性优化问题涉及到的函数和约束条件可能不是凸的。凸性优化问题通常更容易解决,因为它们的全局最小值唯一。

Q2: 如何判断一个函数是否凸?

A2: 一个函数f(x)是凸的 if and only if 对于任意x, y在域内且0≤t≤1,有

$$ f(t x + (1-t) y) \leq t f(x) + (1-t) f(y) $$

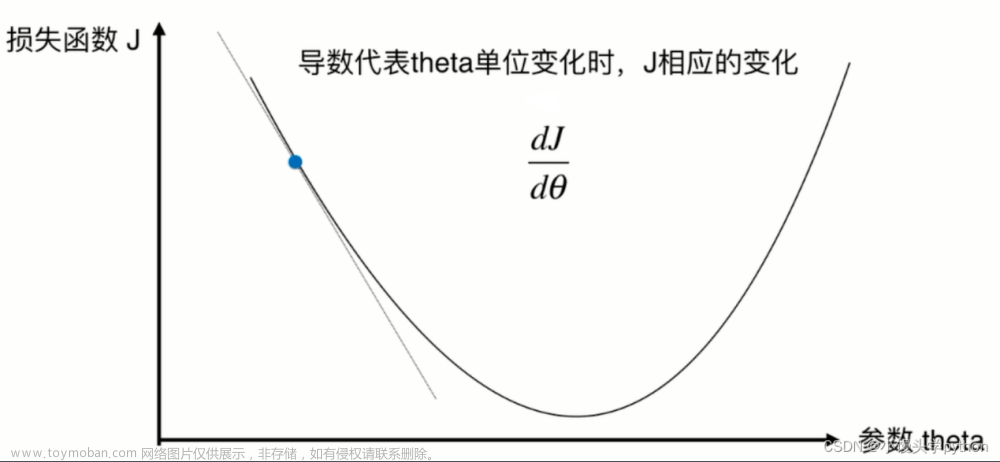

Q3: 牛顿法和梯度下降有什么区别?

A3: 梯度下降是一种首先以梯度下降的简单方法,而牛顿法是一种更高级的方法,使用了函数的二阶导数。牛顿法通常在每一轮迭代中需要解决方程,而梯度下降则只需要计算梯度。

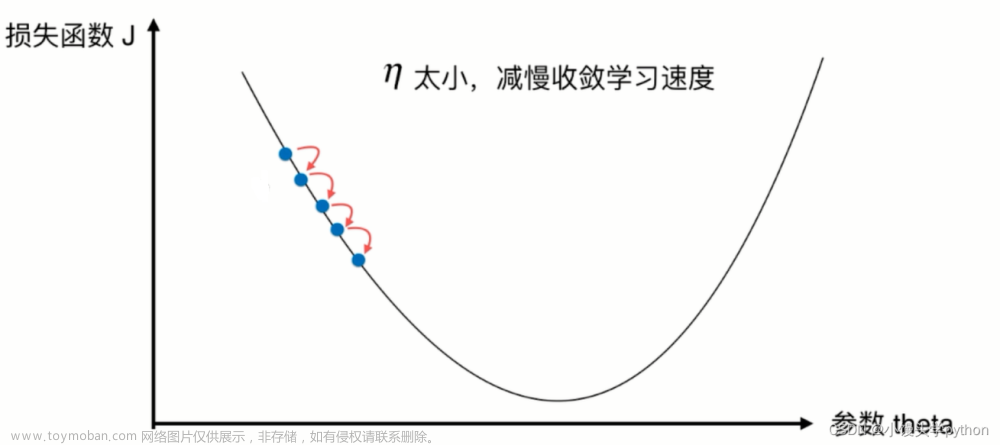

Q4: 如何选择步长α?文章来源:https://www.toymoban.com/news/detail-826376.html

A4: 步长α的选择取决于问题的具体情况。一种常见的方法是使用线搜索法,即在当前点xk处以不同步长α进行搜索,找到使目标函数值最小的步长。另一种方法是使用Armijo规则,即在每一轮迭代中更新步长α,使得目标函数值减小达到一个预设的阈值。文章来源地址https://www.toymoban.com/news/detail-826376.html

到了这里,关于深入探讨:Hessian 矩阵在凸性优化中的重要作用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!