可解释性AI(XAI)

可解释性AI(XAI)旨在提高人工智能系统的透明度和可理解性,使人们更好地理解AI的决策过程和原理。随着AI技术的广泛应用,XAI成为了一个备受关注的重要领域。它不仅有助于建立人们对AI的信任,还可以帮助解决AI伦理和偏见等问题。XAI的研究和应用涵盖了从算法改进、可视化技术到应用场景等多个方面,为解决复杂问题提供了新的思路和方法。

提醒:在发布作品前,请把不需要的内容删掉。

方向一:可解释性AI的定义与重要性

可解释性AI(XAI)是指那些能够提供关于其决策过程明确解释的人工智能系统。随着AI技术的普及,XAI的重要性日益凸显。由于人们往往对不透明的算法决策过程感到不安,XAI旨在提供一种方法,使AI的决策过程更易于理解,从而提高人们对AI的信任。

随着人工智能技术在金融、医疗、教育等领域的广泛应用,人们越来越关注AI决策的透明度和可解释性。对于企业而言,能够解释AI决策过程有助于建立用户信任,提升品牌形象。对于监管机构而言,解释性AI能够帮助他们更好地监管AI应用,确保其合规性和公平性。此外,解释性AI还有助于增强人们对AI技术的理解,推动其进一步的普及和发展。

方向二:可解释性AI的挑战与难点

尽管XAI的目标明确,但在实际操作中存在许多挑战和难点。

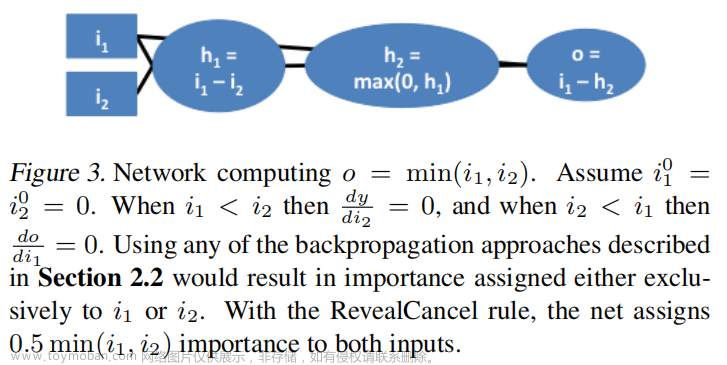

首先,许多先进的机器学习模型,如深度神经网络,具有很高的复杂性和非线性,这使得解释其决策过程变得极为困难。此外,一些模型在做出决策时并不会给出明确的原因或依据,这使得解释性AI的实现变得更加复杂。

其次,确定AI决策背后的真正原因是一个巨大的挑战。在复杂的系统中,因果关系往往难以确定,多个变量之间可能存在相互影响和依赖关系。这要求解释性AI不仅要揭示出直接影响决策的因素,还需要考虑各种潜在的间接因素和背景信息。

此外,数据偏差也可能影响AI的决策和解释性。如果训练数据存在偏差或偏见,那么即使是最透明的模型也可能产生不公正的结果。因此,在实现解释性AI的过程中,需要充分考虑数据的质量和多样性,并采取适当的措施来减少潜在的偏见和歧视。

方向三:可解释性AI的应用场景

解释性AI在许多场景中都显示出其价值:

金融领域:在信贷评估、股票交易等金融场景中,解释性AI能够帮助用户理解模型是基于哪些因素做出推荐或决策的。通过提供明确的解释,可以增加用户对AI系统的信任度,并减少误导和误解的风险。

医疗领域:在诊断和治疗建议中,医生需要知道AI是基于哪些医学证据和逻辑给出某个结论的。解释性AI可以提供详细的医学信息和决策依据,帮助医生更好地理解和接受AI的推荐方案。

法律领域:在涉及AI证据的司法场景中,解释性AI能够帮助律师和法官理解AI是如何得出某一结论的。通过提供合理的解释,可以增加判决的公正性和透明度,并减少对AI决策的质疑和争议。

此外,解释性AI还可以应用于智能助手、智能家居等场景中。在这些场景中,解释性AI能够帮助用户理解智能系统的行为和决策过程,提高用户体验和满意度。

方向四:可解释性AI的评估与度量

评估解释性AI的方法和度量标准仍在发展中:

- 透明度度量:衡量模型能够解释其决策的程度。可以通过比较模型输出的可解释性与随机猜测的可解释性来进行评估。

- 人类理解的符合度:评估人类对模型解释的理解程度。可以通过用户调研或实验来测量用户对模型输出的理解程度和满意度。

- 预测准确性与可解释性的权衡:在某些情况下,提高可解释性可能会牺牲一些预测准确性。因此,需要评估模型在保持预测准确性的同时实现可解释性的能力。

- 鲁棒性和泛化能力:评估模型在不同数据分布下的表现和泛化能力也是重要的度量标准。这有助于确保模型在实际应用中的稳定性和可靠性。

- 可扩展性和效率:评估模型的计算复杂性和训练时间也是重要的考量因素。高效的模型更易于部署和扩展到大规模的数据集上。

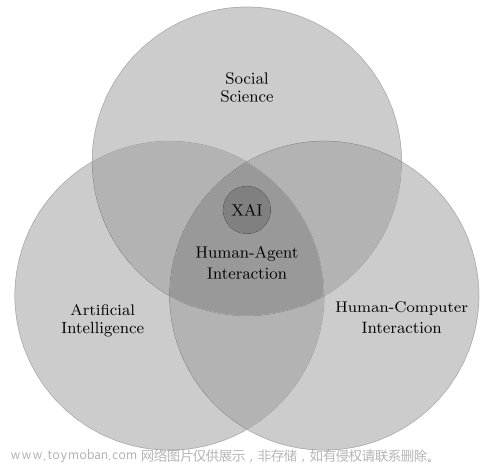

为了实现更好的评估和度量标准,需要跨学科的合作和深入的研究工作。心理学、社会学和其他相关领域的研究可以为评估解释性AI提供有用的见解和方法论指导。同时,工业界和学术界的合作也将有助于推动解释性AI的发展和应用。

方向五:可解释性AI的未来发展

随着技术的进步和应用的深入,可解释性AI(XAI)有望在未来几年取得重大突破和发展。以下是一些可能的发展趋势:

- 技术进步:随着机器学习和人工智能技术的不断进步,更先进的解释方法和技术将不断涌现。例如,基于图形的解释方法和模型内解释技术可能会在未来得到更广泛的应用。

- 多学科交叉:心理学、社会学和其他相关领域的研究将更多地与XAI结合,更深入地探讨人类对AI决策过程的认知和理解。这种跨学科的研究将有助于推动XAI的进一步发展。

- 与伦理、法律标准的结合:随着对AI伦理和法律的关注增加,XAI将更加紧密地与这些领域结合。解释性AI将不仅关注技术实现,还将更多地关注其在社会和伦理方面的考量,以确保AI决策的公正性和透明度。

- 更多应用领域:随着XAI的发展,其应用领域将进一步扩展。除了金融、医疗、法律等领域,XAI还可能应用于自动驾驶、智能家居等新兴领域,为人们的生活带来更多便利和安全。

- 标准化和评估:随着XAI的广泛应用,标准化和评估将成为重要的研究方向。制定统一的评估标准和度量方法将有助于比较不同解释方法的优劣,推动XAI的持续改进和发展。

总之,可解释性AI的未来发展前景广阔,将在技术、应用、伦理等多个方面取得突破。通过不断的研究和创新,XAI有望成为AI技术的重要发展方向,为人类带来更多福祉。

方向六:可解释性AI的实践经验与案例分析

以下是一些具有代表性的可解释性AI(XAI)实践经验和案例分析:文章来源:https://www.toymoban.com/news/detail-826880.html

- 微软的Grad-CAM技术:Grad-CAM是一种图像解释技术,能够通过分析神经网络的最后一层,生成图像来解释分类决策。微软的研究人员利用Grad-CAM技术对图像分类器进行解释,帮助用户理解模型决策背后的原因。通过这种方式,用户可以更好地理解模型的分类依据,提高对模型的信任度。

- 谷歌的SHapley值:SHapley值是一种在游戏理论中用于分配合作收益的方法。谷歌的研究人员将其应用于机器学习模型中,以公平地分配模型对输出的贡献。通过计算每个特征对模型输出的贡献,SHapley值提供了一种解释模型决策的方法,有助于揭示模型中不同特征的重要性和影响。

- MIT的Explainable Boosting Machine:Explainable Boosting Machine是一种结合了决策树和梯度提升机的机器学习模型。该模型旨在提供一种既高效又可解释的机器学习模型。通过采用集成学习的方法,该模型能够生成一系列决策树,每棵树都负责解释前一棵树的决策过程。这种方法提供了更加详细和透明的模型决策过程,有助于用户更好地理解模型的工作原理和输出结果。

这些实践经验和案例分析表明,可解释性AI在解决实际问题的过程中具有巨大的潜力和价值。通过提供清晰、详细的解释,XAI可以帮助用户更好地理解模型的决策过程,提高模型的信任度和应用效果。随着技术的不断发展和应用的深入,可解释性AI将为更多领域带来实际效益和改进。文章来源地址https://www.toymoban.com/news/detail-826880.html

到了这里,关于解释性AI:打开AI决策过程之门的金钥匙的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!