搭建hadoop虚拟机集群

一,虚拟机环境准备

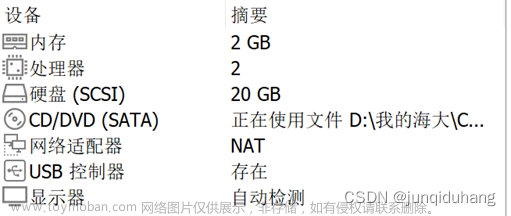

以三台虚拟机为例,配置如下:

1.台虚拟机:内存2G,处理2 硬盘50G ,如图

(电脑配置参考:8核16线程+32运行内存)

2.修改克隆虚拟机的静态IP

root下执行

vim /etc/sysconfig/network-scripts/ifcfg-ens33更改

DEVICE=ens33

TYPE=Ethernet

ONBOOT=yes

BOOTPROTO=static

NAME="ens33"

PREFIX=24

IPADDR=192.168.1.102(要修改的ip)

GATEWAY=192.168.1.2

DNS1=192.168.1.2

3.查看Linux虚拟机的虚拟网络编辑器,编辑->虚拟网络编辑器->VMnet8

4.查看Windows系统适配器VMware Network Adapter VMnet8的IP地址

保证Linux文件中IP地址、Linux虚拟网络编辑器地址和Windows系统VM8网络IP地址相同。

修改主机名 命令 hostnamectl --static set-hostname hadoop102

配置主机名称映射,(ip+空格+name)打开/etc/hosts ,添加

192.168.1.100 hadoop100

192.168.1.101 hadoop101

192.168.1.102 hadoop102

192.168.1.103 hadoop103

192.168.1.104 hadoop104

192.168.1.105 hadoop105

192.168.1.106 hadoop106

192.168.1.107 hadoop107

192.168.1.108 hadoop108

修改window10的主机映射文件(hosts文件)

(a)进入C:\Windows\System32\drivers\etc路径

(b)拷贝hosts文件到桌面

(c)打开桌面hosts文件并添加如下内容

192.168.1.100 hadoop100

192.168.1.101 hadoop101

192.168.1.102 hadoop102

192.168.1.103 hadoop103

192.168.1.104 hadoop104

192.168.1.105 hadoop105

192.168.1.106 hadoop106

192.168.1.107 hadoop107

192.168.1.108 hadoop108(d)将桌面hosts文件覆盖C:\Windows\System32\drivers\etc路径hosts文件

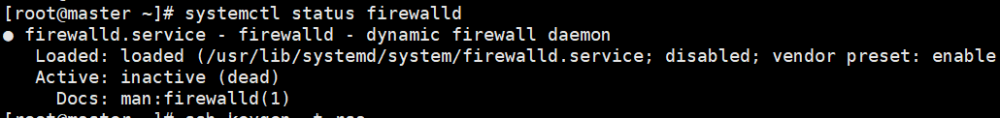

5.关闭防火墙(root下执行)

systemctl stop firewalld

systemctl disable firewalld

6.配置普通用户(以我创建的xiaoyi为例)具有root权限(root下执行)

vim /etc/sudoers

修改/etc/sudoers文件,找到%wheel下面添加一行:

## Allow root to run any commands anywhere

root ALL=(ALL) ALL

%wheel ALL=(ALL) ALL

xiaoyi ALL=(ALL) NOPASSWD: ALL

7.在/opt目录下创建文件夹(root下执行)

(1)在/opt目录下创建module、software文件夹

mkdir /opt/module /opt/software

(2)修改module、software文件夹的所有者

chown xiaoyi:xiaoyi /opt/module /opt/software

8.重启(root下执行)

reboot

二,编写集群分发脚本xsync

1.scp(secure copy)安全拷贝

(1)scp定义:

scp可以实现服务器与服务器之间的数据拷贝。(from server1 to server2)

(2)基本语法

scp -r $pdir/$fname $user@hadoop$host:$pdir/$fname命令 递归 要拷贝的文件路径/名称 目的用户@主机:目的路径/名称

(3)案例实操

(a)在hadoop102上,将hadoop102中/opt/module目录下的软件拷贝到hadoop103上。

[xiaoyi@hadoop102 ~]$ scp -r /opt/module/* xiaoyi@hadoop103:/opt/module(b)在hadoop104上,将hadoop102服务器上的/opt/module目录下的软件拷贝到hadoop104上。

[xiaoyi@hadoop104 opt]$ scp -r xiaoyi@hadoop102:/opt/module/* xiaoyi@hadoop104:/opt/module注意:拷贝过来的/opt/module目录,别忘了在hadoop102、hadoop103、hadoop104上修改所有文件的,所有者和所有者组。sudo chown xiaoyi:xiaoyi -R /opt/module

2.rsync远程同步工具

rsync主要用于备份和镜像。具有速度快、避免复制相同内容和支持符号链接的优点。

rsync和scp区别:用rsync做文件的复制要比scp的速度快,rsync只对差异文件做更新。scp是把所有文件都复制过去。

(1)基本语法

rsync -av $pdir/$fname $user@hadoop$host:$pdir/$fname

命令 选项参数 要拷贝的文件路径/名称 目的用户@主机:目的路径/名称

选项参数说明

| 选项 |

功能 |

| -a |

归档拷贝 |

| -v |

显示复制过程 |

(2)案例实操

(a)将hadoop102中/etc/profile.d/my_env.sh文件拷贝到hadoop103的/etc/profile.d/my_env.sh上。

[xiaoyi@hadoop102 ~]$ sudo rsync -av /etc/profile.d/my_env.sh

root@hadoop103:/etc/profile.d/my_env.sh(b)将hadoop102中/etc/profile.d/my_env.sh文件拷贝到hadoop103的/etc/profile.d/my_env.sh上。

[xiaoyi@hadoop102 ~]$ sudo rsync -av /etc/profile.d/my_env.sh root@hadoop104:/etc/profile.d/my_env.sh注意:拷贝过来的配置文件别忘了source一下/etc/profile.d/my_env.sh。

3.xsync集群分发脚本

(1)需求:循环复制文件到所有节点的相同目录下

(2)需求分析:

(a)rsync命令原始拷贝:

rsync -av /opt/module root@hadoop103:/opt/(b)期望脚本:

xsync要同步的文件名称

(c)说明:在/home/xiaoyi/bin这个目录下存放的脚本,xiaoyi用户可以在系统任何地方直接执行。

(3)脚本实现

(a)在家目录/home/xiaoyi下创建bin文件夹

[xiaoyi@hadoop102 ~]$ mkdir bin(b)在/home/xiaoyi/bin目录下创建xsync文件,以便全局调用

[xiaoyi@hadoop102 ~]$ cd /home/xiaoyi/bin[xiaoyi@hadoop102 ~]$ vim xsync在该文件中编写如下代码

#!/bin/bash

#1. 判断参数个数

if [ $# -lt 1 ]

then

echo Not Enough Arguement!

exit;

fi

#2. 遍历集群所有机器

for host in hadoop102 hadoop103 hadoop104

do

echo ==================== $host ====================

#3. 遍历所有目录,挨个发送

for file in $@

do

#4 判断文件是否存在

if [ -e $file ]

then

#5. 获取父目录

pdir=$(cd -P $(dirname $file); pwd)

#6. 获取当前文件的名称

fname=$(basename $file)

ssh $host "mkdir -p $pdir"

rsync -av $pdir/$fname $host:$pdir

else

echo $file does not exists!

fi

done

done(c)修改脚本 xsync 具有执行权限

[xiaoyi@hadoop102 bin]$ chmod +x xsync(d)测试脚本

[xiaoyi@hadoop102 bin]$ xsync xsync三, SSH无密登录配置

1.配置ssh

(1)基本语法

ssh另一台电脑的IP地址

(2)ssh连接时出现Host key verification failed的解决方法

[xiaoyi@hadoop102 ~]$ ssh hadoop103出现:

The authenticity of host '192.168.1.103 (192.168.1.103)' can't be established.

RSA key fingerprint is cf:1e:de:d7:d0:4c:2d:98:60:b4:fd:ae:b1:2d:ad:06.

Are you sure you want to continue connecting (yes/no)?

(3)解决方案如下:直接输入yes

2.无密钥配置(自己创建的用户下执行)

生成公钥和私钥执行命令:

ssh-keygen -t rsa然后敲(三个回车),就会生成两个文件id_rsa(私钥)、id_rsa.pub(公钥)

将公钥拷贝到要免密登录的目标机器上,执行以下三个命令

ssh-copy-id hadoop102ssh-copy-id hadoop103 ssh-copy-id hadoop104注意:

还需要在hadoop102上采用root账号,配置一下无密登录到hadoop102、hadoop103、hadoop104;

还需要在hadoop103上采用自己创建的账号(我的是xiaoyi)配置一下无密登录到hadoop102、hadoop103、hadoop104服务器上。

3.ssh文件夹下(~/.ssh)的文件功能解释

| known_hosts |

记录ssh访问过计算机的公钥(public key) |

| id_rsa |

生成的私钥 |

| id_rsa.pub |

生成的公钥 |

| authorized_keys文章来源:https://www.toymoban.com/news/detail-827392.html |

存放授权过的无密登录服务器公钥文章来源地址https://www.toymoban.com/news/detail-827392.html |

到了这里,关于虚拟机集群部署hadoop的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!