1.背景介绍

随着数据量的增加,数据处理和分析变得越来越复杂。在大数据领域,我们需要一种有效的方法来处理高维数据,以便更好地理解数据之间的关系和模式。这就是奇异值分解(Singular Value Decomposition, SVD)和主成分分析(Principal Component Analysis, PCA)发挥作用的地方。在本文中,我们将深入探讨这两种方法的核心概念、算法原理和应用。

2.核心概念与联系

2.1 奇异值分解(SVD)

奇异值分解是一种矩阵分解方法,它可以将矩阵分解为三个矩阵的乘积。给定一个矩阵A,SVD可以表示为:

$$ A = U \Sigma V^T $$

其中,U和V是两个矩阵,$\Sigma$是一个对角矩阵,包含了矩阵A的奇异值。奇异值是矩阵A的特征值,它们反映了矩阵A的秩和紧凑性。奇异值分解的主要应用是降维和矩阵分解,可以用于文本摘要、图像处理和推荐系统等领域。

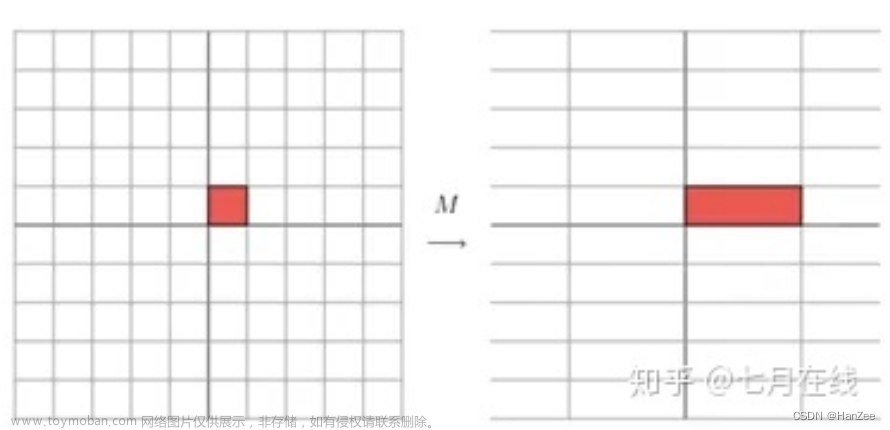

2.2 主成分分析(PCA)

主成分分析是一种降维方法,它通过找出数据中的主要方向,将高维数据压缩到低维空间。给定一个数据矩阵X,PCA可以表示为以下步骤:

- 计算矩阵X的自协方差矩阵。

- 找到自协方差矩阵的特征值和特征向量。

- 按照特征值的大小对特征向量进行排序。

- 选择最大的特征值和对应的特征向量,构成新的矩阵Y。

- 将原始数据矩阵X投影到新的矩阵Y的空间中。

主成分分析的主要应用是数据压缩、噪声消除和特征提取,可以用于图像处理、信号处理和机器学习等领域。

尽管SVD和PCA在理论和应用上存在一定的区别,但它们在实际应用中具有很强的联系。在文本摘要和推荐系统等领域,SVD可以用于构建用户-商品的相似度矩阵,然后通过PCA进行降维。此外,PCA也可以看作是SVD的一个特例,当矩阵A的奇异值都是正数且相等时,SVD和PCA是等价的。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

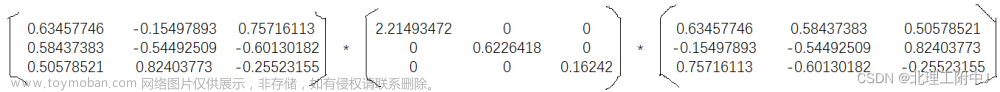

3.1 奇异值分解(SVD)

3.1.1 算法原理

SVD是一种矩阵分解方法,它可以将矩阵A分解为三个矩阵的乘积,其中A是一个实数矩阵,U和V是两个单位正交矩阵,$\Sigma$是一个非负定对角矩阵。SVD的核心在于找到矩阵A的奇异向量和奇异值。

3.1.2 具体操作步骤

- 计算矩阵A的奇异向量。

- 计算奇异向量的对应奇异值。

- 构造奇异值矩阵$\Sigma$。

- 构造左右奇异矩阵U和V。

3.1.3 数学模型公式详细讲解

给定一个矩阵A,其大小为$m \times n$,$m \geq n$。我们可以通过以下步骤进行SVD:

- 计算矩阵A的奇异向量。

首先,我们需要计算矩阵A的自适应值矩阵S,其大小为$n \times n$。自适应值矩阵S可以通过以下公式计算:

$$ S = A^T A $$

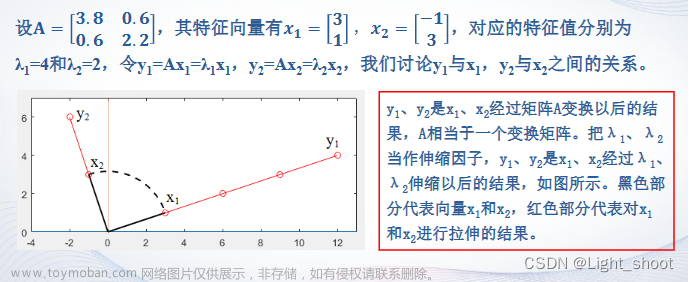

接下来,我们需要计算自适应值矩阵S的特征值和特征向量。特征值$\lambdai$和特征向量$vi$可以通过以下公式计算:

$$ S vi = \lambdai v_i $$

特征向量$v_i$可以正规化为单位向量,即:

$$ ui = \frac{vi}{\|v_i\|} $$

- 计算奇异向量的对应奇异值。

奇异值$\sigmai$可以通过自适应值矩阵S的特征值$\lambdai$计算:

$$ \sigmai = \sqrt{\lambdai} $$

- 构造奇异值矩阵$\Sigma$。

奇异值矩阵$\Sigma$是一个$n \times n$的非负定对角矩阵,其对角线元素为奇异值$\sigma_i$。

- 构造左右奇异矩阵U和V。

左奇异矩阵U是一个$m \times n$的矩阵,其每一行是对应的奇异向量$ui$。右奇异矩阵V是一个$n \times n$的矩阵,其每一行是对应的奇异向量$vi$。

3.2 主成分分析(PCA)

3.2.1 算法原理

PCA是一种降维方法,它通过找出数据中的主要方向,将高维数据压缩到低维空间。PCA的核心在于计算数据的自协方差矩阵,找到自协方差矩阵的特征值和特征向量,然后按照特征值的大小对特征向量进行排序。

3.2.2 具体操作步骤

- 计算矩阵X的自协方差矩阵。

- 找到自协方差矩阵的特征值和特征向量。

- 按照特征值的大小对特征向量进行排序。

- 选择最大的特征值和对应的特征向量,构成新的矩阵Y。

- 将原始数据矩阵X投影到新的矩阵Y的空间中。

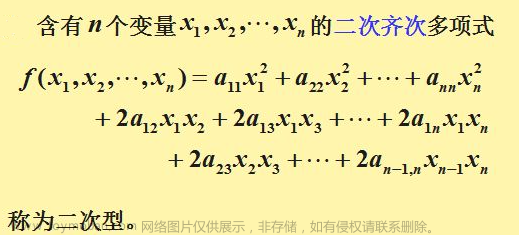

3.2.3 数学模型公式详细讲解

给定一个数据矩阵X,其大小为$n \times d$,$n \geq d$。我们可以通过以下步骤进行PCA:

- 计算矩阵X的自协方差矩阵。

自协方差矩阵S可以通过以下公式计算:

$$ S = \frac{1}{n - 1} X^T X $$

- 找到自协方差矩阵的特征值和特征向量。

特征值$\lambdai$和特征向量$pi$可以通过以下公式计算:

$$ S pi = \lambdai p_i $$

特征向量$p_i$可以正规化为单位向量,即:

$$ ei = \frac{pi}{\|p_i\|} $$

- 按照特征值的大小对特征向量进行排序。

将特征向量按照特征值的大小从大到小排序,得到一个新的矩阵E。

- 选择最大的特征值和对应的特征向量,构成新的矩阵Y。

选择特征值$\lambdai$和对应的特征向量$ei$,构成新的矩阵Y。

- 将原始数据矩阵X投影到新的矩阵Y的空间中。

将原始数据矩阵X投影到新的矩阵Y的空间中,可以通过以下公式计算:

$$ Y = X E $$

其中,E是一个$d \times r$的矩阵,$r$是选择的特征向量的数量。

4.具体代码实例和详细解释说明

4.1 奇异值分解(SVD)

4.1.1 Python代码实例

```python import numpy as np from scipy.linalg import svd

给定一个矩阵A

A = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

使用svd函数进行奇异值分解

U, sigma, V = svd(A, full_matrices=False)

打印结果

print("U:\n", U) print("sigma:\n", sigma) print("V:\n", V) ```

4.1.2 解释说明

在上述代码中,我们使用了scipy库中的svd函数进行奇异值分解。full_matrices=False参数表示返回U和V为单位正交矩阵,而不是全矩阵。最后,我们打印了U、sigma和V的结果。

4.2 主成分分析(PCA)

4.2.1 Python代码实例

```python import numpy as np from scipy.linalg import eig

给定一个数据矩阵X

X = np.array([[1, 2], [3, 4], [5, 6], [7, 8]])

计算自协方差矩阵S

S = np.dot(X.T, X) / (X.shape[0] - 1)

计算自协方差矩阵S的特征值和特征向量

values, vectors = eig(S)

按照特征值的大小对特征向量进行排序

indices = np.argsort(values)[::-1] sorted_vectors = vectors[:, indices]

选择最大的特征值和对应的特征向量,构成新的矩阵Y

threshold = np.finfo(float).eps * 2 values = values[values > threshold] vectors = vectors[:, values > threshold]

将原始数据矩阵X投影到新的矩阵Y的空间中

Y = np.dot(X, vectors)

打印结果

print("Y:\n", Y) ```

4.2.2 解释说明

在上述代码中,我们首先计算了自协方差矩阵S,然后使用eig函数计算了自协方差矩阵S的特征值和特征向量。接下来,我们按照特征值的大小对特征向量进行排序,选择最大的特征值和对应的特征向量,构成新的矩阵Y。最后,我们将原始数据矩阵X投影到新的矩阵Y的空间中,并打印了结果。

5.未来发展趋势与挑战

随着大数据技术的不断发展,SVD和PCA在数据处理和分析中的应用范围将会不断扩大。未来的挑战之一是如何在面对大规模数据和高维特征的情况下,更高效地进行奇异值分解和主成分分析。此外,如何在保持准确性的同时,降低算法复杂度和计算成本,也是未来研究的重点。

6.附录常见问题与解答

6.1 SVD与PCA的区别

SVD是一种矩阵分解方法,它可以将矩阵分解为三个矩阵的乘积。PCA是一种降维方法,它通过找出数据中的主要方向,将高维数据压缩到低维空间。虽然它们在理论和应用上存在一定的区别,但它们在实际应用中具有很强的联系。

6.2 SVD与PCA的联系

在文本摘要和推荐系统等领域,SVD可以用于构建用户-商品的相似度矩阵,然后通过PCA进行降维。此外,PCA也可以看作是SVD的一个特例,当矩阵A的奇异值都是正数且相等时,SVD和PCA是等价的。

6.3 SVD与PCA的应用

SVD和PCA在数据处理和分析中有广泛的应用,包括文本摘要、图像处理、信号处理、机器学习等领域。它们在降维、特征提取和矩阵分解等方面具有很强的优势。

参考文献

[1] Turki Alsaadi, Ahmed Al-Fuqaha. "Principal Component Analysis: Theory and Applications." Springer, 2012.

[2] G. H. Golub, C. F. Van Loan. "Matrix Computations." Johns Hopkins University Press, 1996.文章来源:https://www.toymoban.com/news/detail-827930.html

[3] E. J. Candes, M. Recht, J. O. Davenport, J. W. Demmel. "Matrix Compression: An Algorithm for Reducing the Memory Footprint of Sparse Matrices." Journal of Machine Learning Research, 2011.文章来源地址https://www.toymoban.com/news/detail-827930.html

到了这里,关于特征值与特征向量: 矩阵的奇异值分解与主成分分析的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!