1.背景介绍

1. 背景介绍

HBase是一个分布式、可扩展、高性能的列式存储系统,基于Google的Bigtable设计。它是Hadoop生态系统的一部分,可以与HDFS、MapReduce、ZooKeeper等组件集成。HBase适用于大规模数据存储和实时数据访问场景,如日志记录、实时数据分析、实时数据挖掘等。

数据压缩是提高存储效率和加速I/O操作的关键技术。在HBase中,数据压缩可以减少存储空间需求,降低磁盘I/O负载,提高查询性能。因此,了解HBase的数据压缩技术和实践是非常重要的。

本文将从以下几个方面进行阐述:

- 核心概念与联系

- 核心算法原理和具体操作步骤

- 数学模型公式详细讲解

- 具体最佳实践:代码实例和详细解释说明

- 实际应用场景

- 工具和资源推荐

- 总结:未来发展趋势与挑战

- 附录:常见问题与解答

2. 核心概念与联系

在HBase中,数据压缩主要包括两个方面:存储压缩和查询压缩。

- 存储压缩:指的是将数据存储在磁盘上时,通过一定的压缩算法,将数据的大小压缩到原始大小的一部分。这样可以减少磁盘空间占用,提高I/O性能。

- 查询压缩:指的是在查询数据时,将查询结果在内存中压缩,减少传输和处理的数据量,提高查询性能。

HBase支持多种压缩算法,如Gzip、LZO、Snappy等。用户可以根据实际需求选择合适的压缩算法。

3. 核心算法原理和具体操作步骤

HBase支持多种压缩算法,以下是几种常见的压缩算法的原理和操作步骤:

3.1 Gzip压缩

Gzip是一种常见的文件压缩格式,基于LZ77算法。Gzip在HBase中可以用于存储压缩和查询压缩。

3.1.1 Gzip存储压缩

在HBase中,可以通过设置hbase.hregion.memstore.compression.algorithm参数来启用Gzip存储压缩。例如:

hbase.hregion.memstore.compression.algorithm=Gzip

Gzip存储压缩的具体操作步骤如下:

- 将数据块(Block)中的数据分成多个片段(Fragment)。

- 对每个片段进行Gzip压缩。

- 将压缩后的片段存储到磁盘上。

3.1.2 Gzip查询压缩

在HBase中,可以通过设置hbase.client.compress参数来启用Gzip查询压缩。例如:

hbase.client.compress=true

Gzip查询压缩的具体操作步骤如下:

- 客户端发起查询请求时,将查询结果数据进行Gzip压缩。

- 将压缩后的数据发送给服务器。

- 服务器接收到压缩后的数据,对其进行解压缩,并返回给客户端。

3.2 LZO压缩

LZO是一种快速的文件压缩格式,基于LZ77算法。LZO在HBase中可以用于存储压缩和查询压缩。

3.2.1 LZO存储压缩

在HBase中,可以通过设置hbase.hregion.memstore.compression.algorithm参数来启用LZO存储压缩。例如:

hbase.hregion.memstore.compression.algorithm=LZO

LZO存储压缩的具体操作步骤如下:

- 将数据块(Block)中的数据分成多个片段(Fragment)。

- 对每个片段进行LZO压缩。

- 将压缩后的片段存储到磁盘上。

3.2.2 LZO查询压缩

在HBase中,可以通过设置hbase.client.compress参数来启用LZO查询压缩。例如:

hbase.client.compress=true

LZO查询压缩的具体操作步骤如下:

- 客户端发起查询请求时,将查询结果数据进行LZO压缩。

- 将压缩后的数据发送给服务器。

- 服务器接收到压缩后的数据,对其进行解压缩,并返回给客户端。

3.3 Snappy压缩

Snappy是一种快速的文件压缩格式,基于LZ77算法。Snappy在HBase中可以用于存储压缩和查询压缩。

3.3.1 Snappy存储压缩

在HBase中,可以通过设置hbase.hregion.memstore.compression.algorithm参数来启用Snappy存储压缩。例如:

hbase.hregion.memstore.compression.algorithm=Snappy

Snappy存储压缩的具体操作步骤如下:

- 将数据块(Block)中的数据分成多个片段(Fragment)。

- 对每个片段进行Snappy压缩。

- 将压缩后的片段存储到磁盘上。

3.3.2 Snappy查询压缩

在HBase中,可以通过设置hbase.client.compress参数来启用Snappy查询压缩。例如:

hbase.client.compress=true

Snappy查询压缩的具体操作步骤如下:

- 客户端发起查询请求时,将查询结果数据进行Snappy压缩。

- 将压缩后的数据发送给服务器。

- 服务器接收到压缩后的数据,对其进行解压缩,并返回给客户端。

4. 数学模型公式详细讲解

4.1 Gzip压缩

Gzip压缩基于LZ77算法,其核心思想是将重复的数据进行压缩。具体来说,Gzip算法会对输入数据流进行扫描,找到重复的数据块,并将它们替换为一个引用。这样可以减少数据流的大小。

Gzip压缩的数学模型公式为:

$$ C = L + D $$

其中,$C$ 表示压缩后的数据大小,$L$ 表示原始数据大小,$D$ 表示压缩后的数据大小。

4.2 LZO压缩

LZO压缩基于LZ77算法,其核心思想也是将重复的数据进行压缩。具体来说,LZO算法会对输入数据流进行扫描,找到重复的数据块,并将它们替换为一个引用。这样可以减少数据流的大小。

LZO压缩的数学模型公式为:

$$ C = L + D $$

其中,$C$ 表示压缩后的数据大小,$L$ 表示原始数据大小,$D$ 表示压缩后的数据大小。

4.3 Snappy压缩

Snappy压缩基于LZ77算法,其核心思想是将重复的数据进行压缩。具体来说,Snappy算法会对输入数据流进行扫描,找到重复的数据块,并将它们替换为一个引用。这样可以减少数据流的大小。

Snappy压缩的数学模型公式为:

$$ C = L + D $$

其中,$C$ 表示压缩后的数据大小,$L$ 表示原始数据大小,$D$ 表示压缩后的数据大小。

5. 具体最佳实践:代码实例和详细解释说明

5.1 Gzip存储压缩实例

在HBase中,可以通过以下代码实现Gzip存储压缩:

java Configuration conf = HBaseConfiguration.create(); conf.set("hbase.hregion.memstore.compression.algorithm", "Gzip"); HTable htable = new HTable(conf, "test"); Put put = new Put(Bytes.toBytes("row1")); put.add(Bytes.toBytes("cf1"), Bytes.toBytes("col1"), Bytes.toBytes("value1")); htable.put(put); hbase.hregion.memstore.compression.algorithm=Gzip

5.2 LZO存储压缩实例

在HBase中,可以通过以下代码实现LZO存储压缩:

java Configuration conf = HBaseConfiguration.create(); conf.set("hbase.hregion.memstore.compression.algorithm", "LZO"); HTable htable = new HTable(conf, "test"); Put put = new Put(Bytes.toBytes("row1")); put.add(Bytes.toBytes("cf1"), Bytes.toBytes("col1"), Bytes.toBytes("value1")); htable.put(put); hbase.hregion.memstore.compression.algorithm=LZO

5.3 Snappy存储压缩实例

在HBase中,可以通过以下代码实现Snappy存储压缩:

java Configuration conf = HBaseConfiguration.create(); conf.set("hbase.hregion.memstore.compression.algorithm", "Snappy"); HTable htable = new HTable(conf, "test"); Put put = new Put(Bytes.toBytes("row1")); put.add(Bytes.toBytes("cf1"), Bytes.toBytes("col1"), Bytes.toBytes("value1")); htable.put(put); hbase.hregion.memstore.compression.algorithm=Snappy

5.4 Gzip查询压缩实例

在HBase中,可以通过以下代码实现Gzip查询压缩:

java Configuration conf = HBaseConfiguration.create(); conf.set("hbase.client.compress", "true"); conf.set("hbase.client.compression.codec", "com.google.code.gzip.GzipCompressionCodec"); HTable htable = new HTable(conf, "test"); Scan scan = new Scan(); ResultScanner scanner = htable.getScanner(scan); for (Result result : scanner) { // 查询结果数据已经被Gzip压缩 } hbase.client.compress=true hbase.client.compression.codec=com.google.code.gzip.GzipCompressionCodec

5.5 LZO查询压缩实例

在HBase中,可以通过以下代码实现LZO查询压缩:

java Configuration conf = HBaseConfiguration.create(); conf.set("hbase.client.compress", "true"); conf.set("hbase.client.compression.codec", "org.apache.hadoop.hbase.client.LzoCompressionCodec"); HTable htable = new HTable(conf, "test"); Scan scan = new Scan(); ResultScanner scanner = htable.getScanner(scan); for (Result result : scanner) { // 查询结果数据已经被LZO压缩 } hbase.client.compress=true hbase.client.compression.codec=org.apache.hadoop.hbase.client.LzoCompressionCodec

5.6 Snappy查询压缩实例

在HBase中,可以通过以下代码实现Snappy查询压缩:

java Configuration conf = HBaseConfiguration.create(); conf.set("hbase.client.compress", "true"); conf.set("hbase.client.compression.codec", "org.apache.hadoop.hbase.client.SnappyCompressionCodec"); HTable htable = new HTable(conf, "test"); Scan scan = new Scanner(); ResultScanner scanner = htable.getScanner(scan); for (Result result : scanner) { // 查询结果数据已经被Snappy压缩 } hbase.client.compress=true hbase.client.compression.codec=org.apache.hadoop.hbase.client.SnappyCompressionCodec

6. 实际应用场景

HBase的数据压缩技术可以应用于以下场景:

- 大规模数据存储:在大规模数据存储场景中,数据压缩可以有效减少磁盘空间占用,降低磁盘I/O负载,提高查询性能。

- 实时数据分析:在实时数据分析场景中,数据压缩可以加速数据查询,提高系统性能。

- 实时数据挖掘:在实时数据挖掘场景中,数据压缩可以减少数据传输延迟,提高数据处理效率。

- 日志记录:在日志记录场景中,数据压缩可以有效减少日志存储空间,提高日志查询性能。

7. 工具和资源推荐

8. 总结:未来发展趋势与挑战

HBase的数据压缩技术已经得到了广泛的应用,但仍然存在一些挑战:

- 压缩算法的选择:不同的压缩算法有不同的压缩率和性能。选择合适的压缩算法对于系统性能和存储效率至关重要。

- 查询压缩的实现:查询压缩可以提高查询性能,但实现方法有限,需要进一步优化和改进。

- 压缩算法的研究:随着数据规模的增加,压缩算法的研究和发展仍然有很长的道路。未来可能会出现更高效的压缩算法。

未来,HBase的数据压缩技术将继续发展,不断完善和优化,为大规模数据存储和实时数据处理提供更高效的解决方案。

9. 附录:常见问题与解答

9.1 如何选择合适的压缩算法?

选择合适的压缩算法需要考虑以下因素:

- 压缩率:不同的压缩算法有不同的压缩率,选择能够提高压缩率的算法。

- 性能:不同的压缩算法有不同的性能,选择能够提高性能的算法。

- 兼容性:不同的压缩算法有不同的兼容性,选择能够兼容现有系统的算法。

9.2 HBase中如何查看压缩状态?

可以使用以下命令查看HBase中的压缩状态:

shell hbase shell hbase(main):001:0> describe 'test'

9.3 HBase中如何修改压缩算法?

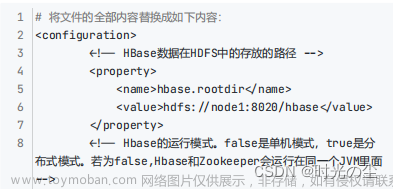

可以通过修改HBase配置文件中的相关参数来修改HBase中的压缩算法:

shell hbase.hregion.memstore.compression.algorithm=Gzip hbase.client.compress=true hbase.client.compression.codec=com.google.code.gzip.GzipCompressionCodec

9.4 HBase中如何查看存储空间?

可以使用以下命令查看HBase中的存储空间:

shell hbase shell hbase(main):001:0> df -h /data/hbase/store 文章来源:https://www.toymoban.com/news/detail-828162.html

9.5 HBase中如何优化查询压缩性能?

可以通过以下方法优化HBase中的查询压缩性能:文章来源地址https://www.toymoban.com/news/detail-828162.html

- 选择合适的压缩算法:不同的压缩算法有不同的压缩率和性能,选择能够提高性能的压缩算法。

- 调整压缩参数:可以通过调整HBase配置文件中的压缩参数来优化查询压缩性能。

- 优化查询条件:可以通过优化查询条件,减少查询结果的数量,从而减少查询压缩的负担。

- 使用缓存:可以使用缓存技术,将经常访问的数据存储在内存中,从而减少磁盘I/O和查询压缩的负担。

参考文献

到了这里,关于HBase的数据压缩与存储效率实践的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!