《揭秘AI“黑箱”:可解释性AI(XAI)引领透明智能新时代》

方向一:可解释性AI的定义与重要性

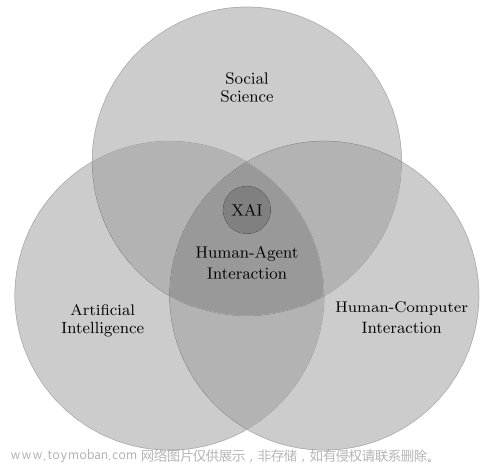

可解释性AI(XAI)是指能够使人工智能系统的决策过程和输出结果具有可理解性和透明度的技术与方法。随着人工智能技术的广泛应用,人们越来越关注AI系统的可解释性,因为这有助于建立人们对AI的信任,促进AI技术的可持续发展。

可解释性AI的重要性主要体现在以下几个方面:首先,它有助于人们理解AI系统的决策过程和原理,从而增强对AI的信任和接受度;其次,它可以帮助发现和纠正AI系统中的偏见和错误,提高AI的准确性和可靠性;最后,它有助于推动AI技术的创新和发展,为解决复杂问题提供新的思路和方法。

方向二:可解释性AI的挑战与难点

尽管可解释性AI具有重要意义,但在实现过程中面临着许多挑战和难点。其中最主要的挑战包括模型复杂性、数据不确定性和因果关系等。

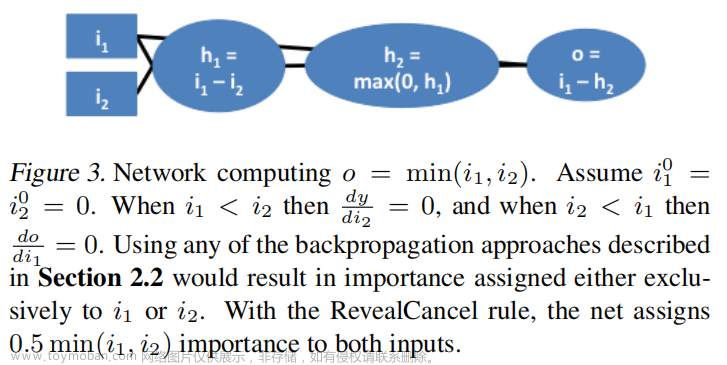

模型复杂性是指现代AI系统通常包含大量的参数和复杂的结构,导致人们难以直观地理解其决策过程。数据不确定性是指AI系统在处理数据时存在的不确定性,如噪声、缺失值等,这些不确定性会影响AI系统的决策结果和可解释性。因果关系是指AI系统在做出决策时需要考虑的各种因素之间的因果关系,这些因果关系往往难以准确地捕捉和描述。

为了克服这些挑战,提高AI的可解释性,研究者们正在不断探索新的方法和技术,如简化模型结构、提高数据质量、引入因果推理等。

方向三:可解释性AI的应用场景

可解释性AI在许多领域都有着广泛的应用,如金融、医疗、自动驾驶、安全等。在金融领域,可解释性AI可以帮助银行等机构更好地理解客户的信用评分和贷款审批过程,从而提高决策的准确性和公正性。在医疗领域,可解释性AI可以帮助医生更好地理解诊断结果和治疗方案,从而提高治疗效果和患者满意度。在自动驾驶领域,可解释性AI可以帮助人们更好地理解自动驾驶系统的决策过程和行驶轨迹,从而增强对自动驾驶系统的信任和接受度。在安全领域,可解释性AI可以帮助安全专家更好地理解安全漏洞和攻击行为,从而提高系统的安全性和可靠性。

方向四:可解释性AI的评估与度量

评估和度量AI的可解释性是推动可解释性AI发展的重要环节。目前,研究者们已经提出了一些评估和度量AI可解释性的标准和方法,如模型简洁性、决策一致性、用户满意度等。

模型简洁性是指AI模型的复杂程度,简洁的模型通常更容易被人们理解和接受。决策一致性是指AI系统在相同或相似输入下做出的决策是否一致,一致性高的系统通常更可靠。用户满意度是指用户对AI系统决策过程和结果的满意程度,用户满意度高的系统通常更易于推广和应用。

然而,这些评估标准和度量方法都存在一定的局限性和不足之处。例如,模型简洁性可能无法完全反映AI系统的决策过程,决策一致性可能受到数据不确定性的影响,用户满意度可能受到用户主观因素的影响。因此,在实际应用中需要综合考虑多种评估标准和度量方法,以全面评估AI的可解释性。

方向五:可解释性AI的未来发展

随着人工智能技术的不断发展和应用领域的不断拓展,可解释性AI将面临更多的挑战和机遇。未来,可解释性AI的发展趋势可能包括以下几个方面:

- 模型简化与优化:为了提高AI的可解释性,研究者们可能会继续探索如何简化和优化AI模型的结构和参数,使其更易于理解和实现。

- 数据质量与处理:数据是AI系统的基础,提高数据质量和处理效率将有助于提高AI的可解释性。未来,研究者们可能会更加关注数据清洗、去噪、填充等预处理技术,以及如何利用无监督学习等方法从数据中提取有用信息。

- 因果推理与可解释性增强:因果推理是一种重要的可解释性增强技术,它可以帮助人们更好地理解AI系统的决策过程和输出结果。未来,研究者们可能会继续探索如何将因果推理与深度学习等方法相结合,以实现更高效和准确的可解释性AI。

- 多模态可解释性AI:随着多媒体技术的发展,AI系统需要处理的数据类型越来越丰富多样。未来,研究者们可能会探索如何实现多模态可解释性AI,即能够同时处理文本、图像、音频等多种类型数据并输出可理解的结果和解释。

- 隐私保护与安全性增强:随着AI技术的广泛应用和数据量的不断增加,隐私保护和安全性问题也越来越突出。未来,研究者们可能会更加关注如何在保证AI可解释性的同时保护用户隐私和数据安全。

方向六:可解释性AI的实践经验与案例分析

在实际应用可解释性AI的过程中,许多企业和研究机构已经积累了一些宝贵的实践经验和案例分析。这些经验和案例不仅有助于人们更好地理解和应用可解释性AI,还可以为未来的研究和发展提供有益的借鉴和参考。

例如,在金融领域,一些银行已经利用可解释性AI技术来优化信用评分和贷款审批流程。他们通过构建简洁而透明的AI模型来解释客户的信用评分结果和贷款审批决策过程,从而提高了决策的准确性和公正性并增强了客户信任度。在医疗领域,一些医院已经利用可解释性AI技术来辅助医生进行诊断和治疗方案制定。他们通过构建基于深度学习等技术的可解释性AI模型来自动分析医学影像和病历数据并输出诊断结果和治疗建议,从而提高了治疗效果和患者满意度并降低了医疗成本。文章来源:https://www.toymoban.com/news/detail-828307.html

这些实践经验和案例分析表明,可解释性AI在实际应用中具有广阔的应用前景和巨大的潜力价值。未来随着技术的不断发展和应用场景的不断拓展,可解释性AI将在更多领域发挥重要作用并推动人工智能技术的可持续发展。文章来源地址https://www.toymoban.com/news/detail-828307.html

到了这里,关于《揭秘AI“黑箱”:可解释性AI(XAI)引领透明智能新时代》的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!