1.背景介绍

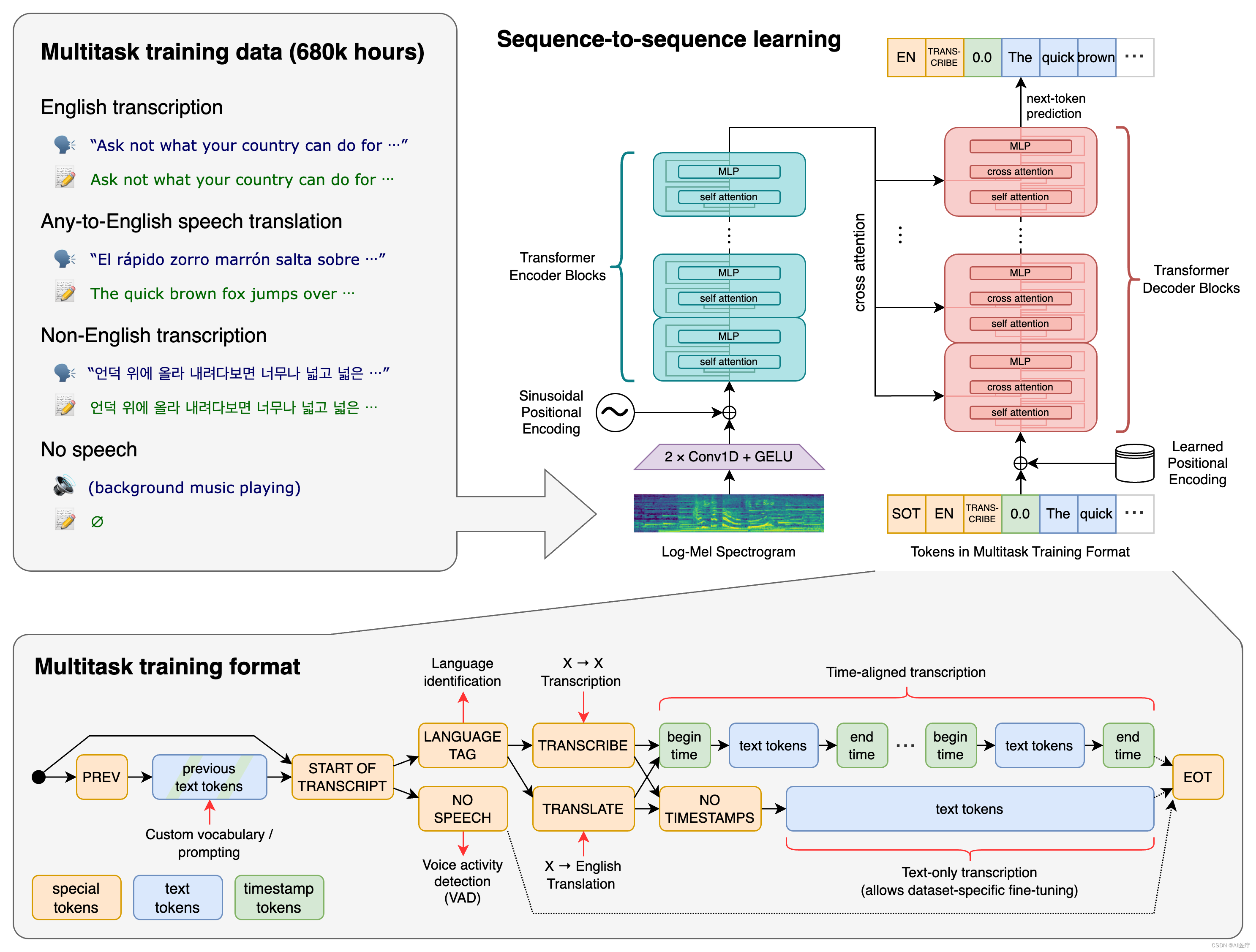

语音识别技术是人工智能领域的一个重要分支,它能将人类的语音信号转换为文本,从而实现人机交互、语音搜索、语音助手等多种应用。在过去的几十年里,语音识别技术发展迅速,从基于规则的方法演变到基于机器学习的方法,最终达到了现代深度学习时代。

在深度学习时代,自编码器(Autoencoder)是一种非常重要的神经网络架构,它可以用于降维、特征学习和代码压缩等任务。自编码器的核心思想是通过压缩输入数据的编码器(Encoder),将编码信息解码为原始数据的解码器(Decoder)。自编码器可以学习数据的潜在结构,从而实现数据压缩和特征提取。

然而,传统的自编码器存在一个问题:它们只能学习到完全完备的代码,即编码器和解码器之间的映射是双向的、无损的。这种完备性限制了自编码器的表达能力,因为在实际应用中,我们往往需要学习到欠完备的代码,即编码器和解码器之间的映射是单向的、有损的。例如,在图像压缩应用中,我们需要将高质量的原图压缩为低质量的缩略图,然后通过解码器重构出原图,这种过程是有损的。

为了解决这个问题,2007年,Jürgen Schmidhuber等人提出了欠完备自编码(Undercomplete Autoencoding)的概念,并在语音识别领域进行了广泛应用。欠完备自编码的核心思想是通过学习欠完备的代码,实现对数据的有损压缩和特征提取。在语音识别任务中,欠完备自编码可以学习到语音特征的欠完备代码,从而实现语音信号的有损压缩和文本转换。

在这篇文章中,我们将从以下六个方面进行深入探讨:

- 背景介绍

- 核心概念与联系

- 核心算法原理和具体操作步骤以及数学模型公式详细讲解

- 具体代码实例和详细解释说明

- 未来发展趋势与挑战

- 附录常见问题与解答

2.核心概念与联系

在本节中,我们将介绍欠完备自编码的核心概念和与语音识别任务的联系。

2.1 欠完备自编码

欠完备自编码(Undercomplete Autoencoding)是一种学习欠完备代码的自编码器变体。在欠完备自编码中,编码器的输出神经元数量小于输入神经元数量,这使得编码器能够学习到数据的低维表示,从而实现有损压缩。欠完备自编码的核心思想是通过学习欠完备的代码,实现对数据的有损压缩和特征提取。

2.2 语音识别任务

语音识别任务的核心是将人类的语音信号转换为文本,从而实现人机交互、语音搜索、语音助手等多种应用。语音识别任务可以分为两个主要阶段:语音特征提取和语音模型识别。在语音特征提取阶段,我们需要将语音信号转换为数字特征,如MFCC(Mel-frequency cepstral coefficients)、PBMM(Perceptual Binary Pitch-synchronous Masking)等。在语音模型识别阶段,我们需要将数字特征输入到语音模型中,如HMM(Hidden Markov Model)、DNN(Deep Neural Network)等,从而实现文本转换。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

在本节中,我们将详细讲解欠完备自编码在语音识别任务中的核心算法原理、具体操作步骤以及数学模型公式。

3.1 欠完备自编码的算法原理

欠完备自编码的算法原理如下:

- 编码器(Encoder):将输入的高维数据(如语音特征)压缩为低维的欠完备代码。

- 解码器(Decoder):将低维的欠完备代码展开为原始数据(如文本)。

欠完备自编码的学习目标是最小化输入数据和解码器重构后的数据之间的差异,从而实现有损压缩和特征提取。

3.2 欠完备自编码的具体操作步骤

欠完备自编码的具体操作步骤如下:

- 初始化编码器和解码器的权重。

- 对输入数据(如语音特征)进行正则化处理,以防止过拟合。

- 通过编码器将输入数据压缩为低维的欠完备代码。

- 通过解码器将欠完备代码展开为原始数据(如文本)。

- 计算输入数据和解码器重构后的数据之间的差异,并更新编码器和解码器的权重。

- 重复步骤3-5,直到收敛。

3.3 欠完备自编码的数学模型公式

欠完备自编码的数学模型公式如下:

$$ \begin{aligned} & E{enc} = \frac{1}{N} \sum{i=1}^{N} \| xi - \hat{x}i \|^2 \ & E{dec} = \frac{1}{N} \sum{i=1}^{N} \| xi - \hat{x}i \|^2 \ & E{total} = E{enc} + \alpha E_{dec} \ \end{aligned} $$

其中,$E{enc}$表示编码器损失,$E{dec}$表示解码器损失,$E{total}$表示总损失,$N$表示数据样本数量,$xi$表示输入数据,$\hat{x}_i$表示解码器重构后的数据,$\alpha$表示解码器损失的权重。

4.具体代码实例和详细解释说明

在本节中,我们将通过一个具体的代码实例来详细解释欠完备自编码在语音识别任务中的实现过程。

4.1 数据准备

首先,我们需要准备语音数据。我们可以使用LibriSpeech数据集,将其中的语音信号转换为MFCC特征。

```python import librosa import numpy as np

def mfcc(audiofile): signal, sr = librosa.load(audiofile, sr=16000) mfccs = librosa.feature.mfcc(signal, sr=16000) return mfccs

audiofile = 'path/to/audio/file' mfccs = mfcc(audiofile) ```

4.2 编码器和解码器的定义

接下来,我们需要定义编码器和解码器。我们可以使用PyTorch来定义神经网络模型。

```python import torch import torch.nn as nn

class Encoder(nn.Module): def init(self, inputdim, hiddendim, outputdim): super(Encoder, self).init() self.linear1 = nn.Linear(inputdim, hiddendim) self.linear2 = nn.Linear(hiddendim, output_dim)

def forward(self, x):

h = torch.relu(self.linear1(x))

return self.linear2(h)class Decoder(nn.Module): def init(self, inputdim, hiddendim, outputdim): super(Decoder, self).init() self.linear1 = nn.Linear(inputdim, hiddendim) self.linear2 = nn.Linear(hiddendim, output_dim)

def forward(self, x):

h = torch.relu(self.linear1(x))

return self.linear2(h)```

4.3 训练过程

最后,我们需要训练编码器和解码器。我们可以使用Stochastic Gradient Descent(SGD)优化算法,并设置合适的学习率、批量大小等参数。

```python encoder = Encoder(inputdim=mfccs.shape[1], hiddendim=64, outputdim=32) decoder = Decoder(inputdim=32, hiddendim=64, outputdim=mfccs.shape[1])

optimizer = torch.optim.SGD(params=encoder.parameters() + decoder.parameters(), lr=0.01) criterion = nn.MSELoss()

for epoch in range(100): optimizer.zero_grad() encoded = encoder(mfccs) decoded = decoder(encoded) loss = criterion(mfccs, decoded) loss.backward() optimizer.step() if epoch % 10 == 0: print(f'Epoch {epoch}, Loss: {loss.item()}') ```

5.未来发展趋势与挑战

在本节中,我们将讨论欠完备自编码在语音识别领域的未来发展趋势与挑战。

5.1 未来发展趋势

- 更高效的算法:未来,我们可以尝试开发更高效的欠完备自编码算法,以实现更快的训练速度和更低的计算成本。

- 更强的模型:我们可以尝试使用更深的神经网络结构,以提高模型的表达能力,从而实现更准确的语音识别。

- 更广的应用:欠完备自编码在语音识别任务中的应用不仅限于语音搜索和语音助手,还可以扩展到语音合成、语音命令识别等多种应用。

5.2 挑战

- 数据不均衡:语音数据集中的类别和样本数量往往存在较大的不均衡,这会导致模型在训练过程中容易过拟合。

- 语音质量问题:语音质量受环境、设备等因素影响,这会导致输入数据的不稳定性,从而影响模型的性能。

- 语音变化问题:人类的语音在不同的情境下会有所变化,这会导致模型需要处理大量的变化样本,从而增加模型的复杂性。

6.附录常见问题与解答

在本节中,我们将回答一些常见问题及其解答。

6.1 问题1:为什么欠完备自编码在语音识别任务中表现出色?

答案:欠完备自编码在语音识别任务中表现出色是因为它可以学习到语音特征的欠完备代码,从而实现有损压缩和特征提取。这种有损压缩可以减少存储和传输开销,从而实现更高效的语音识别。

6.2 问题2:欠完备自编码与完备自编码的区别是什么?

答案:完备自编码是指编码器和解码器之间的映射是双向的、无损的,即可以将编码信息解码回原始数据。而欠完备自编码是指编码器和解码器之间的映射是单向的、有损的,即无法将解码信息编码回原始数据。文章来源:https://www.toymoban.com/news/detail-828326.html

6.3 问题3:欠完备自编码在其他应用中的作用是什么?

答案:欠完备自编码不仅可以应用于语音识别,还可以应用于图像压缩、图像生成、生成对抗网络(GAN)等多种应用。在这些应用中,欠完备自编码可以学习到数据的欠完备代码,从而实现有损压缩和特征提取。文章来源地址https://www.toymoban.com/news/detail-828326.html

到了这里,关于欠完备自编码在语音识别领域的革命的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!