1.背景介绍

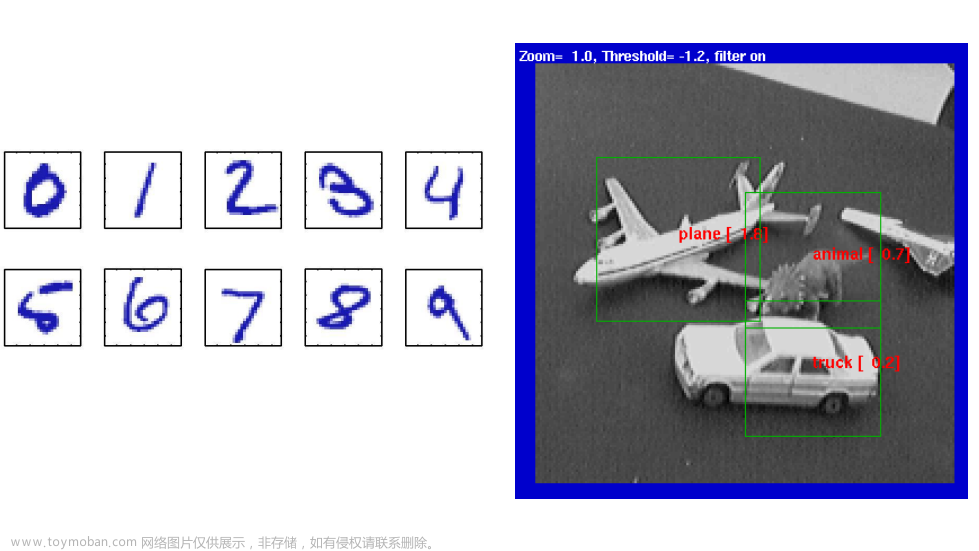

强化学习(Reinforcement Learning, RL)是一种人工智能(Artificial Intelligence, AI)技术,它通过在环境中进行交互,学习如何取得最大化的奖励。在过去的几年里,强化学习技术取得了显著的进展,并在许多领域得到了广泛应用,如游戏、自动驾驶、机器人控制、语音识别等。

在本文中,我们将探讨强化学习在人工智能发展中的重要性和前景。我们将讨论强化学习的核心概念、算法原理、具体操作步骤以及数学模型。此外,我们还将分析一些具体的代码实例,以及未来发展趋势与挑战。

2.核心概念与联系

强化学习的核心概念包括:状态、动作、奖励、策略、值函数等。这些概念在强化学习中具有重要的意义。

2.1 状态(State)

状态是强化学习中的一个基本概念,它表示环境在某个时刻的一个描述。状态可以是数字、字符串、图像等形式。在强化学习中,状态用来描述环境的当前状态,以便于算法做出决策。

2.2 动作(Action)

动作是强化学习中的另一个基本概念,它表示在某个状态下可以采取的行为。动作可以是数字、字符串、图像等形式。在强化学习中,动作用来描述环境在某个状态下可以执行的操作。

2.3 奖励(Reward)

奖励是强化学习中的一个关键概念,它用于评估算法的性能。奖励是环境给出的反馈,用于指导算法学习如何取得最大化的奖励。奖励可以是数字、字符串、图像等形式。

2.4 策略(Policy)

策略是强化学习中的一个关键概念,它用于描述在某个状态下采取哪个动作。策略可以是数字、字符串、图像等形式。在强化学习中,策略用来指导算法在环境中进行决策。

2.5 值函数(Value Function)

值函数是强化学习中的一个关键概念,它用于评估策略的性能。值函数表示在某个状态下采取某个策略下的期望累积奖励。值函数可以是数字、字符串、图像等形式。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

强化学习的核心算法包括:值迭代(Value Iteration)、策略迭代(Policy Iteration)、动态规划(Dynamic Programming)等。这些算法用于解决强化学习问题。

3.1 值迭代(Value Iteration)

值迭代是强化学习中的一个核心算法,它通过迭代地更新值函数来找到最优策略。值迭代的具体操作步骤如下:

- 初始化值函数为零。

- 对于每个状态,计算出期望累积奖励的最大值。

- 更新策略,使得在每个状态下采取的动作是最大化期望累积奖励的动作。

- 重复步骤2和步骤3,直到值函数收敛。

值迭代的数学模型公式如下:

$$ V{k+1}(s) = \max{a} \sum{s'} P(s'|s,a) [R(s,a,s') + \gamma Vk(s')] $$

3.2 策略迭代(Policy Iteration)

策略迭代是强化学习中的另一个核心算法,它通过迭代地更新策略来找到最优策略。策略迭代的具体操作步骤如下:

- 初始化策略为随机策略。

- 对于每个状态,计算出期望累积奖励的最大值。

- 更新策略,使得在每个状态下采取的动作是最大化期望累积奖励的动作。

- 重复步骤2和步骤3,直到策略收敛。

策略迭代的数学模型公式如下:

$$ \pi{k+1}(a|s) = \frac{\exp^{\sum{s'} P(s'|s,a) [R(s,a,s') + \gamma Vk(s')]}}{\sum{a'} \exp^{\sum{s'} P(s'|s,a') [R(s,a',s') + \gamma Vk(s')]}} $$

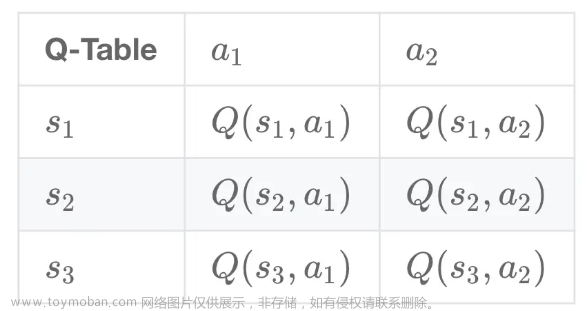

3.3 动态规划(Dynamic Programming)

动态规划是强化学习中的一个核心算法,它用于解决决策过程中的子问题。动态规划的具体操作步骤如下:

- 对于每个状态,计算出期望累积奖励的最大值。

- 对于每个状态和动作,计算出期望累积奖励的最大值。

- 更新策略,使得在每个状态下采取的动作是最大化期望累积奖励的动作。

动态规划的数学模型公式如下:

$$ Q(s,a) = R(s,a,s') + \gamma \max{a'} \sum{s'} P(s'|s,a,a') Q(s',a') $$

4.具体代码实例和详细解释说明

在这里,我们将给出一个具体的强化学习代码实例,并进行详细解释。

4.1 示例代码

```python import numpy as np

初始化环境

env = Environment()

初始化参数

alpha = 0.01 gamma = 0.99 epsilon = 0.1

初始化策略

policy = np.random.rand(env.nstates, env.nactions)

初始化值函数

value = np.zeros(env.n_states)

主循环

for episode in range(num_episodes): state = env.reset() done = False

while not done:

# 随机选择动作

if np.random.uniform() < epsilon:

action = env.action_space.sample()

else:

# 根据策略选择动作

action = np.argmax(policy[state])

# 执行动作

next_state, reward, done, _ = env.step(action)

# 更新值函数

value[state] = value[state] + alpha * (reward + gamma * value[next_state] - value[state])

# 更新策略

policy[state] = policy[state] + alpha * (reward + gamma * np.max(value[next_state]) - np.max(value[state])) * env.transition_prob(state, action, next_state)

# 更新状态

state = next_state输出结果

print("策略:", policy) print("值函数:", value) ```

4.2 解释说明

这个示例代码实现了一个基本的强化学习算法,它使用了策略梯度(Policy Gradient)方法。首先,我们初始化了环境、参数和策略。然后,我们进入主循环,每个循环表示一个episode。在每个episode中,我们从环境中重置状态,并执行以下操作:

- 根据策略选择动作。如果随机数小于epsilon,则随机选择动作;否则,选择策略中状态下最大的动作。

- 执行动作,并获取下一个状态、奖励和是否结束的信息。

- 更新值函数,使用策略梯度方法。

- 更新策略,使用策略梯度方法。

- 更新状态,使用下一个状态。

最后,我们输出策略和值函数。

5.未来发展趋势与挑战

强化学习在过去的几年里取得了显著的进展,但仍然存在一些挑战。未来的发展趋势和挑战包括:

- 数据效率:强化学习需要大量的数据来进行训练,这可能导致计算成本较高。未来的研究应该关注如何降低数据需求,以提高数据效率。

- 算法鲁棒性:强化学习算法在实际应用中的鲁棒性可能不足,这可能导致算法在面对未知情况时表现不佳。未来的研究应该关注如何提高算法的鲁棒性。

- 多任务学习:强化学习可以用于解决单个任务,但在面对多个任务时,算法的性能可能会受到影响。未来的研究应该关注如何提高强化学习算法在多任务学习中的性能。

- 人工智能安全:强化学习算法可能会生成不安全的行为,这可能导致人工智能系统的安全问题。未来的研究应该关注如何确保强化学习算法的安全性。

6.附录常见问题与解答

在这里,我们将给出一些常见问题与解答。

Q1:强化学习与其他人工智能技术的区别是什么?

强化学习与其他人工智能技术的主要区别在于,强化学习通过在环境中进行交互,学习如何取得最大化的奖励。其他人工智能技术,如监督学习、无监督学习、深度学习等,通过对数据的学习,学习如何对数据进行分类、回归等。

Q2:强化学习可以应用于哪些领域?

强化学习可以应用于许多领域,如游戏、自动驾驶、机器人控制、语音识别等。这些领域中的应用包括游戏中的智能玩家、自动驾驶汽车的导航、机器人的动作控制以及语音识别系统的训练等。

Q3:强化学习的挑战包括哪些?

强化学习的挑战包括数据效率、算法鲁棒性、多任务学习和人工智能安全等。这些挑战需要未来的研究关注并解决,以提高强化学习算法的性能和应用范围。文章来源:https://www.toymoban.com/news/detail-828351.html

Q4:强化学习的未来发展趋势是什么?

强化学习的未来发展趋势包括提高数据效率、提高算法鲁棒性、提高多任务学习能力和确保人工智能安全等。这些发展趋势将有助于强化学习算法在更广泛的领域中得到应用,并提高其性能。文章来源地址https://www.toymoban.com/news/detail-828351.html

到了这里,关于强化学习在人工智能的发展中的重要性与前景的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!