前言

在现代软件开发中,与网络通信相关的技术变得愈发重要。Java作为一种强大而灵活的编程语言,提供了丰富的工具和库,用于处理各种网络通信场景。本文将聚焦在Java中使用HttpClient库发送HTTP GET请求,并将服务器的响应数据进行输出,同时加入代理服务器的配置,以应对实际项目中可能遇到的情况。

需求场景

假设我们需要从某个网站上获取特定信息,例如新闻标题、股票数据或者天气信息,并将获取到的数据输出到我们的应用程序或者保存到本地文件中。为了实现这个需求,我们可以使用Java中的HttpClient库来发送HTTP GET请求,并获取服务器的响应数据。

让我们通过一个实际的案例来分享如何使用Java中的HttpClient库爬取股票数据。我们将使用一个简单的股票数据API,通过HTTP GET请求获取股票信息。

目标分析

我们的目标是使用Java中的HttpClient库发送HTTP GET请求,并将服务器的响应数据输出到控制台或者保存到本地文件中。为了实现这个目标,我们需要分析以下几个关键步骤:

- 创建HttpClient实例。

- 创建HTTP GET请求。

- 执行HTTP GET请求,并获取服务器的响应。

- 解析服务器的响应数据。

- 输出响应数据到控制台或者保存到本地文件中。

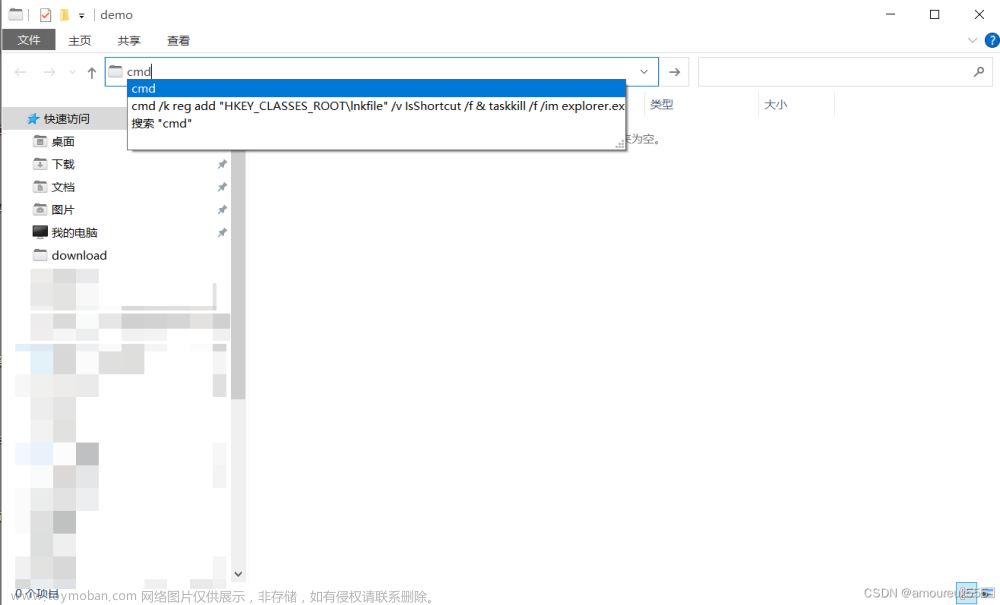

完整代码

下面是完整爬取股票数据的Java代码示例:文章来源:https://www.toymoban.com/news/detail-828476.html

import org.apache.http.HttpHost;

import org.apache.http.HttpResponse;

import org.apache.http.client.HttpClient;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

import java.io.IOException;

public class StockDataCrawler {

public static void main(String[] args) {

// 代理信息

String proxyHost = "www.16yun.cn";

String proxyPort = "5445";

String proxyUser = "16QMSOML";

String proxyPass = "280651";

// 创建HttpClient实例,并设置代理

HttpClient httpClient = HttpClients.custom()

.setProxy(new HttpHost(proxyHost, Integer.parseInt(proxyPort)))

.setDefaultCredentialsProvider(Utils.createProxyCredentialsProvider(proxyUser, proxyPass))

.build();

// 创建HTTP GET请求

HttpGet httpGet = new HttpGet("http://stock-api.example.com/data");

try {

// 执行HTTP GET请求并获取服务器的响应

HttpResponse response = httpClient.execute(httpGet);

// 解析服务器的响应数据

String responseBody = EntityUtils.toString(response.getEntity());

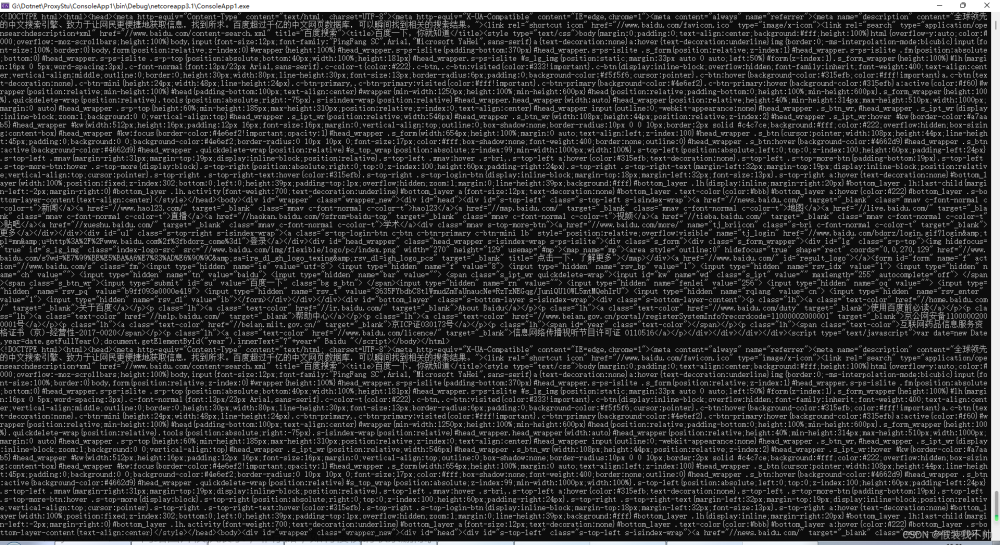

// 输出响应数据到控制台

System.out.println("股票数据响应:");

System.out.println(responseBody);

} catch (IOException e) {

e.printStackTrace();

}

}

}

注意事项

在实际的网络爬取应用中,我们经常会面临各种问题,这些问题可能会影响到爬取任务的稳定性和可靠性。以下是一些常见的问题以及相应的解决方案:文章来源地址https://www.toymoban.com/news/detail-828476.html

- 网络连接超时:在网络爬取过程中,由于网络波动或服务器负载过高等原因,可能会导致网络连接超时。为了解决这个问题,我们可以通过设置适当的连接超时时间来避免长时间等待响应。同时,合理设计重试机制,当连接超时时,可以尝试重新发起请求,提高成功率。

- 服务器错误:有时候服务器可能会出现内部错误或者不可用的情况,这会导致爬取任务失败。针对这种情况,我们可以通过监控服务器返回的状态码来判断服务器的可用性,当遇到5xx系列的状态码时,可以暂时停止爬取并记录错误信息,等待服务器恢复正常后再次尝试。

- 响应数据格式不一致:不同的网站或API返回的数据格式可能会有所不同,这可能会导致我们的爬取代码无法正确解析响应数据。为了应对这种情况,我们可以编写灵活的数据解析代码,使用通用的数据处理工具库,例如JSON解析库或者HTML解析器,来处理不同格式的响应数据。另外,建议在解析数据之前先进行数据格式验证,确保数据的完整性和正确性。

- 反爬机制:一些网站为了防止被爬虫过度访问,会采取一些反爬虫策略,例如IP封锁、验证码、请求频率限制等。要应对这些反爬机制,我们可以采用一些策略来规避,例如设置合理的爬取频率、使用代理IP进行请求、模拟人类操作行为等。同时,我们也需要注意遵守网站的爬取规则,尊重网站的服务协议,避免对服务器造成过大的负担。

到了这里,关于HttpClient:HTTP GET请求的服务器响应输出的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!