1.背景介绍

在大数据处理领域,流处理和批处理是两个非常重要的领域。Apache Flink 是一个流处理框架,Apache Airflow 是一个工作流管理器。在实际应用中,我们可能需要将这两个系统集成在一起,以实现更高效的数据处理和管理。本文将详细介绍 Flink 与 Airflow 的集成方法,并提供一些实际的最佳实践和案例。

1. 背景介绍

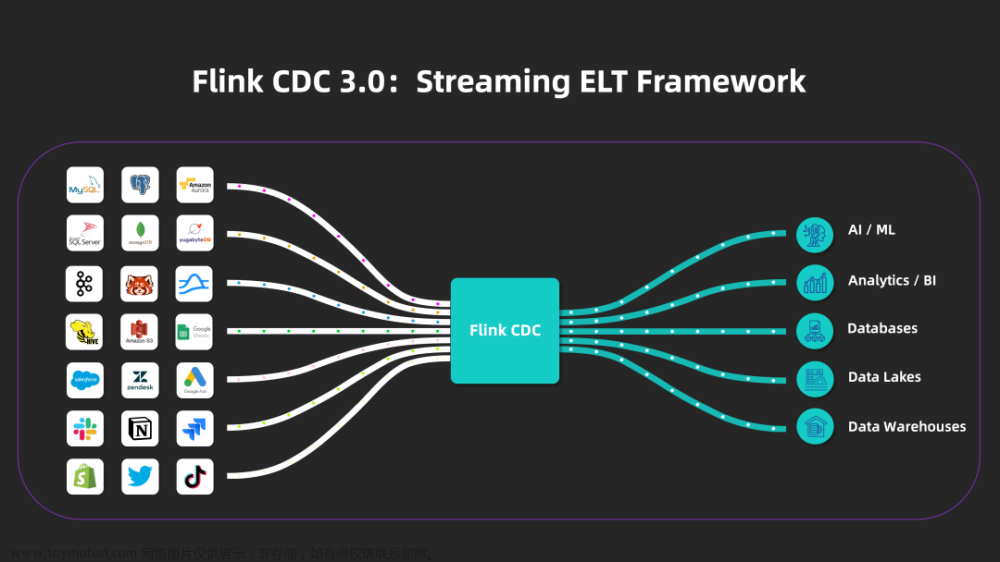

Apache Flink 是一个流处理框架,用于实时数据处理和分析。它支持大规模数据流处理,具有低延迟和高吞吐量。Flink 提供了一系列的流处理算法,如窗口操作、连接操作等,可以用于处理复杂的流数据。

Apache Airflow 是一个工作流管理器,用于自动化和管理数据处理任务。Airflow 支持各种类型的任务,如批处理任务、流处理任务等。Airflow 提供了一个用于定义、调度和监控任务的界面,可以帮助用户更好地管理和优化数据处理任务。

在实际应用中,Flink 和 Airflow 可以相互补充,实现更高效的数据处理和管理。例如,Flink 可以用于实时处理和分析数据,而 Airflow 可以用于自动化和管理这些任务。

2. 核心概念与联系

在 Flink 与 Airflow 的集成中,我们需要了解一些核心概念和联系。

2.1 Flink 核心概念

- 数据流(Stream):Flink 中的数据流是一种无限序列,每个元素都是一条数据记录。数据流可以通过各种流操作(如映射、筛选、连接等)进行处理。

- 数据源(Source):Flink 中的数据源是用于生成数据流的来源。例如,可以从 Kafka 主题、文件系统、数据库等获取数据。

- 数据接收器(Sink):Flink 中的数据接收器是用于接收处理后的数据流的目的地。例如,可以将数据写入 HDFS、Kafka 主题、数据库等。

- 流操作(Stream Operation):Flink 中的流操作是用于对数据流进行处理的操作。例如,映射、筛选、连接、窗口等。

2.2 Airflow 核心概念

- Directed Acyclic Graph(DAG):Airflow 中的 DAG 是一个有向无环图,用于表示工作流中的任务和依赖关系。每个节点表示一个任务,每条边表示一个依赖关系。

- 任务(Task):Airflow 中的任务是一个可执行的单元,可以是批处理任务、流处理任务等。任务可以通过 DAG 来定义和调度。

- 执行器(Executor):Airflow 中的执行器是用于执行任务的进程。执行器可以是本地执行器、远程执行器等。

- 调度器(Scheduler):Airflow 中的调度器是用于调度任务执行的组件。调度器根据 DAG 的依赖关系和执行策略,生成任务执行计划。

2.3 Flink 与 Airflow 的联系

Flink 与 Airflow 的集成可以实现以下功能:

- 流处理任务的自动化管理:通过将 Flink 流处理任务定义为 Airflow 的任务,可以实现任务的自动化调度和监控。

- 数据流的可视化:通过将 Flink 数据流与 Airflow 的 DAG 相结合,可以实现数据流的可视化,方便用户查看和调试。

- 数据处理的扩展性:通过将 Flink 与 Airflow 集成,可以实现更高效的数据处理和管理,支持更多的数据源和接收器。

3. 核心算法原理和具体操作步骤以及数学模型公式详细讲解

在 Flink 与 Airflow 的集成中,我们需要了解一些核心算法原理和具体操作步骤。

3.1 Flink 流处理算法原理

Flink 流处理算法主要包括以下几种:

- 映射(Map):将数据流中的每个元素映射到一个新的元素。

- 筛选(Filter):从数据流中筛选出满足条件的元素。

- 连接(Join):将两个数据流进行连接,根据某个键进行分组和匹配。

- 窗口(Window):将数据流划分为一定大小的窗口,对窗口内的数据进行聚合。

3.2 Airflow 工作流管理算法原理

Airflow 工作流管理算法主要包括以下几种:

- 任务调度:根据 DAG 的依赖关系和执行策略,生成任务执行计划。

- 任务执行:根据执行计划,执行任务。

- 任务监控:监控任务执行状态,并在出现问题时发出警告。

3.3 Flink 与 Airflow 集成算法原理

Flink 与 Airflow 的集成算法原理是将 Flink 的流处理算法与 Airflow 的工作流管理算法相结合,实现流处理任务的自动化管理、数据流的可视化和数据处理的扩展性。

具体操作步骤如下:

- 定义 Flink 流处理任务,包括数据源、数据接收器和流操作。

- 将 Flink 流处理任务定义为 Airflow 的任务,包括任务类型、任务参数、任务配置等。

- 将 Flink 数据流与 Airflow 的 DAG 相结合,实现数据流的可视化。

- 使用 Airflow 的调度器和执行器,实现流处理任务的自动化调度和监控。

4. 具体最佳实践:代码实例和详细解释说明

以下是一个 Flink 与 Airflow 集成的具体最佳实践示例:

4.1 Flink 流处理任务定义

```python from flink import StreamExecutionEnvironment from flink import DataStream

env = StreamExecutionEnvironment.getexecutionenvironment() env.set_parallelism(1)

定义数据源

datasource = DataStream(env.fromelements([1, 2, 3, 4, 5]))

定义流操作

result = data_source.map(lambda x: x * 2).print()

env.execute("Flink Streaming Job") ```

4.2 Airflow 任务定义

```python from airflow import DAG from airflow.operators.pythonoperator import PythonOperator from airflow.utils.dates import daysago

defaultargs = { 'owner': 'airflow', 'startdate': days_ago(1), }

dag = DAG( 'flinkairflowexample', defaultargs=defaultargs, description='Flink with Airflow example', schedule_interval=None, )

def flink_task(**kwargs): # 调用 Flink 流处理任务 # ...

flinktask = PythonOperator( taskid='flinktask', pythoncallable=flink_task, dag=dag, )

flink_task ```

4.3 Flink 与 Airflow 集成

在 Flink 与 Airflow 的集成中,我们可以将 Flink 的流处理任务定义为 Airflow 的任务,并将 Flink 数据流与 Airflow 的 DAG 相结合。这样,我们可以实现流处理任务的自动化管理、数据流的可视化和数据处理的扩展性。

5. 实际应用场景

Flink 与 Airflow 的集成可以应用于各种场景,例如:

- 实时数据处理:将 Flink 用于实时数据处理,并将处理结果存储到 HDFS、Kafka 等数据库。

- 数据流分析:将 Flink 用于数据流分析,并将分析结果展示到 Airflow 的 DAG 中,实现数据流的可视化。

- 数据处理管理:将 Flink 与 Airflow 集成,实现数据处理任务的自动化管理,提高数据处理效率。

6. 工具和资源推荐

在 Flink 与 Airflow 的集成中,可以使用以下工具和资源:

7. 总结:未来发展趋势与挑战

Flink 与 Airflow 的集成是一种有前途的技术,可以实现流处理任务的自动化管理、数据流的可视化和数据处理的扩展性。在未来,我们可以期待 Flink 与 Airflow 的集成技术不断发展,实现更高效的数据处理和管理。

挑战:

- 性能优化:Flink 与 Airflow 的集成可能会导致性能问题,例如任务执行延迟、资源占用等。我们需要不断优化和提高 Flink 与 Airflow 的性能。

- 兼容性:Flink 与 Airflow 的集成可能会导致兼容性问题,例如不同版本的 Flink 和 Airflow 之间的兼容性。我们需要确保 Flink 与 Airflow 的集成具有良好的兼容性。

- 安全性:Flink 与 Airflow 的集成可能会导致安全性问题,例如数据泄露、权限管理等。我们需要确保 Flink 与 Airflow 的集成具有良好的安全性。

8. 附录:常见问题与解答

Q:Flink 与 Airflow 的集成有什么好处? A:Flink 与 Airflow 的集成可以实现流处理任务的自动化管理、数据流的可视化和数据处理的扩展性。

Q:Flink 与 Airflow 的集成有哪些挑战? A:Flink 与 Airflow 的集成可能会导致性能问题、兼容性问题和安全性问题。我们需要不断优化和提高 Flink 与 Airflow 的性能、兼容性和安全性。

Q:Flink 与 Airflow 的集成有哪些应用场景? A:Flink 与 Airflow 的集成可以应用于实时数据处理、数据流分析和数据处理管理等场景。文章来源:https://www.toymoban.com/news/detail-828626.html

Q:Flink 与 Airflow 的集成有哪些工具和资源? A:Flink 与 Airflow 的集成可以使用 Flink 官方文档、Airflow 官方文档、Flink 与 Airflow 集成教程、Flink 与 Airflow 集成例子等工具和资源。文章来源地址https://www.toymoban.com/news/detail-828626.html

到了这里,关于Flink与ApacheAirflow集成的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!