1.背景介绍

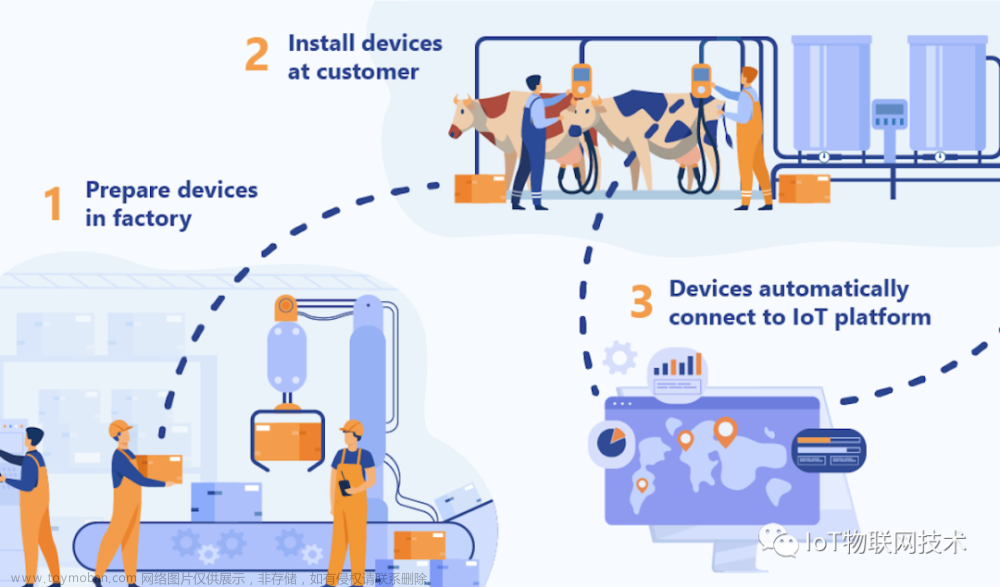

视频场景识别技术是一种人工智能技术,它可以从视频中识别出场景信息,例如:室内、室外、道路、森林等。这种技术在智能家居和智能城市应用中具有重要意义。在智能家居中,视频场景识别技术可以用于智能家居系统的控制和管理,例如根据场景自动调节灯光、空调、音乐等。在智能城市中,视频场景识别技术可以用于交通管理、安全监控、环境监测等方面。

本文将从以下六个方面进行阐述:

- 背景介绍

- 核心概念与联系

- 核心算法原理和具体操作步骤以及数学模型公式详细讲解

- 具体代码实例和详细解释说明

- 未来发展趋势与挑战

- 附录常见问题与解答

1.1 背景介绍

视频场景识别技术的发展与计算机视觉、深度学习等领域的进步紧密相关。近年来,随着计算能力的提升和数据量的增加,深度学习技术在计算机视觉领域取得了显著的成果。同时,随着人们对智能家居和智能城市的需求不断增加,视频场景识别技术也逐渐成为一个热门的研究方向。

视频场景识别技术的主要应用场景包括:

- 智能家居:根据用户的行为和环境信息,自动调节家居设备,提高用户的生活质量。

- 智能城市:通过监控城市的视频流,实现交通管理、安全监控、环境监测等功能,提高城市的安全和绿色度。

- 安全监控:识别异常行为,提供安全保障。

- 娱乐行业:制作特效、动画等。

在这些应用场景中,视频场景识别技术的核心是识别场景信息,并根据场景信息进行相应的处理。为了实现这一目标,需要对计算机视觉和深度学习等相关技术有所了解。

2. 核心概念与联系

在本节中,我们将介绍视频场景识别技术的核心概念和联系。

2.1 计算机视觉

计算机视觉是计算机科学和人工智能领域的一个分支,研究如何让计算机理解和处理图像和视频。计算机视觉的主要任务包括:图像分类、目标检测、目标识别、场景识别等。

计算机视觉的核心技术包括:

- 图像处理:包括图像的增强、压缩、分割等操作。

- 特征提取:包括边缘检测、颜色分析、形状描述等方法。

- 机器学习:包括支持向量机、决策树、神经网络等算法。

- 深度学习:包括卷积神经网络、递归神经网络、自然语言处理等技术。

2.2 深度学习

深度学习是计算机科学和人工智能领域的一个分支,研究如何让计算机通过模拟人类大脑的学习过程来进行自主学习。深度学习的主要任务包括:图像识别、语音识别、自然语言处理等。

深度学习的核心技术包括:

- 卷积神经网络(CNN):一种特殊的神经网络,主要应用于图像和声音等空间数据的处理。

- 递归神经网络(RNN):一种能够处理序列数据的神经网络,主要应用于自然语言处理等领域。

- 生成对抗网络(GAN):一种生成模型,可以生成新的数据样本。

- 自然语言处理(NLP):一种通过计算机处理自然语言的技术,主要应用于机器翻译、情感分析、语音识别等领域。

2.3 视频场景识别与计算机视觉和深度学习的联系

视频场景识别技术是计算机视觉和深度学习的一个应用领域,它利用计算机视觉和深度学习的技术来识别视频中的场景信息。具体来说,视频场景识别技术可以使用计算机视觉的特征提取方法来提取视频帧中的特征,然后使用深度学习的算法来分类和识别场景。

在后续的内容中,我们将详细介绍视频场景识别技术的核心算法原理和具体操作步骤以及数学模型公式详细讲解。

3. 核心算法原理和具体操作步骤以及数学模型公式详细讲解

在本节中,我们将介绍视频场景识别技术的核心算法原理和具体操作步骤以及数学模型公式详细讲解。

3.1 核心算法原理

视频场景识别技术的核心算法原理是基于深度学习,特别是卷积神经网络(CNN)。CNN是一种特殊的神经网络,主要应用于图像和声音等空间数据的处理。CNN的主要特点是:

- 卷积层:对输入的图像数据进行卷积操作,以提取图像的特征。

- 池化层:对卷积层的输出进行下采样操作,以减少特征维度。

- 全连接层:将池化层的输出进行全连接,以进行分类和识别。

在视频场景识别中,我们可以将视频帧看作是一个序列的图像数据,可以使用CNN对每一帧进行特征提取,然后将这些特征作为输入进行场景识别。

3.2 具体操作步骤

具体来说,视频场景识别技术的具体操作步骤包括:

- 数据预处理:将视频转换为帧序列,并对帧进行预处理,例如缩放、裁剪等。

- 特征提取:使用CNN对每一帧进行特征提取,得到每一帧的特征向量。

- 场景识别:将每一帧的特征向量输入到全连接层,进行分类和识别,得到场景标签。

- 结果输出:将场景标签输出,并进行结果评估。

3.3 数学模型公式详细讲解

在这里,我们将详细介绍CNN的数学模型公式。

3.3.1 卷积层

卷积层的数学模型公式为:

$$ y(i,j) = \sum{p=0}^{P-1} \sum{q=0}^{Q-1} x(i-p,j-q) \cdot k(p,q) $$

其中,$x(i,j)$ 表示输入图像的像素值,$k(p,q)$ 表示卷积核的像素值。$P$ 和 $Q$ 分别表示卷积核的宽度和高度。

3.3.2 池化层

池化层的数学模型公式为:

$$ y(i,j) = \max_{p,q} x(i-p,j-q) $$

其中,$x(i,j)$ 表示输入图像的像素值,$y(i,j)$ 表示池化层的输出像素值。

3.3.3 全连接层

全连接层的数学模型公式为:

$$ y = \sum{i=1}^{n} wi x_i + b $$

其中,$xi$ 表示输入神经元的输出,$wi$ 表示权重,$b$ 表示偏置。

在视频场景识别中,我们可以将这些公式应用于视频帧的特征提取和场景识别。具体来说,我们可以将视频帧的特征向量作为输入,并使用这些公式进行特征提取和场景识别。

4. 具体代码实例和详细解释说明

在本节中,我们将介绍一个具体的视频场景识别代码实例,并详细解释说明其中的过程。

4.1 代码实例

我们将使用Python和TensorFlow来实现一个简单的视频场景识别模型。首先,我们需要导入所需的库:

python import tensorflow as tf from tensorflow.keras import layers, models

接下来,我们需要加载和预处理视频数据:

```python

加载视频数据

videodata = loadvideo_data()

预处理视频数据

videodata = preprocessvideodata(videodata) ```

然后,我们可以定义一个简单的CNN模型:

```python

定义CNN模型

model = models.Sequential() model.add(layers.Conv2D(32, (3, 3), activation='relu', inputshape=(224, 224, 3))) model.add(layers.MaxPooling2D((2, 2))) model.add(layers.Conv2D(64, (3, 3), activation='relu')) model.add(layers.MaxPooling2D((2, 2))) model.add(layers.Conv2D(128, (3, 3), activation='relu')) model.add(layers.MaxPooling2D((2, 2))) model.add(layers.Flatten()) model.add(layers.Dense(512, activation='relu')) model.add(layers.Dense(numclasses, activation='softmax')) ```

接下来,我们可以编译和训练模型:

```python

编译模型

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

训练模型

model.fit(videodata, epochs=10, batchsize=32) ```

最后,我们可以使用模型进行场景识别:

```python

使用模型进行场景识别

scene_label = model.predict(frame) ```

4.2 详细解释说明

在这个代码实例中,我们首先导入了所需的库,包括TensorFlow和Keras。然后,我们加载和预处理了视频数据。接下来,我们定义了一个简单的CNN模型,包括卷积层、池化层和全连接层。我们使用ReLU作为激活函数,并将输入的图像大小设置为224x224x3。

接下来,我们编译了模型,使用Adam优化器和交叉熵损失函数。然后,我们训练了模型,使用视频数据作为输入,并设置了10个周期和32个批次大小。

最后,我们使用模型进行场景识别,将输入的帧作为输入,并得到场景标签。

5. 未来发展趋势与挑战

在本节中,我们将介绍视频场景识别技术的未来发展趋势与挑战。

5.1 未来发展趋势

- 深度学习模型优化:随着深度学习模型的不断发展,我们可以期待更高效、更准确的视频场景识别模型。

- 多模态融合:将视频场景识别与其他模态(如音频、文本等)的技术进行融合,以提高识别的准确性和效率。

- 边缘计算:将视频场景识别模型部署到边缘设备上,以实现实时的场景识别和分析。

- 个性化化:根据用户的需求和偏好,提供更个性化的场景识别服务。

5.2 挑战

- 大量计算资源:视频场景识别模型的训练和部署需要大量的计算资源,这可能限制了其实际应用。

- 数据不均衡:视频数据集中可能存在数据不均衡的问题,这可能影响模型的性能。

- 场景识别的泛化能力:视频场景识别模型可能无法泛化到未见过的场景中,这可能限制了其实际应用。

- 隐私保护:视频场景识别技术可能涉及到用户隐私信息的处理,这可能引发隐私保护的问题。

6. 附录常见问题与解答

在本节中,我们将介绍视频场景识别技术的一些常见问题与解答。

6.1 问题1:如何提高视频场景识别模型的准确性?

答案:可以尝试以下方法来提高模型的准确性:

- 使用更大的数据集进行训练,以提高模型的泛化能力。

- 使用更复杂的模型结构,以提高模型的表达能力。

- 使用更好的数据预处理方法,以提高模型的输入质量。

6.2 问题2:如何减少视频场景识别模型的计算成本?

答案:可以尝试以下方法来减少模型的计算成本:

- 使用量化方法来减少模型的参数数量,如整数化、二进制化等。

- 使用裁剪方法来减少模型的权重数量,以保留模型的性能。

- 使用知识迁移方法来将更复杂的模型迁移到更简单的模型中,以保留模型的性能。

6.3 问题3:如何解决视频场景识别模型的过拟合问题?

答案:可以尝试以下方法来解决模型的过拟合问题:

- 使用正则化方法,如L1正则化、L2正则化等,以防止模型过拟合。

- 使用Dropout方法,以防止模型过拟合。

- 使用更小的数据集进行训练,以防止模型过拟合。

7. 结论

在本文中,我们介绍了视频场景识别技术的背景介绍、核心概念与联系、核心算法原理和具体操作步骤以及数学模型公式详细讲解、具体代码实例和详细解释说明、未来发展趋势与挑战等内容。我们希望这篇文章能够帮助读者更好地理解视频场景识别技术,并为未来的研究和应用提供一定的启示。

8. 参考文献

[1] K. Simonyan and A. Zisserman. Two-stream convolutional networks for action recognition in videos. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 343–351, 2014.

[2] T. Donahue, J. Hinton, and G. E. Dahl. Long-term recurrent convolutional networks for visual recognition. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 1036–1043, 2014.

[3] K. He, G. Zhang, R. Ren, and J. Sun. Deep residual learning for image recognition. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 770–778, 2016.

[4] S. Redmon, A. Farhadi, K. Krafka, and R. Darrell. You only look once: real-time object detection with region proposals. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 776–782, 2016.

[5] A. Krizhevsky, I. Sutskever, and G. E. Hinton. ImageNet classification with deep convolutional neural networks. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 109–116, 2012.文章来源:https://www.toymoban.com/news/detail-829000.html

[6] Y. LeCun, Y. Bengio, and G. Hinton. Deep learning. Nature, 433(7028):245–249, 2009.文章来源地址https://www.toymoban.com/news/detail-829000.html

到了这里,关于视频场景识别技术:智能家居与智能城市应用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!