Cai, Y., Ge, L., Liu, J., Cai, J., Cham, T.-J., Yuan, J., & Magnenat-Thalmann, N. (2019). Exploiting spatial-temporal relationships for 3D pose estimation via graph convolutional networks. IEEE International Conference on Computer Vision, 2272–2281. https://doi.org/10.1109/ICCV.2019.00236

利用图卷积网络(Graph Convolutional Networks)来通过空间-时间关系进行3D姿势估计

尽管在从单视图图像或视频进行的3D姿势估计方面取得了巨大的进展,但由于存在显著的深度模糊和严重的自遮挡,这仍然是一项具有挑战性的任务。受到将空间依赖性和时间一致性纳入以缓解这些问题的有效性的启发,我们提出了一种新颖的基于图的方法,以解决从短序列的2D关节检测中进行3D人体和3D手部姿势估计的问题。特别地,关于人手(身体)配置的领域知识被明确地整合到图卷积操作中,以满足3D姿势估计的特定需求。此外,我们引入了一个局部到全局的网络架构,能够学习用于基于图的表示的多尺度特征。我们在具有挑战性的基准数据集上评估了所提出的方法,用于3D手部姿势估计和3D身体姿势估计。实验结果表明,我们的方法在两项任务上均取得了最先进的性能。

图1。图示了(a)完整人体和(b)人手之间的图形空间-时间依赖关系。时间边连接相邻帧之间的相同关节,而空间边表示每个帧的自然连接。为了简单起见,我们仅在空间-时间图的前帧上绘制了整个空间连接,包括直接的物理连接(实线)和间接的“对称”关系(虚线曲线)。我们使用颜色对关节进行编码,以显示人体(手)的不同部分。

图2。我们提出的用于从连续2D姿势估计3D姿势的网络架构的示意概述。输入是从RGB图像估计得到的少量相邻2D姿势,输出是目标帧的3D关节位置。我们在骨架序列上构建一个空间-时间图,并设计了一个层次化的“局部到全局”架构,其中包含图卷积操作,以有效处理和 consol feature 在不同尺度上。为了进一步改进估计结果,应用了一个可以与图卷积网络一起进行端到端训练的姿势细化过程。请注意,这个流程适用于3D人体和手部姿势估计,这里我们只是以3D人体姿势估计为可视化示例。

图3。可视化了(a)人体和(b)人手的不同邻近节点。邻近节点根据它们的语义含义分为六类:中心节点(蓝色),包括比骨架根节点更近(紫色)和比骨架根节点更远(绿色)的物理连接节点,间接“对称”相关节点(深蓝色),时间向前节点(黄色)和时间向后节点(橙色)。

图4。展示了“局部到全局”网络架构的示意图,该架构能够有效地处理和整合不同尺度上的特征。为了方便说明,我们仅在空间-时间图的前帧上绘制了整个空间连接。

图5。定义的分层图池化策略,适用于(a)人体和(b)人手。给定每帧的原始图结构,我们首先根据可解释的骨架结构将节点划分为各个子集,这些子集用相同的颜色表示,然后在每个子集上执行最大池化操作。接下来,缩小的图被最大池化成一个节点,其中包含整个骨架的全局信息。请注意,在随后的自顶向下处理中,上采样被执行为所提出的池化的反向操作,将较粗图中的顶点的特征分配给较细图中的其子顶点。文章来源:https://www.toymoban.com/news/detail-829083.html

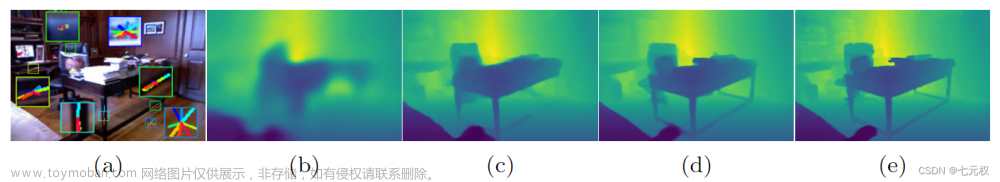

图7。我们提出的方法在Human3.6M和STB数据集上的视觉结果。第一行:Human3.6M [18]。第二行:STB [52]。请注意,为了方便比较,骨架以新的视角显示。文章来源地址https://www.toymoban.com/news/detail-829083.html

到了这里,关于Exploiting Spatial-temporal Relationships for 3D Pose Estimation via Graph Convolutional Networks的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!