Hive切换引擎(MR、Tez、Spark)

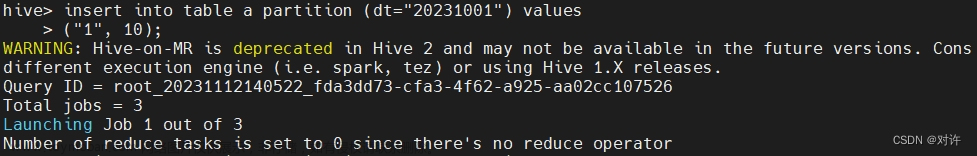

1. MapReduce计算引擎(默认)

set hive.execution.engine=mr;

2. Tez引擎

set hive.execution.engine=tez;

1. Spark计算引擎

set hive.execution.engine=spark;

文章来源地址https://www.toymoban.com/news/detail-829323.html

文章来源:https://www.toymoban.com/news/detail-829323.html

到了这里,关于Hive切换引擎(MR、Tez、Spark)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!