OpenAI关于Sora的技术概要

OpenAI官网介绍:Video generation models as world simulators

OpenAI尝试在视频数据上探索生成模型的大规模训练,研究结果表明,尺度可变视频生成模型是构建物理世界通用模拟器的有希望的途径。(可变的视频时长、帧分辨率和长宽比)

OpenAI从大型语言模型(LLM)中获得灵感,LLM通过对互联网规模级别数据的训练获得了通用且强大的能力。LLM范式的成功部分得益于使用标记块(token,作为符号系统的最小单位),token优雅地统一了不同类型的文本:代码、数学和各种自然语言。

与此对应,Sora有视觉块(patch,统一图像数据的最小单位)。之前的实践表明patch是视觉数据模型的有效的表示。通过实际的训练,OpenAI发现,对于训练不同类型的视频和图像的生成模型,patch是一种高度可扩展的有效表示。

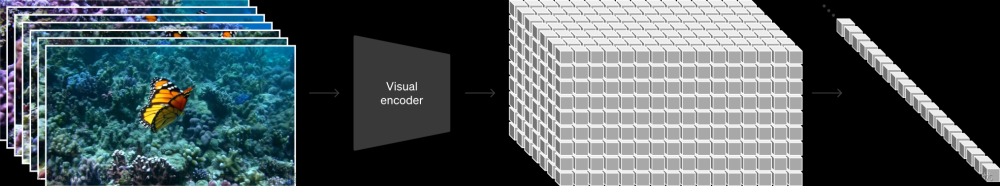

OpenAI训练一个网络来降低视觉数据的维数,该网络将原始视频作为输入,输出时间和空间上都压缩的潜在表示。Sora在这个低维度的潜在空间中训练。还训练了一个相应的解码模型,该模型将潜在表示映射回像素空间(像素自然的组成视频)。

给定一个压缩的输入视频,提取压缩的时空patch序列,作为Transformer的token输入。这个方案也适用于图像,因为图像只是单帧的视频。基于patch表示使Sora能够在不同分辨率、时长和宽高比的视频和图像上进行训练。在推断时,可以通过在适当大小的网格中安排随机的补丁来控制生成视频的大小。

潜在表示空间的patch作为输入,可以随机插入patch增加输出大小,Transformer本身可以处理可变的输入,变为可变长的输出,可以认为输出长度是输入长度的函数。

比如通过在一个时间范围为一帧的空间网格中排列高斯噪声块来生成可变大小的图像,Sora最高可达2048 × 2048分辨率。

深度学习分为两个阶段:根据目标反向学习 和 根据输入前向推断/推理,对应于训练和使用。

Sora基于扩散模型:给定输入的噪声(随机化生成的)patches(以及条件信息,比如说根据特定文本生成视频),它被训练来预测原始的“干净”块。重要的是,Sora是一个扩散Transformer,Transformer已经在许多领域展示了显著的缩放特性,包括语言建模、计算机视觉和图像生成。

过去的图像和视频生成方法通常是调整、裁剪或修剪视频到标准尺寸,例如,4秒256x256分辨率的视频。相反,OpenAI发现在原始大小的数据上进行训练提供了几个好处。

- 采样的灵活性:Sora可以采样介于1920x1080p和1080x1920之间的所有视频。这让Sora可以直接以不同设备的原始宽高比为其创建内容。它还能在生成全分辨率的内容之前,以较小的尺寸快速创建内容原型——所有内容都使用相同的模型。

- 改进框架和构图:实践发现,在视频的原始长宽比上进行训练可以改善构图和框架。在正方形裁剪上训练的模型(这是训练视频生成模型时的常见做法)有时会生成仅显示部分主题的视频。相比之下,来自Sora的视频显示更完整。

另外,训练文本到视频生成系统需要大量带有相应文本说明的视频。可以将DALL·E3中介绍的再描述技术(re-captioning technique)应用到视频中:首先训练描述模型,然后使用它为训练集中的所有视频生成文本描述。在这样的视频描述上进行训练 可以提高 文本保真度以及视频的整体质量。

与DALL·E3类似,还利用GPT将简短的用户提示转换为更长的详细字幕,并将其发送到视频模型。这使得Sora能够准确地按照用户提示生成高质量的视频。

Sora也可以通过其他输入进行提示,比如预先存在的图像或视频。这种功能使Sora能够执行广泛的图像和视频编辑任务:创建完美的循环视频,通过静态图像产生动画,向前或向后扩展视频等。

图片和视频本身可以被转化为潜在表示,可以直接输入到Sora(扩散Transformer)中

视频模型在大规模训练时表现出许多有趣的涌现能力。这些能力使Sora能够模拟人、动物和现实环境的某些方面。这些属性在没有任何关于3D、物体等的明确归纳偏好的情况下涌现——它们纯粹是因为大尺度产生现象。

机器学习算法在学习过程中对某种类型假设的偏好,称为“归纳偏好”(inductive bias),或简称为“偏好”。

这里意在表达没有任何额外的设计,任何设计无疑会引入函数空间的偏好。

Sora可以生成带有动态摄像机运动的视频。随着摄像机的移动和旋转,人物和场景元素在三维空间中始终如一地移动。

视频生成系统面临的一个重大挑战是在长视频采样时保持时间一致性。Sora经常(虽然不是总是)能够有效地为短期和长期依赖关系建模。例如,可以保存人物、动物和物体,即使它们被遮挡或离开了框架。同样,它可以在单个样本中生成同一角色的多个镜头,在整个视频中保持其外观。

Sora有时可以用简单的方式模拟影响世界状态的行为。例如,画家可以在画布上留下新的笔触,随着时间的推移,或者一个人吃汉堡时留下咬痕。

Sora还能够模拟虚拟过程,比如视频游戏。Sora 可以通过一个基本策略同时控制 Minecraft 中的玩家,同时还能以高保真度渲染世界及其动态。通过提示 Sora 有关“Minecraft”的标题,可以无示例(zero-shot)地引发这些功能。

这些能力表明,视频模型的持续扩展是开发高度功能强大的物理和数字世界以及其中存在的物体、动物和人的模拟器的有前途的途径。

Sora目前作为模拟器存在许多局限性。例如,它无法准确地模拟许多基本交互的物理效果,比如玻璃破碎。其他交互,比如吃东西,并不总是能正确地改变对象的状态,比如在长时间样本中发展出的不一致性或物体的自发出现。

我们的目光所及,只是不远的前方,但是可以看到,那里有许多工作要做。

——Alan Turing

世界模型和未来

未知是最大的恐惧

意识、问题与语言 - 知乎从内在的视角讨论了人的世界模型,分析了语言可能存在的缺陷,这里更多的从计算、AI工程的角度来讨论世界模型。

可以看到Sora虽然惊人,但是AI领域还是需要更多新的突破。Sora展现了人工神经网络的惊人能力,展现了差异很大的结构(图像数据和文本数据)如何在计算上被统一的算法解决,这种涌现能力确实会让认为只有进一步研究脑才能得出终极AI的人感到惊奇——虽然还不至于彻底改变研究脑的处境。

很容易被人忽视的是,所谓视觉数据和文本数据究竟意味着什么?至少以目前情况来看,这二者都是依赖于外在的视角——即人或者其它类似之物。视觉数据和文本数据在计算机内部的处理都是以数的形式,只有通过显示器发出信号,然后被人接受,这二者才产生这样的差异。

在计算机内部这二者的差异只是不同模型、不同的处理方式——应当看到这有一种惊人的对应,在脑的结构上,身体隔绝了外在世界,使得进入脑内部的数据都是电信号,对于脑来说,视觉数据和文本数据的差别也只能是源于处理方式和数据本身所在空间模式的差异,当然,这样的说明无疑是不令人满意的,在不接受头脑中的小人之后,需要对脑的进一步研究。

另一种对应在于,有人认为脑的结构也表明存在一种通用的处理方法来处理不同的感官,深度学习似乎表明可以通过一个单独的模块处理一种感官输入,然后映射到低维空间,在低维空间上进行预测和运动,低维空间的元素就对应意识感知到的东西,这些模块的算法很可能是公共的,即使它们处理不同的感官数据。

怎么才能把不同的感官、模型连接起来?毕竟人类感知到语言、视觉、声音、触觉是紧密结合的,不过不能事先认为这一定是统一的,视觉空间和触觉空间有着一定的独立性,对于婴儿来说这有可能不是统一的,而是通过运动来实现,以及行为主义原则——经常一起出现,就产生了联系。

实践着手眼协作的儿童试图抓住他们够不着的对象;只是渐渐地,他们才或多或少正确地判断出距离。当我们抓不住对象时,在视感觉和为使对象处于我们够得着的范围内所必须的路程之间,一种新的相互联接就开始产生作用了。陌生的情况甚至会使成年人犯错误——例如,他们会错误地估计对象在水中的深度。遥远的距离永远处在常识的范围以外。唯有科学才能使我们确信,太阳比月亮离我们更远。

——《物的分析 / The Analysis of Matter》Bertrand Russell

可以把不同感官看成不同且独立的模型,这些模型之间只需要通过某些接口来进行交流,其中语言模型和其他模型的交流是最多、最频繁的。

一个日常事件的分析

拿以下事件作为例子:看到一个苹果,想到‘苹果’这个词,感到饥饿,产生进食欲望,知道‘苹果能吃’,通过运动来抓住这个苹果,最后吃掉这个苹果,感到饱腹感、停止进食。

这一件事展现了语言、触觉、视觉、运动和情绪感知之间的密切联系。

如果不认为头脑里面有个小人,看到苹果本身是完全不在当前的理论描述之内的事情,看到是脑活动制造的一种东西,脑只是接受信息,然后制造出低维的视觉空间,再制造出‘看到’这样的概念。人类也并不只是看到一个苹果,而是一个视觉世界,苹果只是作为现在关注的视觉中心,苹果是低维视觉空间的一个复合的几何体。

在视觉空间的物体可以自然的引出语言的描述,这是视觉模型到语言模型的路径,也能反过来从语言模型到视觉模型。

就计算的层面来讲,大模型已经能做到语言转入到图像和视频,从视频和图像输入也能得到语言,从图像和视频得到语言,这恰好是人类经常做的事,人类越来越多地使用语言来描述一个场景、生活中的一件事。这里发生的事情,脑和深度学习有着类似之处,都是通过同时输入视觉数据和语言数据来进行二者的关联学习。

但人类的知觉是一个持续的过程,相比较而言,至少从目前没有人能指出人工神经网络的计算中哪里发生了持续的事,反而只是快速的计算,也没有整体性的东西。

至于感到饥饿,这有可能是由于当前的场景触发的,但终归是身体模型的一个元素,这样一件身体模型的事会通过某种途径影响行为模型,脑很有可能是通过记忆来做到这一点,感到饥饿会引起搜索,比如视觉空间的搜索,视觉模型的搜索依赖于知识,大脑有可能是通过记忆来表达这样的知识,这些知识记忆和语言模型又是密切相关的。

视觉模型搜寻的结果和身体模型的输出可以发送给行为模型,行为模型这可以采取行动,这就意味着,身体、行为和视觉模型之间有了交互型,饥饿是身体模型的一件事,身体的运动这是一件行为模型的事,身体的运动又会导致视觉模型的外界输入的变化,这会影响视觉模型。

最终运动使得身体拿到了苹果,并完成了进食,此时引入了触觉模型,和视觉模型一样,触觉模型和其它模型也是紧密结合的。

可以看到这里的每一件事都是极其复杂的,更不要说要把这些组织到一起,其中最不可思议的是整体性的知觉、记忆和时间的知觉。

要强调的是,现在没有任何角度可以看出深入学习能够制造出像人一样的视角,深度学习、人工智能依旧是面向人的工具,但是深度学习却很可能在不远的将来就会学习到世界的因果模型,而一部分人认为人类就只是一个拥有世界的因果模型的东西,人们应该重新审视这样的观点。

深度学习和脑的一个不同之处在于,深学习中人工神经网络中权重是学习到的东西,保留了数据,随机初始化权重的网络一般需要大量的数据进行训练,而DNA不能完全决定这么多神经细胞的连接。这也就意味着初始的神经细胞连接要么是随机的,要么有种简洁且统一的策略来初始化权重。

真的能有简洁且统一的策略来初始化权重吗?看上去这是不可思议的。而如果大部分连接是随机的。这就意味着需要大量的数据来学习。看上去,即使人类的感官输入信息很多,相比较而言也不足达到现在的大模型的数量级,不要说这种数量级还有待增加。此外,婴儿不是什么也不会的来到世界上——除非他们在子宫内的学习足以达到这样的水平。

另一点在于脑似乎只需要通过少数几个计算步骤就可以得到答案,不像大模型一样需要很多计算步骤。

这一切都表明,神经细胞之间具有某种独特的模式,这种模式和现有的人工神经网络不同。

由此有人也指出,大脑更像一个记忆机器,而不像是计算机器,这在某种意义上不令人惊讶,例如,一个人究竟是怎么计算简单的加法?最初的训练似乎是通过记忆个位数之间的相加的答案,对于多个位数的数字之间相加,仍然通过分解为各个数位之间的相加和数位之间的进位得到答案,而各个数位之间的相加的答案依旧是通过记忆来得到的。

不过事实上,在某个方面,深度学习也是通过记忆来完成答案,正如有人指责深度学习只是在背诵,而不是在推理。就这个层面来讲,脑和神经网络是类似的,不类似的依旧还是在于脑的计算步骤应该要更小一点,而且有着不错的连接模式,当然这不让人奇怪——如果自然选择是正确的,脑就是被这样塑造的。文章来源:https://www.toymoban.com/news/detail-829371.html

另一个方面脑是在反馈的计算,即有自上而下的路径,也有自下道上的路径,这是否能够通过分模块来间接的实现还有待阐述。文章来源地址https://www.toymoban.com/news/detail-829371.html

到了这里,关于Sora:通过视频生成模型制造世界模拟器(世界模型)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!