有时候会搞混这两个概念。什么是前向传播?不是只有后向传播吗?后向传播好像是用来更新模型参数的,前向传播是什么东西?

带着疑问再次梳理一遍:

前向传播

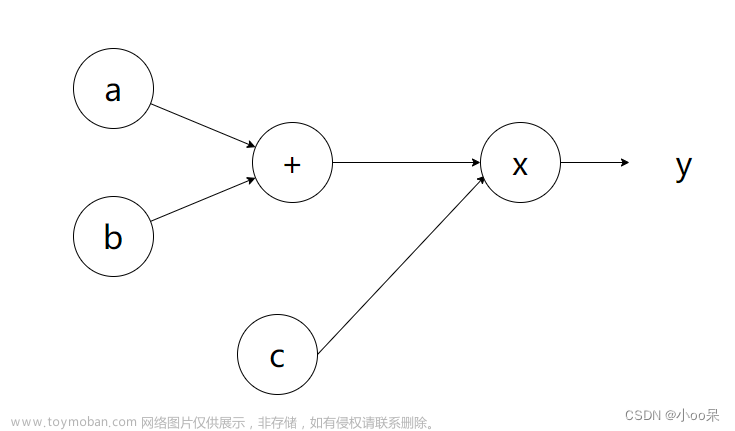

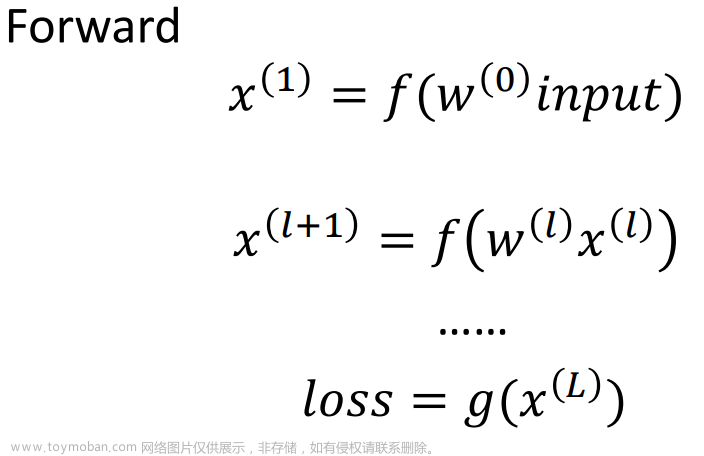

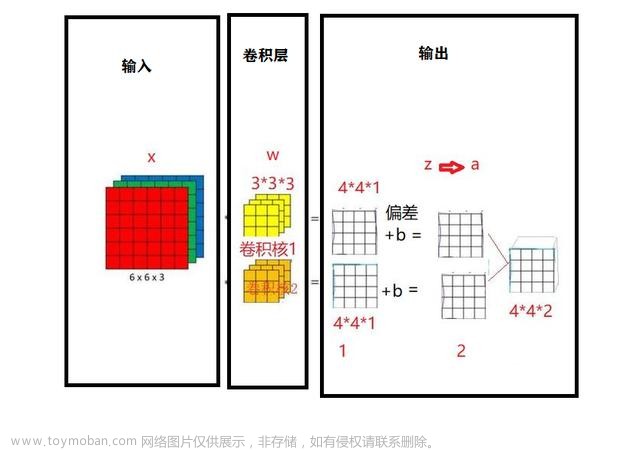

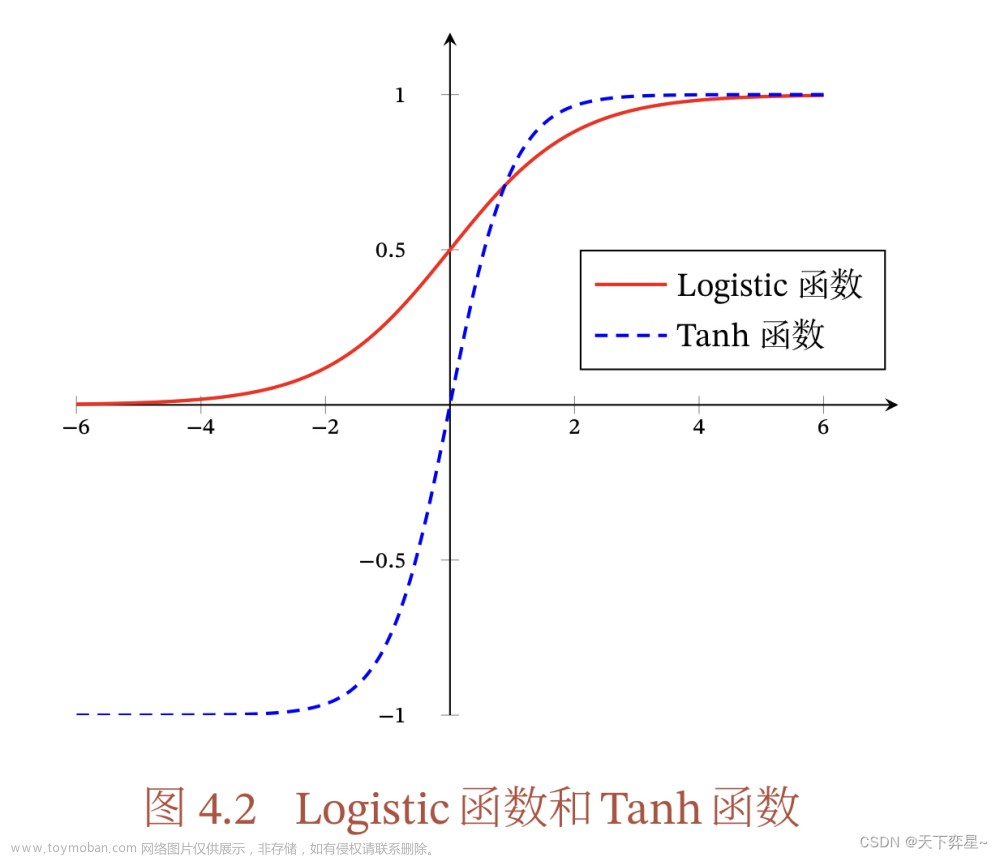

前向传播是神经网络进行预测的过程。在这个过程中,输入数据沿着神经网络从输入层经过隐藏层(如果有的话)最终到输出层流动。在每一层,数据会与层内的权重(parameters)进行计算(如加权和),并通过激活函数(activation function)进行非线性转换,生成该层的输出。这个输出随后成为下一层的输入,直到最后生成最终的预测结果。前向传播的目的是根据当前的模型参数(权重和偏置)对输入数据进行预测。

后向传播

后向传播是训练神经网络时用于计算损失函数(loss function)关于模型参数的梯度(gradient)的过程。这个过程始于最终输出层的损失函数,此函数衡量了模型预测和实际标签之间的差异。在后向传播中,这个损失会被用来计算对每个参数的梯度,表示损失函数如何随这些参数的变化而变化。这通过链式法则(chain rule)实现,从输出层开始逐层向后计算梯度,直至输入层。计算得到的梯度随后用于更新模型的参数(如通过梯度下降法),目的是减少损失,从而改善模型的预测性能。

关系

前向传播提供了模型对当前输入的预测,这个预测随后用于计算损失,损失反映了模型当前性能的好坏。

后向传播利用这个损失,通过计算损失相对于每个参数的梯度,来指导模型参数的更新,以减少未来的预测误差。

前向传播是数据输入到网络模型得到预测结果的过程,后向传播是计算loss function计算模型参数梯度的过程。文章来源:https://www.toymoban.com/news/detail-829919.html

引申概念:梯度。

什么是梯度?我们知道模型是根据目标函数的梯度反方向更新参数的,那么这个重要的梯度是如何计算和得到的?梯度的计算通常依赖于链式法则,它是微积分中的一个基本原则,用于计算复合函数的导数。在深度学习中,模型的输出和损失可以视为输入数据和模型参数的复合函数,链式法则允许我们分步骤计算损失相对于每个参数的偏导数。文章来源地址https://www.toymoban.com/news/detail-829919.html

到了这里,关于神经网络中的前向传播(Forward Propagation)和后向传播(Backward Propagation)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!